内核源码版本:4.x

一、系统初始化

1. x86架构

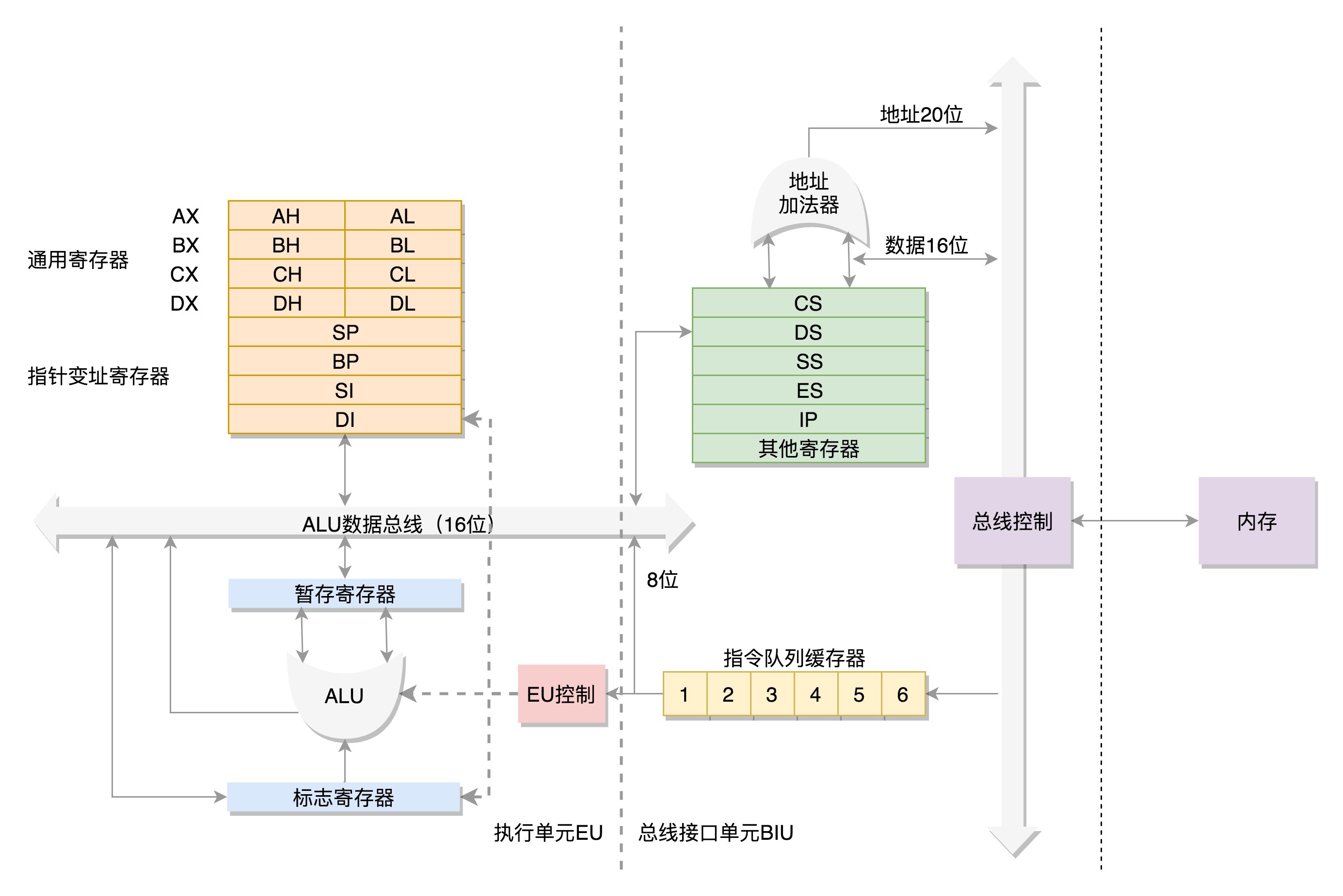

1.1 8086的原理

数据单元

为了暂存数据,8086处理器内部有8个16位的通用寄存器,分别是AX、BX、CX、DX、SP、BP、SI、DI。这些寄存器主要用于在计算过程中暂存数据。

其中AX、BX、CX、DX可以分成两个8位的寄存器来使用,分别是AH、AL、BH、BL、CH、CL、DH、DL,其中H就是High(高位),L就是Low(低位)的意思。

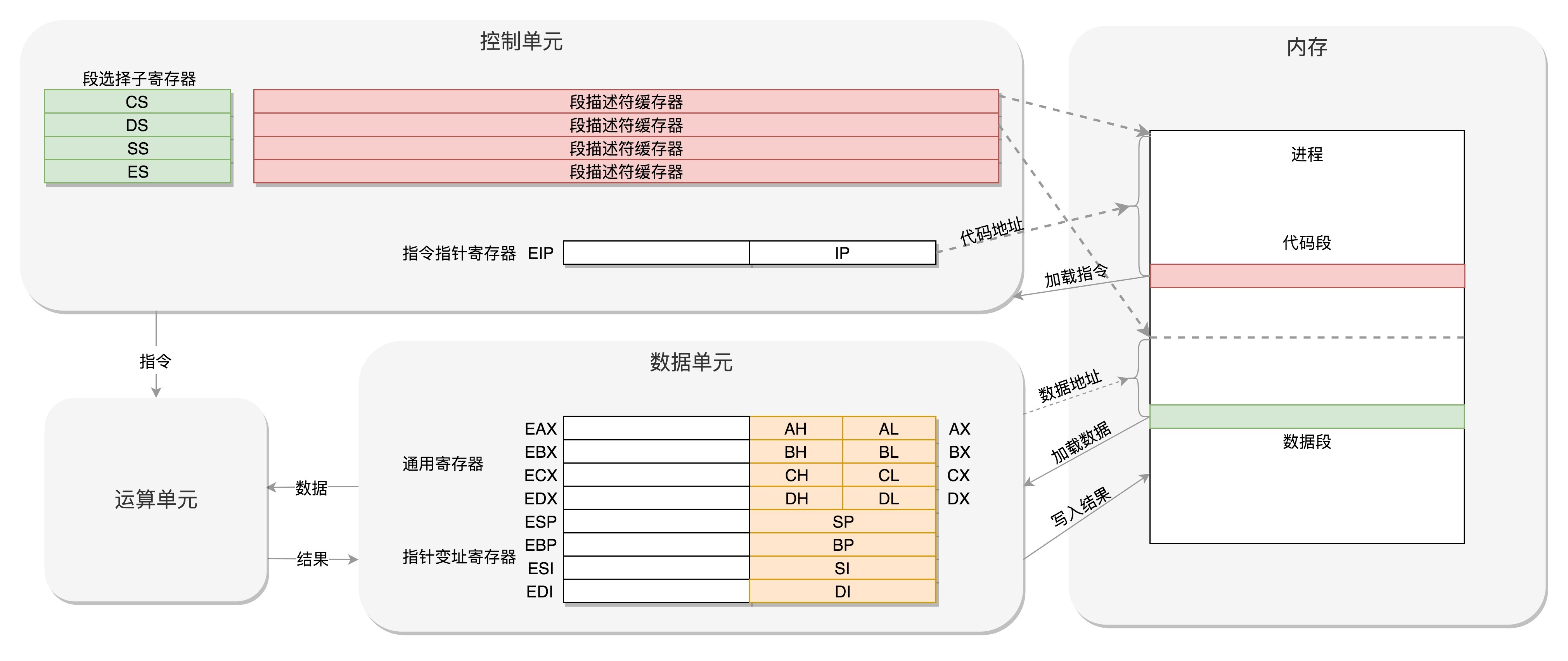

控制单元

IP寄存器就是指令指针寄存器(Instruction Pointer Register),指向代码段中下一条指令的位置。CPU会根据它来不断地将指令从内存的代码段中,加载到CPU的指令队列中,然后交给运算单元去执行。

如果需要切换进程呢?每个进程都分代码段和数据段,为了指向不同进程的地址空间,有四个16位的段寄存器,分别是CS、DS、SS、ES。

其中,CS就是代码段寄存器(Code Segment Register),通过它可以找到代码在内存中的位置;DS是数据段的寄存器,通过它可以找到数据在内存中的位置。

SS是栈寄存器(Stack Register)。栈是程序运行中一个特殊的数据结构,数据的存取只能从一端进行,秉承后进先出的原则,push就是入栈,pop就是出栈。

ES为扩展段寄存器。

在CS和DS中都存放着一个段的起始地址。代码段的偏移量在IP寄存器中,数据段的偏移量会放在通用寄存器中。

这时候问题来了,CS和DS都是16位的,也就是说,起始地址都是16位的,IP寄存器和通用寄存器都是16位的,偏移量也是16位的,但是8086的地址总线地址是20位。怎么凑够这20位呢?方法就是”起始地址*16+偏移量”,也就是把CS和DS中的值左移4位,变成20位的,加上16位的偏移量,这样就可以得到最终20位的数据地址。

因为偏移量只能是16位的,所以一个段最大的大小是2^16=64k。

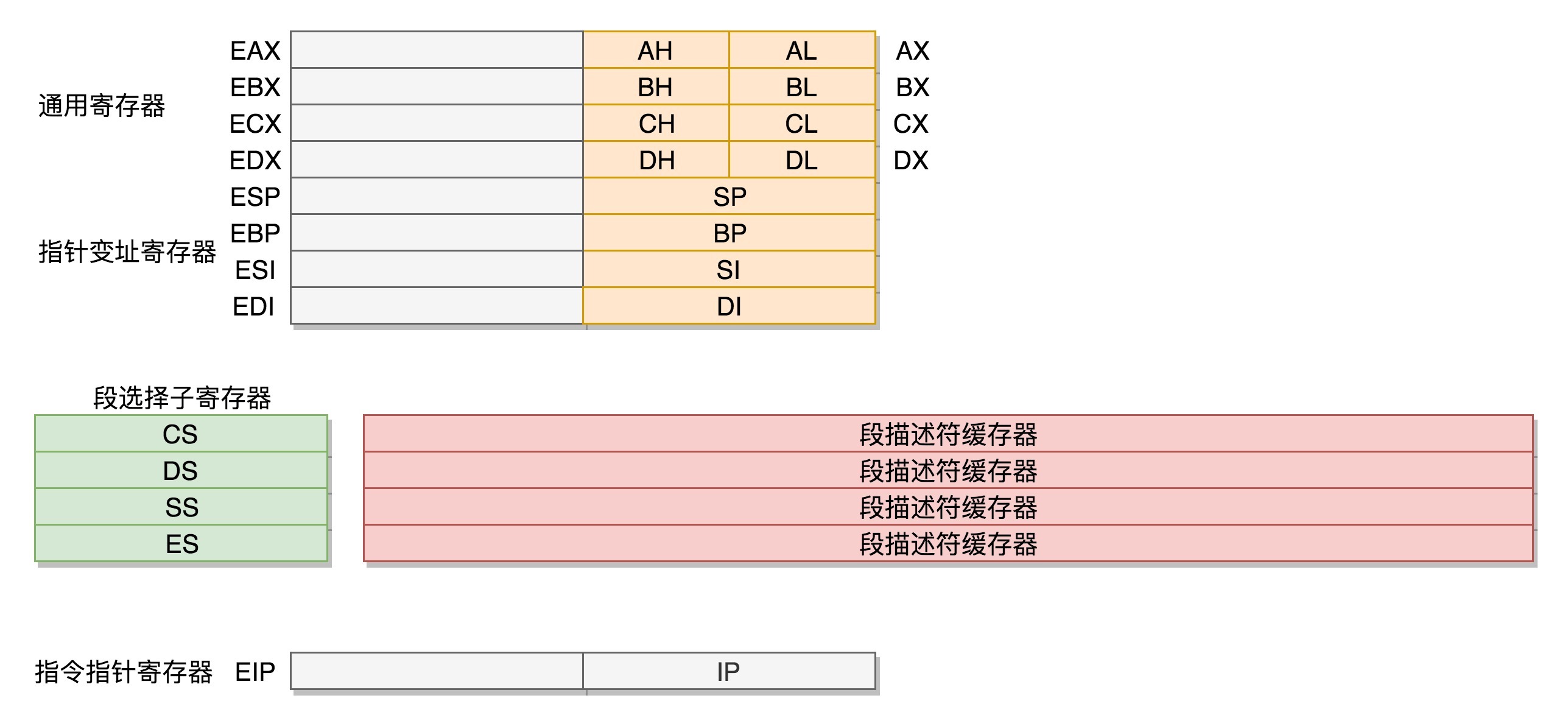

1.2 32位处理器

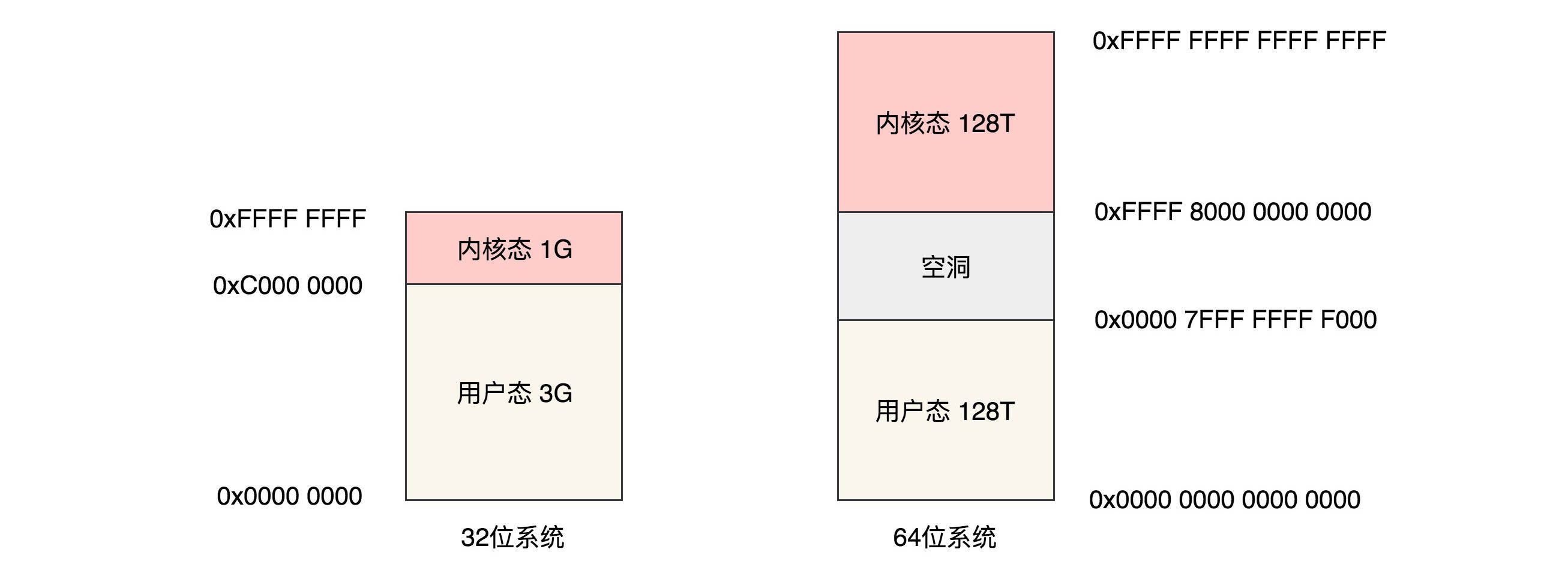

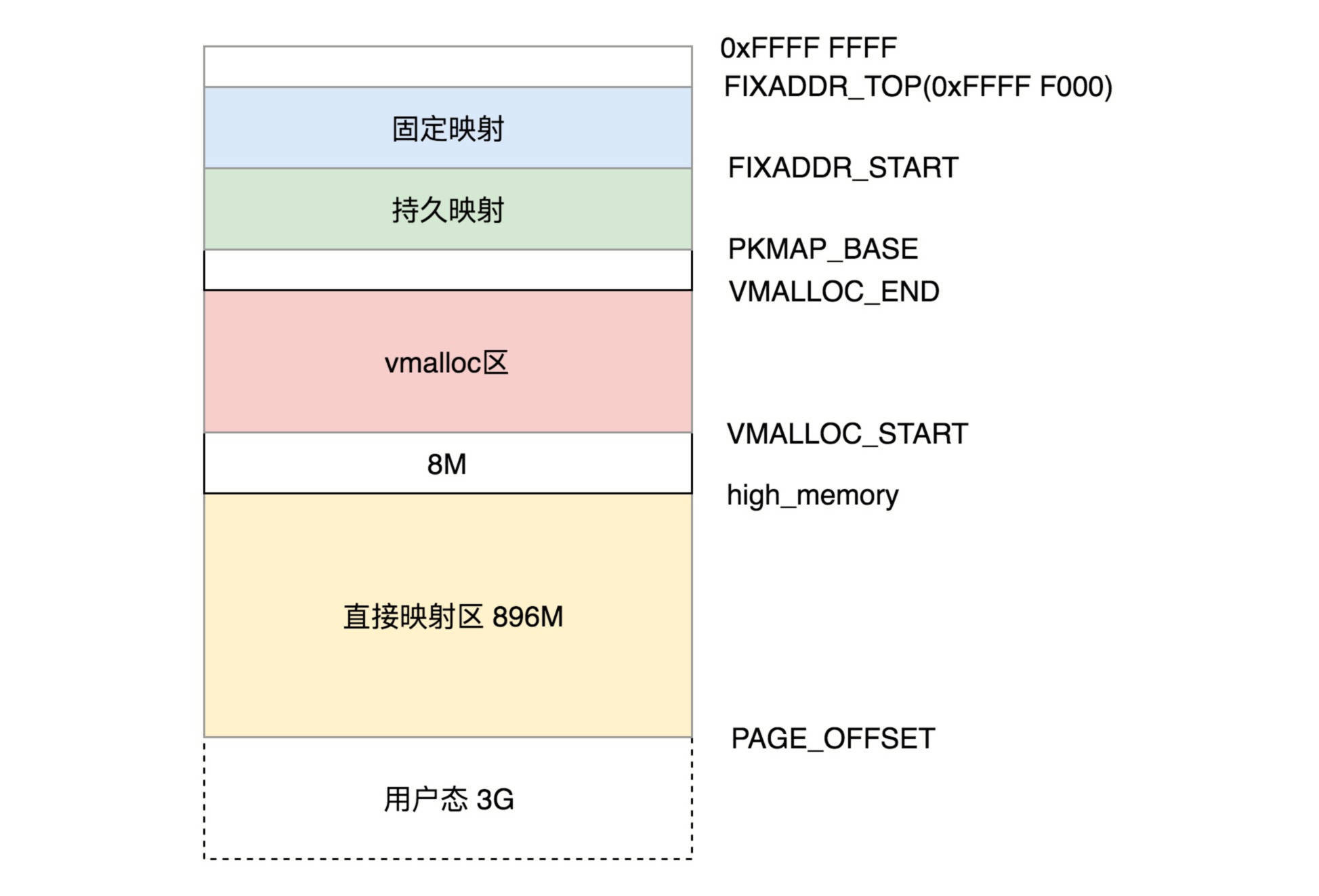

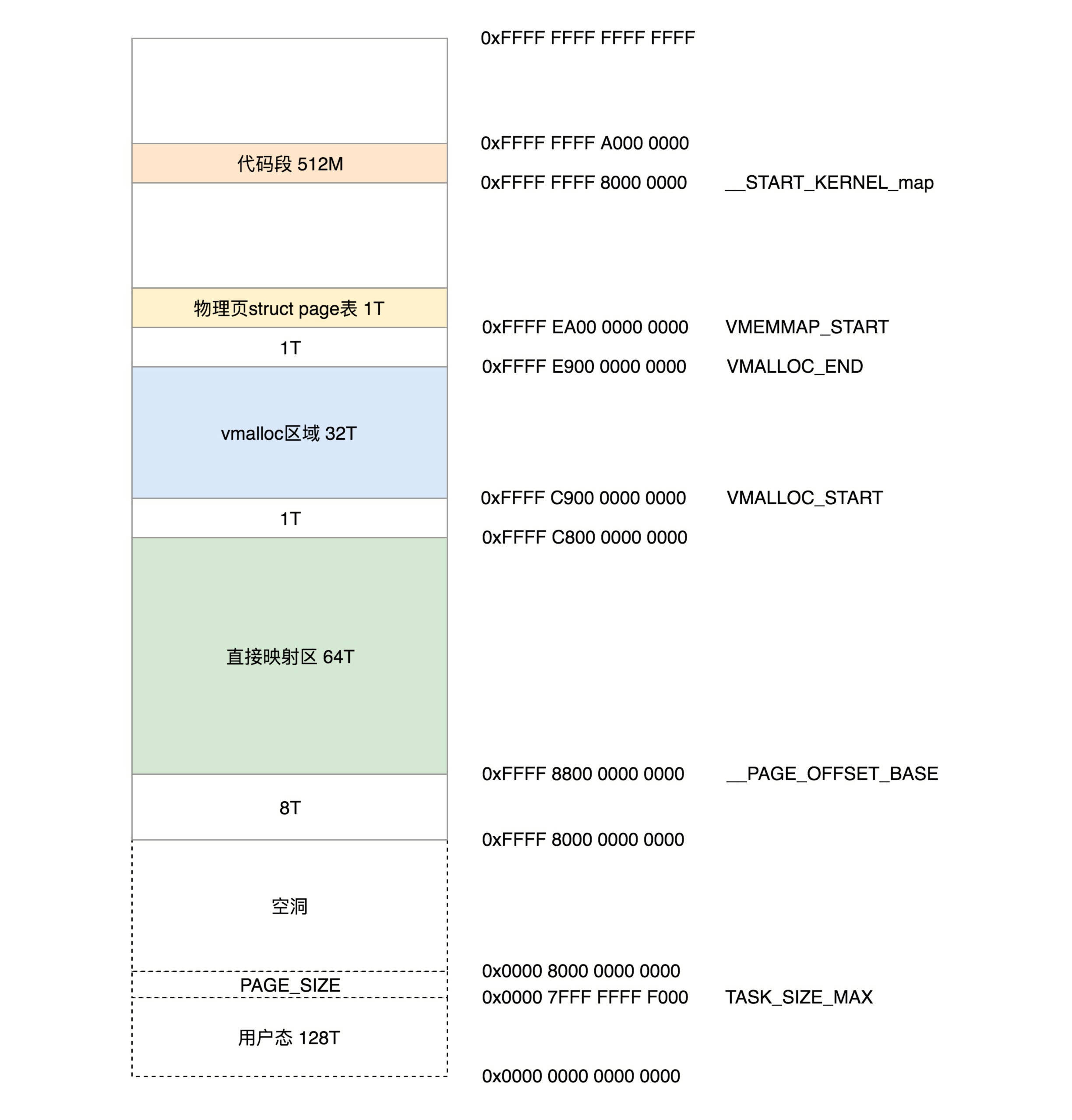

在32位处理器中,有32根地址总线,可以访问2^32=4G的内存。

首先,通用寄存器有扩展,可以将8个16位的扩展到8个32位的,但是依然可以保留16位的和8位的使用方式。你可能会问,为什么高16位不分成两个8位使用呢?因为这样就不兼容了呀!

其中,指向下一条指令的指令指针寄存器IP,就会扩展成32位的,同样也兼容16位的。

而改动比较大,有点不兼容的就是段寄存器(Segment Register)。

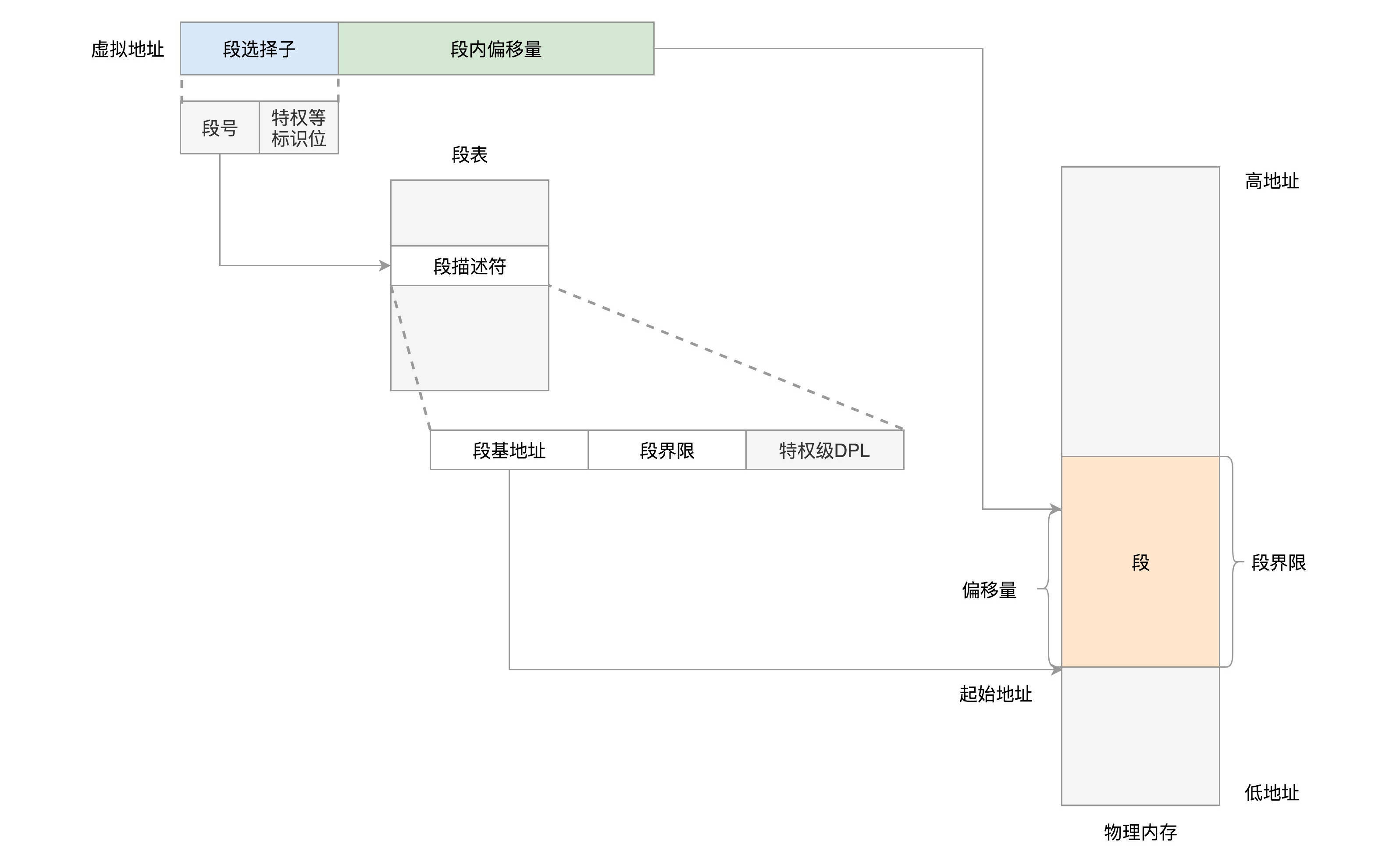

CS、SS、DS、ES仍然是16位的,但是不再是段的起始地址。段的起始地址放在内存的某个地方。这个地方是一个表格,表格中的一项一项是段描述符(Segment Descriptor)。这里面才是真正的段的起始地址。而段寄存器里面保存的是在这个表格中的哪一项,称为选择子(Selector)。

这样,将一个从段寄存器直接拿到的段起始地址,就变成了先间接地从段寄存器找到表格中的一项,再从表格中的一项中拿到段起始地址。

为了快速拿到段起始地址,段寄存器会从内存中拿到CPU的描述符高速缓存器中。

32位的系统架构下,我们将前一种模式称为实模式(Real Pattern),后一种模式称为保护模式(Protected Pattern)。

当系统刚刚启动的时候,CPU是处于实模式的。

1.3 总结

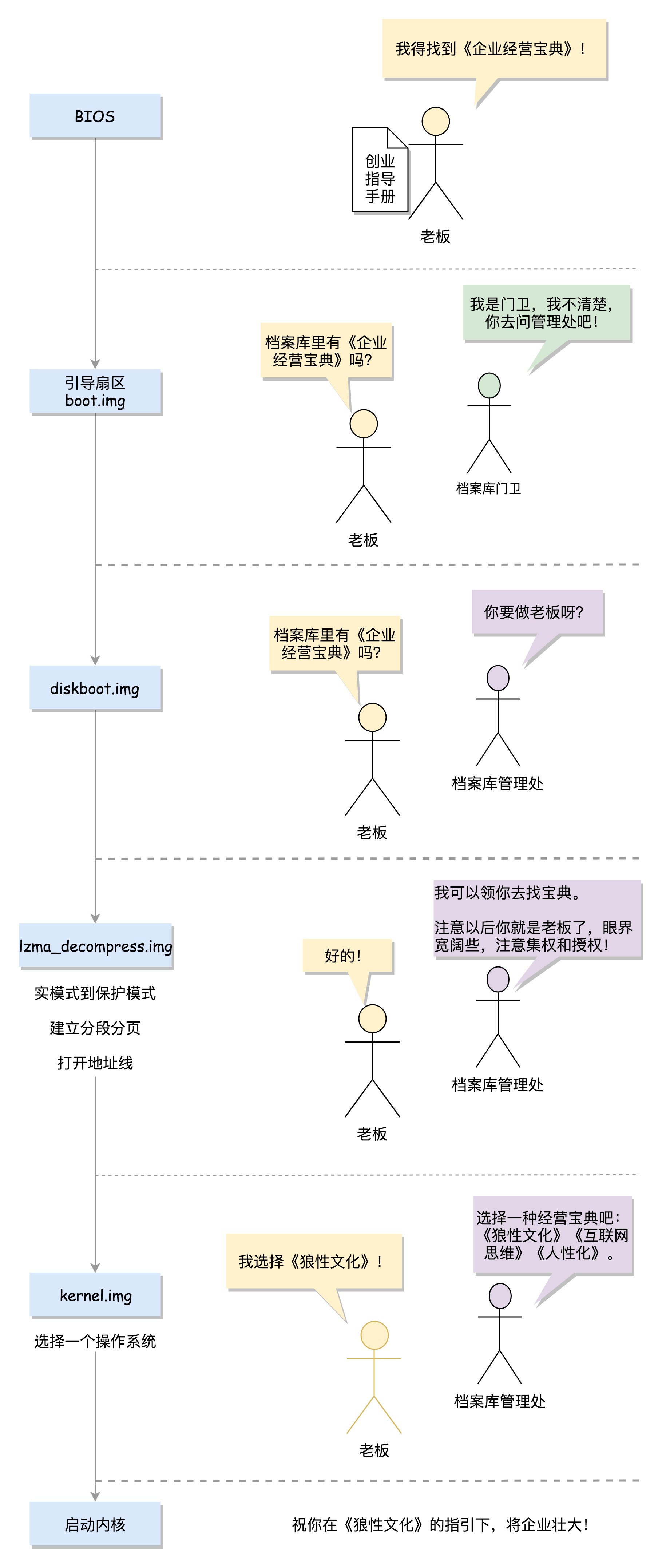

2. 系统启动过程

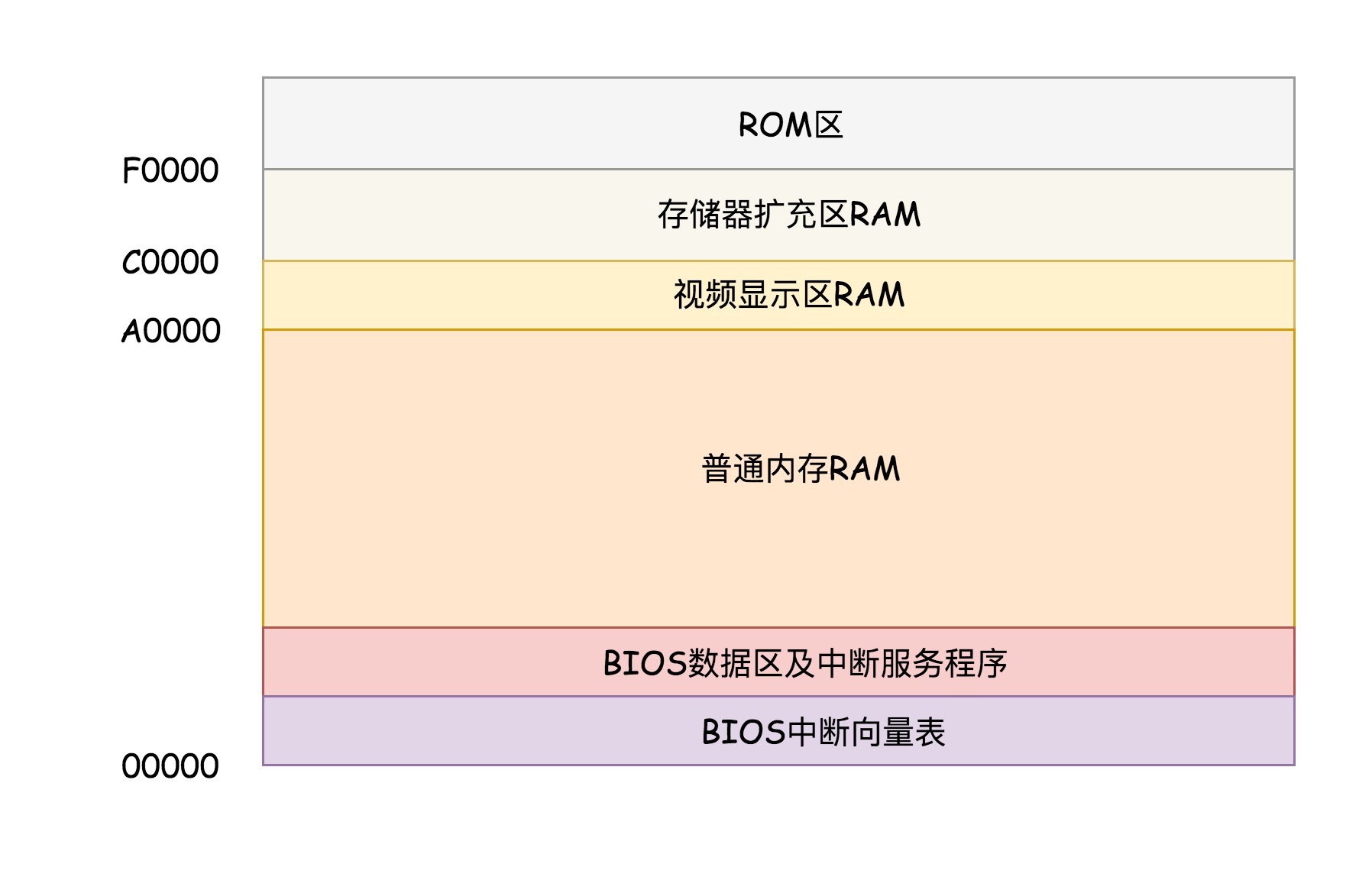

系统加电后,CPU 运行在实模式下,且 CS 重置为 0xFFFF ,IP 为 0x0000。

实模式下,内存地址的计算方式是:

段寄存器 * 16 + 偏移量。所以系统加电后运行的第一条指令在CS * 16 + IP = 0xFFFF0。实模式只有 1MB 内存寻址空间(X86)。

在 x86 系统中,内存

0xF0000-0xFFFFF映射到 BIOS 程序(存储在 ROM 中),BIOS 主要做三件事:- 检查硬件。

- 提供基本输入(中断)输出(显存映射)服务。

把 MBR(Master Boot Record,主引导记录/扇区)装载到内存 0x7C00 开始的 512 字节大小的内存区域,并设置 CS:IP 为 0x0000:7C00 。

MBR 指启动盘的第一个扇区,大小 512 字节,并且以 0xAA55 结束。

MBR中存放的一般是由 Grub2 写入的 boot.img。

boot.img 加载 Grub2 的 core.img 。

boot.img 由 boot.S 编译而成。

core.img 包括 diskroot.img, lzma_decompress.img, kernel.img 以及其他模块。

硬盘启动时,boot.img 先加载运行 diskroot.img, 再由 diskroot.img 加载 core.img 的其他内容。

diskroot.img 解压运行 lzma_compress.img 。

diskroot.img 由 diskboot.S 编译而成。

lzma_compress.img 首先切换到保护模式。然后再解压运行 grub 内核 kernel.img。

lzma_compress.img 由 startup_raw.S 编译而成。

调用

real_to_prot切换到保护模式需要做三件事:- 启用分段, 辅助进程管理。在内存里面建立段描述符表,将寄存器里面的段寄存器变成段选择子,指向某个段描述符,这样就能实现不同进程的切换了。

- 启动分页, 辅助内存管理;将内存分成相等大小的块。

- 打开其他地址线。打开Gate A20,也就是第21根地址线的控制线。

kernel.img 主要做的是根据配置信息,加载用户选择 linux kernel 并传递内核启动参数。

kernel.img 对应的代码是 startup.S 以及一堆 c 文件,在 startup.S 中会调用

grub_main,这是 grub kernel 的主函数。将真正的操作系统的 kernel 镜像加载执行,Linux Kernel的启动入口是

start_kernel()。start_kernel()中会进行一部分初始化工作,最后调用rest_init()来完成其他的初始化工作。rest_init()中会创建系统 1 号进程 kernel_init , kernel_init 会执行 ramdisk 中的 init 程序,并切换至用户态,加载驱动后执行真正的根文件系统中的 init 程序。rest_init()中会创建系统 2 号进程 kthread ,负责所有内核态线程的调度和管理,是内核态所有运行线程的祖先。

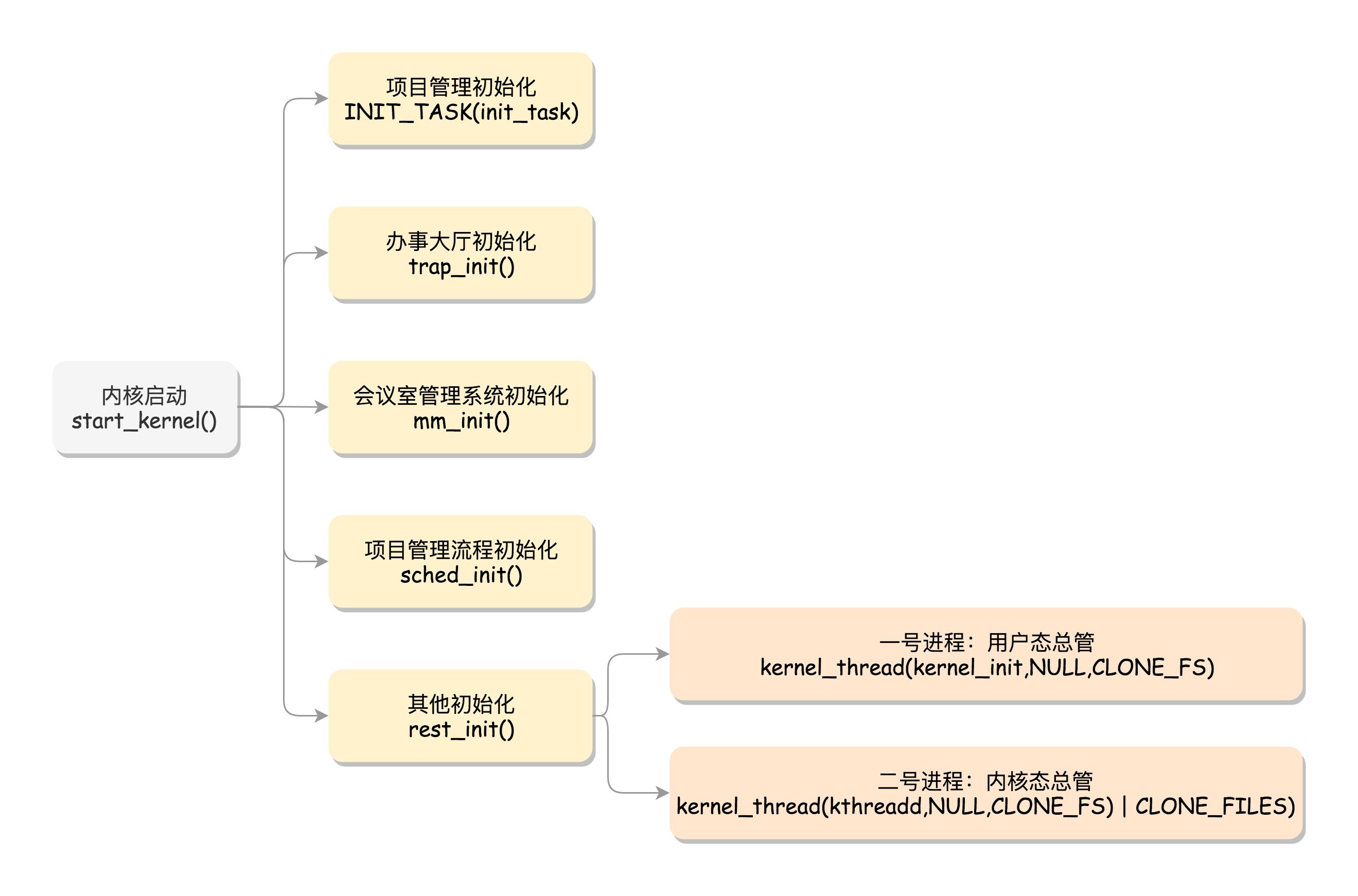

3. 内核初始化

内核的启动从入口函数start_kernel()开始。在init/main.c文件中,start_kernel相当于内核的main函数。

3.1 初始化任务管理

在操作系统里面,先要有个创始进程,有一行指令set_task_stack_end_magic(&init_task)。这里面有一个参数init_task,它的定义是struct task_struct init_task = INIT_TASK(init_task)。它是系统创建的第一个进程,我们称为 0号进程 。这是唯一一个没有通过fork或者kernel_thread产生的进程,是进程列表的第一个。

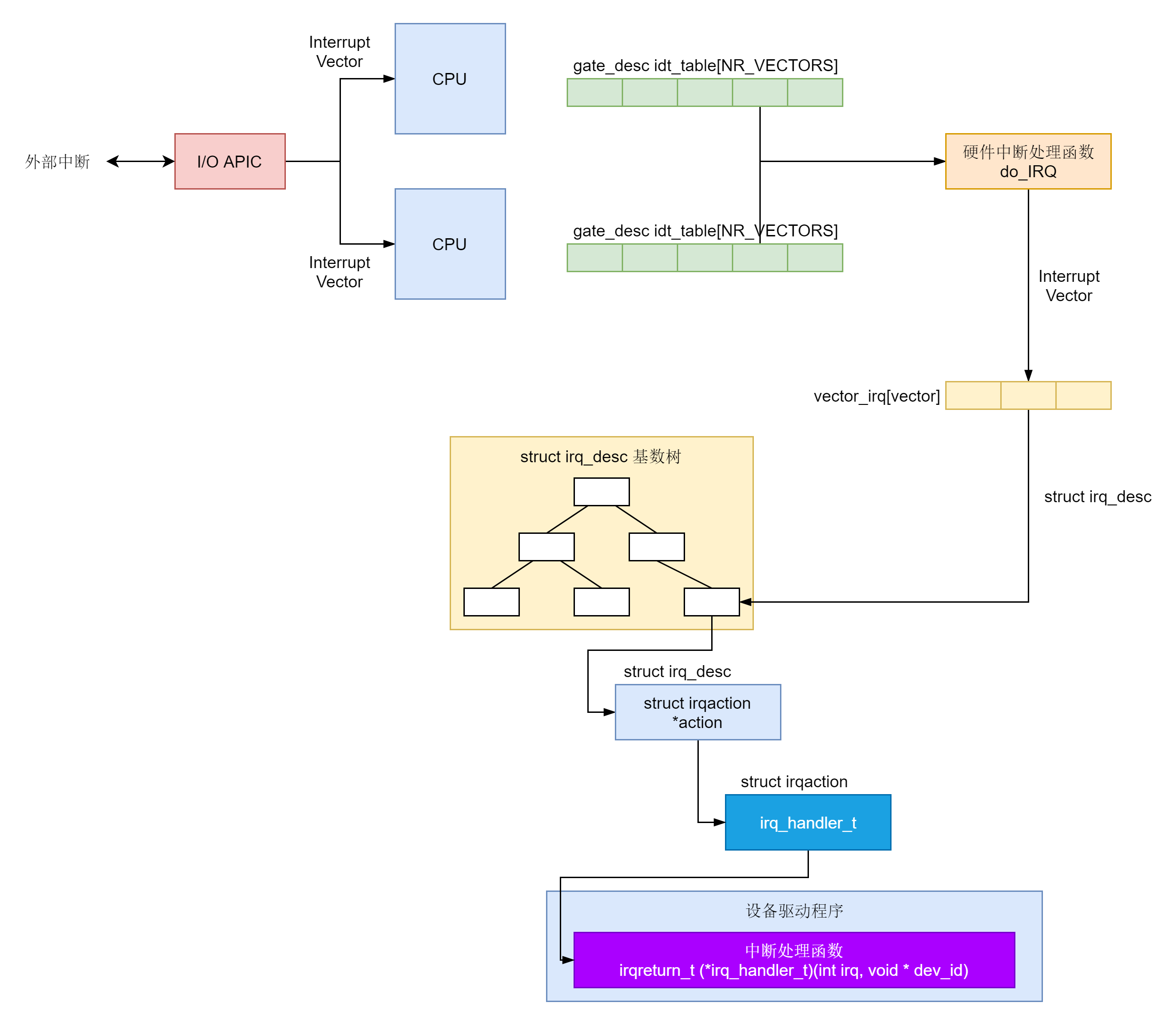

3.2 初始化中断处理

对应的函数是trap_init(),里面设置了很多中断门(Interrupt Gate),用于处理各种中断。其中有一个set_system_intr_gate(IA32_SYSCALL_VECTOR, entry_INT80_32),这是系统调用的中断门。系统调用也是通过发送中断的方式进行的。

64位的有另外的系统调用方法。

3.3 初始化内存管理

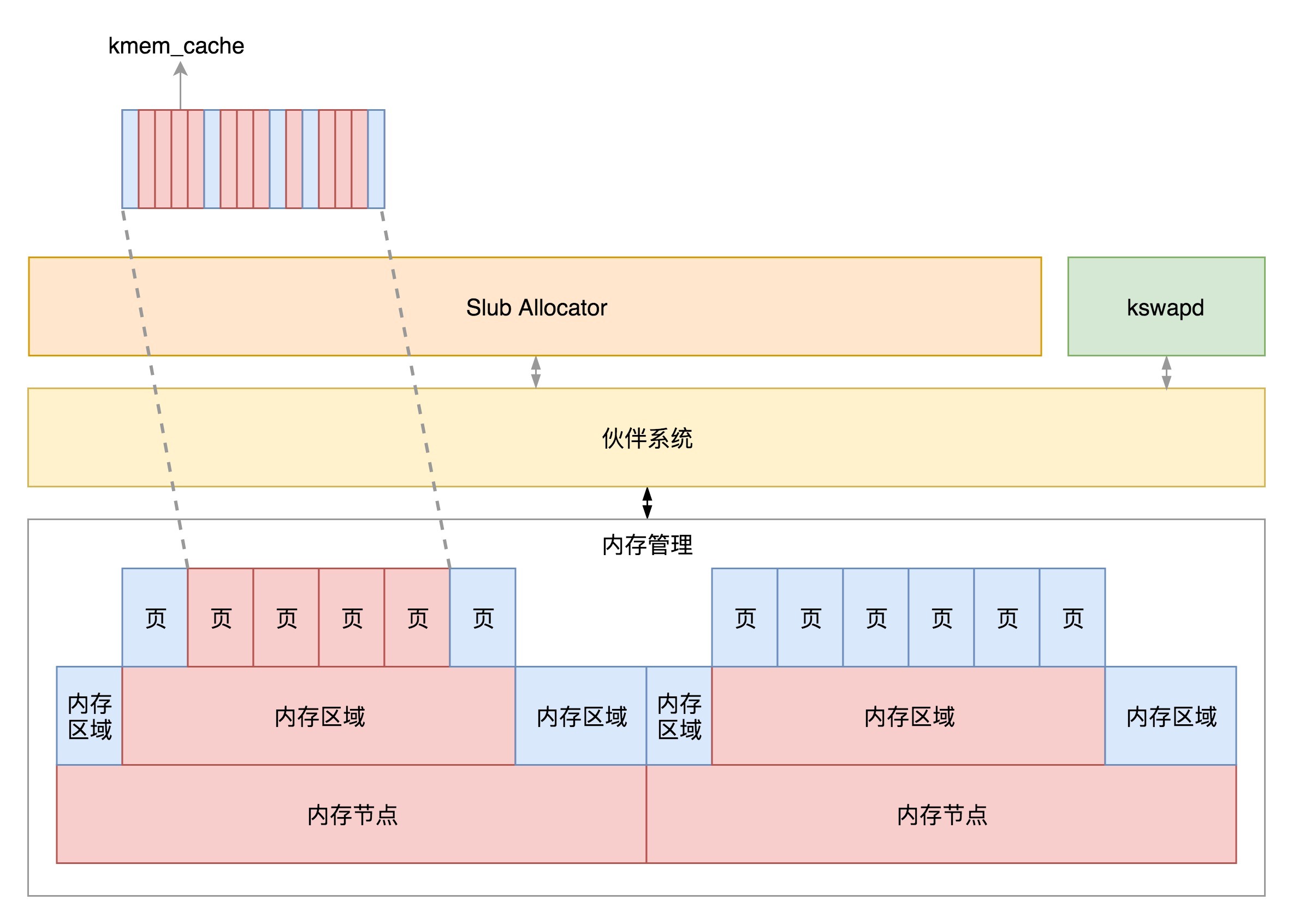

对应的,mm_init()就是用来初始化内存管理模块。

3.4 初始化调度模块

sched_init()就是用于初始化调度模块。

3.5 初始化 rootfs 文件系统

vfs_caches_init()会用来初始化基于内存的文件系统rootfs。在这个函数里面,会调用mnt_init()->init_rootfs()。这里面有一行代码,register_filesystem(&rootfs_fs_type)。在VFS虚拟文件系统里面注册了一种类型,我们定义为struct file_system_type rootfs_fs_type。

3.6 其他初始化

最后,start_kernel()调用的是rest_init(),用来做其他方面的初始化,这里面做了好多的工作。

3.6.1 初始化1号进程

rest_init的第一大工作是,用kernel_thread(kernel_init, NULL, CLONE_FS)创建第二个进程,这个是 1号进程 。

1号进程对于操作系统来讲,有”划时代”的意义。因为它将运行一个用户进程。

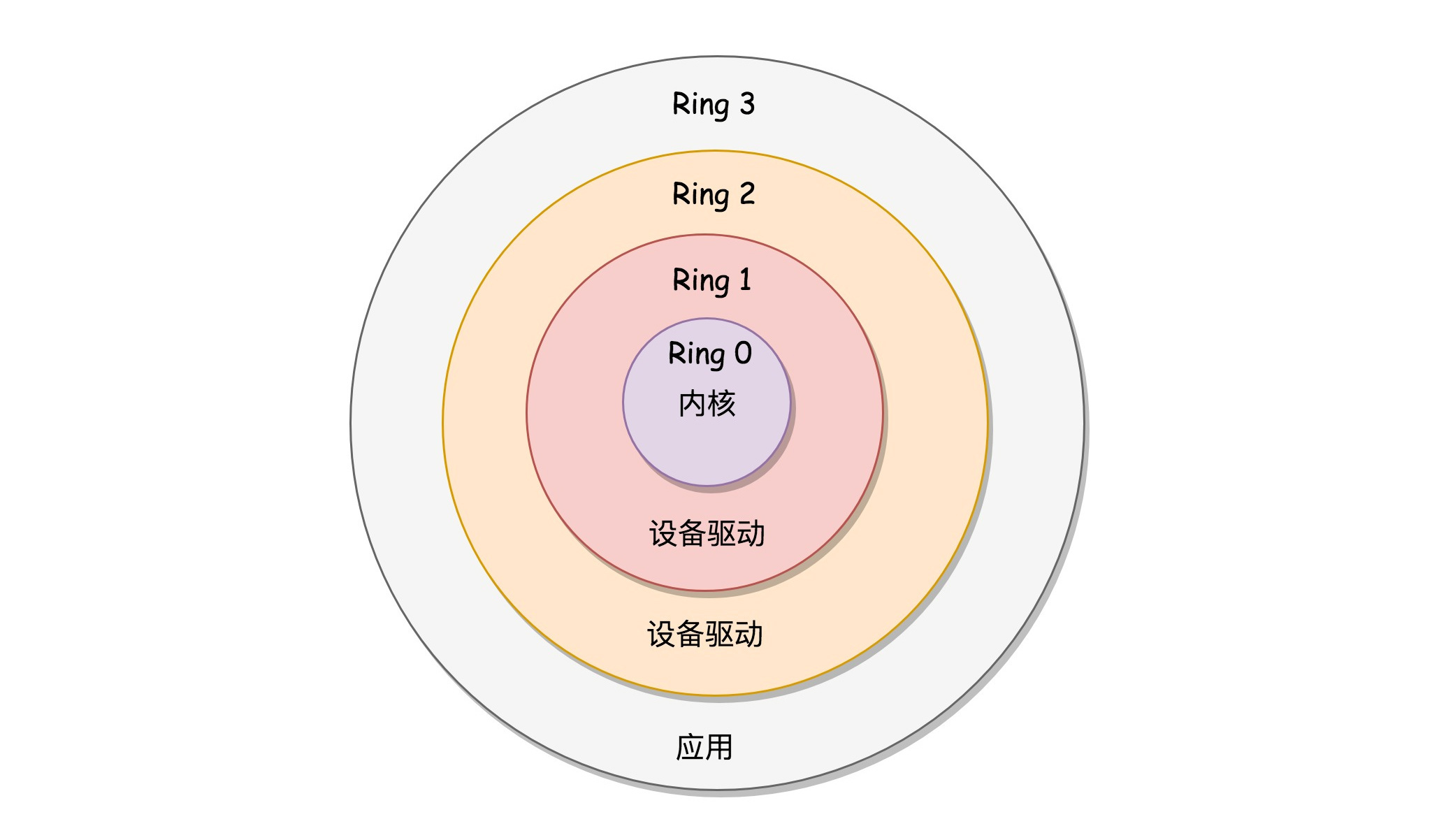

x86提供了分层的权限机制,把区域分成了四个Ring,越往里权限越高,越往外权限越低。

操作系统很好地利用了这个机制,将能够访问关键资源的代码放在Ring0,我们称为 内核态(Kernel Mode) ;将普通的程序代码放在Ring3,我们称为 用户态(User Mode) 。

从内核态到用户态

当执行kernel_thread这个函数的时候,系统在内核态。

kernel_thread的参数是一个函数kernel_init,也就是这个进程会运行这个函数。在kernel_init里面,会调用kernel_init_freeable(),里面有这样的代码:

if (!ramdisk_execute_command) ramdisk_execute_command = "/init";先不管ramdisk是啥,我们回到kernel_init里面。这里面有这样的代码块:

if (ramdisk_execute_command) { ret = run_init_process(ramdisk_execute_command); ...... } ...... if (!try_to_run_init_process("/sbin/init") || !try_to_run_init_process("/etc/init") || !try_to_run_init_process("/bin/init") || !try_to_run_init_process("/bin/sh")) return 0;这就说明,1号进程运行的是一个文件。如果我们打开run_init_process函数,会发现它调用的是do_execve。

static int run_init_process(const char *init_filename) { argv_init[0] = init_filename; return do_execve(getname_kernel(init_filename), (const char __user *const __user *)argv_init, (const char __user *const __user *)envp_init); }execve是一个系统调用,它的作用是运行一个执行文件。加一个do_的往往是内核系统调用的实现。没错,这就是一个系统调用,它会尝试运行ramdisk的”/init”,或者普通文件系统上的”/sbin/init””/etc/init””/bin/init””/bin/sh”。不同版本的Linux会选择不同的文件启动,但是只要有一个起来了就可以。

如何利用执行init文件的机会,从内核态回到用户态呢?

从系统调用的过程可以得到启发,”用户态-系统调用-保存寄存器-内核态执行系统调用-恢复寄存器-返回用户态”,然后接着运行。而咱们刚才运行init,是调用do_execve,正是上面的过程的后半部分,从内核态执行系统调用开始。

do_execve->do_execveat_common->exec_binprm->search_binary_handler,这里面会调用这段内容:

int search_binary_handler(struct linux_binprm *bprm) { ...... struct linux_binfmt *fmt; ...... retval = fmt->load_binary(bprm); ...... }要运行一个程序,需要加载这个二进制文件,它是有一定格式的。Linux下一个常用的格式是ELF(Executable and Linkable Format,可执行与可链接格式)。于是我们就有了下面这个定义:

static struct linux_binfmt elf_format = { .module = THIS_MODULE, .load_binary = load_elf_binary, .load_shlib = load_elf_library, .core_dump = elf_core_dump, .min_coredump = ELF_EXEC_PAGESIZE, };这其实就是先调用load_elf_binary,最后调用start_thread。

void start_thread(struct pt_regs *regs, unsigned long new_ip, unsigned long new_sp) { set_user_gs(regs, 0); regs->fs = 0; regs->ds = __USER_DS; regs->es = __USER_DS; regs->ss = __USER_DS; regs->cs = __USER_CS; regs->ip = new_ip; regs->sp = new_sp; regs->flags = X86_EFLAGS_IF; force_iret(); } EXPORT_SYMBOL_GPL(start_thread);struct pt_regs,看名字里的register,就是寄存器啊!这个结构就是在系统调用的时候,内核中保存用户态运行上下文的,里面将用户态的代码段CS设置为USER_CS,将用户态的数据段DS设置为USER_DS,以及指令指针寄存器IP、栈指针寄存器SP。这里相当于补上了原来系统调用里,保存寄存器的一个步骤。

最后的iret是用于从系统调用中返回。这个时候会恢复寄存器。从哪里恢复呢?按说是从进入系统调用的时候,保存的寄存器里面拿出。好在上面的函数补上了寄存器。CS和指令指针寄存器IP恢复了,指向用户态下一个要执行的语句。DS和函数栈指针SP也被恢复了,指向用户态函数栈的栈顶。所以,下一条指令,就从用户态开始运行了。

ramdisk的作用

init终于从内核到用户态了。一开始到用户态的是ramdisk的init,后来会启动真正根文件系统上的init,成为所有用户态进程的祖先。

为什么会有ramdisk这个东西呢?内核启动的时候,一般会配置参数:

initrd16 /boot/initramfs-3.10.0-862.el7.x86_64.img就是这个东西,这是一个基于内存的文件系统。为啥会有这个呢?

是因为刚才那个init程序是在文件系统上的,文件系统一定是在一个存储设备上的,例如硬盘。Linux访问存储设备,要有驱动才能访问。如果存储系统数目很有限,那驱动可以直接放到内核里面,反正前面我们加载过内核到内存里了,现在可以直接对存储系统进行访问。

但是存储系统越来越多了,如果所有市面上的存储系统的驱动都默认放进内核,内核就太大了。这该怎么办呢?

我们只好先弄一个基于内存的文件系统。内存访问是不需要驱动的,这个就是ramdisk。这个时候,ramdisk是根文件系统。

然后,我们开始运行ramdisk上的/init。等它运行完了就已经在用户态了。/init这个程序会先根据存储系统的类型加载驱动,有了驱动就可以设置真正的根文件系统了。有了真正的根文件系统,ramdisk上的/init会启动文件系统上的init。

接下来就是各种系统的初始化。启动系统的服务,启动控制台,用户就可以登录进来了。

先别忙着高兴,rest_init的第一个大事情才完成。我们仅仅形成了用户态所有进程的祖先。

3.6.2 创建2号进程

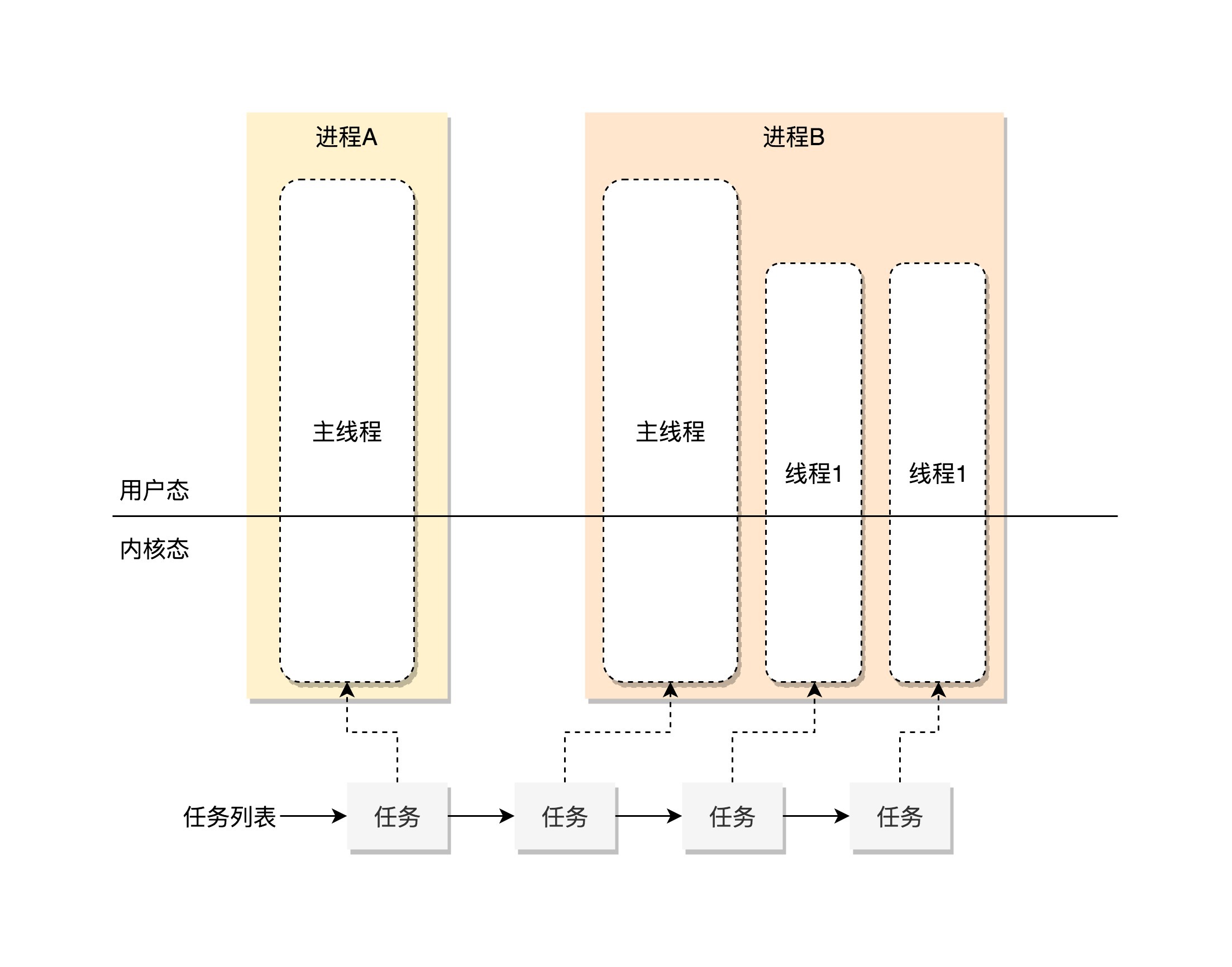

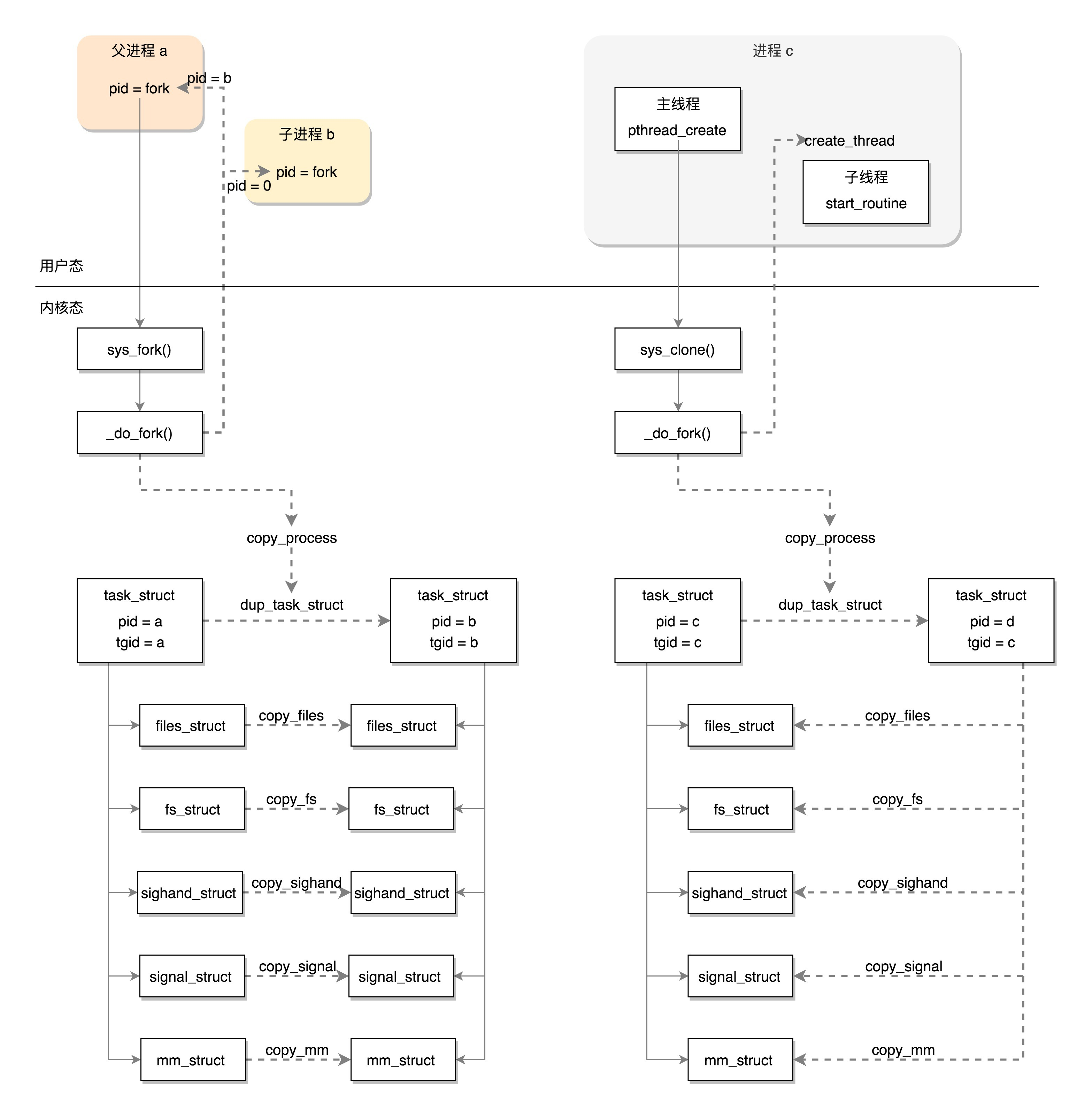

kernel_thread(kthreadd, NULL, CLONE_FS | CLONE_FILES)又一次使用kernel_thread函数创建进程。这里需要指出一点,函数名thread可以翻译成”线程”,这也是操作系统很重要的一个概念。它和进程有什么区别呢?为什么这里创建的是进程,函数名却是线程呢?

从用户态来看,创建进程其实就是立项,也就是启动一个项目。这个项目需要人去执行。有多个人并行执行不同的部分,这就叫 多线程(Multithreading) 。如果只有一个人,那它就是这个项目的主线程。

但是从内核态来看,无论是进程,还是线程,我们都可以统称为任务(Task),都使用相同的数据结构,平放在同一个链表中。

这里的函数kthreadd,负责所有内核态的线程的调度和管理,是内核态所有线程运行的祖先。

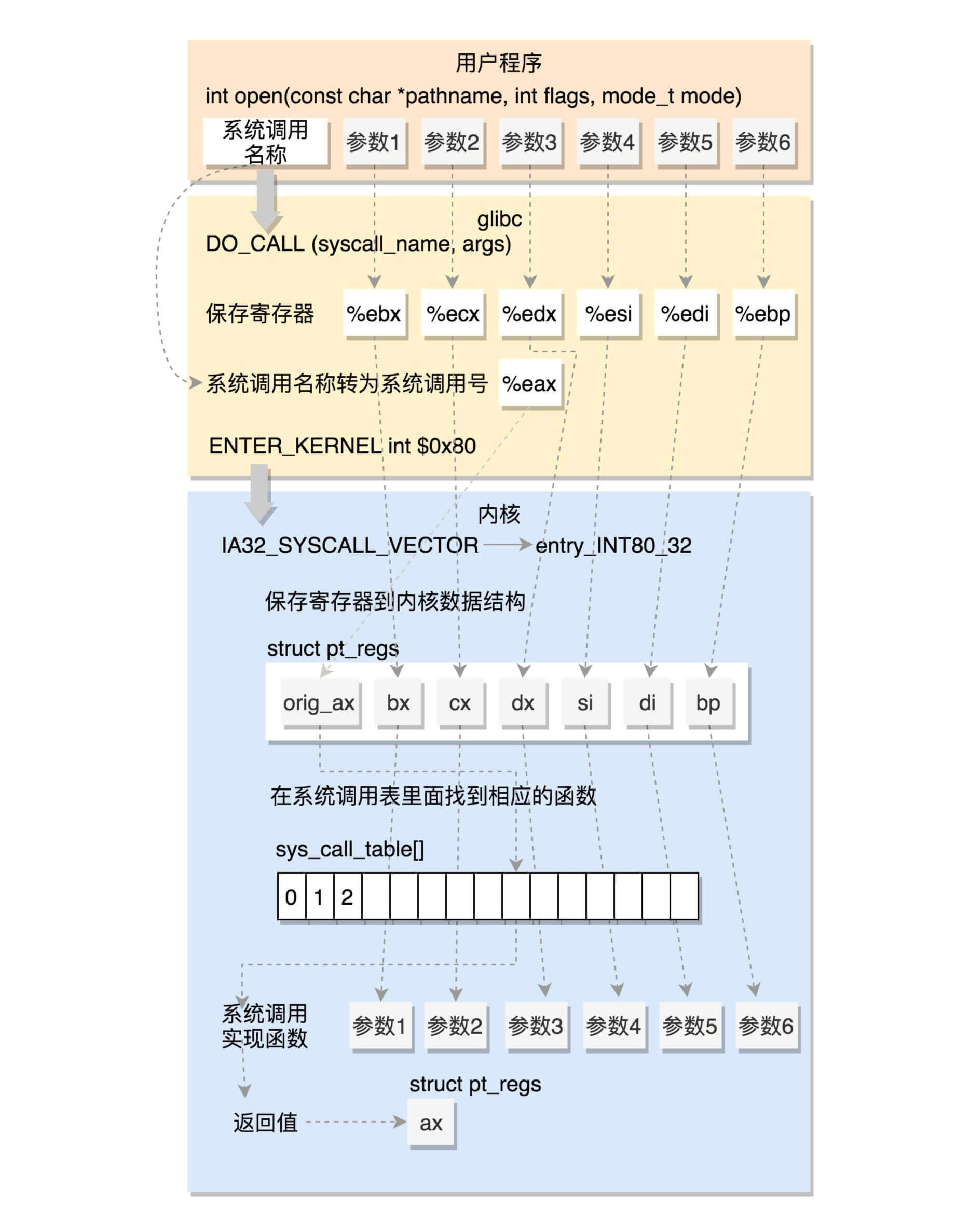

4. 系统调用

4.1 glibc对系统调用的封装

在glibc的源代码中,有个文件syscalls.list,里面列着所有glibc的函数对应的系统调用,就像下面这个样子:

# File name Caller Syscall name Args Strong name Weak names

open - open Ci:siv __libc_open __open open另外,glibc还有一个脚本make-syscall.sh,可以根据上面的配置文件,对于每一个封装好的系统调用,生成一个文件。这个文件里面定义了一些宏,例如#define SYSCALL_NAME open。

glibc还有一个文件syscall-template.S,使用上面这个宏,定义了这个系统调用的调用方式。

T_PSEUDO (SYSCALL_SYMBOL, SYSCALL_NAME, SYSCALL_NARGS)

ret

T_PSEUDO_END (SYSCALL_SYMBOL)

#define T_PSEUDO(SYMBOL, NAME, N) PSEUDO (SYMBOL, NAME, N)这里的PSEUDO也是一个宏,它的定义如下:

#define PSEUDO(name, syscall_name, args) \

.text; \

ENTRY (name) \

DO_CALL (syscall_name, args); \

cmpl $-4095, %eax; \

jae SYSCALL_ERROR_LABEL里面对于任何一个系统调用,会调用DO_CALL。这也是一个宏,这个宏32位和64位的定义是不一样的。

4.2 32位系统调用过程

我们先来看32位的情况(i386目录下的sysdep.h文件)。

/* Linux takes system call arguments in registers:

syscall number %eax call-clobbered

arg 1 %ebx call-saved

arg 2 %ecx call-clobbered

arg 3 %edx call-clobbered

arg 4 %esi call-saved

arg 5 %edi call-saved

arg 6 %ebp call-saved

......

*/

#define DO_CALL(syscall_name, args) \

PUSHARGS_##args \

DOARGS_##args \

movl $SYS_ify (syscall_name), %eax; \

ENTER_KERNEL \

POPARGS_##args这里,我们将请求参数放在寄存器里面,根据系统调用的名称,得到系统调用号,放在寄存器eax里面,然后执行ENTER_KERNEL。

在Linux的源代码注释里面,我们可以清晰地看到,这些寄存器是如何传递系统调用号和参数的。

这里面的ENTER_KERNEL是什么呢?

# define ENTER_KERNEL int $0x80int就是interrupt,也就是”中断”的意思。int $0x80就是触发一个软中断,通过它就可以陷入(trap)内核。

在内核启动的时候,还记得有一个trap_init(),其中有这样的代码:

set_system_intr_gate(IA32_SYSCALL_VECTOR, entry_INT80_32);这是一个软中断的陷入门。当接收到一个系统调用的时候,entry_INT80_32就被调用了。

ENTRY(entry_INT80_32)

ASM_CLAC

pushl %eax /* pt_regs->orig_ax */

SAVE_ALL pt_regs_ax=$-ENOSYS /* save rest */

movl %esp, %eax

call do_syscall_32_irqs_on

.Lsyscall_32_done:

......

.Lirq_return:

INTERRUPT_RETURN通过push和SAVE_ALL将当前用户态的寄存器,保存在pt_regs结构里面。

进入内核之前,保存所有的寄存器,然后调用do_syscall_32_irqs_on。它的实现如下:

static __always_inline void do_syscall_32_irqs_on(struct pt_regs *regs)

{

struct thread_info *ti = current_thread_info();

unsigned int nr = (unsigned int)regs->orig_ax;

......

if (likely(nr < IA32_NR_syscalls)) {

regs->ax = ia32_sys_call_table[nr](

(unsigned int)regs->bx, (unsigned int)regs->cx,

(unsigned int)regs->dx, (unsigned int)regs->si,

(unsigned int)regs->di, (unsigned int)regs->bp);

}

syscall_return_slowpath(regs);

}在这里,我们看到,将系统调用号从eax里面取出来,然后根据系统调用号,在系统调用表中找到相应的函数进行调用,并将寄存器中保存的参数取出来,作为函数参数。如果仔细比对,就能发现,这些参数所对应的寄存器,和Linux的注释是一样的。

根据宏定义,#define ia32_sys_call_table sys_call_table,系统调用就是放在这个表里面。至于这个表是如何形成的,我们后面讲。

当系统调用结束之后,在entry_INT80_32之后,紧接着调用的是INTERRUPT_RETURN,我们能够找到它的定义,也就是iret。

#define INTERRUPT_RETURN iretiret指令将原来用户态保存的现场恢复回来,包含代码段、指令指针寄存器等。这时候用户态进程恢复执行。

这里我总结一下32位的系统调用是如何执行的。

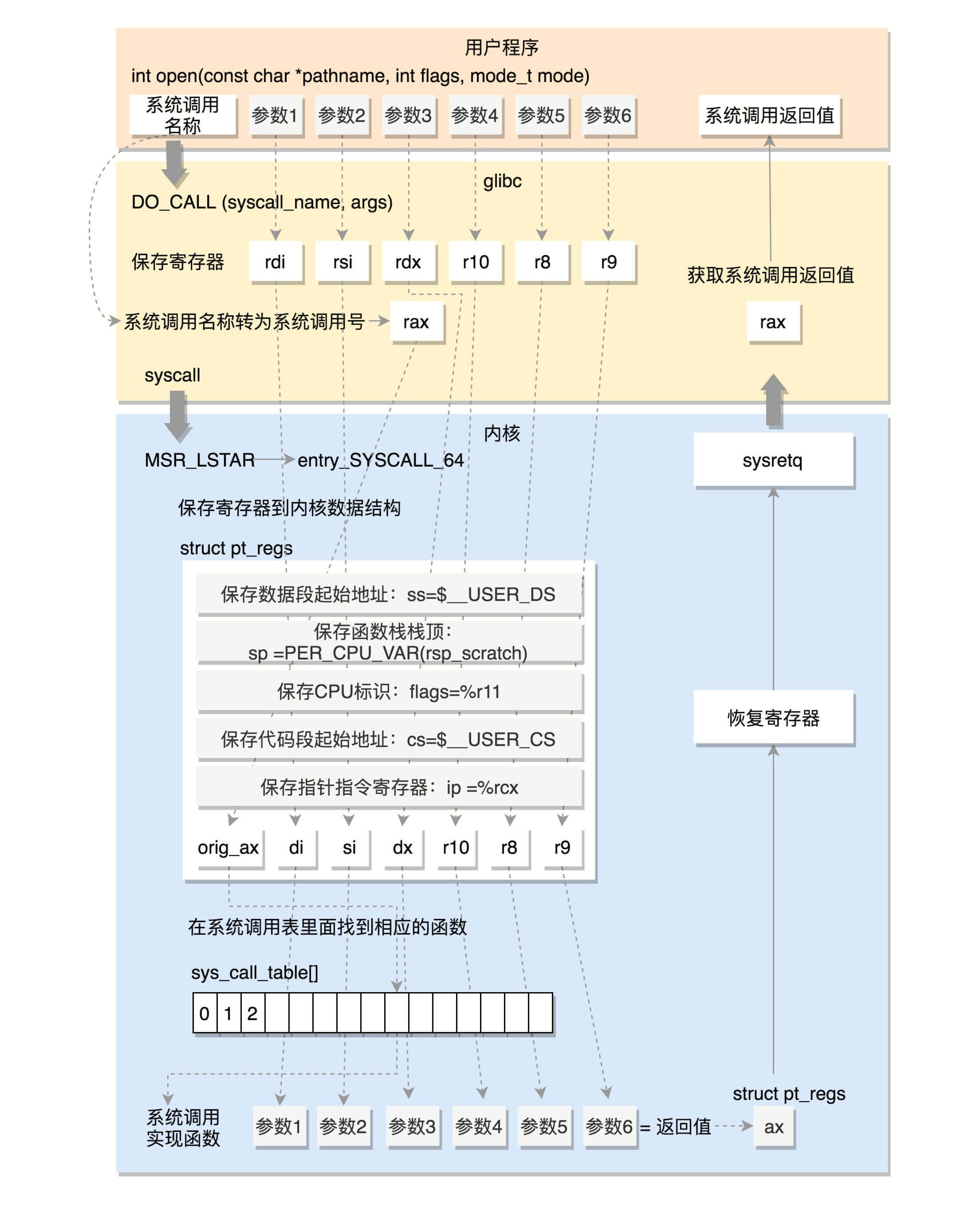

4.3 64位系统调用过程

我们再来看64位的情况(x86_64下的sysdep.h文件)。

/* The Linux/x86-64 kernel expects the system call parameters in

registers according to the following table:

syscall number rax

arg 1 rdi

arg 2 rsi

arg 3 rdx

arg 4 r10

arg 5 r8

arg 6 r9

......

*/

#define DO_CALL(syscall_name, args) \

lea SYS_ify (syscall_name), %rax; \

syscall和之前一样,还是将系统调用名称转换为系统调用号,放到寄存器rax。这里是真正进行调用,不是用中断了,而是改用syscall指令了。并且,通过注释我们也可以知道,传递参数的寄存器也变了。

syscall指令还使用了一种特殊的寄存器,我们叫 特殊模块寄存器(Model Specific Registers,简称MSR) 。这种寄存器是CPU为了完成某些特殊控制功能为目的的寄存器,其中就有系统调用。

在系统初始化的时候,trap_init除了初始化上面的中断模式,这里面还会调用cpu_init->syscall_init。这里面有这样的代码:

wrmsrl(MSR_LSTAR, (unsigned long)entry_SYSCALL_64);rdmsr 和 wrmsr 是用来读写特殊模块寄存器的。MSR_LSTAR就是这样一个特殊的寄存器,当syscall指令调用的时候,会从这个寄存器里面拿出函数地址来调用,也就是调用entry_SYSCALL_64。

在arch/x86/entry/entry_64.S中定义了entry_SYSCALL_64。

ENTRY(entry_SYSCALL_64)

/* Construct struct pt_regs on stack */

pushq $__USER_DS /* pt_regs->ss */

pushq PER_CPU_VAR(rsp_scratch) /* pt_regs->sp */

pushq %r11 /* pt_regs->flags */

pushq $__USER_CS /* pt_regs->cs */

pushq %rcx /* pt_regs->ip */

pushq %rax /* pt_regs->orig_ax */

pushq %rdi /* pt_regs->di */

pushq %rsi /* pt_regs->si */

pushq %rdx /* pt_regs->dx */

pushq %rcx /* pt_regs->cx */

pushq $-ENOSYS /* pt_regs->ax */

pushq %r8 /* pt_regs->r8 */

pushq %r9 /* pt_regs->r9 */

pushq %r10 /* pt_regs->r10 */

pushq %r11 /* pt_regs->r11 */

sub $(6*8), %rsp /* pt_regs->bp, bx, r12-15 not saved */

movq PER_CPU_VAR(current_task), %r11

testl $_TIF_WORK_SYSCALL_ENTRY|_TIF_ALLWORK_MASK, TASK_TI_flags(%r11)

jnz entry_SYSCALL64_slow_path

......

entry_SYSCALL64_slow_path:

/* IRQs are off. */

SAVE_EXTRA_REGS

movq %rsp, %rdi

call do_syscall_64 /* returns with IRQs disabled */

return_from_SYSCALL_64:

RESTORE_EXTRA_REGS

TRACE_IRQS_IRETQ

movq RCX(%rsp), %rcx

movq RIP(%rsp), %r11

movq R11(%rsp), %r11

......

syscall_return_via_sysret:

/* rcx and r11 are already restored (see code above) */

RESTORE_C_REGS_EXCEPT_RCX_R11

movq RSP(%rsp), %rsp

USERGS_SYSRET64这里先保存了很多寄存器到pt_regs结构里面,例如用户态的代码段、数据段、保存参数的寄存器,然后调用entry_SYSCALL64_slow_pat->do_syscall_64。

__visible void do_syscall_64(struct pt_regs *regs)

{

struct thread_info *ti = current_thread_info();

unsigned long nr = regs->orig_ax;

......

if (likely((nr & __SYSCALL_MASK) < NR_syscalls)) {

regs->ax = sys_call_table[nr & __SYSCALL_MASK](

regs->di, regs->si, regs->dx,

regs->r10, regs->r8, regs->r9);

}

syscall_return_slowpath(regs);

}在do_syscall_64里面,从rax里面拿出系统调用号,然后根据系统调用号,在系统调用表sys_call_table中找到相应的函数进行调用,并将寄存器中保存的参数取出来,作为函数参数。如果仔细比对,你就能发现,这些参数所对应的寄存器,和Linux的注释又是一样的。

所以,无论是32位,还是64位,都会到系统调用表sys_call_table这里来。

在研究系统调用表之前,我们看64位的系统调用返回的时候,执行的是USERGS_SYSRET64。定义如下:

#define USERGS_SYSRET64 \

swapgs; \

sysretq;这里,返回用户态的指令变成了sysretq。

我们这里总结一下64位的系统调用是如何执行的。

4.4 系统调用表

32位的系统调用表定义在面arch/x86/entry/syscalls/syscall_32.tbl文件里。例如open是这样定义的:

5 i386 open sys_open compat_sys_open64位的系统调用定义在另一个文件arch/x86/entry/syscalls/syscall_64.tbl里。例如open是这样定义的:

2 common open sys_open第一列的数字是系统调用号。可以看出,32位和64位的系统调用号是不一样的。第三列是系统调用的名字,第四列是系统调用在内核的实现函数。不过,它们都是以sys_开头。

系统调用在内核中的实现函数要有一个声明。声明往往在include/linux/syscalls.h文件中。例如sys_open是这样声明的:

asmlinkage long sys_open(const char __user *filename, int flags, umode_t mode);真正的实现这个系统调用,一般在一个.c文件里面,例如sys_open的实现在fs/open.c里面,但是你会发现样子很奇怪。

SYSCALL_DEFINE3(open, const char __user *, filename, int, flags, umode_t, mode)

{

if (force_o_largefile())

flags |= O_LARGEFILE;

return do_sys_open(AT_FDCWD, filename, flags, mode);

}SYSCALL_DEFINE3是一个宏系统调用最多六个参数,根据参数的数目选择宏。具体是这样定义的:

#define SYSCALL_DEFINE1(name, ...) SYSCALL_DEFINEx(1, _##name, __VA_ARGS__)

#define SYSCALL_DEFINE2(name, ...) SYSCALL_DEFINEx(2, _##name, __VA_ARGS__)

#define SYSCALL_DEFINE3(name, ...) SYSCALL_DEFINEx(3, _##name, __VA_ARGS__)

#define SYSCALL_DEFINE4(name, ...) SYSCALL_DEFINEx(4, _##name, __VA_ARGS__)

#define SYSCALL_DEFINE5(name, ...) SYSCALL_DEFINEx(5, _##name, __VA_ARGS__)

#define SYSCALL_DEFINE6(name, ...) SYSCALL_DEFINEx(6, _##name, __VA_ARGS__)

#define SYSCALL_DEFINEx(x, sname, ...) \

SYSCALL_METADATA(sname, x, __VA_ARGS__) \

__SYSCALL_DEFINEx(x, sname, __VA_ARGS__)

#define __PROTECT(...) asmlinkage_protect(__VA_ARGS__)

#define __SYSCALL_DEFINEx(x, name, ...) \

asmlinkage long sys##name(__MAP(x,__SC_DECL,__VA_ARGS__)) \

__attribute__((alias(__stringify(SyS##name)))); \

static inline long SYSC##name(__MAP(x,__SC_DECL,__VA_ARGS__)); \

asmlinkage long SyS##name(__MAP(x,__SC_LONG,__VA_ARGS__)); \

asmlinkage long SyS##name(__MAP(x,__SC_LONG,__VA_ARGS__)) \

{ \

long ret = SYSC##name(__MAP(x,__SC_CAST,__VA_ARGS__)); \

__MAP(x,__SC_TEST,__VA_ARGS__); \

__PROTECT(x, ret,__MAP(x,__SC_ARGS,__VA_ARGS__)); \

return ret; \

} \

static inline long SYSC##name(__MAP(x,__SC_DECL,__VA_ARGS__)如果我们把宏展开之后,实现如下,和声明的是一样的。

asmlinkage long sys_open(const char __user * filename, int flags, int mode)

{

long ret;

if (force_o_largefile())

flags |= O_LARGEFILE;

ret = do_sys_open(AT_FDCWD, filename, flags, mode);

asmlinkage_protect(3, ret, filename, flags, mode);

return ret;

}声明和实现都好了。接下来,在编译的过程中,需要根据syscall_32.tbl和syscall_64.tbl生成自己的unistd_32.h和unistd_64.h。生成方式在arch/x86/entry/syscalls/Makefile中。

声明和实现都好了。接下来,在编译的过程中,需要根据syscall_32.tbl和syscall_64.tbl生成自己的unistd_32.h和unistd_64.h。生成方式在arch/x86/entry/syscalls/Makefile中。

这里面会使用两个脚本,其中第一个脚本arch/x86/entry/syscalls/syscallhdr.sh,会在文件中生成#define NR_open;第二个脚本arch/x86/entry/syscalls/syscalltbl.sh,会在文件中生成SYSCALL(__NR_open, sys_open)。这样,unistd_32.h和unistd_64.h是对应的系统调用号和系统调用实现函数之间的对应关系。

在文件arch/x86/entry/syscall_32.c,定义了这样一个表,里面include了这个头文件,从而所有的sys_系统调用都在这个表里面了。

__visible const sys_call_ptr_t ia32_sys_call_table[__NR_syscall_compat_max+1] = {

/*

* Smells like a compiler bug -- it doesn't work

* when the & below is removed.

*/

[0 ... __NR_syscall_compat_max] = &sys_ni_syscall,

#include <asm/syscalls_32.h>

};同理,在文件arch/x86/entry/syscall_64.c,定义了这样一个表,里面include了这个头文件,这样所有的sys_系统调用就都在这个表里面了。

/* System call table for x86-64. */

asmlinkage const sys_call_ptr_t sys_call_table[__NR_syscall_max+1] = {

/*

* Smells like a compiler bug -- it doesn't work

* when the & below is removed.

*/

[0 ... __NR_syscall_max] = &sys_ni_syscall,

#include <asm/syscalls_64.h>

};二、进程管理

5. 进程

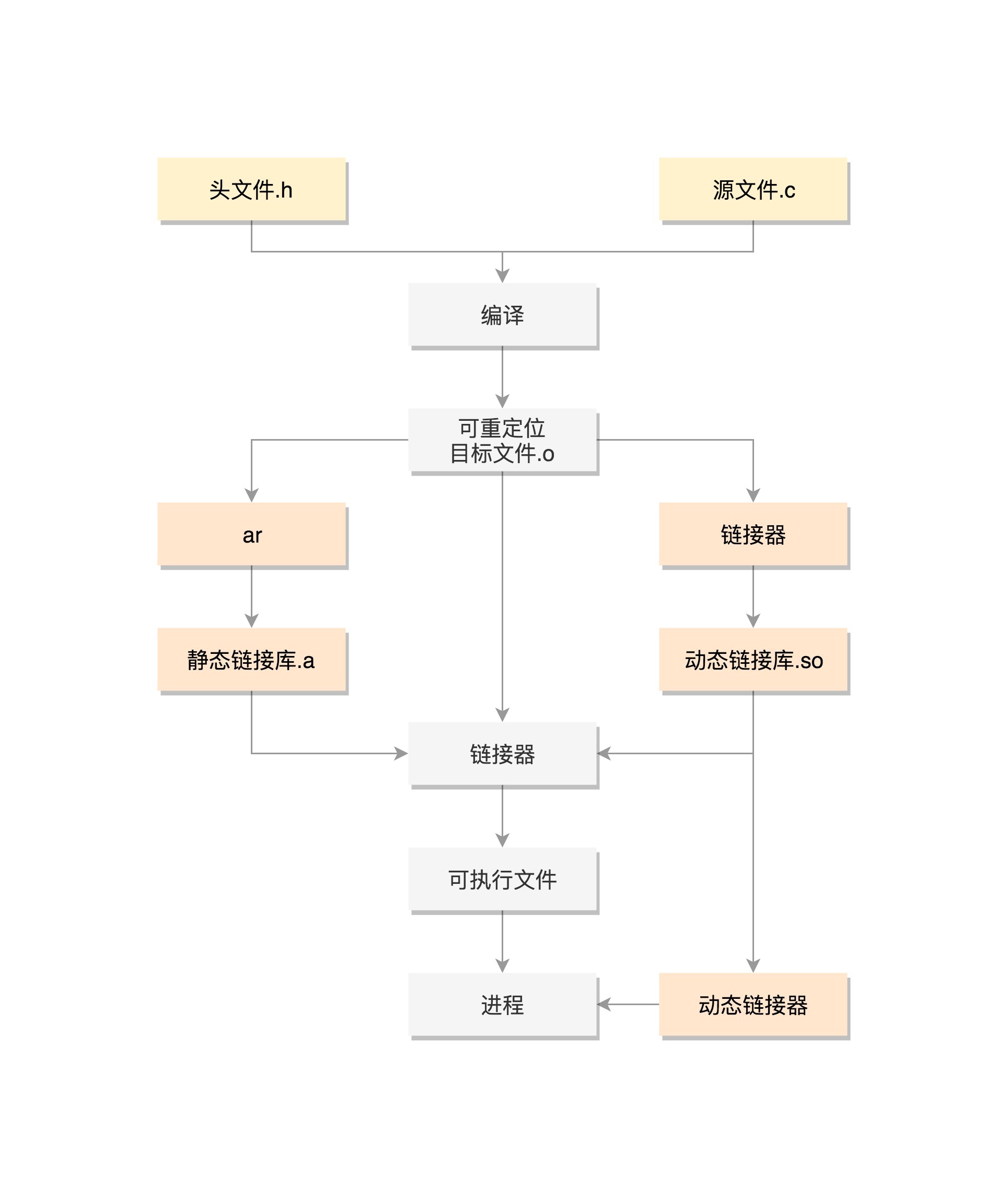

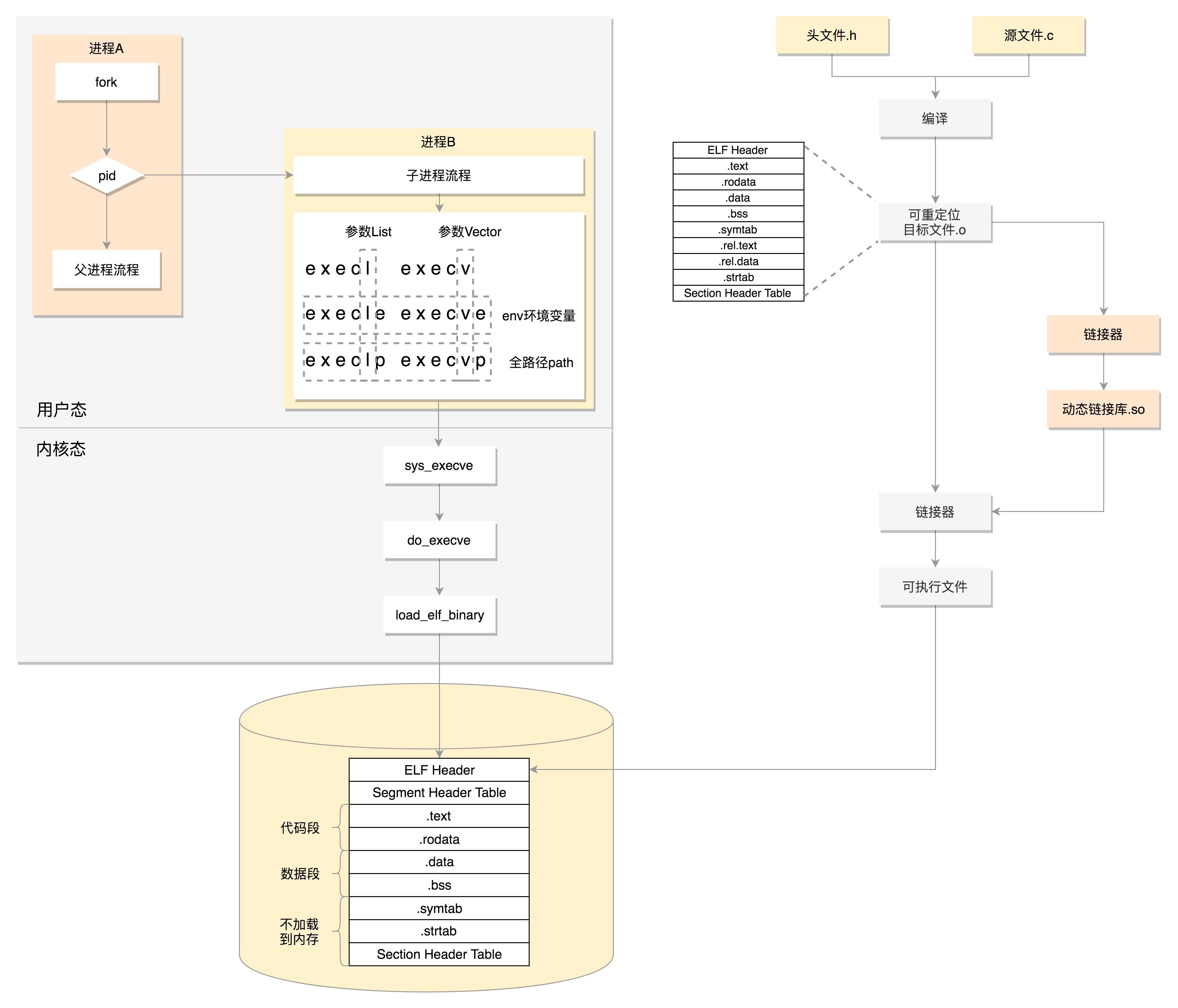

5.1 源码编译

CPU是不能执行文本文件里面的指令的,这些指令只有人能看懂,CPU能够执行的命令是二进制的,比如”0101”这种,所以这些指令还需要翻译一下,这个翻译的过程就是编译(Compile)。

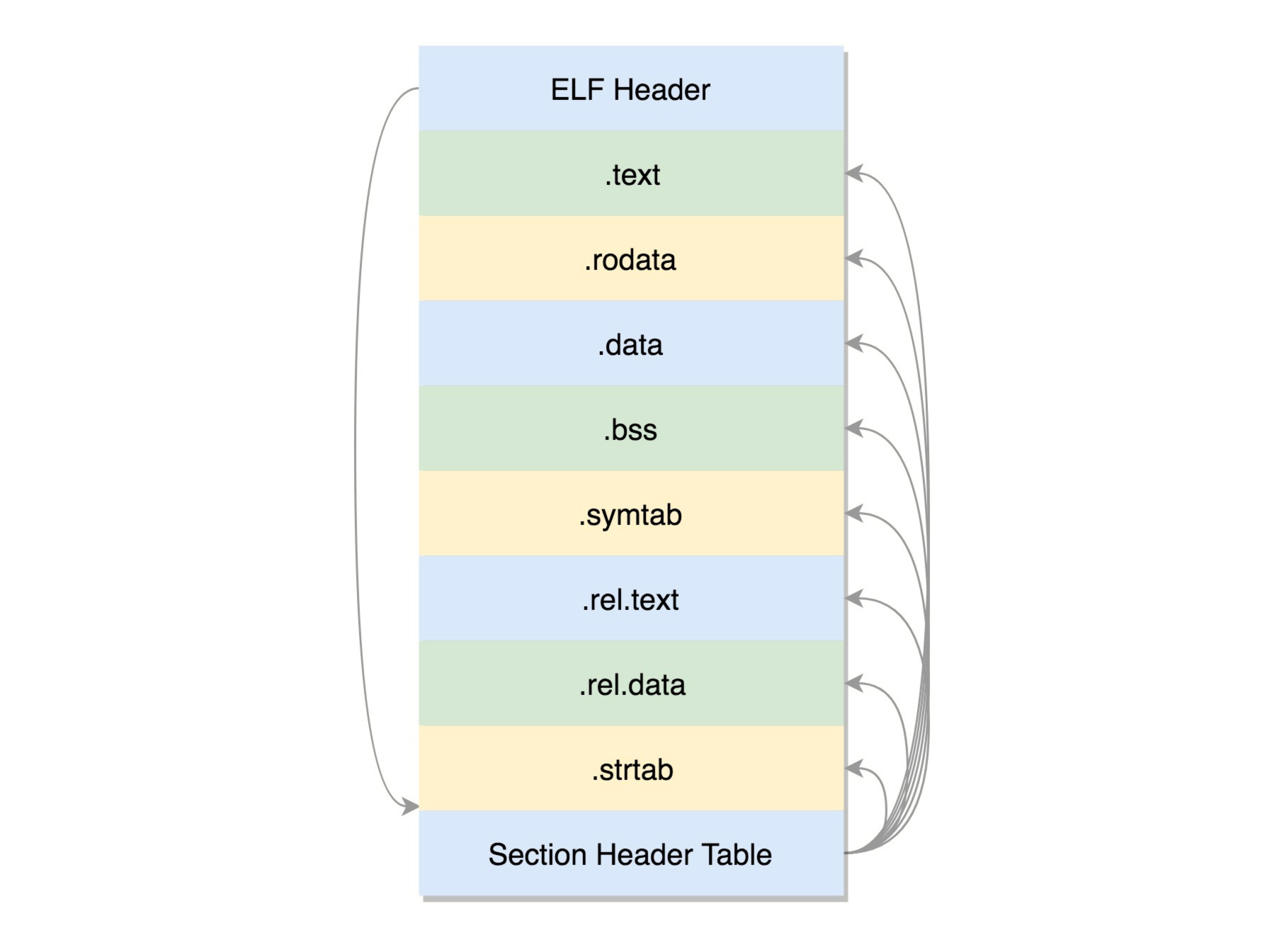

在Linux下面,二进制的程序也要有严格的格式,这个格式我们称为ELF(Executeable and Linkable Format,可执行与可链接格式)。这个格式可以根据编译的结果不同,分为不同的格式。

gcc -c -fPIC mylib.c

gcc -c -fPIC test_mylib.c可重定位文件

在编译的时候,先做预处理工作,例如将头文件嵌入到正文中,将定义的宏展开,然后就是真正的编译过程,最终编译成为.o文件,这就是ELF的第一种类型,可重定位文件(Relocatable File) 。

ELF文件的头是用于描述整个文件的。这个文件格式在内核中有定义,分别为struct elf32_hdr和struct elf64_hdr。

接下来来看一个一个的section,也叫节。

- .text:放编译好的二进制可执行代码

- .data:已经初始化好的全局变量

- .rodata:只读数据,例如字符串常量、const的变量

- .bss:未初始化全局变量,运行时会置0

- .symtab:符号表,记录的则是函数和变量

.strtab:字符串表、字符串常量和变量名

这些节的元数据信息也需要有一个地方保存,就是最后的节头部表(Section Header Table)。在这个表里面,每一个section都有一项,在代码里面也有定义struct elf32_shdr和struct elf64_shdr。在ELF的头里面,有描述这个文件的节头部表的位置,有多少个表项等等信息。

.o里面的位置是不确定的,但是必须是可重新定位的,因为它将来是要做函数库的。有的section,例如.rel.text, .rel.data就与重定位有关。

要想让代码被重用,不能以.o的形式存在,而是要形成库文件,最简单的类型是静态链接库.a文件(Archives),仅仅将一系列对象文件(.o)归档为一个文件,使用命令ar创建。

ar cr libstatic_mylib.a mylib.o虽然这里libstatic_mylib.a里面只有一个.o,但是实际情况可以有多个.o。当有程序要使用这个静态连接库的时候,会将.o文件提取出来,链接到程序中。

可执行文件

gcc -o static_test_mylib test_mylib.o -L. -lstatic_mylib在这个命令里,-L表示在当前目录下找.a文件,-lstatic_mylib会自动补全文件名,比如加前缀lib,后缀.a,变成libstatic_mylib.a,找到这个.a文件后,将里面的mylib.o取出来,和test_mylib.o做一个链接,形成二进制执行文件static_test_mylib。

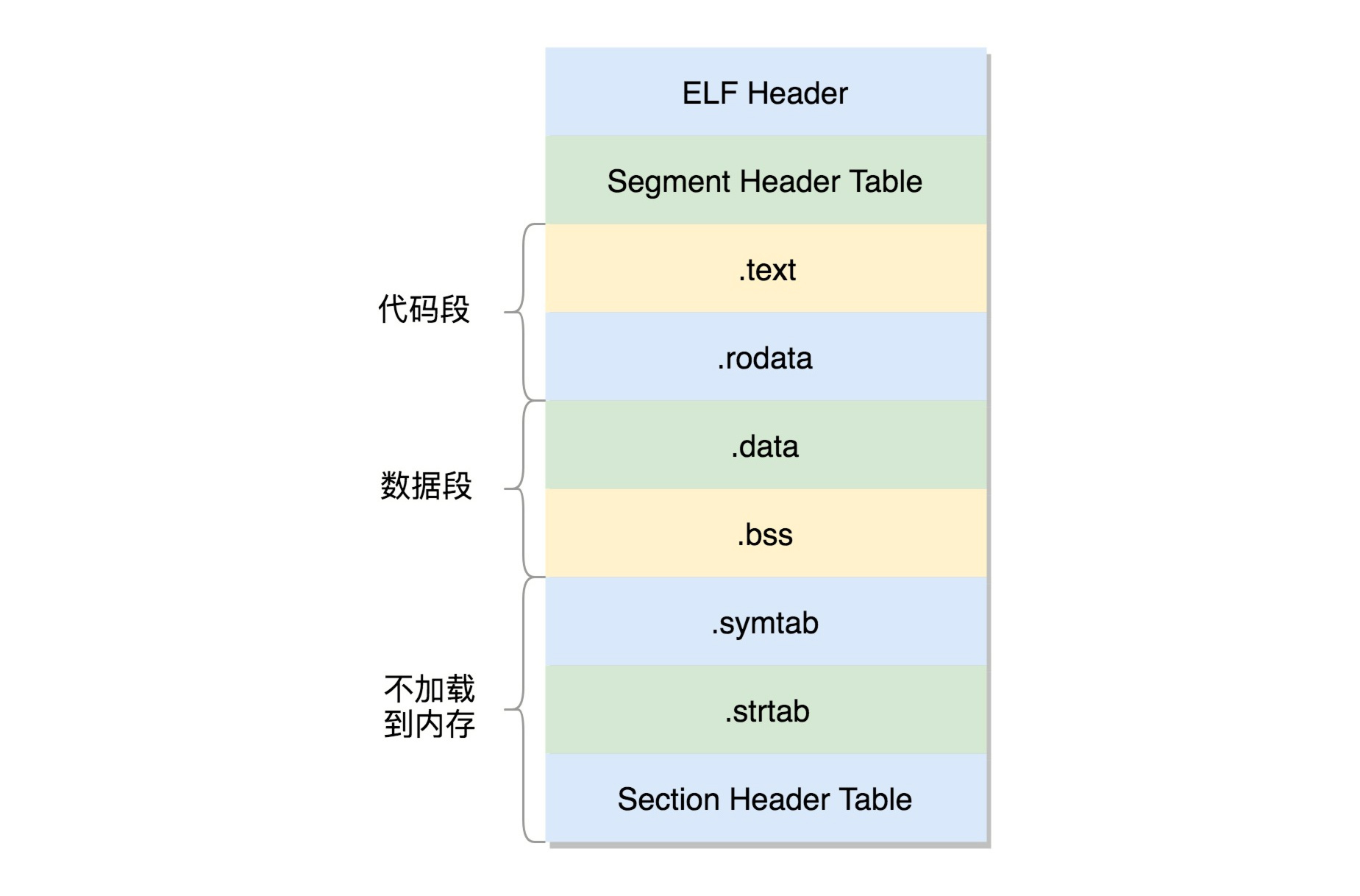

形成的二进制文件叫可执行文件,是ELF的第二种格式,格式如下:

这个格式和.o文件大致相似,还是分成一个个的section,并且被节头表描述。只不过这些section是多个.o文件合并过的。但是这个时候,这个文件已经是马上就可以加载到内存里面执行的文件了,因而这些section被分成了需要加载到内存里面的代码段、数据段和不需要加载到内存里面的部分,将小的section合成了大的段segment,并且在最前面加一个段头表(Segment Header Table)。在代码里面的定义为struct elf32_phdr和struct elf64_phdr,这里面除了有对于段的描述之外,最重要的是p_vaddr,这个是这个段加载到内存的虚拟地址。

在ELF头里面,有一项e_entry,也是个虚拟地址,是这个程序运行的入口。

静态链接库一旦链接进去,代码和变量的section都合并了,因而程序运行的时候,就不依赖于这个库是否存在。但是这样有一个缺点,就是相同的代码段,如果被多个程序使用的话,在内存里面就有多份,而且一旦静态链接库更新了,如果二进制执行文件不重新编译,也不随着更新。

动态链接库

因而就出现了另一种,动态链接库(Shared Libraries),不仅仅是一组对象文件的简单归档,而是多个对象文件的重新组合,可被多个程序共享。

gcc -shared -fPIC -o libdynamic_mylib.so mylib.o当一个动态链接库被链接到一个程序文件中的时候,最后的程序文件并不包括动态链接库中的代码,而仅仅包括对动态链接库的引用,并且不保存动态链接库的全路径,仅仅保存动态链接库的名称。

gcc -o dynamic_test_mylib test_mylib.o -L. -ldynamic_mylib当运行这个程序的时候,首先寻找动态链接库,然后加载它。默认情况下,系统在/lib和/usr/lib文件夹下寻找动态链接库。如果找不到就会报错,我们可以设定LD_LIBRARY_PATH环境变量,程序运行时会在此环境变量指定的文件夹下寻找动态链接库。

动态链接库,就是ELF的第三种类型, 共享对象文件(Shared Object) 。

基于动态连接库创建出来的二进制文件格式还是ELF,但是稍有不同。

首先,多了一个.interp的Segment,这里面是ld-linux.so,这是动态链接器,也就是说,运行时的链接动作都是它做的。

另外,ELF文件中还多了两个section,一个是.plt,过程链接表(Procedure Linkage Table,PLT),一个是.got.plt,全局偏移量表(Global Offset Table,GOT)。

它们是怎么工作的,使得程序运行的时候,可以将so文件动态链接到进程空间的呢?

dynamic_test_mylib这个程序要调用libdynamic_mylib.so里的函数。由于是运行时才去找,编译的时候,压根不知道这个函数在哪里,所以就在PLT里面建立一项PLT[x]。这一项也是一些代码,有点像一个本地的代理,在二进制程序dynamic_test_mylib里面,不直接调用libdynamic_mylib.so里的函数,而是调用PLT[x]里面的代理代码,这个代理代码会在运行的时候找真正的函数。

去哪里找代理代码呢?这就用到了GOT,这里面也会为libdynamic_mylib.so中的函数创建一项GOT[y]。这一项是运行时libdynamic_mylib.so中的函数在内存中真正的地址。

如果这个地址在,dynamic_test_mylib调用PLT[x]里面的代理代码,代理代码调用GOT表中对应项GOT[y],调用的就是加载到内存中的libdynamic_mylib.so里面的对应函数了。

但是GOT怎么知道的呢?对于libdynamic_mylib.so中的函数,GOT一开始就会创建一项GOT[y],但是这里面没有真正的地址,因为它也不知道,但是它有办法,它又回调PLT,告诉它,你里面的代理代码来找我要libdynamic_mylib.so中函数的真实地址,我不知道,你想想办法吧。

PLT这个时候会转而调用PLT[0],也即第一项,PLT[0]转而调用GOT[2],这里面是ld-linux.so的入口函数,这个函数会找到加载到内存中的libdynamic_mylib.so里面的对应函数的地址,然后把这个地址放在GOT[y]里面。下次,PLT[x]的代理函数就能够直接调用了。

5.2 运行程序为进程

在内核中,有这样一个数据结构,用来定义加载二进制文件的方法。

struct linux_binfmt {

struct list_head lh;

struct module *module;

int (*load_binary)(struct linux_binprm *);

int (*load_shlib)(struct file *);

int (*core_dump)(struct coredump_params *cprm);

unsigned long min_coredump; /* minimal dump size */

} __randomize_layout;对于ELF文件格式,有对应的实现。

static struct linux_binfmt elf_format = {

.module = THIS_MODULE,

.load_binary = load_elf_binary,

.load_shlib = load_elf_library,

.core_dump = elf_core_dump,

.min_coredump = ELF_EXEC_PAGESIZE,

};load_elf_binary是不是你很熟悉?没错,我们加载内核镜像的时候,用的也是这种格式。

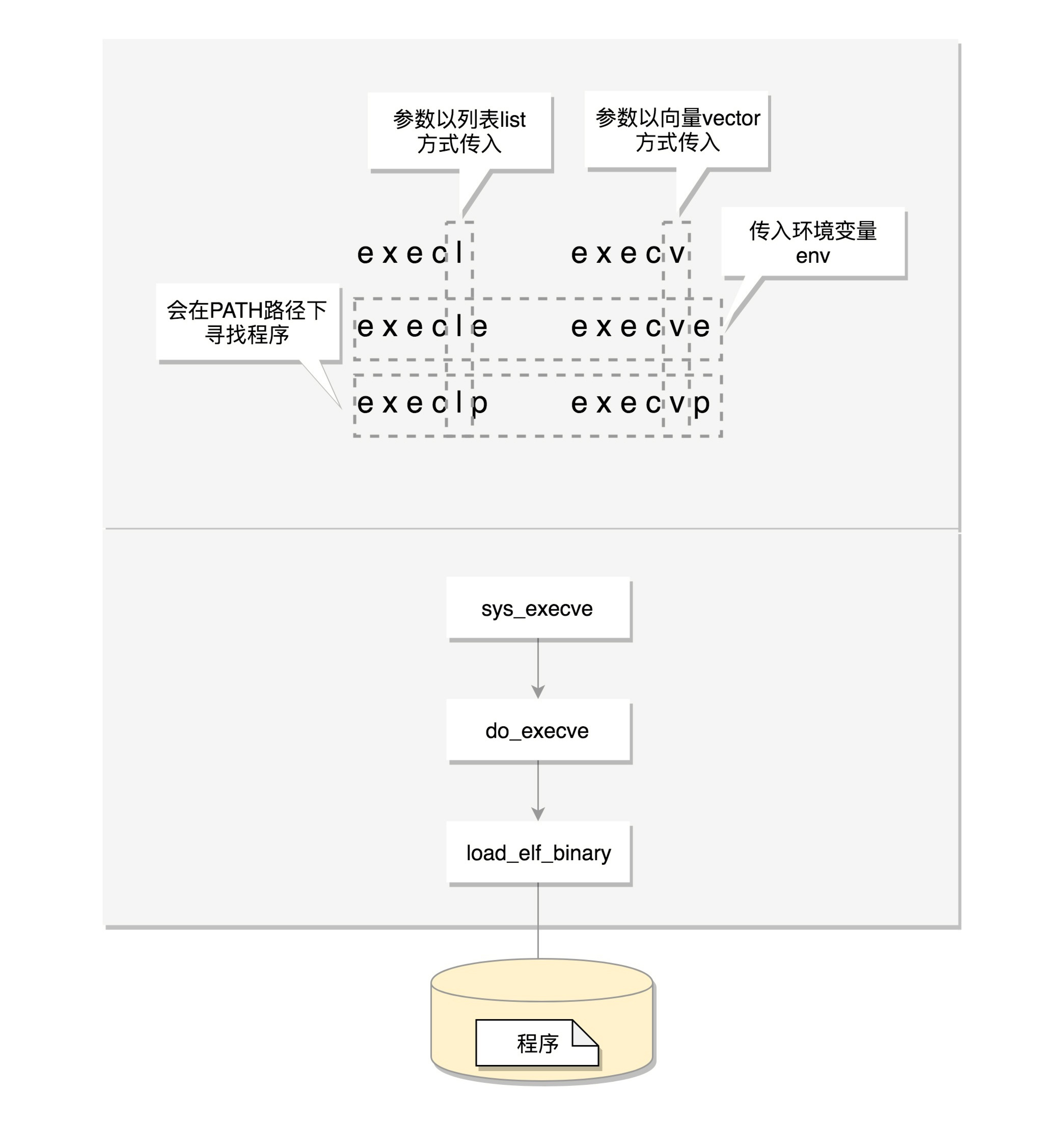

还记得当时是谁调用的load_elf_binary函数吗?具体是这样的:do_execve->do_execveat_common->exec_binprm->search_binary_handler。

那do_execve又是被谁调用的呢?我们看下面的代码。

SYSCALL_DEFINE3(execve,

const char __user *, filename,

const char __user *const __user *, argv,

const char __user *const __user *, envp)

{

return do_execve(getname(filename), argv, envp);

}学过了系统调用一节,你会发现,原理是exec这个系统调用最终调用的load_elf_binary。

exec比较特殊,它是一组函数:

- 包含p的函数(execvp, execlp)会在PATH路径下面寻找程序;

- 不包含p的函数需要输入程序的全路径;

- 包含v的函数(execv, execvp, execve)以数组的形式接收参数;

- 包含l的函数(execl, execlp, execle)以列表的形式接收参数;

- 包含e的函数(execve, execle)以数组的形式接收环境变量。

5.3 进程树

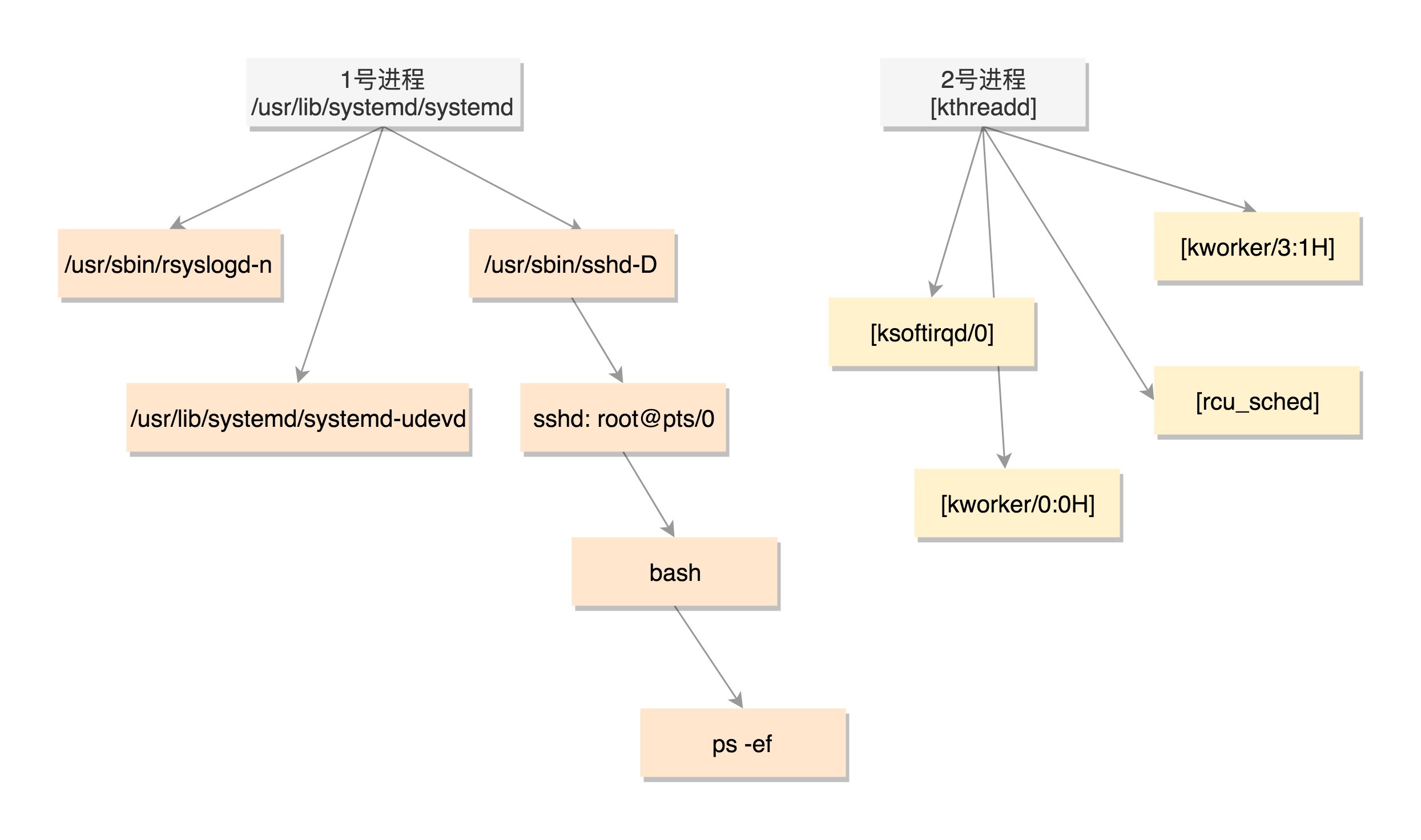

既然所有的进程都是从父进程fork过来的,那总归有一个祖宗进程,这就是咱们系统启动的init进程。

在解析Linux的启动过程的时候,1号进程是/sbin/init。如果在centOS 7里面,我们ls一下,可以看到,这个进程是被软链接到systemd的。

/sbin/init -> ../lib/systemd/systemd系统启动之后,init进程会启动很多的daemon进程,为系统运行提供服务,然后就是启动getty,让用户登录,登录后运行shell,用户启动的进程都是通过shell运行的,从而形成了一棵进程树。

我们可以通过ps -ef命令查看当前系统启动的进程,我们会发现有三类进程。

$ ps -ef

UID PID PPID C STIME TTY TIME CMD

root 1 0 0 2018 ? 00:00:29 /usr/lib/systemd/systemd --system --deserialize 21

root 2 0 0 2018 ? 00:00:00 [kthreadd]

root 3 2 0 2018 ? 00:00:00 [ksoftirqd/0]

root 5 2 0 2018 ? 00:00:00 [kworker/0:0H]

root 9 2 0 2018 ? 00:00:40 [rcu_sched]

......

root 337 2 0 2018 ? 00:00:01 [kworker/3:1H]

root 380 1 0 2018 ? 00:00:00 /usr/lib/systemd/systemd-udevd

root 415 1 0 2018 ? 00:00:01 /sbin/auditd

root 498 1 0 2018 ? 00:00:03 /usr/lib/systemd/systemd-logind

......

root 852 1 0 2018 ? 00:06:25 /usr/sbin/rsyslogd -n

root 2580 1 0 2018 ? 00:00:00 /usr/sbin/sshd -D

root 29058 2 0 Jan03 ? 00:00:01 [kworker/1:2]

root 29672 2 0 Jan04 ? 00:00:09 [kworker/2:1]

root 30467 1 0 Jan06 ? 00:00:00 /usr/sbin/crond -n

root 31574 2 0 Jan08 ? 00:00:01 [kworker/u128:2]

......

root 32792 2580 0 Jan10 ? 00:00:00 sshd: root@pts/0

root 32794 32792 0 Jan10 pts/0 00:00:00 -bash

root 32901 32794 0 00:01 pts/0 00:00:00 ps -ef你会发现,PID 1的进程就是我们的init进程systemd,PID 2的进程是内核线程kthreadd,这两个我们在内核启动的时候都见过。其中用户态的不带中括号,内核态的带中括号。

接下来进程号依次增大,但是你会看所有带中括号的内核态的进程,祖先都是2号进程。而用户态的进程,祖先都是1号进程。tty那一列,是问号的,说明不是前台启动的,一般都是后台的服务。

pts的父进程是sshd,bash的父进程是pts,ps -ef这个命令的父进程是bash。这样整个链条都比较清晰了。

5.4 总结

我们首先通过图右边的文件编译过程,生成so文件和可执行文件,放在硬盘上。下图左边的用户态的进程A执行fork,创建进程B,在进程B的处理逻辑中,执行exec系列系统调用。这个系统调用会通过load_elf_binary方法,将刚才生成的可执行文件,加载到进程B的内存中执行。

6. 线程

6.1 为什么要有线程?

对于任何一个进程来讲,即便我们没有主动去创建线程,进程也是默认有一个主线程的。线程是负责执行二进制指令的,一行一行执行下去。进程要比线程管的宽多了,除了执行指令之外,内存、文件系统等等都要它来管。

进程相当于一个项目,而线程就是为了完成项目需求,而建立的一个个开发任务。

使用进程实现并行执行的问题也有两个。第一,创建进程占用资源太多;第二,进程之间的通信需要数据在不同的内存空间传来传去,无法共享。

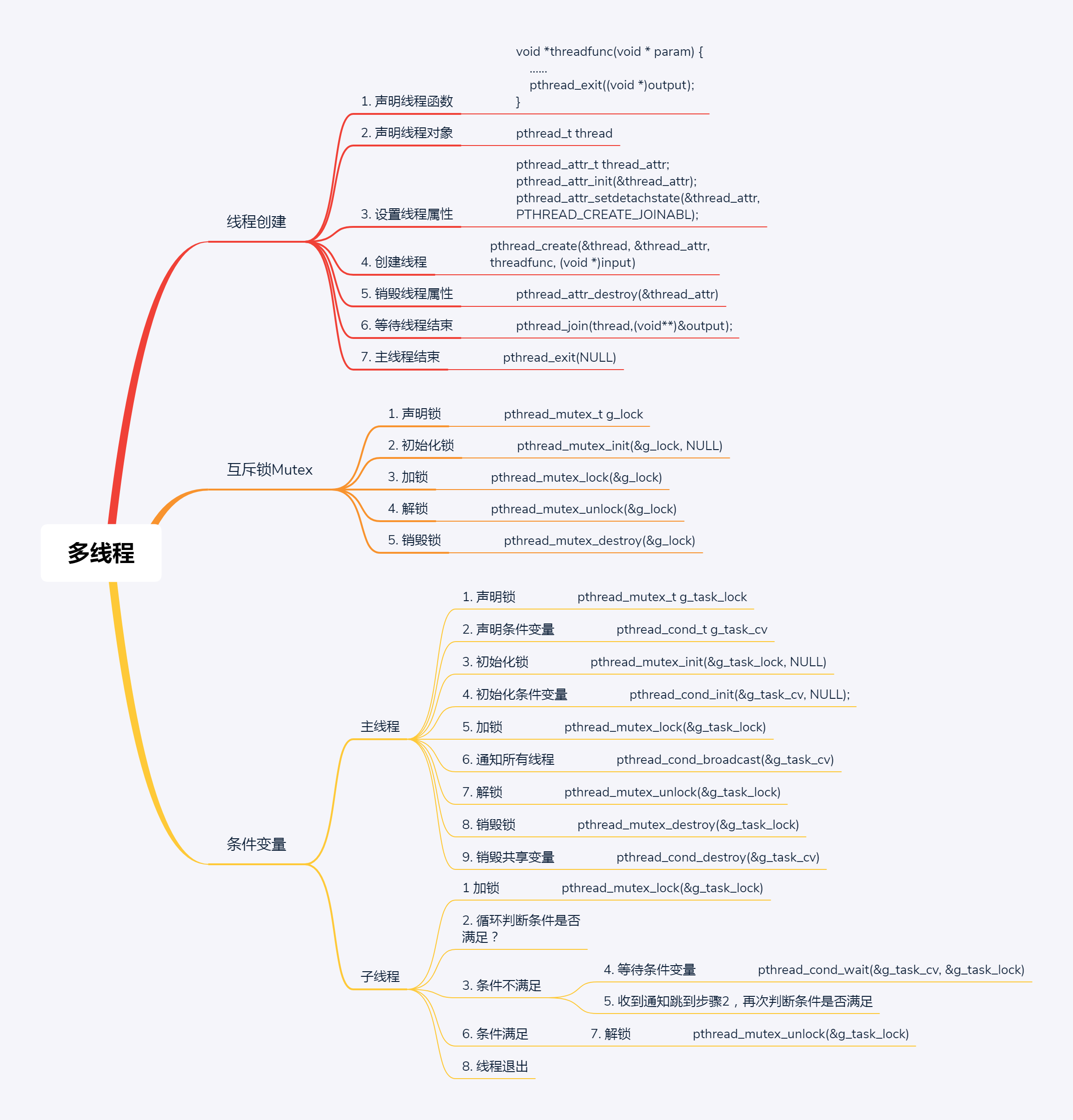

6.2 如何创建线程?

#include <pthread.h>

#include <stdio.h>

#include <stdlib.h>

#define NUM_OF_TASKS 5

void *downloadfile(void *filename)

{

printf("I am downloading the file %s!\n", (char *)filename);

sleep(10);

long downloadtime = rand()%100;

printf("I finish downloading the file within %d minutes!\n", downloadtime);

pthread_exit((void *)downloadtime);

}

int main(int argc, char *argv[])

{

char files[NUM_OF_TASKS][20]={"file1.avi","file2.rmvb","file3.mp4","file4.wmv","file5.flv"};

pthread_t threads[NUM_OF_TASKS];

int rc;

int t;

int downloadtime;

pthread_attr_t thread_attr;

pthread_attr_init(&thread_attr);

pthread_attr_setdetachstate(&thread_attr,PTHREAD_CREATE_JOINABL);

for(t=0;t<NUM_OF_TASKS;t++){

printf("creating thread %d, please help me to download %s\n", t, files[t]);

rc = pthread_create(&threads[t], &thread_attr, downloadfile, (void *)files[t]);

if (rc){

printf("ERROR; return code from pthread_create() is %d\n", rc);

exit(-1);

}

}

pthread_attr_destroy(&thread_attr);

for(t=0;t<NUM_OF_TASKS;t++){

pthread_join(threads[t],(void**)&downloadtime);

printf("Thread %d downloads the file %s in %d minutes.\n",t,files[t],downloadtime);

}

pthread_exit(NULL);

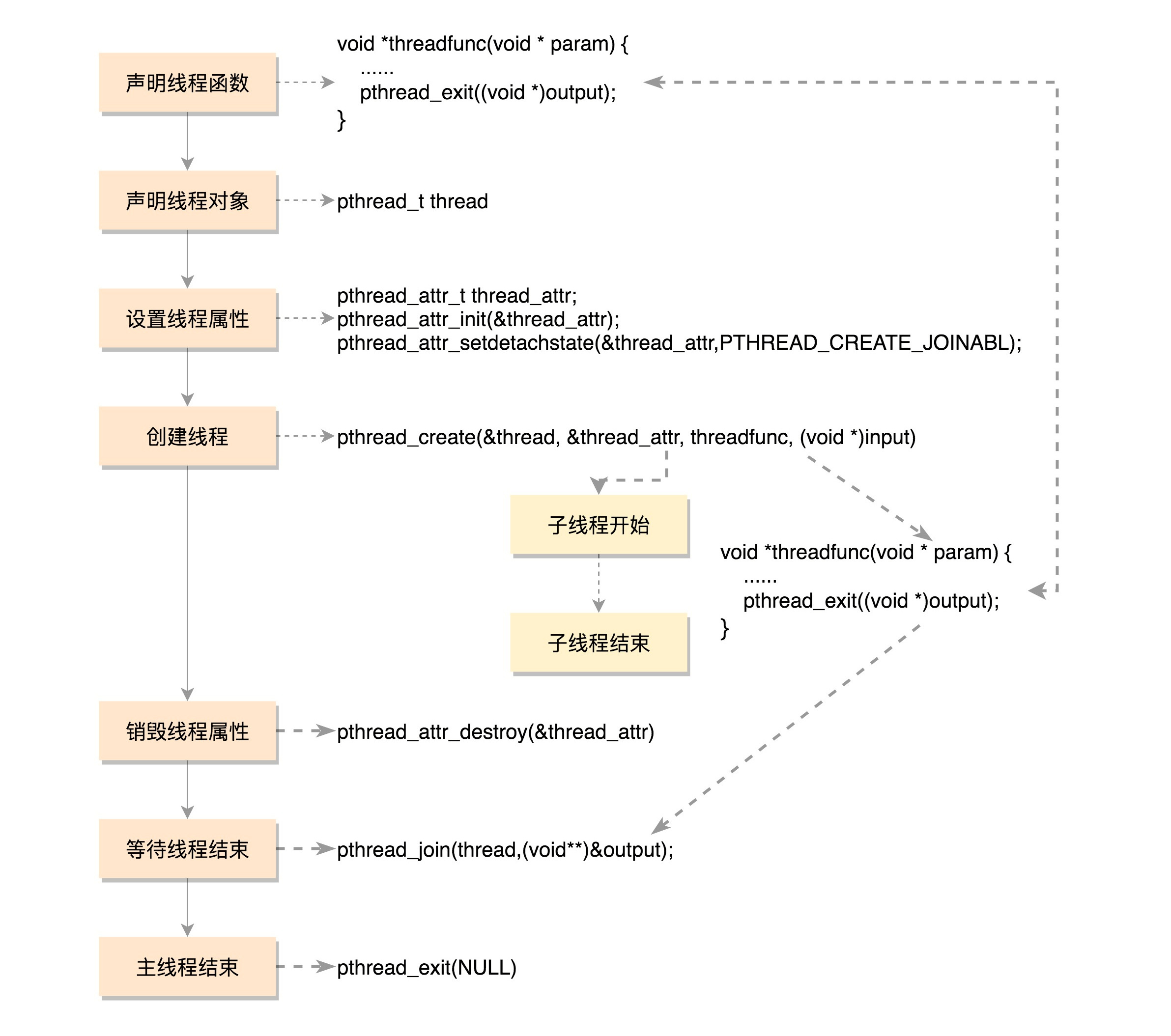

}一个运行中的线程可以调用pthread_exit退出线程。这个函数可以传入一个参数转换为(void *)类型。这是线程退出的返回值。

接下来,我们来看主线程。在这里面,我列了五个文件名。接下来声明了一个数组,里面有五个pthread_t类型的线程对象。

接下来,声明一个线程属性pthread_attr_t。我们通过pthread_attr_init初始化这个属性,并且设置属性PTHREAD_CREATE_JOINABLE。这表示将来主线程程等待这个线程的结束,并获取退出时的状态。

接下来是一个循环。对于每一个文件和每一个线程,可以调用pthread_create创建线程。一共有四个参数,第一个参数是线程对象,第二个参数是线程的属性,第三个参数是线程运行函数,第四个参数是线程运行函数的参数。主线程就是通过第四个参数,将自己的任务派给子线程。

任务分配完毕,每个线程下载一个文件,接下来主线程要做的事情就是等待这些子任务完成。当一个线程退出的时候,就会发送信号给其他所有同进程的线程。有一个线程使用pthread_join获取这个线程退出的返回值。线程的返回值通过pthread_join传给主线程,这样子线程就将自己下载文件所耗费的时间,告诉给主线程。

好了,程序写完了,开始编译。多线程程序要依赖于libpthread.so。

gcc download.c -lpthread总结一下,一个普通线程的创建和运行过程。

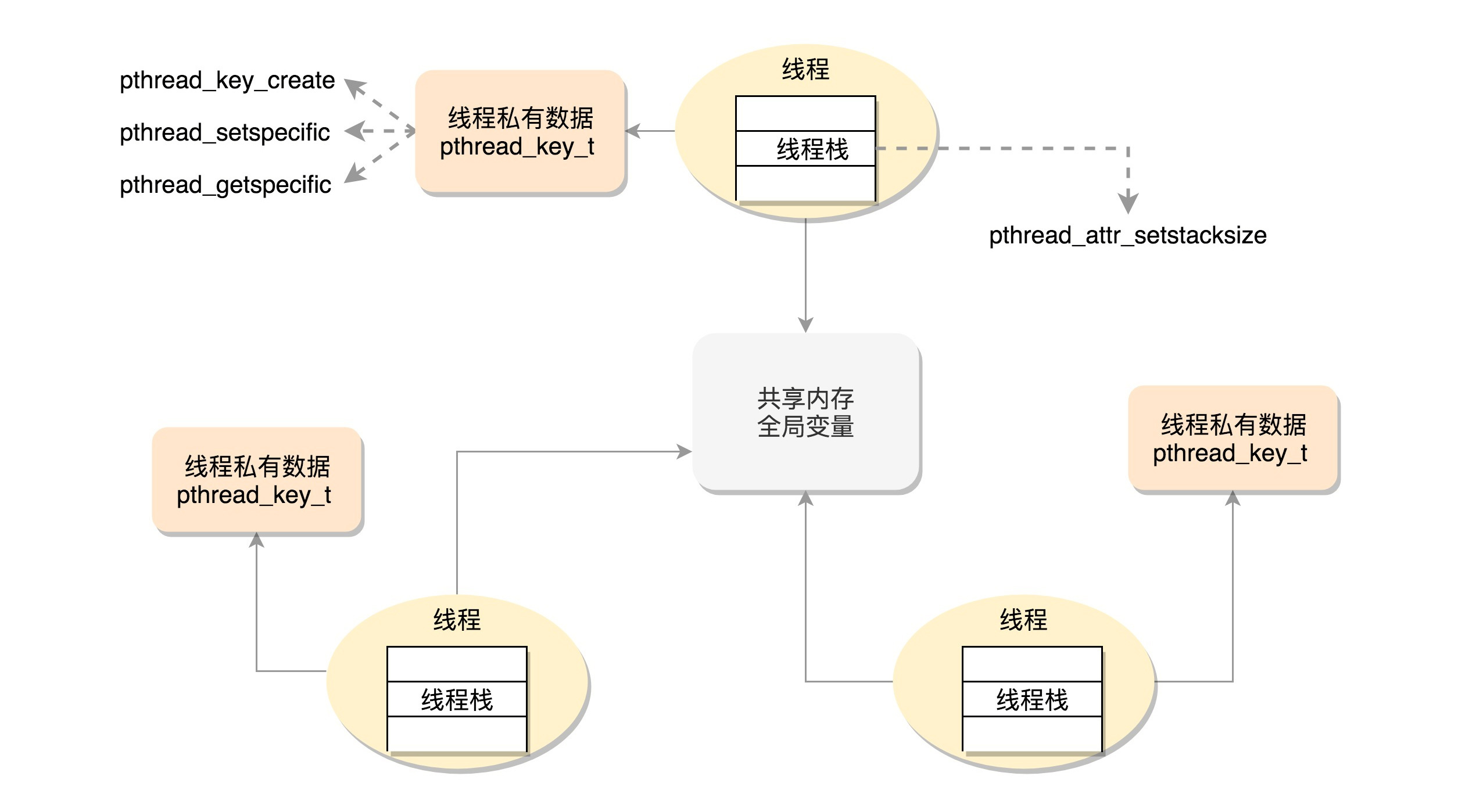

6.3 线程的数据

我们把线程访问的数据细分成三类。

线程栈上的本地数据

比如函数执行过程中的局部变量。前面我们说过,函数的调用会使用栈的模型,这在线程里面是一样的。只不过每个线程都有自己的栈空间。

栈的大小可以通过命令ulimit -a查看,默认情况下线程栈大小为8192(8MB)。我们可以使用命令ulimit -s修改。

对于线程栈,可以通过下面这个函数pthread_attr_t,修改线程栈的大小。

int pthread_attr_setstacksize(pthread_attr_t *attr, size_t stacksize);主线程在内存中有一个栈空间,其他线程栈也拥有独立的栈空间。为了避免线程之间的栈空间踩踏,线程栈之间还会有小块区域,用来隔离保护各自的栈空间。一旦另一个线程踏入到这个隔离区,就会引发段错误。

在整个进程里共享的全局数据

例如全局变量,虽然在不同进程中是隔离的,但是在一个进程中是共享的。

线程私有数据(Thread Specific Data)

可以通过以下函数创建:

int pthread_key_create(pthread_key_t *key, void (*destructor)(void*))可以看到,创建一个key,伴随着一个析构函数。

key一旦被创建,所有线程都可以访问它,但各线程可根据自己的需要往key中填入不同的值,这就相当于提供了一个同名而不同值的全局变量。

我们可以通过下面的函数设置key对应的value。

int pthread_setspecific(pthread_key_t key, const void *value)我们还可以通过下面的函数获取key对应的value。

void *pthread_getspecific(pthread_key_t key)而等到线程退出的时候,就会调用析构函数释放value。

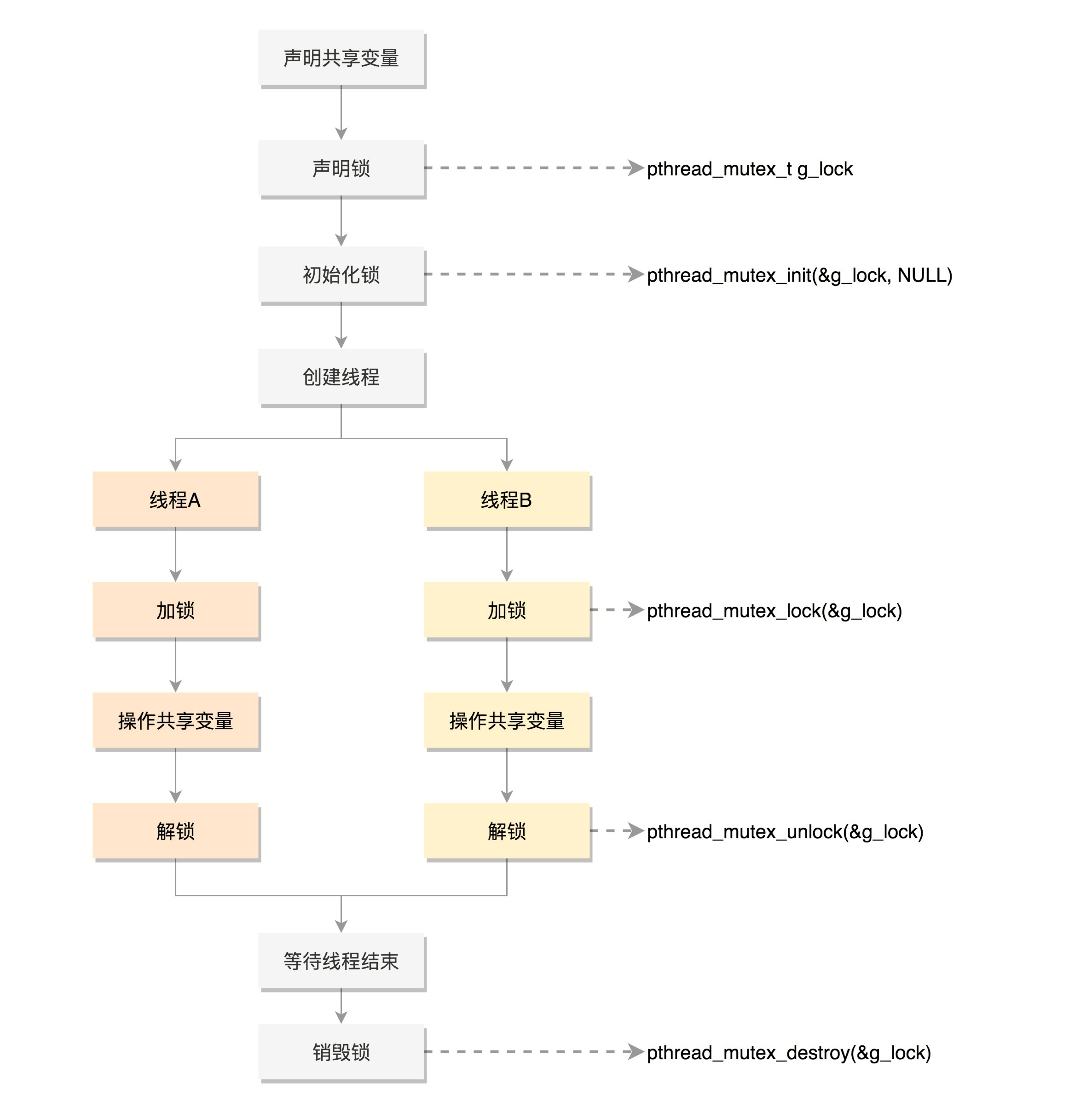

6.4 数据的保护

Mutex,全称Mutual Exclusion,中文叫互斥。顾名思义,有你没我,有我没你。它的模式就是在共享数据访问的时候,去申请加把锁,谁先拿到锁,谁就拿到了访问权限,其他人就只好在门外等着,等这个人访问结束,把锁打开,其他人再去争夺,还是遵循谁先拿到谁访问。

使用Mutex,首先要使用pthread_mutex_init函数初始化这个mutex,初始化后,就可以用它来保护共享变量了。

pthread_mutex_lock() 就是去抢那把锁的函数,如果抢到了,就可以执行下一行程序,对共享变量进行访;如果没抢到,就被阻塞在那里等待。

如果不想被阻塞,可以使用pthread_mutex_trylock去抢那把锁,如果抢到了,就可以执行下一行程序,对共享变量进行访问;如果没抢到,不会被阻塞,而是返回一个错误码。

当共享数据访问结束了,别忘了使用pthread_mutex_unlock释放锁,让给其他人使用,最终调用pthread_mutex_destroy销毁掉这把锁。

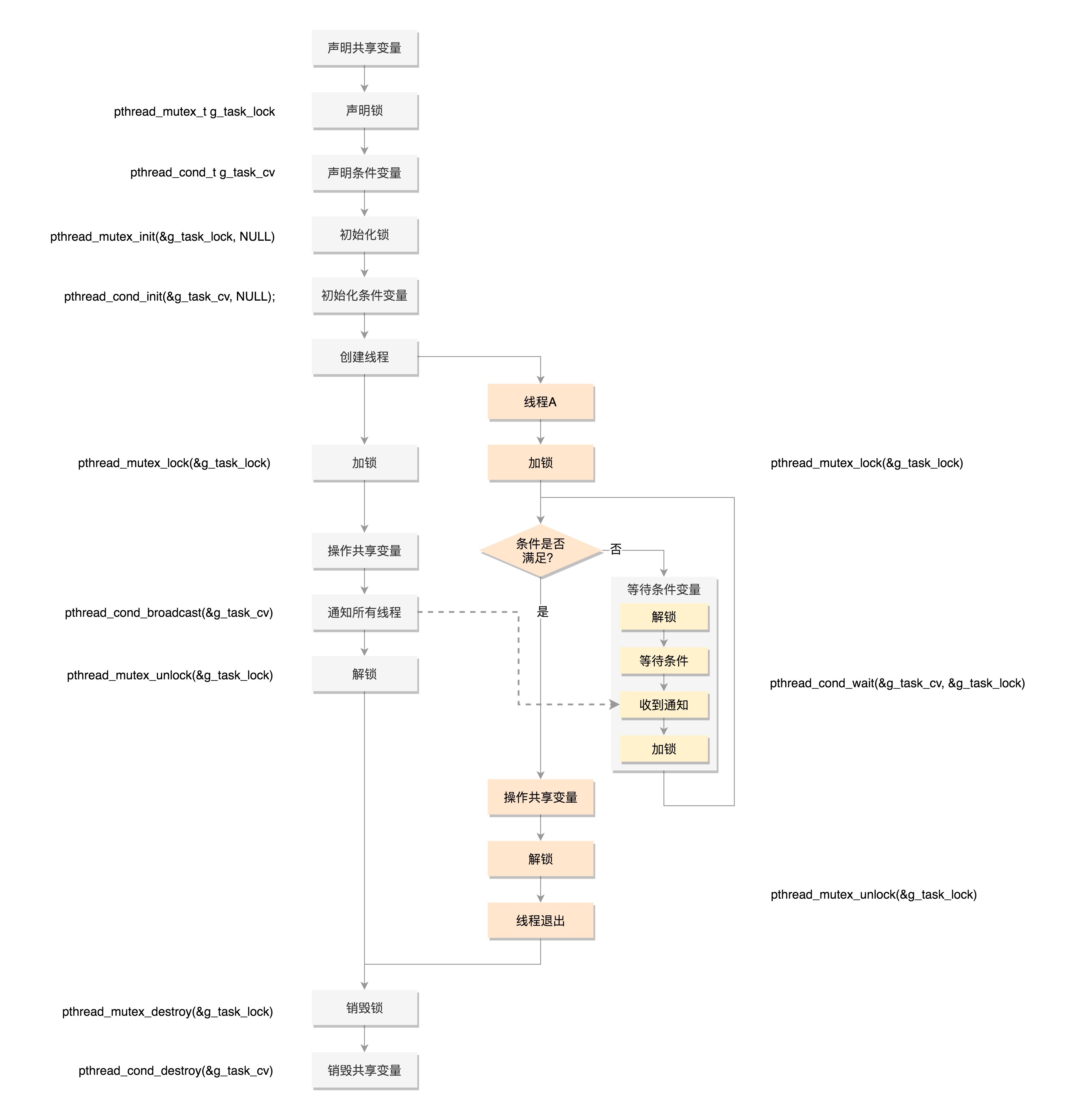

在使用Mutex的时候,有个问题是如果使用pthread_mutex_lock(),那就需要一直在那里等着。如果是pthread_mutex_trylock(),就可以不用等着,去干点儿别的,但是我怎么知道什么时候回来再试一下,是不是轮到我了呢?能不能在轮到我的时候,通知我一下呢?

这其实就是条件变量,也就是说如果没事儿,就让大家歇着,有事儿了就去通知,别让人家没事儿就来问问,浪费大家的时间。

但是当它接到了通知,来操作共享资源的时候,还是需要抢互斥锁,因为可能很多人都受到了通知,都来访问了,所以 条件变量和互斥锁是配合使用的 。

6.5 总结

7. 进程数据结构(上)

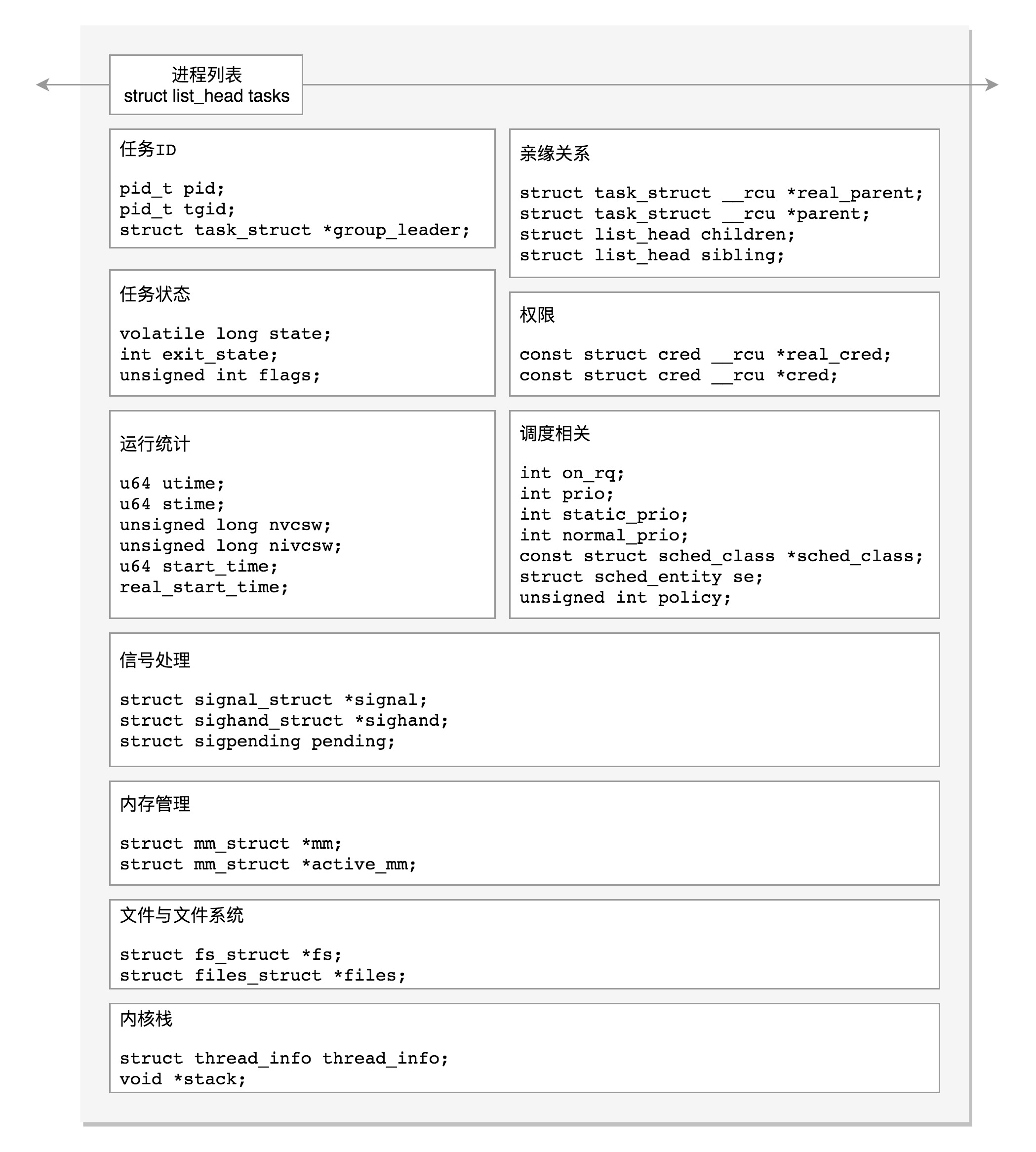

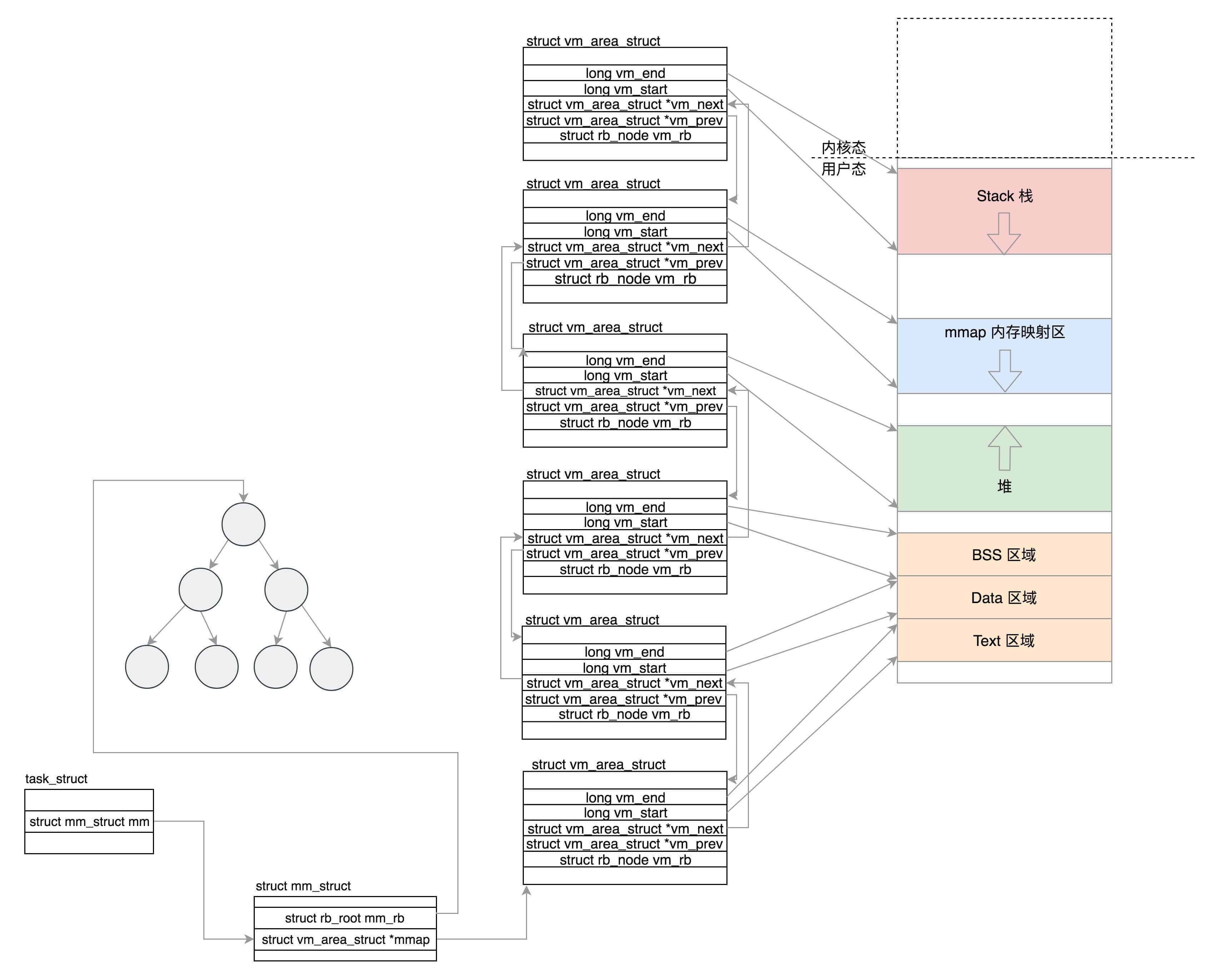

在Linux里面,无论是进程,还是线程,到了内核里面,我们统一都叫任务(Task),由一个统一的结构task_struct进行管理。

Linux内核有一个链表,将所有的task_struct串起来。

struct list_head tasks;接下来,我们来看每一个任务都应该包含哪些字段。

7.1 任务ID

每一个任务都应该有一个ID,作为这个任务的唯一标识。到时候排期啊、下发任务啊等等,都按ID来,就不会产生歧义。

task_struct里面涉及任务ID的,有下面几个:

pid_t pid;

pid_t tgid;

struct task_struct *group_leader;你可能觉得奇怪,既然是ID,有一个就足以做唯一标识了,这个怎么看起来这么麻烦?这是因为,上面的进程和线程到了内核这里,统一变成了任务,这就带来两个问题。

任务展示

前面我们学习命令行的时候,知道ps命令可以展示出所有的进程。但是如果你是这个命令的实现者,到了内核,按照上面的任务列表把这些命令都显示出来,把所有的线程全都平摊开来显示给用户。用户肯定觉得既复杂又困惑。复杂在于,列表这么长;困惑在于,里面出现了很多并不是自己创建的线程。

给任务下发指令

可以通过kill来给进程发信号,通知进程退出。如果发给了其中一个线程,我们就不能只退出这个线程,而是应该退出整个进程。当然,有时候,我们希望只给某个线程发信号。

所以在内核中,它们虽然都是任务,但是应该加以区分。其中,pid是process id,tgid是thread group ID。

任何一个进程,如果只有主线程,那pid是自己,tgid是自己,group_leader指向的还是自己。

但是,如果一个进程创建了其他线程,那就会有所变化了。线程有自己的pid,tgid就是进程的主线程的pid,group_leader指向的就是进程的主线程。

好了,有了tgid,我们就知道tast_struct代表的是一个进程还是代表一个线程了。

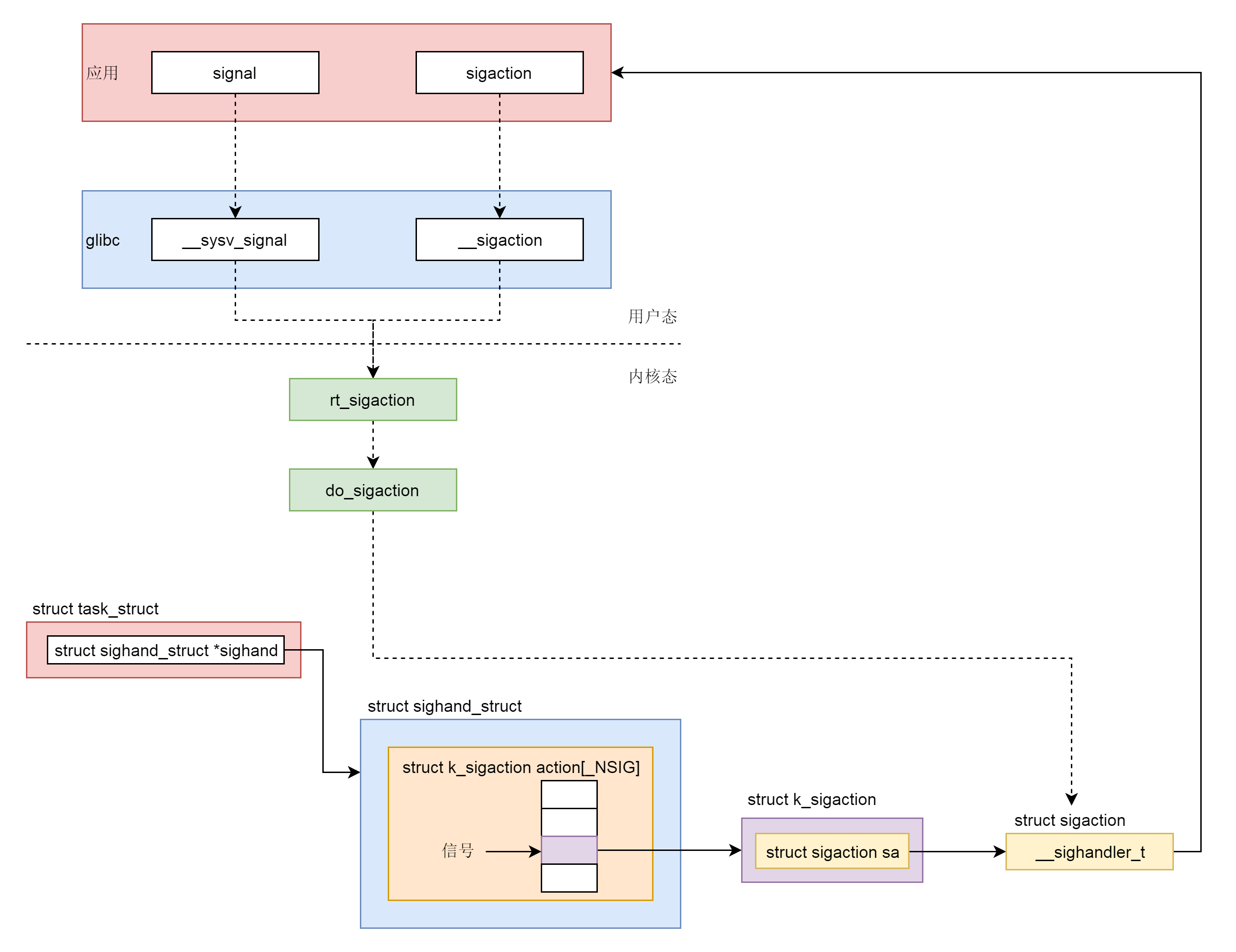

7.2 信号处理

task_struct里面关于信号处理的字段。

/* Signal handlers: */

struct signal_struct *signal;

struct sighand_struct *sighand;

sigset_t blocked;

sigset_t real_blocked;

sigset_t saved_sigmask;

struct sigpending pending;

unsigned long sas_ss_sp;

size_t sas_ss_size;

unsigned int sas_ss_flags;这里定义了哪些信号被阻塞暂不处理(blocked),哪些信号尚等待处理(pending),哪些信号正在通过信号处理函数进行处理(sighand)。处理的结果可以是忽略,可以是结束进程等等。

信号处理函数默认使用用户态的函数栈,当然也可以开辟新的栈专门用于信号处理,这就是sas_ss_xxx这三个变量的作用。

上面我说了下发信号的时候,需要区分进程和线程。从这里我们其实也能看出一些端倪。

task_struct里面有一个struct sigpending pending。如果我们进入struct signal_struct *signal去看的话,还有一个struct sigpending shared_pending。它们一个是本任务的,一个是线程组共享的。

7.3 任务状态

在task_struct里面,涉及任务状态的是下面这几个变量:

volatile long state; /* -1 unrunnable, 0 runnable, >0 stopped */

int exit_state;

unsigned int flags;state(状态)可以取的值定义在include/linux/sched.h头文件中。

/* Used in tsk->state: */

#define TASK_RUNNING 0

#define TASK_INTERRUPTIBLE 1

#define TASK_UNINTERRUPTIBLE 2

#define __TASK_STOPPED 4

#define __TASK_TRACED 8

/* Used in tsk->exit_state: */

#define EXIT_DEAD 16

#define EXIT_ZOMBIE 32

#define EXIT_TRACE (EXIT_ZOMBIE | EXIT_DEAD)

/* Used in tsk->state again: */

#define TASK_DEAD 64

#define TASK_WAKEKILL 128

#define TASK_WAKING 256

#define TASK_PARKED 512

#define TASK_NOLOAD 1024

#define TASK_NEW 2048

#define TASK_STATE_MAX 4096从定义的数值很容易看出来,flags是通过bitset的方式设置的也就是说,当前是什么状态,哪一位就置一。

TASK_RUNNING并不是说进程正在运行,而是表示进程在时刻准备运行的状态。当处于这个状态的进程获得时间片的时候,就是在运行中;如果没有获得时间片,就说明它被其他进程抢占了,在等待再次分配时间片。

在运行中的进程,一旦要进行一些I/O操作,需要等待I/O完毕,这个时候会释放CPU,进入睡眠状态。

在Linux中,有两种睡眠状态。

TASK_INTERRUPTIBLE,可中断的睡眠状态。

这是一种浅睡眠的状态,也就是说,虽然在睡眠,等待I/O完成,但是这个时候一个信号来的时候,进程还是要被唤醒。只不过唤醒后,不是继续刚才的操作,而是进行信号处理。当然程序员可以根据自己的意愿,来写信号处理函数,例如收到某些信号,就放弃等待这个I/O操作完成,直接退出,也可也收到某些信息,继续等待。

TASK_UNINTERRUPTIBLE,不可中断的睡眠状态。

这是一种深度睡眠状态,不可被信号唤醒,只能死等I/O操作完成。一旦I/O操作因为特殊原因不能完成,这个时候,谁也叫不醒这个进程了。你可能会说,我kill它呢?别忘了,kill本身也是一个信号,既然这个状态不可被信号唤醒,kill信号也被忽略了。除非重启电脑,没有其他办法。

因此,这其实是一个比较危险的事情,除非程序员极其有把握,不然还是不要设置成TASK_UNINTERRUPTIBLE。

于是,我们就有了一种新的进程睡眠状态,TASK_KILLABLE,可以终止的新睡眠状态。进程处于这种状态中,它的运行原理类似TASK_UNINTERRUPTIBLE,只不过可以响应致命信号。

从定义可以看出,TASK_WAKEKILL用于在接收到致命信号时唤醒进程,而TASK_KILLABLE相当于这两位都设置了。

#define TASK_KILLABLE (TASK_WAKEKILL | TASK_UNINTERRUPTIBLE)TASK_STOPPED是在进程接收到SIGSTOP、SIGTTIN、SIGTSTP或者SIGTTOU信号之后进入该状态。

TASK_TRACED表示进程被debugger等进程监视,进程执行被调试程序所停止。当一个进程被另外的进程所监视,每一个信号都会让进程进入该状态。

一旦一个进程要结束,先进入的是EXIT_ZOMBIE状态,但是这个时候它的父进程还没有使用wait()等系统调用来获知它的终止信息,此时进程就成了僵尸进程。

EXIT_DEAD是进程的最终状态。

EXIT_ZOMBIE和EXIT_DEAD也可以用于exit_state。

上面的进程状态和进程的运行、调度有关系,还有其他的一些状态,我们称为标志。放在flags字段中,这些字段都被定义称为宏,以PF开头。我这里举几个例子。

#define PF_EXITING 0x00000004

#define PF_VCPU 0x00000010

#define PF_FORKNOEXEC 0x00000040- PF_EXITING 表示正在退出。当有这个flag的时候,在函数find_alive_thread中,找活着的线程,遇到有这个flag的,就直接跳过。

- PF_VCPU 表示进程运行在虚拟CPU上。在函数account_system_time中,统计进程的系统运行时间,如果有这个flag,就调用account_guest_time,按照客户机的时间进行统计。

- PF_FORKNOEXEC 表示fork完了,还没有exec。在_do_fork函数里面调用copy_process,这个时候把flag设置为PF_FORKNOEXEC。当exec中调用了load_elf_binary的时候,又把这个flag去掉。

7.4 进程调度

进程的状态切换往往涉及调度,下面这些字段都是用于调度的。为了让你理解task_struct进程管理的全貌,我先在这里列一下,咱们后面会有单独的章节讲解,这里你只要大概看一下里面的注释就好了。

//是否在运行队列上

int on_rq;

//优先级

int prio;

int static_prio;

int normal_prio;

unsigned int rt_priority;

//调度器类

const struct sched_class *sched_class;

//调度实体

struct sched_entity se;

struct sched_rt_entity rt;

struct sched_dl_entity dl;

//调度策略

unsigned int policy;

//可以使用哪些CPU

int nr_cpus_allowed;

cpumask_t cpus_allowed;

struct sched_info sched_info;7.5 总结

画一个图总结一下。这个图是进程管理task_struct的的结构图。其中红色的部分是今天讲的部分,你可以对着这张图说出它们的含义。

.webp)

8. 进程数据结构(中)

8.1 运行统计信息

在进程的运行过程中,会有一些统计量,具体你可以看下面的列表。这里面有进程在用户态和内核态消耗的时间、上下文切换的次数等等。

u64 utime;//用户态消耗的CPU时间

u64 stime;//内核态消耗的CPU时间

unsigned long nvcsw;//自愿(voluntary)上下文切换计数

unsigned long nivcsw;//非自愿(involuntary)上下文切换计数

u64 start_time;//进程启动时间,不包含睡眠时间

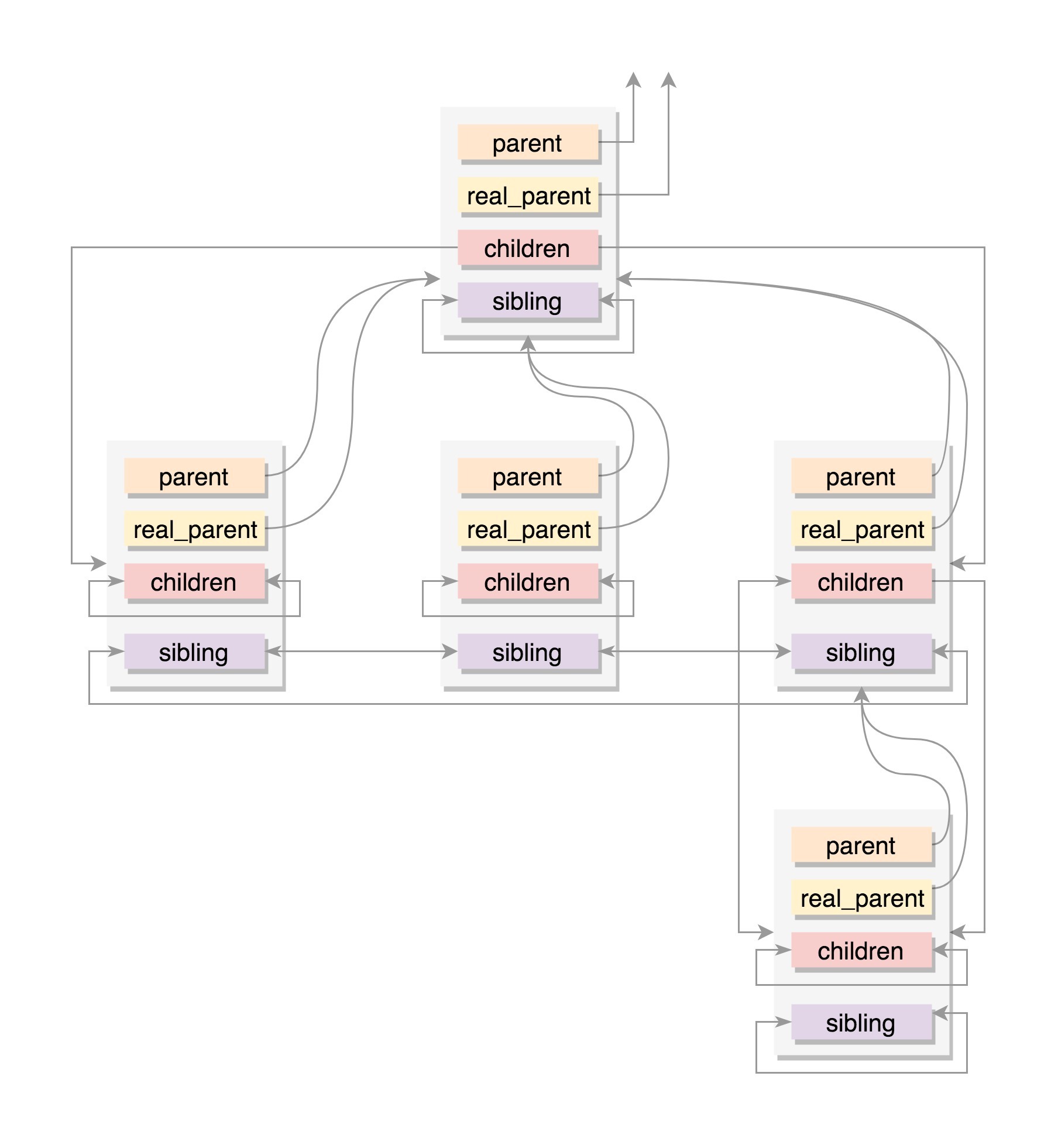

u64 real_start_time;//进程启动时间,包含睡眠时间8.2 进程亲缘关系

从我们之前讲的创建进程的过程,可以看出,任何一个进程都有父进程。所以,整个进程其实就是一棵进程树。而拥有同一父进程的所有进程都具有兄弟关系。

struct task_struct __rcu *real_parent; /* real parent process */

struct task_struct __rcu *parent; /* recipient of SIGCHLD, wait4() reports */

struct list_head children; /* list of my children */

struct list_head sibling; /* linkage in my parent's children list */- parent指向其父进程。当它终止时,必须向它的父进程发送信号。

- children表示链表的头部。链表中的所有元素都是它的子进程。

- sibling用于把当前进程插入到兄弟链表中。

通常情况下,real_parent和parent是一样的,但是也会有另外的情况存在。例如,bash创建一个进程,那进程的parent和real_parent就都是bash。如果在bash上使用GDB来debug一个进程,这个时候GDB是real_parent,bash是这个进程的parent。

8.3 进程权限

在Linux里面,对于进程权限的定义如下:

/* Objective and real subjective task credentials (COW): */

const struct cred __rcu *real_cred;

/* Effective (overridable) subjective task credentials (COW): */

const struct cred __rcu *cred;这个结构的注释里,有两个名词比较拗口,Objective和Subjective。事实上,所谓的权限,就是我能操纵谁,谁能操纵我。

“谁能操作我”,很显然,这个时候我就是被操作的对象,就是Objective,那个想操作我的就是Subjective。”我能操作谁”,这个时候我就是Subjective,那个要被我操作的就是Objectvie。

“操作”,就是一个对象对另一个对象进行某些动作。当动作要实施的时候,就要审核权限,当两边的权限匹配上了,就可以实施操作。其中,real_cred就是说明谁能操作我这个进程,而cred就是说明我这个进程能够操作谁。

这里cred的定义如下:

struct cred {

......

kuid_t uid; /* real UID of the task */

kgid_t gid; /* real GID of the task */

kuid_t suid; /* saved UID of the task */

kgid_t sgid; /* saved GID of the task */

kuid_t euid; /* effective UID of the task */

kgid_t egid; /* effective GID of the task */

kuid_t fsuid; /* UID for VFS ops */

kgid_t fsgid; /* GID for VFS ops */

......

kernel_cap_t cap_inheritable; /* caps our children can inherit */

kernel_cap_t cap_permitted; /* caps we're permitted */

kernel_cap_t cap_effective; /* caps we can actually use */

kernel_cap_t cap_bset; /* capability bounding set */

kernel_cap_t cap_ambient; /* Ambient capability set */

......

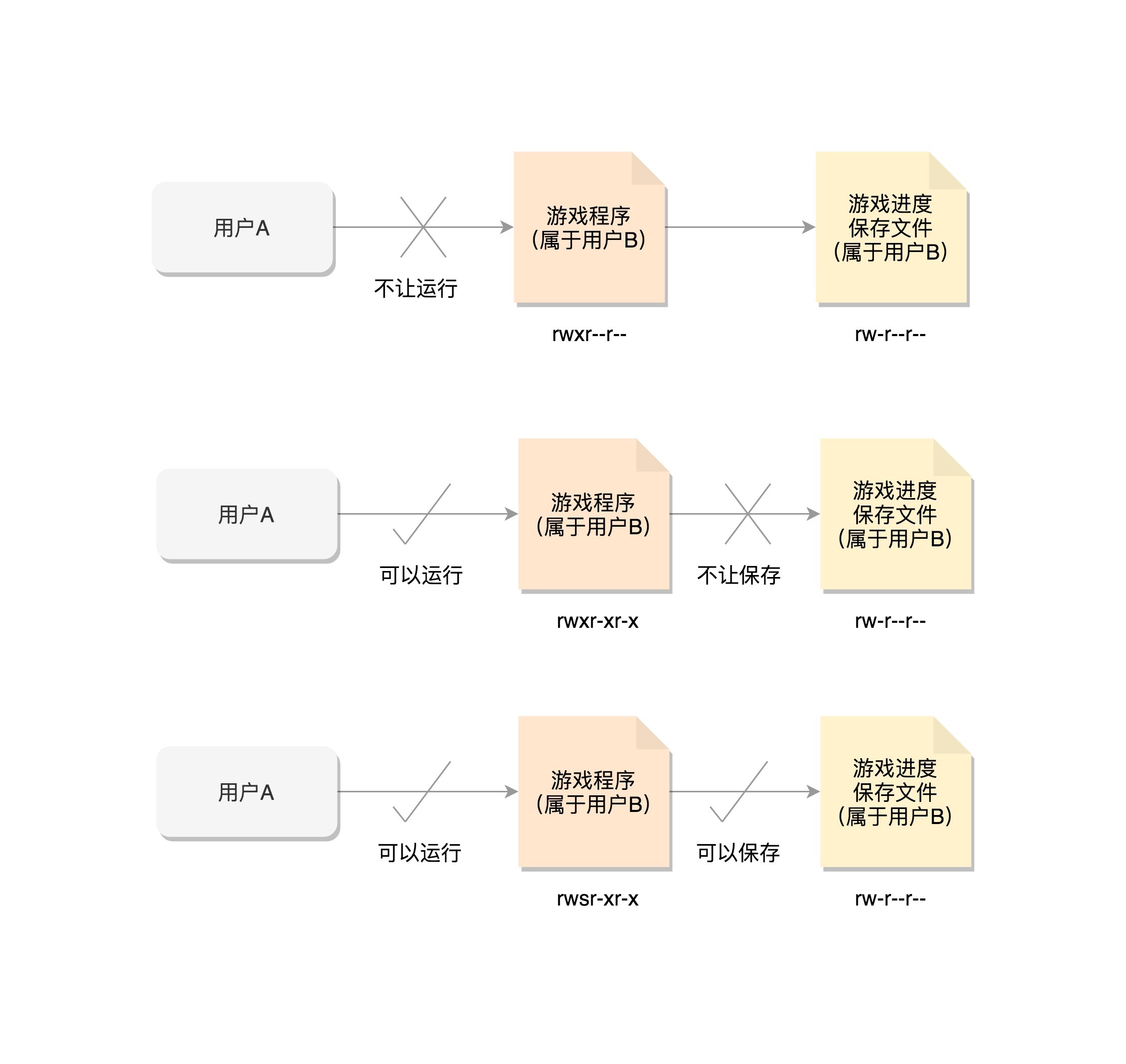

} __randomize_layout;从这里的定义可以看出,大部分是关于 用户和用户所属的用户组信息 。

第一个是uid和gid,注释是real user/group id。一般情况下,谁启动的进程,就是谁的ID。但是权限审核的时候,往往不比较这两个,也就是说不大起作用。

第二个是euid和egid,注释是effective user/group id。一看这个名字,就知道这个是起”作用”的。当这个进程要操作消息队列、共享内存、信号量等对象的时候,其实就是在比较这个用户和组是否有权限。

第三个是fsuid和fsgid,也就是filesystem user/group id。这个是对文件操作会审核的权限。

一般说来,fsuid、euid,和uid是一样的,fsgid、egid,和gid也是一样的。因为谁启动的进程,就应该审核启动的用户到底有没有这个权限。

例如,用户A想玩一个游戏,这个游戏的程序是用户B安装的。游戏这个程序文件的权限为rwxr–r—。A是没有权限运行这个程序的,因而用户B要给用户A权限才行。用户B说没问题,都是朋友嘛,于是用户B就给这个程序设定了所有的用户都能执行的权限rwxr-xr-x,说兄弟你玩吧。

于是,用户A就获得了运行这个游戏的权限。当游戏运行起来之后,游戏进程的uid、euid、fsuid都是用户A。看起来没有问题,玩的很开心。

用户A好不容易通过一关,想保存通关数据的时候,发现坏了,这个游戏的玩家数据是保存在另一个文件里面的。这个文件权限rw———-,只给用户B开了写入权限,而游戏进程的euid和fsuid都是用户A,当然写不进去了。完了,这一局白玩儿了。

那怎么解决这个问题呢?我们可以通过chmod u+s program命令,给这个游戏程序设置set-user-ID的标识位,把游戏的权限变成rwsr-xr-x。这个时候,用户A再启动这个游戏的时候,创建的进程uid当然还是用户A,但是euid和fsuid就不是用户A了,因为看到了set-user-id标识,就改为文件的所有者的ID,也就是说,euid和fsuid都改成用户B了,这样就能够将通关结果保存下来。

在Linux里面,一个进程可以随时通过setuid设置用户ID,所以,游戏程序的用户B的ID还会保存在一个地方,这就是suid和sgid,也就是saved uid和save gid。这样就可以很方便地使用setuid,通过设置uid或者suid来改变权限。

除了以用户和用户组控制权限,Linux还有另一个机制就是 capabilities 。

原来控制进程的权限,要么是高权限的root用户,要么是一般权限的普通用户,这时候的问题是,root用户权限太大,而普通用户权限太小。有时候一个普通用户想做一点高权限的事情,必须给他整个root的权限。这个太不安全了。

于是,我们引入新的机制capabilities,用位图表示权限,在capability.h可以找到定义的权限。我这里列举几个。

#define CAP_CHOWN 0

#define CAP_KILL 5

#define CAP_NET_BIND_SERVICE 10

#define CAP_NET_RAW 13

#define CAP_SYS_MODULE 16

#define CAP_SYS_RAWIO 17

#define CAP_SYS_BOOT 22

#define CAP_SYS_TIME 25

#define CAP_AUDIT_READ 37

#define CAP_LAST_CAP CAP_AUDIT_READ对于普通用户运行的进程,当有这个权限的时候,就能做这些操作;没有的时候,就不能做,这样粒度要小很多。

cap_permitted表示进程能够使用的权限。但是真正起作用的是cap_effective。cap_permitted中可以包含cap_effective中没有的权限。一个进程可以在必要的时候,放弃自己的某些权限,这样更加安全。假设自己因为代码漏洞被攻破了,但是如果啥也干不了,就没办法进一步突破。

cap_inheritable表示当可执行文件的扩展属性设置了inheritable位时,调用exec执行该程序会继承调用者的inheritable集合,并将其加入到permitted集合。但在非root用户下执行exec时,通常不会保留inheritable集合,但是往往又是非root用户,才想保留权限,所以非常鸡肋。

cap_bset,也就是capability bounding set,是系统中所有进程允许保留的权限。如果这个集合中不存在某个权限,那么系统中的所有进程都没有这个权限。即使以超级用户权限执行的进程,也是一样的。

这样有很多好处。例如,系统启动以后,将加载内核模块的权限去掉,那所有进程都不能加载内核模块。这样,即便这台机器被攻破,也做不了太多有害的事情。

cap_ambient是比较新加入内核的,就是为了解决cap_inheritable鸡肋的状况,也就是,非root用户进程使用exec执行一个程序的时候,如何保留权限的问题。当执行exec的时候,cap_ambient会被添加到cap_permitted中,同时设置到cap_effective中。

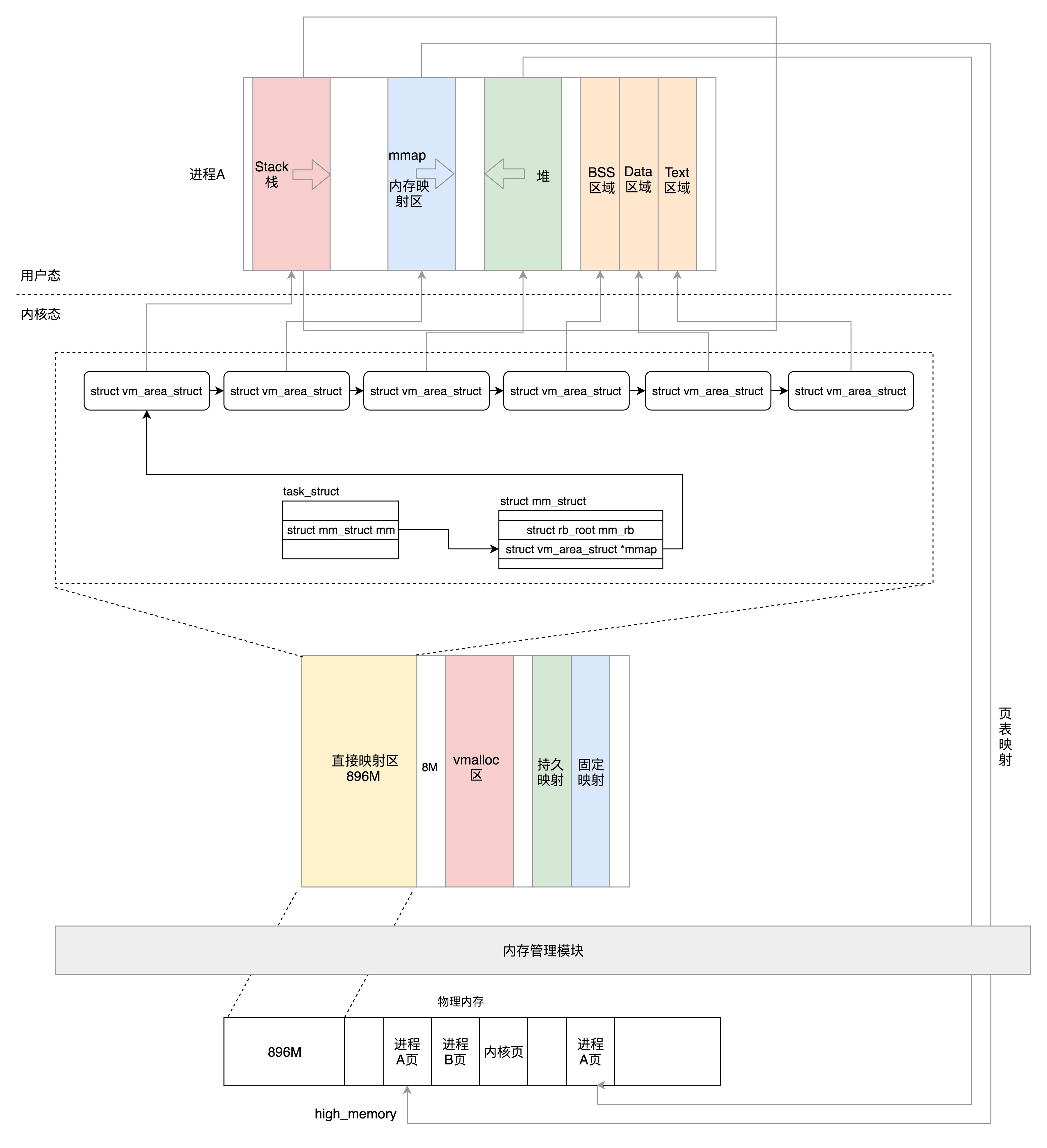

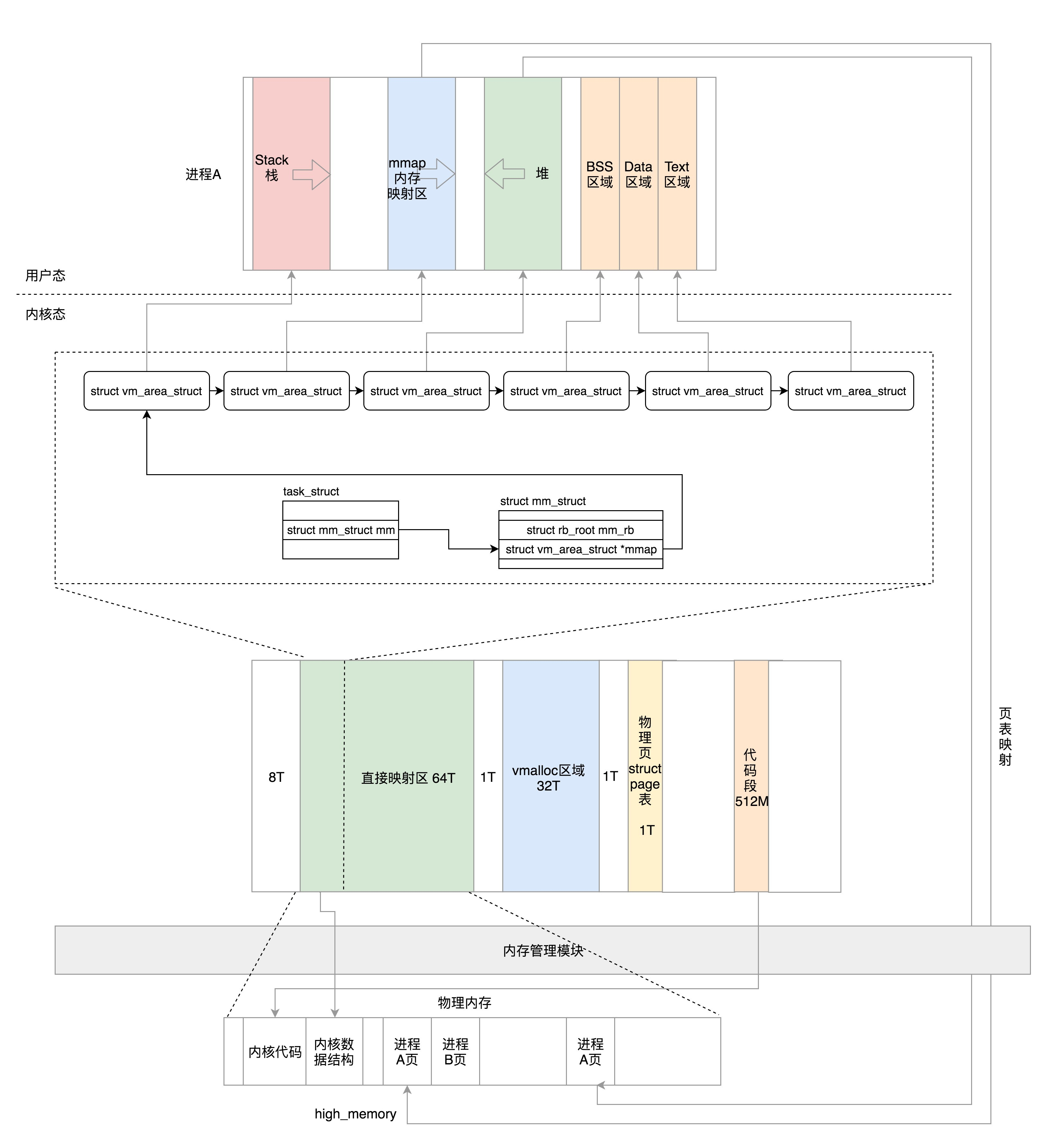

8.4 内存管理

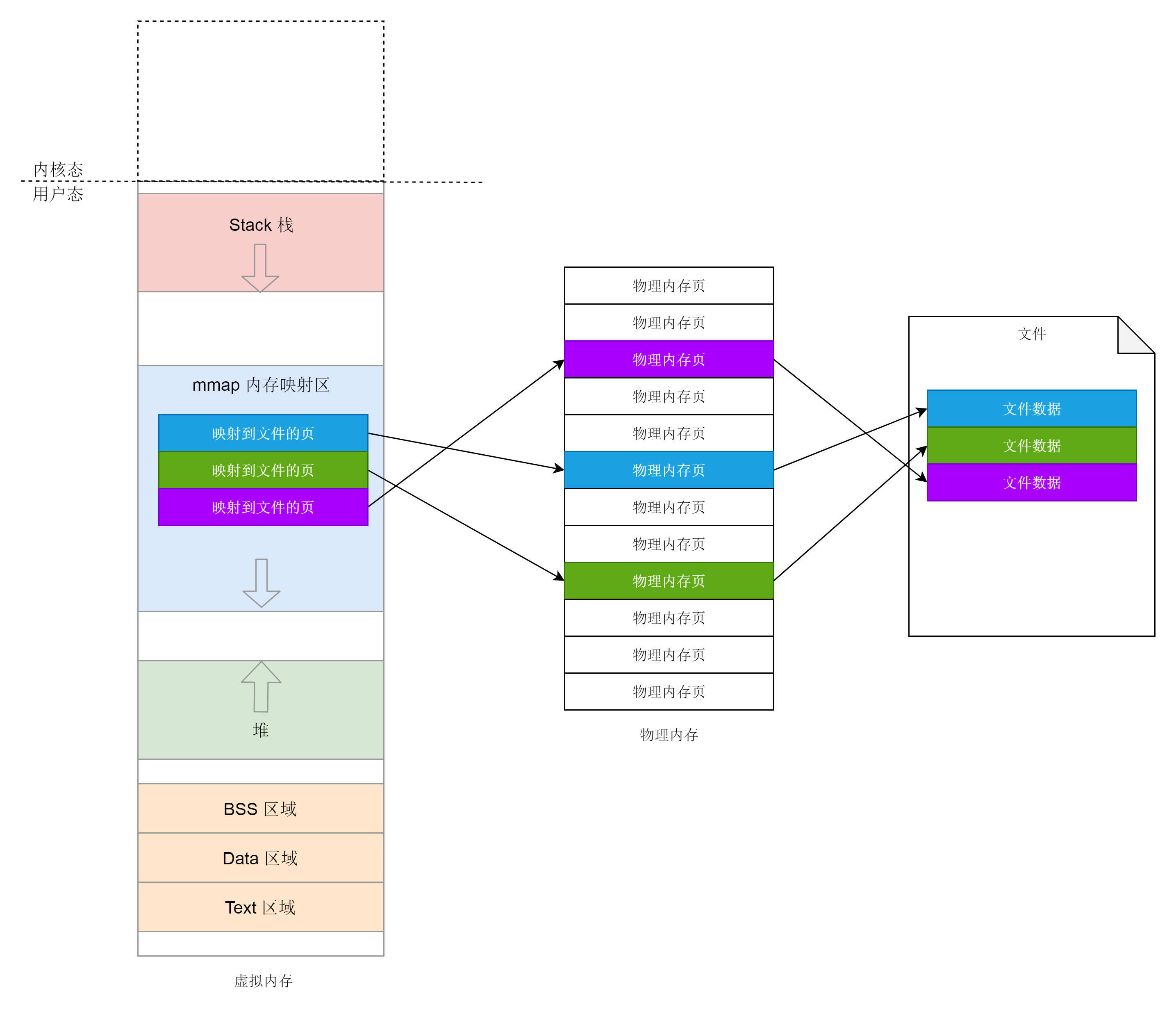

每个进程都有自己独立的虚拟内存空间,这需要有一个数据结构来表示,就是mm_struct。这个我们在内存管理那一节详细讲述。这里你先有个印象。

struct mm_struct *mm;

struct mm_struct *active_mm;8.5 文件与文件系统

每个进程有一个文件系统的数据结构,还有一个打开文件的数据结构。这个我们放到文件系统那一节详细讲述。

/* Filesystem information: */

struct fs_struct *fs;

/* Open file information: */

struct files_struct *files;8.6 总结

这一节,我们终于把进程管理复杂的数据结构基本讲完了,请你重点记住以下两点:

- 进程亲缘关系维护的数据结构,是一种很有参考价值的实现方式,在内核中会多个地方出现类似的结构;

- 进程权限中setuid的原理,这一点比较难理解,但是很重要,面试经常会考。

你可以对着下面这张图,看看自己是否真的理解了,进程树是如何组织的,以及如何控制进程的权限的。

.webp)

9. 进程数据结构(下)

在程序执行过程中,一旦调用到系统调用,就需要进入内核继续执行。那如何将用户态的执行和内核态的执行串起来呢?

这就需要以下两个重要的成员变量:

struct thread_info thread_info;

void *stack;9.1 用户态函数栈

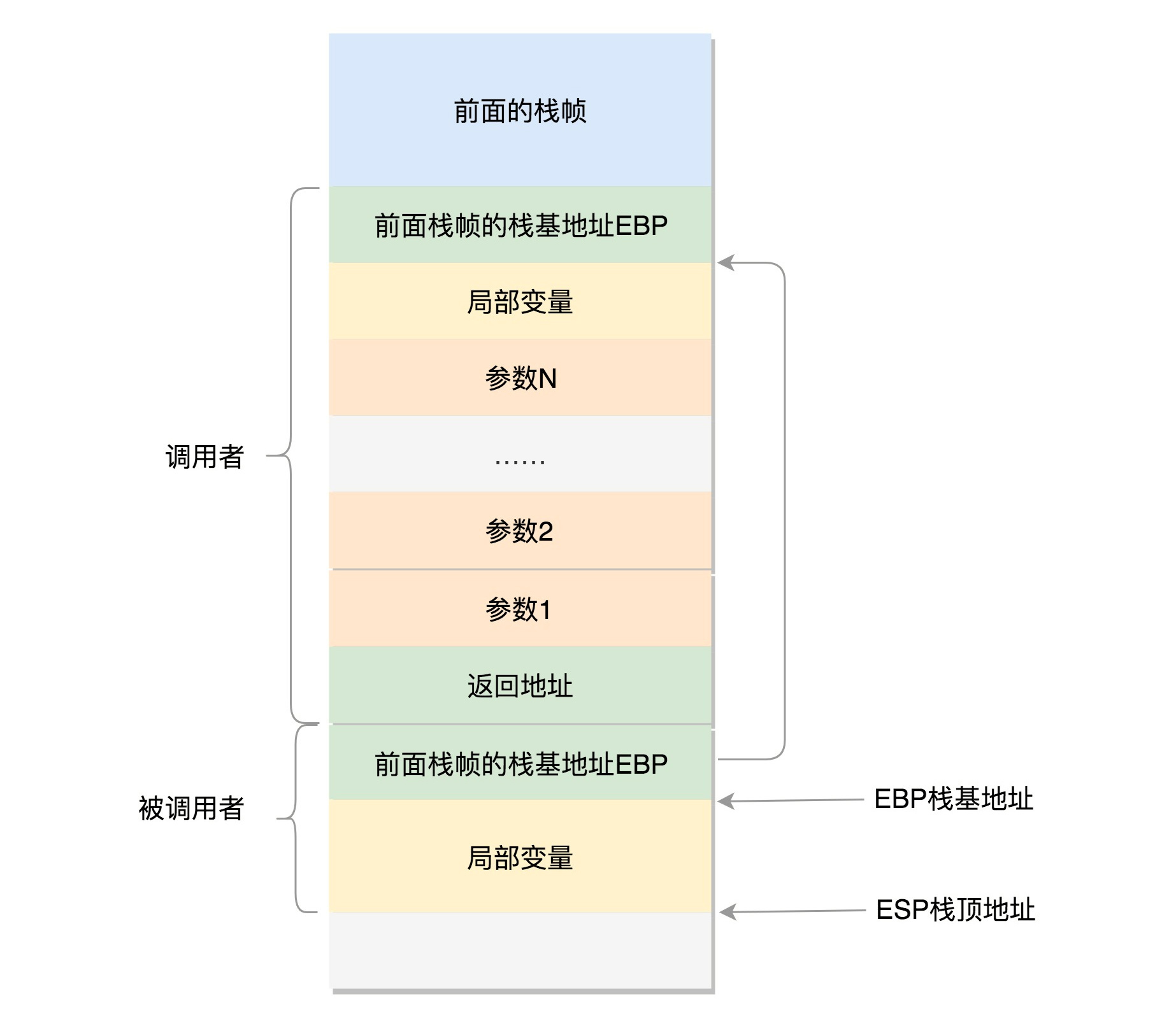

在用户态中,程序的执行往往是一个函数调用另一个函数。函数调用都是通过栈来进行的。

在进程的内存空间里面,栈是一个从高地址到低地址,往下增长的结构,也就是上面是栈底,下面是栈顶,入栈和出栈的操作都是从下面的栈顶开始的。

以下栈操作,都是在进程的内存空间里面进行的。

9.1.1 32位操作系统

在CPU里,ESP(Extended Stack Pointer)是栈顶指针寄存器,入栈操作Push和出栈操作Pop指令,会自动调整ESP的值。另外有一个寄存器EBP(Extended Base Pointer),是栈基地址指针寄存器,指向当前栈帧的最底部。

例如,A调用B,A的栈里面包含A函数的局部变量,然后是调用B的时候要传给它的参数,然后返回A的地址,这个地址也应该入栈,这就形成了A的栈帧。接下来就是B的栈帧部分了,先保存的是A栈帧的栈底位置,也就是EBP。因为在B函数里面获取A传进来的参数,就是通过这个指针获取的,接下来保存的是B的局部变量等等。

当B返回的时候,返回值会保存在EAX寄存器中,从栈中弹出返回地址,将指令跳转回去,参数也从栈中弹出,然后继续执行A。

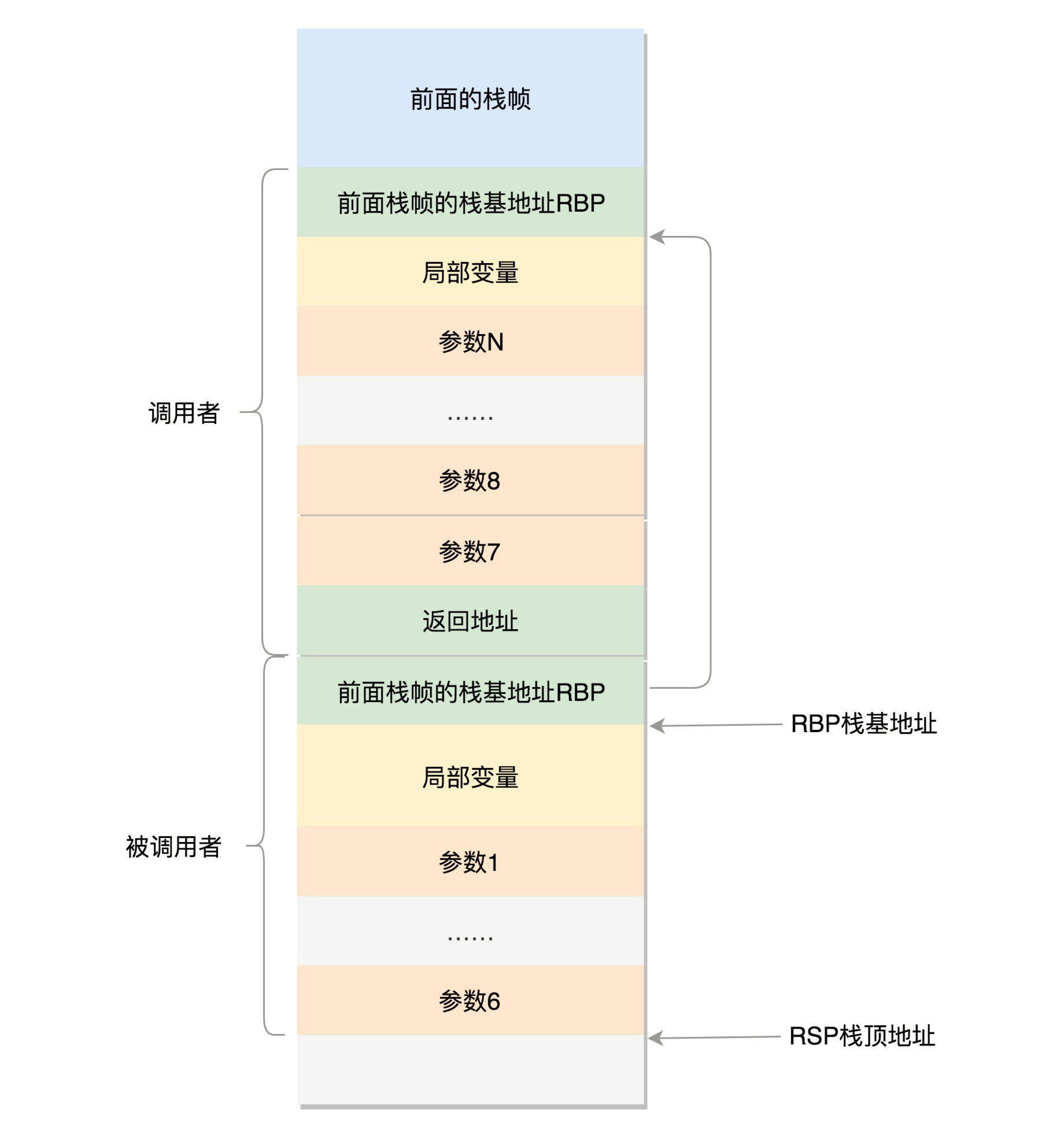

9.1.2 64位操作系统

对于64位操作系统,模式多少有些不一样。因为64位操作系统的寄存器数目比较多。rax用于保存函数调用的返回结果。栈顶指针寄存器变成了rsp,指向栈顶位置。堆栈的Pop和Push操作会自动调整rsp,栈基指针寄存器变成了rbp,指向当前栈帧的起始位置。

改变比较多的是参数传递。rdi、rsi、rdx、rcx、r8、r9这6个寄存器,用于传递存储函数调用时的6个参数。如果超过6的时候,还是需要放到栈里面。

然而,前6个参数有时候需要进行寻址,但是如果在寄存器里面,是没有地址的,因而还是会放到栈里面,只不过放到栈里面的操作是被调用函数做的。

9.2 内核态函数栈

接下来,我们通过系统调用,从进程的内存空间到内核中了。内核中也有各种各样的函数调用来调用去的,也需要这样一个机制,这该怎么办呢?

这时候,上面的成员变量stack,也就是内核栈,就派上了用场。

Linux给每个task都分配了内核栈。在32位系统上arch/x86/include/asm/page_32_types.h,是这样定义的:一个PAGE_SIZE是4K,左移一位就是乘以2,也就是8K。

#define THREAD_SIZE_ORDER 1

#define THREAD_SIZE (PAGE_SIZE << THREAD_SIZE_ORDER)内核栈在64位系统上arch/x86/include/asm/page_64_types.h,是这样定义的:在PAGE_SIZE的基础上左移两位,也即16K,并且要求起始地址必须是8192的整数倍。

#ifdef CONFIG_KASAN

#define KASAN_STACK_ORDER 1

#else

#define KASAN_STACK_ORDER 0

#endif

#define THREAD_SIZE_ORDER (2 + KASAN_STACK_ORDER)

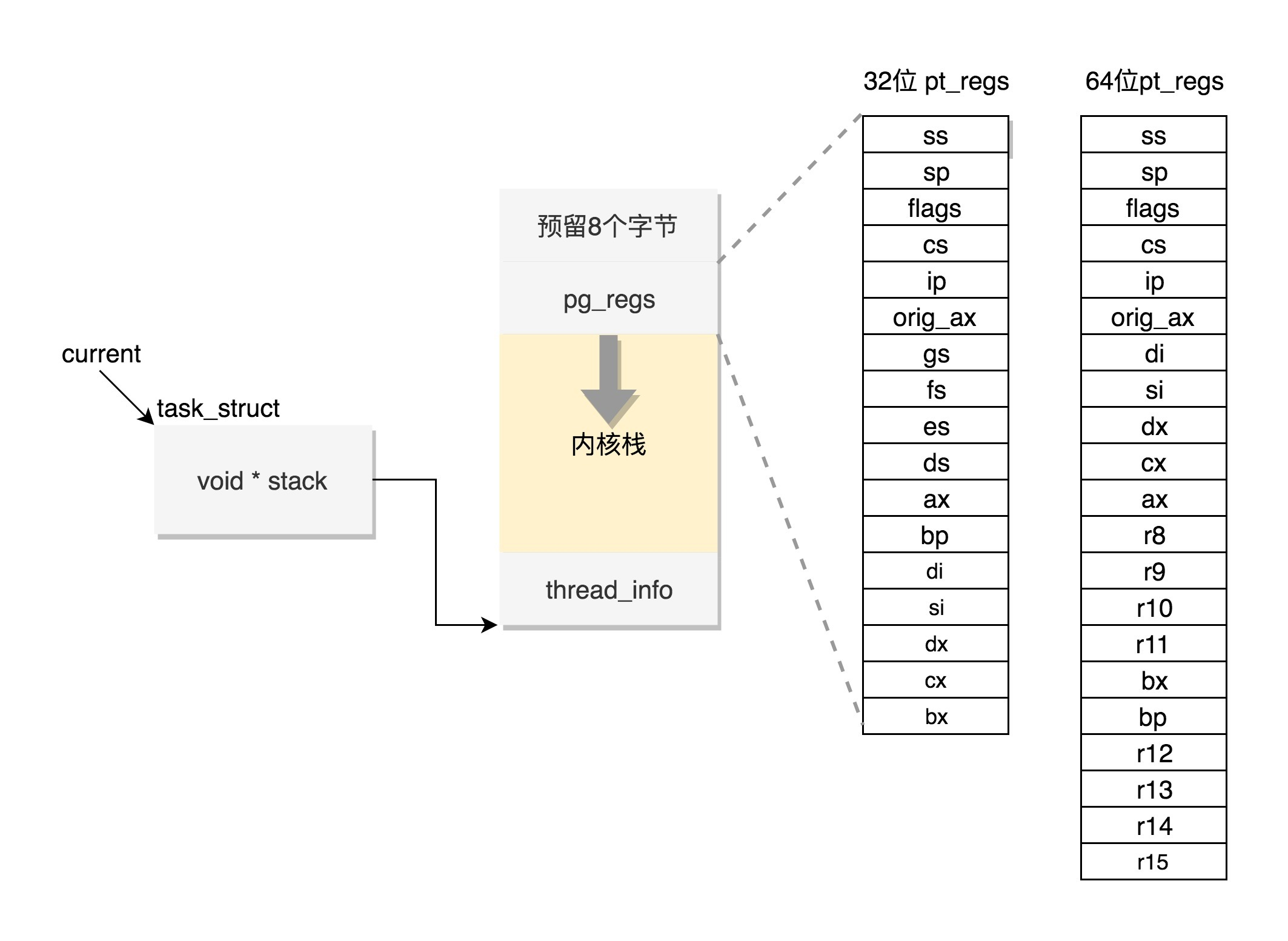

#define THREAD_SIZE (PAGE_SIZE << THREAD_SIZE_ORDER)内核栈是一个非常特殊的结构,如下图所示:

这段空间的最低位置,是一个thread_info结构。这个结构是对task_struct结构的补充。因为task_struct结构庞大但是通用,不同的体系结构就需要保存不同的东西,所以往往与体系结构有关的,都放在thread_info里面。

在内核代码里面有这样一个union,将thread_info和stack放在一起,在include/linux/sched.h文件中就有。

union thread_union {

#ifndef CONFIG_THREAD_INFO_IN_TASK

struct thread_info thread_info;

#endif

unsigned long stack[THREAD_SIZE/sizeof(long)];

};这个union就是这样定义的,开头是thread_info,后面是stack。

在内核栈的最高地址端,存放的是另一个结构pt_regs,定义如下。其中,32位和64位的定义不一样。

#ifdef __i386__

struct pt_regs {

unsigned long bx;

unsigned long cx;

unsigned long dx;

unsigned long si;

unsigned long di;

unsigned long bp;

unsigned long ax;

unsigned long ds;

unsigned long es;

unsigned long fs;

unsigned long gs;

unsigned long orig_ax;

unsigned long ip;

unsigned long cs;

unsigned long flags;

unsigned long sp;

unsigned long ss;

};

#else

struct pt_regs {

unsigned long r15;

unsigned long r14;

unsigned long r13;

unsigned long r12;

unsigned long bp;

unsigned long bx;

unsigned long r11;

unsigned long r10;

unsigned long r9;

unsigned long r8;

unsigned long ax;

unsigned long cx;

unsigned long dx;

unsigned long si;

unsigned long di;

unsigned long orig_ax;

unsigned long ip;

unsigned long cs;

unsigned long flags;

unsigned long sp;

unsigned long ss;

/* top of stack page */

};

#endif当系统调用从用户态到内核态的时候,首先要做的第一件事情,就是将用户态运行过程中的CPU上下文保存起来,其实主要就是保存在这个结构的寄存器变量里。这样当从内核系统调用返回的时候,才能让进程在刚才的地方接着运行下去。

如果我们对比系统调用那一节的内容,你会发现系统调用的时候,压栈的值的顺序和struct pt_regs中寄存器定义的顺序是一样的。

在内核中,CPU的寄存器ESP或者RSP,已经指向内核栈的栈顶,在内核态里的调用都有和用户态相似的过程。

9.3 通过task_struct找内核栈

如果有一个task_struct的stack指针在手,你可以通过下面的函数找到这个线程内核栈:

static inline void *task_stack_page(const struct task_struct *task)

{

return task->stack;

}从task_struct如何得到相应的pt_regs呢?我们可以通过下面的函数:

/*

* TOP_OF_KERNEL_STACK_PADDING reserves 8 bytes on top of the ring0 stack.

* This is necessary to guarantee that the entire "struct pt_regs"

* is accessible even if the CPU haven't stored the SS/ESP registers

* on the stack (interrupt gate does not save these registers

* when switching to the same priv ring).

* Therefore beware: accessing the ss/esp fields of the

* "struct pt_regs" is possible, but they may contain the

* completely wrong values.

*/

#define task_pt_regs(task) \

({ \

unsigned long __ptr = (unsigned long)task_stack_page(task); \

__ptr += THREAD_SIZE - TOP_OF_KERNEL_STACK_PADDING; \

((struct pt_regs *)__ptr) - 1; \

})你会发现,这是先从task_struct找到内核栈的开始位置。然后这个位置加上THREAD_SIZE就到了最后的位置,然后转换为struct pt_regs,再减一,就相当于减少了一个pt_regs的位置,就到了这个结构的首地址。

这里面有一个TOP_OF_KERNEL_STACK_PADDING,这个的定义如下:

#ifdef CONFIG_X86_32

# ifdef CONFIG_VM86

# define TOP_OF_KERNEL_STACK_PADDING 16

# else

# define TOP_OF_KERNEL_STACK_PADDING 8

# endif

#else

# define TOP_OF_KERNEL_STACK_PADDING 0

#endif也就是说,32位机器上是8,其他是0。这是为什么呢?因为压栈pt_regs有两种情况。我们知道,CPU用ring来区分权限,从而Linux可以区分内核态和用户态。

因此,第一种情况,我们拿涉及从用户态到内核态的变化的系统调用来说。因为涉及权限的改变,会压栈保存SS、ESP寄存器的,这两个寄存器共占用8个byte。

另一种情况是,不涉及权限的变化,就不会压栈这8个byte。这样就会使得两种情况不兼容。如果没有压栈还访问,就会报错,所以还不如预留在这里,保证安全。在64位上,修改了这个问题,变成了定长的。

好了,现在如果你task_struct在手,就能够轻松得到内核栈和内核寄存器。

9.4 通过内核栈找task_struct

那如果一个当前在某个CPU上执行的进程,想知道自己的task_struct在哪里,又该怎么办呢?

这个艰巨的任务要交给thread_info这个结构。

struct thread_info {

struct task_struct *task; /* main task structure */

__u32 flags; /* low level flags */

__u32 status; /* thread synchronous flags */

__u32 cpu; /* current CPU */

mm_segment_t addr_limit;

unsigned int sig_on_uaccess_error:1;

unsigned int uaccess_err:1; /* uaccess failed */

};这里面有个成员变量task指向task_struct,所以我们常用current_thread_info()->task来获取task_struct。

static inline struct thread_info *current_thread_info(void)

{

return (struct thread_info *)(current_top_of_stack() - THREAD_SIZE);

}而thread_info的位置就是内核栈的最高位置,减去THREAD_SIZE,就到了thread_info的起始地址。

但是现在变成这样了,只剩下一个flags。

struct thread_info {

unsigned long flags; /* low level flags */

};那这时候怎么获取当前运行中的task_struct呢?current_thread_info有了新的实现方式。

在include/linux/thread_info.h中定义了current_thread_info。

#include <asm/current.h>

#define current_thread_info() ((struct thread_info *)current)那current又是什么呢?在arch/x86/include/asm/current.h中定义了。

struct task_struct;

DECLARE_PER_CPU(struct task_struct *, current_task);

static __always_inline struct task_struct *get_current(void)

{

return this_cpu_read_stable(current_task);

}

#define current get_current到这里,你会发现,新的机制里面,每个CPU运行的task_struct不通过thread_info获取了,而是直接放在Per CPU 变量里面了。

多核情况下,CPU是同时运行的,但是它们共同使用其他的硬件资源的时候,我们需要解决多个CPU之间的同步问题。

Per CPU变量是内核中一种重要的同步机制。顾名思义,Per CPU变量就是为每个CPU构造一个变量的副本,这样多个CPU各自操作自己的副本,互不干涉。比如,当前进程的变量current_task就被声明为Per CPU变量。

要使用Per CPU变量,首先要声明这个变量,在arch/x86/include/asm/current.h中有:

DECLARE_PER_CPU(struct task_struct *, current_task);然后是定义这个变量,在arch/x86/kernel/cpu/common.c中有:

DEFINE_PER_CPU(struct task_struct *, current_task) = &init_task;也就是说,系统刚刚初始化的时候,current_task都指向init_task。

当某个CPU上的进程进行切换的时候,current_task被修改为将要切换到的目标进程。例如,进程切换函数__switch_to就会改变current_task。

__visible __notrace_funcgraph struct task_struct *

__switch_to(struct task_struct *prev_p, struct task_struct *next_p)

{

......

this_cpu_write(current_task, next_p);

......

return prev_p;

}当要获取当前的运行中的task_struct的时候,就需要调用this_cpu_read_stable进行读取。

#define this_cpu_read_stable(var) percpu_stable_op("mov", var)好了,现在如果你是一个进程,正在某个CPU上运行,就能够轻松得到task_struct了。

9.5 总结

这一节虽然只介绍了内核栈,但是内容更加重要。如果说task_struct的其他成员变量都是和进程管理有关的,内核栈是和进程运行有关系的。

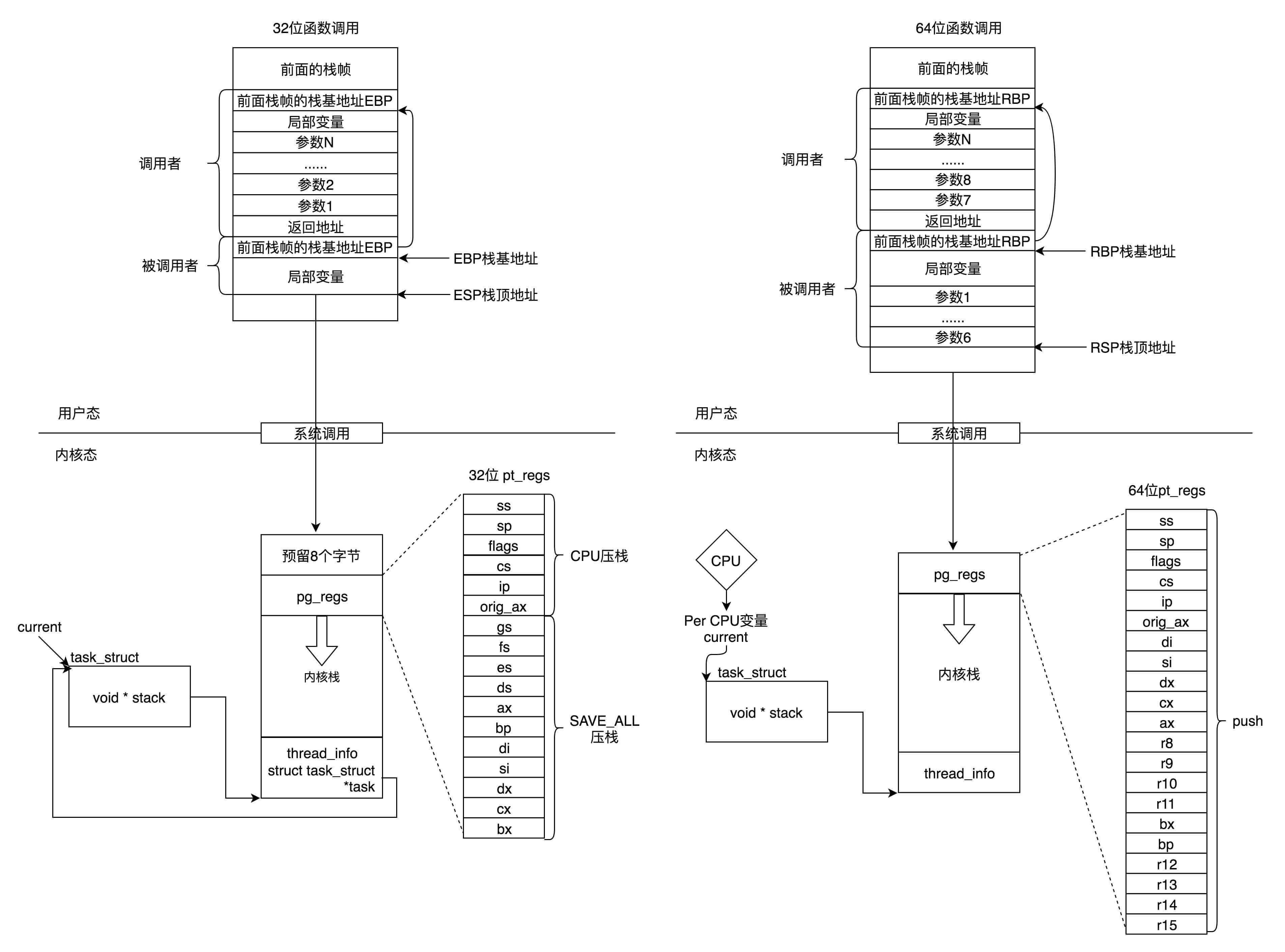

我这里画了一张图总结一下32位和64位的工作模式,左边是32位的,右边是64位的。

- 在用户态,应用程序进行了至少一次函数调用。32位和64的传递参数的方式稍有不同,32位的就是用函数栈,64位的前6个参数用寄存器,其他的用函数栈。

- 在内核态,32位和64位都使用内核栈,格式也稍有不同,主要集中在pt_regs结构上。

- 在内核态,32位和64位的内核栈和task_struct的关联关系不同。32位主要靠thread_info,64位主要靠Per-CPU变量。

10. 调度(上)

对于操作系统来讲,它面对的CPU的数量是有限的,干活儿都是它们,但是进程数目远远超过CPU的数目,因而就需要进行进程的调度,有效地分配CPU的时间,既要保证进程的最快响应,也要保证进程之间的公平。这也是一个非常复杂的、需要平衡的事情。

10.1 调度策略与调度类

在Linux里面,进程大概可以分成两种。

一种称为 实时进程 ,也就是需要尽快执行返回结果的那种。

另一种是 普通进程 ,大部分的进程其实都是这种。

对于这两种进程,我们的调度策略肯定是不同的。

在task_struct中,有一个成员变量,我们叫调度策略。

unsigned int policy;它有以下几个定义:

#define SCHED_NORMAL 0

#define SCHED_FIFO 1

#define SCHED_RR 2

#define SCHED_BATCH 3

#define SCHED_IDLE 5

#define SCHED_DEADLINE 6配合调度策略的,还有我们刚才说的优先级,也在task_struct中。

int prio, static_prio, normal_prio;

unsigned int rt_priority;优先级其实就是一个数值,对于实时进程,优先级的范围是0~99;对于普通进程,优先级的范围是100~139。数值越小,优先级越高。从这里可以看出,所有的实时进程都比普通进程优先级要高。

10.2 实时调度策略

对于调度策略,其中SCHED_FIFO、SCHED_RR、SCHED_DEADLINE是实时进程的调度策略。

- SCHED_FIFO 就是先来先服务,可以分配更高的优先级,也就是说,高优先级的进程可以抢占低优先级的进程,而相同优先级的进程,我们遵循先来先得。

- SCHED_RR 轮流调度算法。采用时间片,相同优先级的任务当用完时间片会被放到队列尾部,以保证公平性,而高优先级的任务也是可以抢占低优先级的任务。

- SCHED_DEADLINE 按照任务的deadline进行调度的。当产生一个调度点的时候,DL调度器总是选择其deadline距离当前时间点最近的那个任务,并调度它执行。

10.3 普通调度策略

对于普通进程的调度策略有,SCHED_NORMAL、SCHED_BATCH、SCHED_IDLE。

- SCHED_NORMAL 是普通的进程。

- SCHED_BATCH 是后台进程,几乎不需要和前端进行交互。不要影响需要交互的进程,可以降低他的优先级。

- SCHED_IDLE 是特别空闲的时候才跑的进程。

上面无论是policy还是priority,都设置了一个变量,变量仅仅表示了应该这样这样干,但事情总要有人去干,谁呢?在task_struct里面,还有这样的成员变量:

const struct sched_class *sched_class;调度策略的执行逻辑,就封装在这里面,它是真正干活的那个。

sched_class有几种实现:

- stop_sched_class 优先级最高的任务会使用这种策略,会中断所有其他线程,且不会被其他任务打断;

- dl_sched_class就对应上面的deadline调度策略;

- rt_sched_class就对应RR算法或者FIFO算法的调度策略,具体调度策略由进程的task_struct->policy指定;

- fair_sched_class就是普通进程的调度策略;

- idle_sched_class就是空闲进程的调度策略。

这里实时进程的调度策略RR和FIFO相对简单一些,而且由于咱们平时常遇到的都是普通进程,在这里,咱们就重点分析普通进程的调度问题。普通进程使用的调度策略是fair_sched_class,顾名思义,对于普通进程来讲,公平是最重要的。

10.4 完全公平调度算法

在Linux里面,实现了一个基于CFS的调度算法。CFS全称Completely Fair Scheduling,叫完全公平调度。听起来很”公平”。那这个算法的原理是什么呢?我们来看看。

首先,你需要记录下进程的运行时间。CPU会提供一个时钟,过一段时间就触发一个时钟中断。就像咱们的表滴答一下,这个我们叫Tick。CFS会为每一个进程安排一个虚拟运行时间vruntime。如果一个进程在运行,随着时间的增长,也就是一个个tick的到来,进程的vruntime将不断增大。没有得到执行的进程vruntime不变。

显然,那些vruntime少的,原来受到了不公平的对待,需要给它补上,所以会优先运行这样的进程。

这有点像让你把一筐球平均分到N个口袋里面,你看着哪个少,就多放一些;哪个多了,就先不放。这样经过多轮,虽然不能保证球完全一样多,但是也差不多公平。

你可能会说,不还有优先级呢?如何给优先级高的进程多分时间呢?

这个简单,就相当于N个口袋,优先级高的袋子大,优先级低的袋子小。这样球就不能按照个数分配了,要按照比例来,大口袋的放了一半和小口袋放了一半,里面的球数目虽然差很多,也认为是公平的。

在更新进程运行的统计量的时候,我们其实就可以看出这个逻辑。

/*

* Update the current task's runtime statistics.

*/

static void update_curr(struct cfs_rq *cfs_rq)

{

struct sched_entity *curr = cfs_rq->curr;

u64 now = rq_clock_task(rq_of(cfs_rq));

u64 delta_exec;

......

delta_exec = now - curr->exec_start;

......

curr->exec_start = now;

......

curr->sum_exec_runtime += delta_exec;

......

curr->vruntime += calc_delta_fair(delta_exec, curr);

update_min_vruntime(cfs_rq);

......

}

/*

* delta /= w

*/

static inline u64 calc_delta_fair(u64 delta, struct sched_entity *se)

{

if (unlikely(se->load.weight != NICE_0_LOAD))

/* delta_exec * weight / lw.weight */

delta = __calc_delta(delta, NICE_0_LOAD, &se->load);

return delta;

}在这里得到当前的时间,以及这次的时间片开始的时间,两者相减就是这次运行的时间delta_exec ,但是得到的这个时间其实是实际运行的时间,需要做一定的转化才作为虚拟运行时间vruntime。转化方法如下:

虚拟运行时间vruntime += 实际运行时间delta_exec * NICE_0_LOAD/权重

这就是说,同样的实际运行时间,给高权重的算少了,低权重的算多了,但是当选取下一个运行进程的时候,还是按照最小的vruntime来的,这样高权重的获得的实际运行时间自然就多了。这就相当于给一个体重(权重)200斤的胖子吃两个馒头,和给一个体重100斤的瘦子吃一个馒头,然后说,你们两个吃的是一样多。这样虽然总体胖子比瘦子多吃了一倍,但是还是公平的。

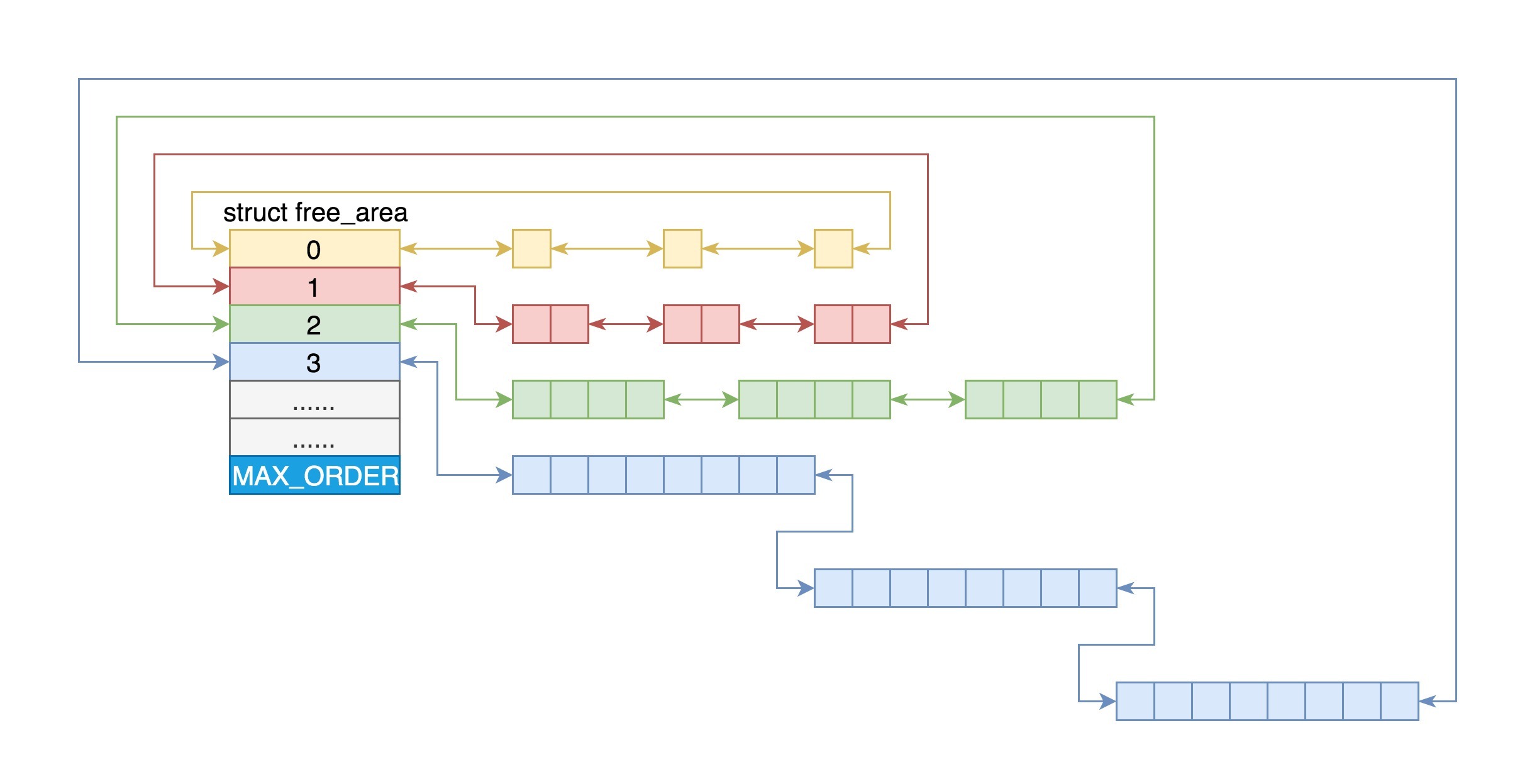

10.5 调度队列与调度实体

看来CFS需要一个数据结构来对vruntime进行排序,找出最小的那个。这个能够排序的数据结构不但需要查询的时候,能够快速找到最小的,更新的时候也需要能够快速的调整排序,要知道vruntime可是经常在变的,变了再插入这个数据结构,就需要重新排序。

能够平衡查询和更新速度的是树,在这里使用的是红黑树。

红黑树的的节点是应该包括vruntime的,称为调度实体。

在task_struct中有这样的成员变量:

struct sched_entity se;

struct sched_rt_entity rt;

struct sched_dl_entity dl;这里有实时调度实体sched_rt_entity,Deadline调度实体sched_dl_entity,以及完全公平算法调度实体sched_entity。

看来不光CFS调度策略需要有这样一个数据结构进行排序,其他的调度策略也同样有自己的数据结构进行排序,因为任何一个策略做调度的时候,都是要区分谁先运行谁后运行。

而进程根据自己是实时的,还是普通的类型,通过这个成员变量,将自己挂在某一个数据结构里面,和其他的进程排序,等待被调度。如果这个进程是个普通进程,则通过sched_entity,将自己挂在这棵红黑树上。

对于普通进程的调度实体定义如下,这里面包含了vruntime和权重load_weight,以及对于运行时间的统计。

struct sched_entity {

struct load_weight load;

struct rb_node run_node;

struct list_head group_node;

unsigned int on_rq;

u64 exec_start;

u64 sum_exec_runtime;

u64 vruntime;

u64 prev_sum_exec_runtime;

u64 nr_migrations;

struct sched_statistics statistics;

......

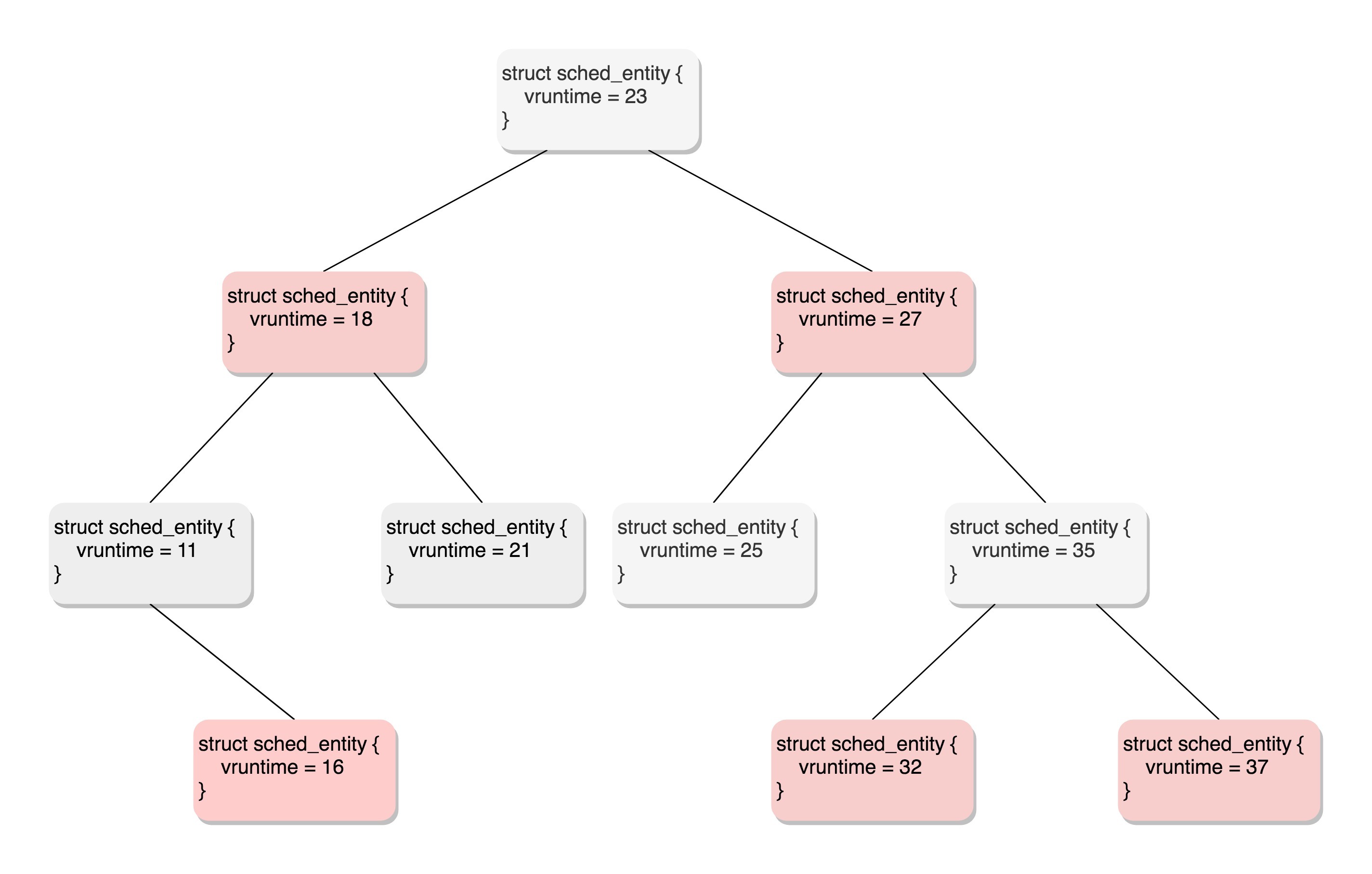

};下图是一个红黑树的例子。

所有可运行的进程通过不断地插入操作最终都存储在以时间为顺序的红黑树中,vruntime最小的在树的左侧,vruntime最多的在树的右侧。 CFS调度策略会选择红黑树最左边的叶子节点作为下一个将获得cpu的任务。

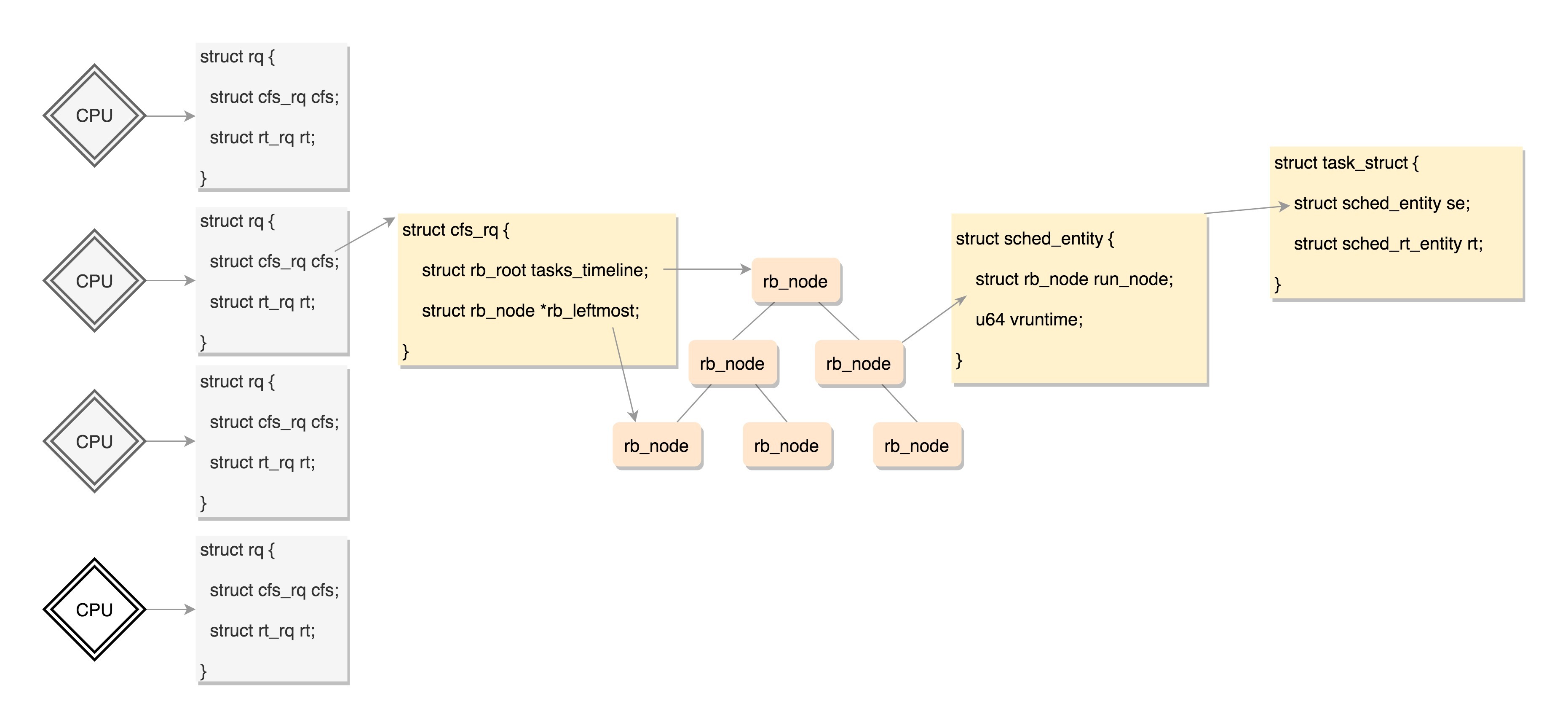

每个CPU都有自己的 struct rq 结构,其用于描述在此CPU上所运行的所有进程,其包括一个实时进程队列rt_rq和一个CFS运行队列cfs_rq,在调度时,调度器首先会先去实时进程队列找是否有实时进程需要运行,如果没有才会去CFS运行队列找是否有进行需要运行。

struct rq {

/* runqueue lock: */

raw_spinlock_t lock;

unsigned int nr_running;

unsigned long cpu_load[CPU_LOAD_IDX_MAX];

......

struct load_weight load;

unsigned long nr_load_updates;

u64 nr_switches;

struct cfs_rq cfs;

struct rt_rq rt;

struct dl_rq dl;

......

struct task_struct *curr, *idle, *stop;

......

};对于普通进程公平队列cfs_rq,定义如下:

/* CFS-related fields in a runqueue */

struct cfs_rq {

struct load_weight load;

unsigned int nr_running, h_nr_running;

u64 exec_clock;

u64 min_vruntime;

#ifndef CONFIG_64BIT

u64 min_vruntime_copy;

#endif

struct rb_root tasks_timeline;

struct rb_node *rb_leftmost;

struct sched_entity *curr, *next, *last, *skip;

......

};这里面rb_root指向的就是红黑树的根节点,这个红黑树在CPU看起来就是一个队列,不断的取下一个应该运行的进程。rb_leftmost指向的是最左面的节点。

到这里终于凑够数据结构了,上面这些数据结构的关系如下图:

10.6 调度类是如何工作的?

调度类的定义如下:

struct sched_class {

const struct sched_class *next;

void (*enqueue_task) (struct rq *rq, struct task_struct *p, int flags);

void (*dequeue_task) (struct rq *rq, struct task_struct *p, int flags);

void (*yield_task) (struct rq *rq);

bool (*yield_to_task) (struct rq *rq, struct task_struct *p, bool preempt);

void (*check_preempt_curr) (struct rq *rq, struct task_struct *p, int flags);

struct task_struct * (*pick_next_task) (struct rq *rq,

struct task_struct *prev,

struct rq_flags *rf);

void (*put_prev_task) (struct rq *rq, struct task_struct *p);

void (*set_curr_task) (struct rq *rq);

void (*task_tick) (struct rq *rq, struct task_struct *p, int queued);

void (*task_fork) (struct task_struct *p);

void (*task_dead) (struct task_struct *p);

void (*switched_from) (struct rq *this_rq, struct task_struct *task);

void (*switched_to) (struct rq *this_rq, struct task_struct *task);

void (*prio_changed) (struct rq *this_rq, struct task_struct *task, int oldprio);

unsigned int (*get_rr_interval) (struct rq *rq,

struct task_struct *task);

void (*update_curr) (struct rq *rq)

}这个结构定义了很多种方法,用于在队列上操作任务。这里请大家注意第一个成员变量,是一个指针,指向下一个调度类。

上面我们讲了,调度类分为下面这几种:

extern const struct sched_class stop_sched_class;

extern const struct sched_class dl_sched_class;

extern const struct sched_class rt_sched_class;

extern const struct sched_class fair_sched_class;

extern const struct sched_class idle_sched_class;它们其实是放在一个链表上的。这里我们以调度最常见的操作,取下一个任务为例,来解析一下。可以看到,这里面有一个for_each_class循环,沿着上面的顺序,依次调用每个调度类的方法。

/*

* Pick up the highest-prio task:

*/

static inline struct task_struct *

pick_next_task(struct rq *rq, struct task_struct *prev, struct rq_flags *rf)

{

const struct sched_class *class;

struct task_struct *p;

......

for_each_class(class) {

p = class->pick_next_task(rq, prev, rf);

if (p) {

if (unlikely(p == RETRY_TASK))

goto again;

return p;

}

}

}这就说明,调度的时候是从优先级最高的调度类到优先级低的调度类,依次执行。而对于每种调度类,有自己的实现,例如,CFS就有fair_sched_class。

const struct sched_class fair_sched_class = {

.next = &idle_sched_class,

.enqueue_task = enqueue_task_fair,

.dequeue_task = dequeue_task_fair,

.yield_task = yield_task_fair,

.yield_to_task = yield_to_task_fair,

.check_preempt_curr = check_preempt_wakeup,

.pick_next_task = pick_next_task_fair,

.put_prev_task = put_prev_task_fair,

.set_curr_task = set_curr_task_fair,

.task_tick = task_tick_fair,

.task_fork = task_fork_fair,

.prio_changed = prio_changed_fair,

.switched_from = switched_from_fair,

.switched_to = switched_to_fair,

.get_rr_interval = get_rr_interval_fair,

.update_curr = update_curr_fair,

};对于同样的pick_next_task选取下一个要运行的任务这个动作,不同的调度类有自己的实现。fair_sched_class的实现是pick_next_task_fair,rt_sched_class的实现是pick_next_task_rt。

我们会发现这两个函数是操作不同的队列,pick_next_task_rt操作的是rt_rq,pick_next_task_fair操作的是cfs_rq。

static struct task_struct *

pick_next_task_rt(struct rq *rq, struct task_struct *prev, struct rq_flags *rf)

{

struct task_struct *p;

struct rt_rq *rt_rq = &rq->rt;

......

}

static struct task_struct *

pick_next_task_fair(struct rq *rq, struct task_struct *prev, struct rq_flags *rf)

{

struct cfs_rq *cfs_rq = &rq->cfs;

struct sched_entity *se;

struct task_struct *p;

......

}这样整个运行的场景就串起来了,在每个CPU上都有一个队列rq,这个队列里面包含多个子队列,例如rt_rq和cfs_rq,不同的队列有不同的实现方式,cfs_rq就是用红黑树实现的。

当有一天,某个CPU需要找下一个任务执行的时候,会按照优先级依次调用调度类,不同的调度类操作不同的队列。当然rt_sched_class先被调用,它会在rt_rq上找下一个任务,只有找不到的时候,才轮到fair_sched_class被调用,它会在cfs_rq上找下一个任务。这样保证了实时任务的优先级永远大于普通任务。

下面我们仔细看一下sched_class定义的与调度有关的函数。

- enqueue_task 向就绪队列中添加一个进程,当某个进程进入可运行状态时,调用这个函数;

- dequeue_task 将一个进程从就就绪队列中删除;

- pick_next_task 选择接下来要运行的进程;

- put_prev_task 用另一个进程代替当前运行的进程;

- set_curr_task 用于修改调度策略;

- task_tick 每次周期性时钟到的时候,这个函数被调用,可能触发调度。

在这里面,我们重点看fair_sched_class对于pick_next_task的实现pick_next_task_fair,获取下一个进程。调用路径如下:pick_next_task_fair->pick_next_entity->__pick_first_entity。

struct sched_entity *__pick_first_entity(struct cfs_rq *cfs_rq)

{

struct rb_node *left = rb_first_cached(&cfs_rq->tasks_timeline);

if (!left)

return NULL;

return rb_entry(left, struct sched_entity, run_node);

}从这个函数的实现可以看出,就是从红黑树里面取最左面的节点。

10.7 总结

一个CPU上有一个队列,CFS的队列是一棵红黑树,树的每一个节点都是一个sched_entity,每个sched_entity都属于一个task_struct,task_struct里面有指针指向这个进程属于哪个调度类。

.webp)

在调度的时候,依次调用调度类的函数,从CPU的队列中取出下一个进程。上面图中的调度器、上下文切换这一节我们没有讲,下一节我们讲讲基于这些数据结构,如何实现调度。

11. 调度(中)

所谓进程调度,其实就是一个人在做A项目,在某个时刻,换成做B项目去了。发生这种情况,主要有两种方式。

方式一:A项目做着做着,发现里面有一条指令sleep,也就是要休息一下,或者在等待某个I/O事件。那没办法了,就要主动让出CPU,然后可以开始做B项目。

方式二:A项目做着做着,旷日持久,实在受不了了。项目经理介入了,说这个项目A先停停,B项目也要做一下,要不然B项目该投诉了。

11.1 主动调度

我们这一节先来看方式一,主动调度。

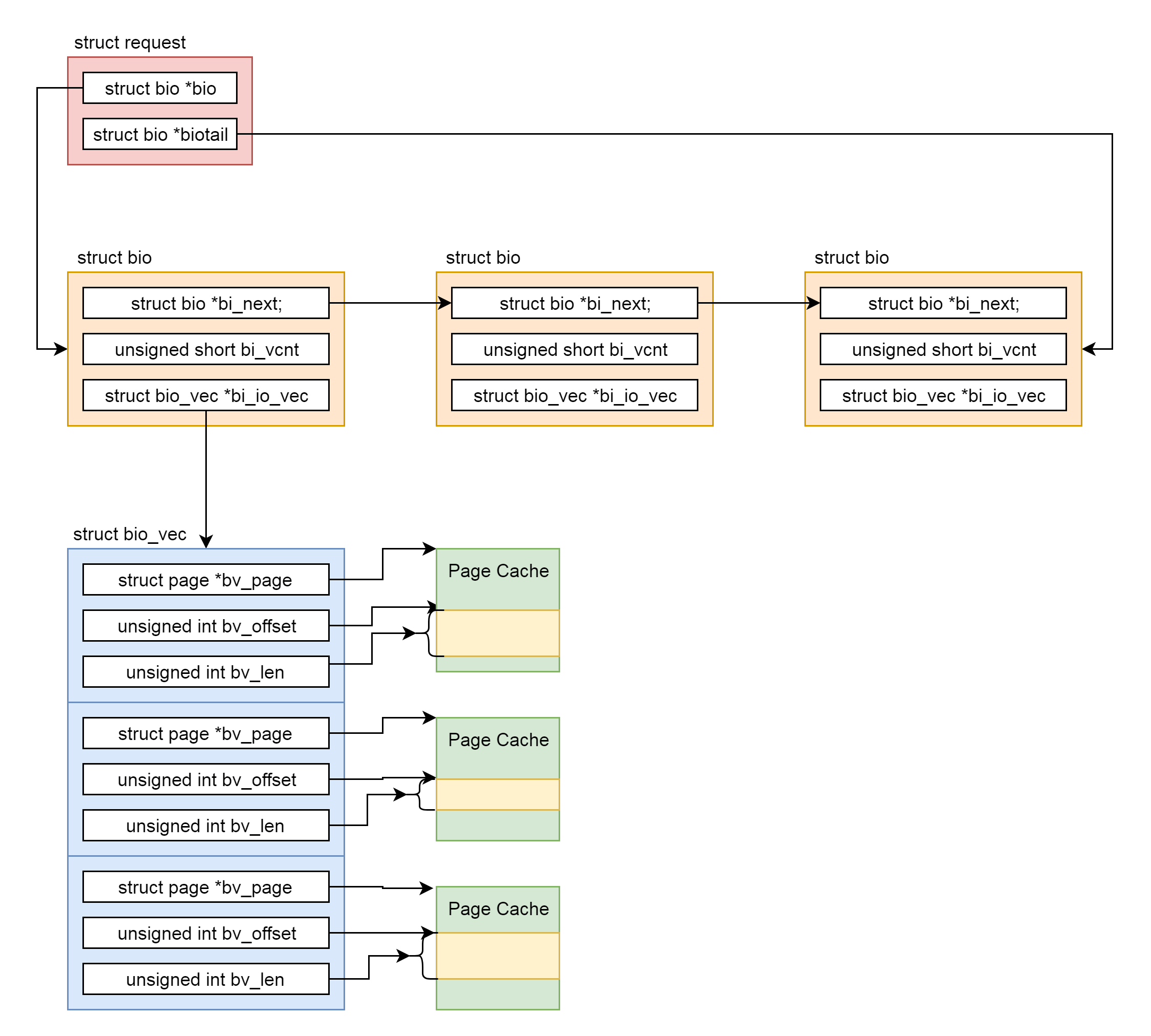

这里我找了几个代码片段。 第一个片段是Btrfs,等待一个写入 。 Btrfs(B-Tree)是一种文件系统。

这个片段可以看作写入块设备的一个典型场景。写入需要一段时间,这段时间用不上CPU,还不如主动让给其他进程。

static void btrfs_wait_for_no_snapshoting_writes(struct btrfs_root *root)

{

......

do {

prepare_to_wait(&root->subv_writers->wait, &wait,

TASK_UNINTERRUPTIBLE);

writers = percpu_counter_sum(&root->subv_writers->counter);

if (writers)

schedule();

finish_wait(&root->subv_writers->wait, &wait);

} while (writers);

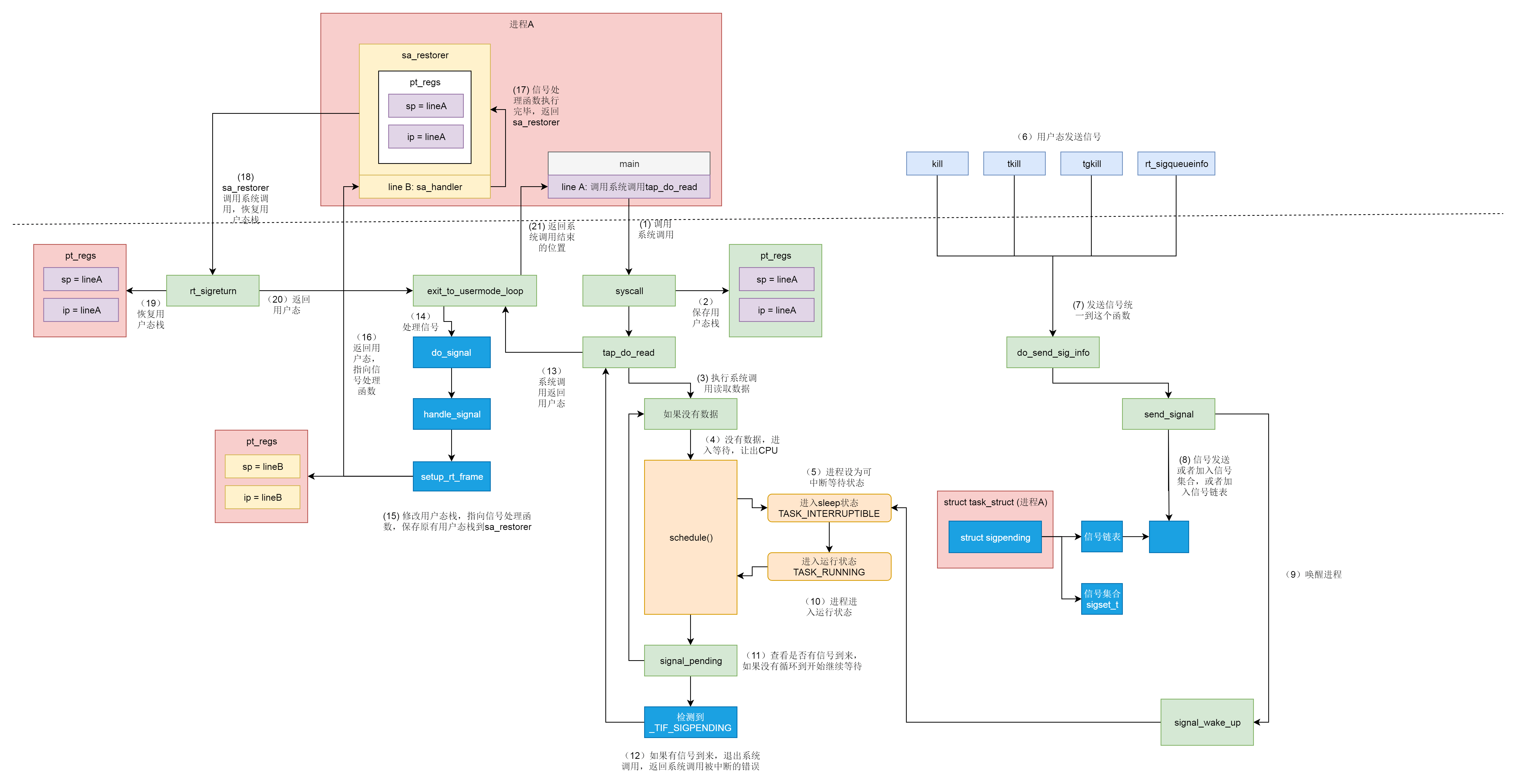

}另外一个例子是, 从Tap网络设备等待一个读取 。Tap网络设备是虚拟机使用的网络设备。当没有数据到来的时候,它也需要等待,所以也会选择把CPU让给其他进程。

static ssize_t tap_do_read(struct tap_queue *q,

struct iov_iter *to,

int noblock, struct sk_buff *skb)

{

......

while (1) {

if (!noblock)

prepare_to_wait(sk_sleep(&q->sk), &wait,

TASK_INTERRUPTIBLE);

......

/* Nothing to read, let's sleep */

schedule();

}

......

}接下来,我们就来看 schedule函数的调用过程。

asmlinkage __visible void __sched schedule(void)

{

struct task_struct *tsk = current;

sched_submit_work(tsk);

do {

preempt_disable();

__schedule(false);

sched_preempt_enable_no_resched();

} while (need_resched());

}这段代码的主要逻辑是在__schedule函数中实现的。这个函数比较复杂,我们分几个部分来讲解。

static void __sched notrace __schedule(bool preempt)

{

struct task_struct *prev, *next;

unsigned long *switch_count;

struct rq_flags rf;

struct rq *rq;

int cpu;

cpu = smp_processor_id();

rq = cpu_rq(cpu);

prev = rq->curr;

......首先,在当前的CPU上,我们取出任务队列rq。

task_struct *prev指向这个CPU的任务队列上面正在运行的那个进程curr。为啥是prev?因为一旦将来它被切换下来,那它就成了前任了。

接下来代码如下:

next = pick_next_task(rq, prev, &rf);

clear_tsk_need_resched(prev);

clear_preempt_need_resched();第二步,获取下一个任务,task_struct *next 指向下一个任务,这就是 继任 。

pick_next_task的实现如下:

static inline struct task_struct *

pick_next_task(struct rq *rq, struct task_struct *prev, struct rq_flags *rf)

{

const struct sched_class *class;

struct task_struct *p;

/*

* Optimization: we know that if all tasks are in the fair class we can call that function directly, but only if the @prev task wasn't of a higher scheduling class, because otherwise those loose the opportunity to pull in more work from other CPUs.

*/

if (likely((prev->sched_class == &idle_sched_class ||

prev->sched_class == &fair_sched_class) &&

rq->nr_running == rq->cfs.h_nr_running)) {

p = fair_sched_class.pick_next_task(rq, prev, rf);

if (unlikely(p == RETRY_TASK))

goto again;

/* Assumes fair_sched_class->next == idle_sched_class */

if (unlikely(!p))

p = idle_sched_class.pick_next_task(rq, prev, rf);

return p;

}

again:

for_each_class(class) {

p = class->pick_next_task(rq, prev, rf);

if (p) {

if (unlikely(p == RETRY_TASK))

goto again;

return p;

}

}

}我们来看again这里,就是咱们上一节讲的依次调用调度类。但是这里有了一个优化,因为大部分进程是普通进程,所以大部分情况下会调用上面的逻辑,调用的就是fair_sched_class.pick_next_task。

根据上一节对于fair_sched_class的定义,它调用的是pick_next_task_fair,代码如下:

static struct task_struct *

pick_next_task_fair(struct rq *rq, struct task_struct *prev, struct rq_flags *rf)

{

struct cfs_rq *cfs_rq = &rq->cfs;

struct sched_entity *se;

struct task_struct *p;

int new_tasks;对于CFS调度类,取出相应的队列cfs_rq,这就是我们上一节讲的那棵红黑树。

struct sched_entity *curr = cfs_rq->curr;

if (curr) {

if (curr->on_rq)

update_curr(cfs_rq);

else

curr = NULL;

......

}

se = pick_next_entity(cfs_rq, curr);取出当前正在运行的任务curr,如果依然是可运行的状态,也即处于进程就绪状态,则调用update_curr更新vruntime。update_curr咱们上一节就见过了,它会根据实际运行时间算出vruntime来。

接着,pick_next_entity从红黑树里面,取最左边的一个节点。这个函数的实现我们上一节也讲过了。

p = task_of(se);

if (prev != p) {

struct sched_entity *pse = &prev->se;

......

put_prev_entity(cfs_rq, pse);

set_next_entity(cfs_rq, se);

}

return ptask_of得到下一个调度实体对应的task_struct,如果发现继任和前任不一样,这就说明有一个更需要运行的进程了,就需要更新红黑树了。前面前任的vruntime更新过了,put_prev_entity放回红黑树,会找到相应的位置,然后set_next_entity将继任者设为当前任务。

第三步,当选出的继任者和前任不同,就要进行上下文切换,继任者进程正式进入运行。

if (likely(prev != next)) {

rq->nr_switches++;

rq->curr = next;

++*switch_count;

......

rq = context_switch(rq, prev, next, &rf);11.2 进程上下文切换

上下文切换主要干两件事情,一是切换进程空间,也即虚拟内存;二是切换寄存器和CPU上下文。

我们先来看context_switch的实现。

/*

* context_switch - switch to the new MM and the new thread's register state.

*/

static __always_inline struct rq *

context_switch(struct rq *rq, struct task_struct *prev,

struct task_struct *next, struct rq_flags *rf)

{

struct mm_struct *mm, *oldmm;

......

mm = next->mm;

oldmm = prev->active_mm;

......

switch_mm_irqs_off(oldmm, mm, next);

......

/* Here we just switch the register state and the stack. */

switch_to(prev, next, prev);

barrier();

return finish_task_switch(prev);

}这里首先是内存空间的切换,里面涉及内存管理的内容比较多。内存管理后面我们会有专门的章节来讲,这里你先知道有这么一回事就行了。

接下来,我们看switch_to。它就是寄存器和栈的切换,它调用到了__switch_to_asm。这是一段汇编代码,主要用于栈的切换。

对于32位操作系统来讲,切换的是栈顶指针esp。

/*

* %eax: prev task

* %edx: next task

*/

ENTRY(__switch_to_asm)

......

/* switch stack */

movl %esp, TASK_threadsp(%eax)

movl TASK_threadsp(%edx), %esp

......

jmp __switch_to

END(__switch_to_asm)对于64位操作系统来讲,切换的是栈顶指针rsp。

/*

* %rdi: prev task

* %rsi: next task

*/

ENTRY(__switch_to_asm)

......

/* switch stack */

movq %rsp, TASK_threadsp(%rdi)

movq TASK_threadsp(%rsi), %rsp

......

jmp __switch_to

END(__switch_to_asm)最终,都返回了__switch_to这个函数。这个函数对于32位和64位操作系统虽然有不同的实现,但里面做的事情是差不多的。所以我这里仅仅列出64位操作系统做的事情。

__visible __notrace_funcgraph struct task_struct *

__switch_to(struct task_struct *prev_p, struct task_struct *next_p)

{

struct thread_struct *prev = &prev_p->thread;

struct thread_struct *next = &next_p->thread;

......

int cpu = smp_processor_id();

struct tss_struct *tss = &per_cpu(cpu_tss, cpu);

......

load_TLS(next, cpu);

......

this_cpu_write(current_task, next_p);

/* Reload esp0 and ss1. This changes current_thread_info(). */

load_sp0(tss, next);

......

return prev_p;

}这里面有一个Per CPU的结构体tss。这是个什么呢?

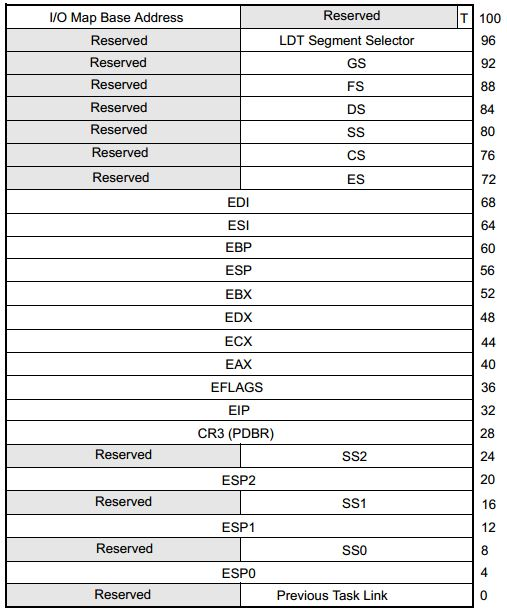

在x86体系结构中,提供了一种以硬件的方式进行进程切换的模式,对于每个进程,x86希望在内存里面维护一个TSS(Task State Segment,任务状态段)结构。这里面有所有的寄存器。

另外,还有一个特殊的寄存器TR(Task Register,任务寄存器),指向某个进程的TSS。更改TR的值,将会触发硬件保存CPU所有寄存器的值到当前进程的TSS中,然后从新进程的TSS中读出所有寄存器值,加载到CPU对应的寄存器中。

下图就是32位的TSS结构。

图片来自Intel® 64 and IA-32 Architectures Software Developer’s Manual Combined Volumes

但是这样有个缺点。我们做进程切换的时候,没必要每个寄存器都切换,这样每个进程一个TSS,就需要全量保存,全量切换,动作太大了。

于是,Linux操作系统想了一个办法。还记得在系统初始化的时候,会调用cpu_init吗?这里面会给每一个CPU关联一个TSS,然后将TR指向这个TSS,然后在操作系统的运行过程中,TR就不切换了,永远指向这个TSS。TSS用数据结构tss_struct表示,在x86_hw_tss中可以看到和上图相应的结构。

void cpu_init(void)

{

int cpu = smp_processor_id();

struct task_struct *curr = current;

struct tss_struct *t = &per_cpu(cpu_tss, cpu);

......

load_sp0(t, thread);

set_tss_desc(cpu, t);

load_TR_desc();

......

}

struct tss_struct {

/*

* The hardware state:

*/

struct x86_hw_tss x86_tss;

unsigned long io_bitmap[IO_BITMAP_LONGS + 1];

}在Linux中,真的参与进程切换的寄存器很少,主要的就是栈顶寄存器。

于是,在task_struct里面,还有一个我们原来没有注意的成员变量thread。这里面保留了要切换进程的时候需要修改的寄存器。

/* CPU-specific state of this task: */

struct thread_struct thread;所谓的进程切换,就是将某个进程的thread_struct里面的寄存器的值,写入到CPU的TR指向的tss_struct,对于CPU来讲,这就算是完成了切换。

例如__switch_to中的load_sp0,就是将下一个进程的thread_struct的sp0的值加载到tss_struct里面去。

11.3 指令指针的保存与恢复

你是不是觉得,这样真的就完成切换了吗?是的,不信我们来 盘点 一下。

从进程A切换到进程B,用户栈要不要切换呢?当然要,其实早就已经切换了,就在切换内存空间的时候。每个进程的用户栈都是独立的,都在内存空间里面。

那内核栈呢?已经在__switch_to里面切换了,也就是将current_task指向当前的task_struct。里面的void *stack指针,指向的就是当前的内核栈。

内核栈的栈顶指针呢?在switch_to_asm里面已经切换了栈顶指针,并且将栈顶指针在switch_to加载到了TSS里面。

用户栈的栈顶指针呢?如果当前在内核里面的话,它当然是在内核栈顶部的pt_regs结构里面呀。当从内核返回用户态运行的时候,pt_regs里面有所有当时在用户态的时候运行的上下文信息,就可以开始运行了。

唯一让人不容易理解的是指令指针寄存器,它应该指向下一条指令的,那它是如何切换的呢?这里有点绕,请你仔细看。

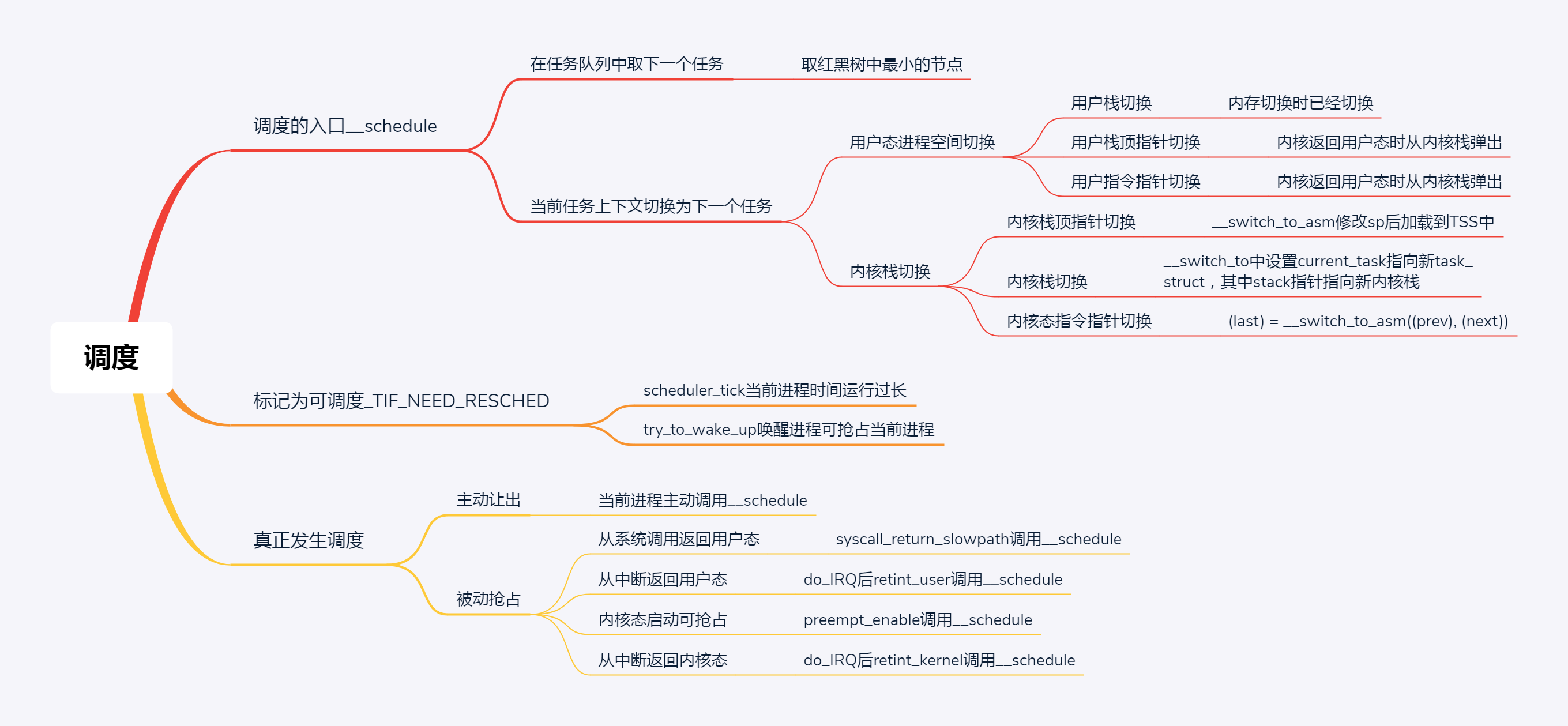

这里我先明确一点,进程的调度都最终会调用到__schedule函数。为了方便你记住,我姑且给它起个名字,就叫” 进程调度第一定律 “。后面我们会多次用到这个定律,你一定要记住。

我们用最前面的例子仔细分析这个过程。本来一个进程A在用户态是要写一个文件的,写文件的操作用户态没办法完成,就要通过系统调用到达内核态。在这个切换的过程中,用户态的指令指针寄存器是保存在pt_regs里面的,到了内核态,就开始沿着写文件的逻辑一步一步执行,结果发现需要等待,于是就调用__schedule函数。

这个时候,进程A在内核态的指令指针是指向schedule了。这里请记住,A进程的内核栈会保存这个schedule的调用,而且知道这是从btrfs_wait_for_no_snapshoting_writes这个函数里面进去的。

__schedule里面经过上面的层层调用,到达了context_switch的最后三行指令(其中barrier语句是一个编译器指令,用于保证switch_to和finish_task_switch的执行顺序,不会因为编译阶段优化而改变,这里咱们可以忽略它)。

switch_to(prev, next, prev);

barrier();

return finish_task_switch(prev);当进程A在内核里面执行switch_to的时候,内核态的指令指针也是指向这一行的。但是在switch_to里面,将寄存器和栈都切换到成了进程B的,唯一没有变的就是指令指针寄存器。当switch_to返回的时候,指令指针寄存器指向了下一条语句finish_task_switch。

但这个时候的finish_task_switch已经不是进程A的finish_task_switch了,而是进程B的finish_task_switch了。

这样合理吗?你怎么知道进程B当时被切换下去的时候,执行到哪里了?恢复B进程执行的时候一定在这里呢?这时候就要用到咱的”进程调度第一定律”了。

当年B进程被别人切换走的时候,也是调用__schedule,也是调用到switch_to,被切换成为C进程的,所以,B进程当年的下一个指令也是finish_task_switch,这就说明指令指针指到这里是没有错的。

接下来,我们要从finish_task_switch完毕后,返回__schedule的调用了。返回到哪里呢?按照函数返回的原理,当然是从内核栈里面去找,是返回到btrfs_wait_for_no_snapshoting_writes吗?当然不是了,因为btrfs_wait_for_no_snapshoting_writes是在A进程的内核栈里面的,它早就被切换走了,应该从B进程的内核栈里面找。

假设,B就是最前面例子里面调用tap_do_read读网卡的进程。它当年调用__schedule的时候,是从tap_do_read这个函数调用进去的。

当然,B进程的内核栈里面放的是tap_do_read。于是,从__schedule返回之后,当然是接着tap_do_read运行,然后在内核运行完毕后,返回用户态。这个时候,B进程内核栈的pt_regs也保存了用户态的指令指针寄存器,就接着在用户态的下一条指令开始运行就可以了。

假设,我们只有一个CPU,从B切换到C,从C又切换到A。在C切换到A的时候,还是按照”进程调度第一定律”,C进程还是会调用__schedule到达switch_to,在里面切换成为A的内核栈,然后运行finish_task_switch。

这个时候运行的finish_task_switch,才是A进程的finish_task_switch。运行完毕从__schedule返回的时候,从内核栈上才知道,当年是从btrfs_wait_for_no_snapshoting_writes调用进去的,因而应该返回btrfs_wait_for_no_snapshoting_writes继续执行,最后内核执行完毕返回用户态,同样恢复pt_regs,恢复用户态的指令指针寄存器,从用户态接着运行。

到这里你是不是有点理解为什么switch_to有三个参数呢?为啥有两个prev呢?其实我们从定义就可以看到。

#define switch_to(prev, next, last) \

do { \

prepare_switch_to(prev, next); \

\

((last) = __switch_to_asm((prev), (next))); \

} while (0)在上面的例子中,A切换到B的时候,运行到switch_to_asm这一行的时候,是在A的内核栈上运行的,prev是A,next是B。但是,A执行完switch_to_asm之后就被切换走了,当C再次切换到A的时候,运行到switch_to_asm,是从C的内核栈运行的。这个时候,prev是C,next是A,但是switch_to_asm里面切换成为了A当时的内核栈。

还记得当年的场景”prev是A,next是B”,__switch_to_asm里面return prev的时候,还没return的时候,prev这个变量里面放的还是C,因而它会把C放到返回结果中。但是,一旦return,就会弹出A当时的内核栈。这个时候,prev变量就变成了A,next变量就变成了B。这就还原了当年的场景,好在返回值里面的last还是C。

通过三个变量switch_to(prev = A, next=B, last=C),A进程就明白了,我当时被切换走的时候,是切换成B,这次切换回来,是从C回来的。

11.4 总结

这一节我们讲主动调度的过程,也即一个运行中的进程主动调用schedule让出CPU。在schedule里面会做两件事情,第一是选取下一个进程,第二是进行上下文切换。而上下文切换又分用户态进程空间的切换和内核态的切换。

12. 调度(下)

12.1 抢占式调度

上一节我们讲的主动调度是第一种方式,第二种方式,就是抢占式调度。什么情况下会发生抢占呢?

最常见的现象就是 一个进程执行时间太长了,是时候切换到另一个进程了 。那怎么衡量一个进程的运行时间呢?在计算机里面有一个时钟,会过一段时间触发一次时钟中断,通知操作系统,时间又过去一个时钟周期,这是个很好的方式,可以查看是否是需要抢占的时间点。

时钟中断处理函数会调用scheduler_tick(),它的代码如下:

void scheduler_tick(void)

{

int cpu = smp_processor_id();

struct rq *rq = cpu_rq(cpu);

struct task_struct *curr = rq->curr;

......

curr->sched_class->task_tick(rq, curr, 0);

cpu_load_update_active(rq);

calc_global_load_tick(rq);

......

}这个函数先取出当前cpu的运行队列,然后得到这个队列上当前正在运行中的进程的task_struct,然后调用这个task_struct的调度类的task_tick函数,顾名思义这个函数就是来处理时钟事件的。

如果当前运行的进程是普通进程,调度类为fair_sched_class,调用的处理时钟的函数为task_tick_fair。我们来看一下它的实现。

static void task_tick_fair(struct rq *rq, struct task_struct *curr, int queued)

{

struct cfs_rq *cfs_rq;

struct sched_entity *se = &curr->se;

for_each_sched_entity(se) {

cfs_rq = cfs_rq_of(se);

entity_tick(cfs_rq, se, queued);

}

......

}根据当前进程的task_struct,找到对应的调度实体sched_entity和cfs_rq队列,调用entity_tick。

static void

entity_tick(struct cfs_rq *cfs_rq, struct sched_entity *curr, int queued)

{

update_curr(cfs_rq);

update_load_avg(curr, UPDATE_TG);

update_cfs_shares(curr);

.....

if (cfs_rq->nr_running > 1)

check_preempt_tick(cfs_rq, curr);

}在entity_tick里面,我们又见到了熟悉的update_curr。它会更新当前进程的vruntime,然后调用check_preempt_tick。顾名思义就是,检查是否是时候被抢占了。

static void

check_preempt_tick(struct cfs_rq *cfs_rq, struct sched_entity *curr)

{

unsigned long ideal_runtime, delta_exec;

struct sched_entity *se;

s64 delta;

ideal_runtime = sched_slice(cfs_rq, curr);

delta_exec = curr->sum_exec_runtime - curr->prev_sum_exec_runtime;

if (delta_exec > ideal_runtime) {

resched_curr(rq_of(cfs_rq));

return;

}

......

se = __pick_first_entity(cfs_rq);

delta = curr->vruntime - se->vruntime;

if (delta < 0)

return;

if (delta > ideal_runtime)

resched_curr(rq_of(cfs_rq));

}check_preempt_tick先是调用sched_slice函数计算出的ideal_runtime,他是一个调度周期中,这个进程应该运行的实际时间。

sum_exec_runtime指进程总共执行的实际时间,prev_sum_exec_runtime指上次该进程被调度时已经占用的实际时间。每次在调度一个新的进程时都会把它的se->prev_sum_exec_runtime = se->sum_exec_runtime,所以sum_exec_runtime-prev_sum_exec_runtime就是这次调度占用实际时间。如果这个时间大于ideal_runtime,则应该被抢占了。

除了这个条件之外,还会通过__pick_first_entity取出红黑树中最小的进程。如果当前进程的vruntime大于红黑树中最小的进程的vruntime,且差值大于ideal_runtime,也应该被抢占了。

当发现当前进程应该被抢占,不能直接把它踢下来,而是把它标记为应该被抢占。为什么呢?因为进程调度第一定律呀,一定要等待正在运行的进程调用__schedule才行啊,所以这里只能先标记一下。

标记一个进程应该被抢占,都是调用resched_curr,它会调用set_tsk_need_resched,标记进程应该被抢占,但是此时此刻,并不真的抢占,而是打上一个标签TIF_NEED_RESCHED。

static inline void set_tsk_need_resched(struct task_struct *tsk)

{

set_tsk_thread_flag(tsk,TIF_NEED_RESCHED);

}另外一个可能抢占的场景是 当一个进程被唤醒的时候 。

我们前面说过,当一个进程在等待一个I/O的时候,会主动放弃CPU。但是当I/O到来的时候,进程往往会被唤醒。这个时候是一个时机。当被唤醒的进程优先级高于CPU上的当前进程,就会触发抢占。try_to_wake_up()调用ttwu_queue将这个唤醒的任务添加到队列当中。ttwu_queue再调用ttwu_do_activate激活这个任务。ttwu_do_activate调用ttwu_do_wakeup。这里面调用了check_preempt_curr检查是否应该发生抢占。如果应该发生抢占,也不是直接踢走当然进程,而也是将当前进程标记为应该被抢占。

static void ttwu_do_wakeup(struct rq *rq, struct task_struct *p, int wake_flags,

struct rq_flags *rf)

{

check_preempt_curr(rq, p, wake_flags);

p->state = TASK_RUNNING;

trace_sched_wakeup(p);

}到这里,你会发现,抢占问题只做完了一半。就是标识当前运行中的进程应该被抢占了,但是真正的抢占动作并没有发生。

12.2 抢占的时机

真正的抢占还需要时机,也就是需要那么一个时刻,让正在运行中的进程有机会调用一下__schedule。

你可以想象,不可能某个进程代码运行着,突然要去调用__schedule,代码里面不可能这么写,所以一定要规划几个时机,这个时机分为用户态和内核态。

12.2.1 用户态的抢占时机

对于用户态的进程来讲,从系统调用中返回的那个时刻,是一个被抢占的时机。

前面讲系统调用的时候,64位的系统调用的链路位do_syscall_64->syscall_return_slowpath->prepare_exit_to_usermode->exit_to_usermode_loop,当时我们还没关注exit_to_usermode_loop这个函数,现在我们来看一下。

static void exit_to_usermode_loop(struct pt_regs *regs, u32 cached_flags)

{

while (true) {

/* We have work to do. */

local_irq_enable();

if (cached_flags & _TIF_NEED_RESCHED)

schedule();

......

}

}现在我们看到在exit_to_usermode_loop函数中,上面打的标记起了作用,如果被打了_TIF_NEED_RESCHED,调用schedule进行调度,调用的过程和上一节解析的一样,会选择一个进程让出CPU,做上下文切换。

对于用户态的进程来讲,从中断中返回的那个时刻,也是一个被抢占的时机。

在arch/x86/entry/entry_64.S中有中断的处理过程。又是一段汇编语言代码,你重点领会它的意思就行,不要纠结每一行都看懂。

common_interrupt:

ASM_CLAC

addq $-0x80, (%rsp)

interrupt do_IRQ

ret_from_intr:

popq %rsp

testb $3, CS(%rsp)

jz retint_kernel

/* Interrupt came from user space */

GLOBAL(retint_user)

mov %rsp,%rdi

call prepare_exit_to_usermode

TRACE_IRQS_IRETQ

SWAPGS

jmp restore_regs_and_iret

/* Returning to kernel space */

retint_kernel:

#ifdef CONFIG_PREEMPT

bt $9, EFLAGS(%rsp)

jnc 1f

0: cmpl $0, PER_CPU_VAR(__preempt_count)

jnz 1f

call preempt_schedule_irq

jmp 0b中断处理调用的是do_IRQ函数,中断完毕后分为两种情况,一个是返回用户态,一个是返回内核态。这个通过注释也能看出来。

咱们先来来看返回用户态这一部分,先不管返回内核态的那部分代码,retint_user会调用prepare_exit_to_usermode,最终调用exit_to_usermode_loop,和上面的逻辑一样,发现有标记则调用schedule()。

12.2.2 内核态的抢占时机

对内核态的执行中,被抢占的时机一般发生在在preempt_enable()中。

在内核态的执行中,有的操作是不能被中断的,所以在进行这些操作之前,总是先调用preempt_disable()关闭抢占,当再次打开的时候,就是一次内核态代码被抢占的机会。

就像下面代码中展示的一样,preempt_enable()会调用preempt_count_dec_and_test(),判断preempt_count和TIF_NEED_RESCHED看是否可以被抢占。如果可以,就调用preempt_schedule->preempt_schedule_common->__schedule进行调度。还是满足进程调度第一定律的。

#define preempt_enable() \

do { \

if (unlikely(preempt_count_dec_and_test())) \

__preempt_schedule(); \

} while (0)

#define preempt_count_dec_and_test() \

({ preempt_count_sub(1); should_resched(0); })

static __always_inline bool should_resched(int preempt_offset)

{

return unlikely(preempt_count() == preempt_offset &&

tif_need_resched());

}

#define tif_need_resched() test_thread_flag(TIF_NEED_RESCHED)

static void __sched notrace preempt_schedule_common(void)

{

do {

......

__schedule(true);

......

} while (need_resched())

}在内核态也会遇到中断的情况,当中断返回的时候,返回的仍然是内核态。这个时候也是一个执行抢占的时机,现在我们再来上面中断返回的代码中返回内核的那部分代码,调用的是preempt_schedule_irq。

asmlinkage __visible void __sched preempt_schedule_irq(void)

{

......

do {

preempt_disable();

local_irq_enable();

__schedule(true);

local_irq_disable();

sched_preempt_enable_no_resched();

} while (need_resched());

......

}preempt_schedule_irq调用__schedule进行调度。还是满足进程调度第一定律的。

12.3 总结

第一条就是总结了进程调度第一定律的核心函数__schedule的执行过程,这是上一节讲的,因为要切换的东西比较多,需要你详细了解每一部分是如何切换的。

第二条总结了标记为可抢占的场景,第三条是所有的抢占发生的时机,这里是真正验证了进程调度第一定律的。

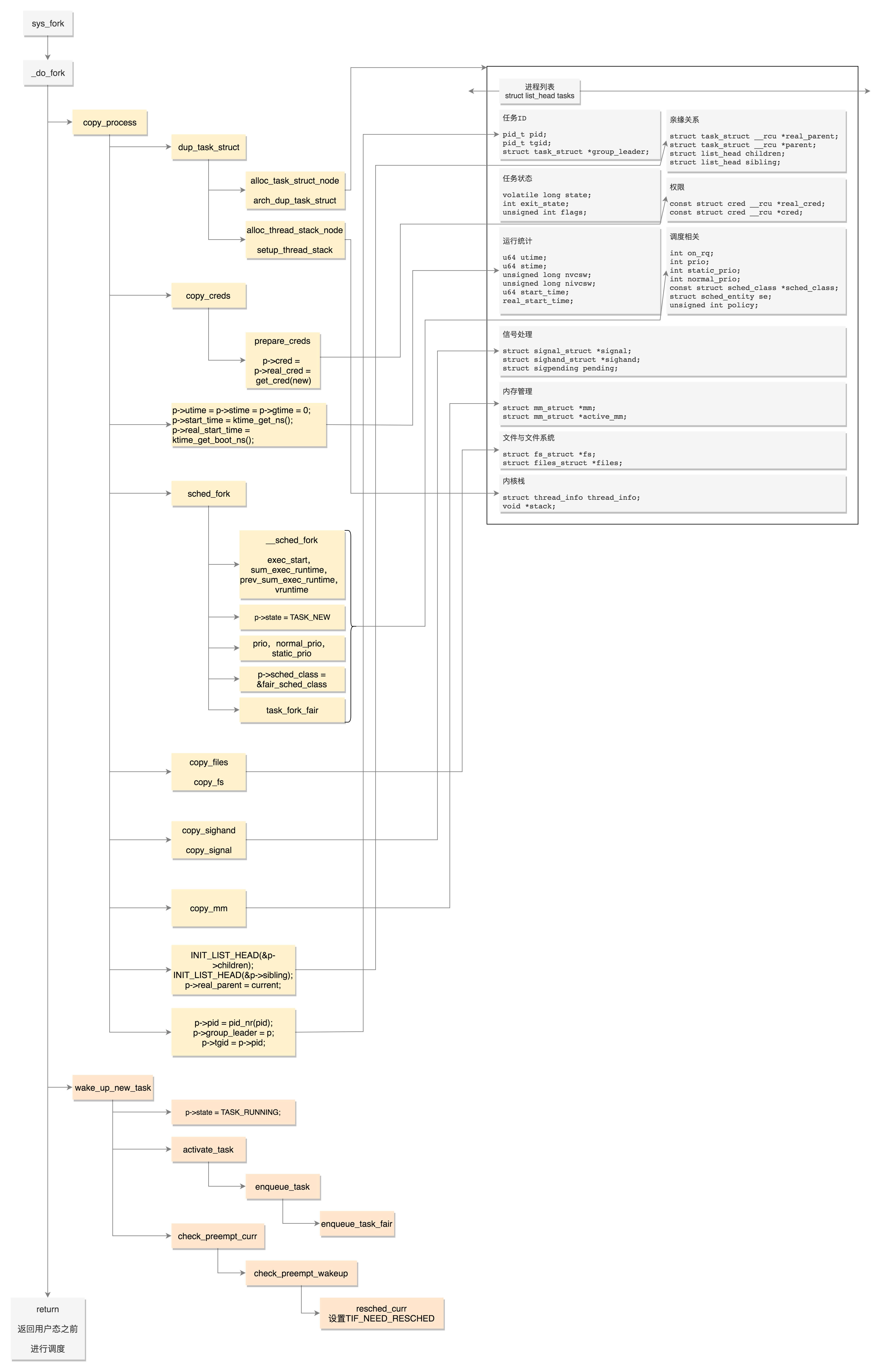

13. 进程的创建

fork是一个系统调用,根据咱们讲过的系统调用的流程,流程的最后会在sys_call_table中找到相应的系统调用sys_fork。

根据SYSCALL_DEFINE0这个宏的定义,下面这段代码就定义了sys_fork。

SYSCALL_DEFINE0(fork)

{

......

return _do_fork(SIGCHLD, 0, 0, NULL, NULL, 0);

}sys_fork会调用_do_fork。

long _do_fork(unsigned long clone_flags,

unsigned long stack_start,

unsigned long stack_size,

int __user *parent_tidptr,

int __user *child_tidptr,

unsigned long tls)

{

struct task_struct *p;

int trace = 0;

long nr;

......

p = copy_process(clone_flags, stack_start, stack_size,

child_tidptr, NULL, trace, tls, NUMA_NO_NODE);

......

if (!IS_ERR(p)) {

struct pid *pid;

pid = get_task_pid(p, PIDTYPE_PID);

nr = pid_vnr(pid);

if (clone_flags & CLONE_PARENT_SETTID)

put_user(nr, parent_tidptr);

......

wake_up_new_task(p);

......

put_pid(pid);

}

......

}13.1 fork的第一件大事:复制结构

_do_fork里面做的第一件大事就是copy_process。

这里我们再把task_struct的结构图拿出来,对比着看如何一个个复制。

static __latent_entropy struct task_struct *copy_process(

unsigned long clone_flags,

unsigned long stack_start,

unsigned long stack_size,

int __user *child_tidptr,

struct pid *pid,

int trace,

unsigned long tls,

int node)

{

int retval;

struct task_struct *p;

......

p = dup_task_struct(current, node);dup_task_struct主要做了下面几件事情:

- 调用alloc_task_struct_node分配一个task_struct结构;

- 调用alloc_thread_stack_node来创建内核栈,这里面调用__vmalloc_node_range分配一个连续的THREAD_SIZE的内存空间,赋值给task_struct的void *stack成员变量;

- 调用arch_dup_task_struct(struct task_struct dst, struct task_structsrc),将task_struct进行复制,其实就是调用memcpy;

- 调用setup_thread_stack设置thread_info。

到这里,整个task_struct复制了一份,而且内核栈也创建好了。

我们再接着看copy_process。

retval = copy_creds(p, clone_flags);轮到权限相关了,copy_creds主要做了下面几件事情:

- 调用prepare_creds,准备一个新的struct cred *new。如何准备呢?其实还是从内存中分配一个新的struct cred结构,然后调用memcpy复制一份父进程的cred;

- 接着p->cred = p->real_cred = get_cred(new),将新进程的”我能操作谁”和”谁能操作我”两个权限都指向新的cred。

接下来,copy_process重新设置进程运行的统计量。

p->utime = p->stime = p->gtime = 0;

p->start_time = ktime_get_ns();

p->real_start_time = ktime_get_boot_ns();接下来,copy_process开始设置调度相关的变量。

retval = sched_fork(clone_flags, p);sched_fork主要做了下面几件事情:

- 调用__sched_fork,在这里面将on_rq设为0,初始化sched_entity,将里面的exec_start、sum_exec_runtime、prev_sum_exec_runtime、vruntime都设为0。你还记得吗,这几个变量涉及进程的实际运行时间和虚拟运行时间。是否到时间应该被调度了,就靠它们几个;

- 设置进程的状态p->state = TASK_NEW;

- 初始化优先级prio、normal_prio、static_prio;

- 设置调度类,如果是普通进程,就设置为p->sched_class = &fair_sched_class;

- 调用调度类的task_fork函数,对于CFS来讲,就是调用task_fork_fair。在这个函数里,先调用update_curr,对于当前的进程进行统计量更新,然后把子进程和父进程的vruntime设成一样,最后调用place_entity,初始化sched_entity。这里有一个变量sysctl_sched_child_runs_first,可以设置父进程和子进程谁先运行。如果设置了子进程先运行,即便两个进程的vruntime一样,也要把子进程的sched_entity放在前面,然后调用resched_curr,标记当前运行的进程TIF_NEED_RESCHED,也就是说,把父进程设置为应该被调度,这样下次调度的时候,父进程会被子进程抢占。

接下来,copy_process开始初始化与文件和文件系统相关的变量。

retval = copy_files(clone_flags, p);

retval = copy_fs(clone_flags, p);copy_files主要用于复制一个进程打开的文件信息。这些信息用一个结构files_struct来维护,每个打开的文件都有一个文件描述符。在copy_files函数里面调用dup_fd,在这里面会创建一个新的files_struct,然后将所有的文件描述符数组fdtable拷贝一份。

copy_fs主要用于复制一个进程的目录信息。这些信息用一个结构fs_struct来维护。一个进程有自己的根目录和根文件系统root,也有当前目录pwd和当前目录的文件系统,都在fs_struct里面维护。copy_fs函数里面调用copy_fs_struct,创建一个新的fs_struct,并复制原来进程的fs_struct。

接下来,copy_process开始初始化与信号相关的变量。

init_sigpending(&p->pending);

retval = copy_sighand(clone_flags, p);

retval = copy_signal(clone_flags, p);copy_sighand会分配一个新的sighand_struct。这里最主要的是维护信号处理函数,在copy_sighand里面会调用memcpy,将信号处理函数sighand->action从父进程复制到子进程。

init_sigpending和copy_signal用于初始化,并且复制用于维护发给这个进程的信号的数据结构。copy_signal函数会分配一个新的signal_struct,并进行初始化。

接下来,copy_process开始复制进程内存空间。

retval = copy_mm(clone_flags, p);进程都自己的内存空间,用mm_struct结构来表示。copy_mm函数中调用dup_mm,分配一个新的mm_struct结构,调用memcpy复制这个结构。dup_mmap用于复制内存空间中内存映射的部分。前面讲系统调用的时候,我们说过,mmap可以分配大块的内存,其实mmap也可以将一个文件映射到内存中,方便可以像读写内存一样读写文件,这个在内存管理那节我们讲。

接下来,copy_process开始分配pid,设置tid,group_leader,并且建立进程之间的亲缘关系。

INIT_LIST_HEAD(&p->children);

INIT_LIST_HEAD(&p->sibling);

......

p->pid = pid_nr(pid);

if (clone_flags & CLONE_THREAD) {

p->exit_signal = -1;

p->group_leader = current->group_leader;

p->tgid = current->tgid;

} else {

if (clone_flags & CLONE_PARENT)

p->exit_signal = current->group_leader->exit_signal;

else

p->exit_signal = (clone_flags & CSIGNAL);

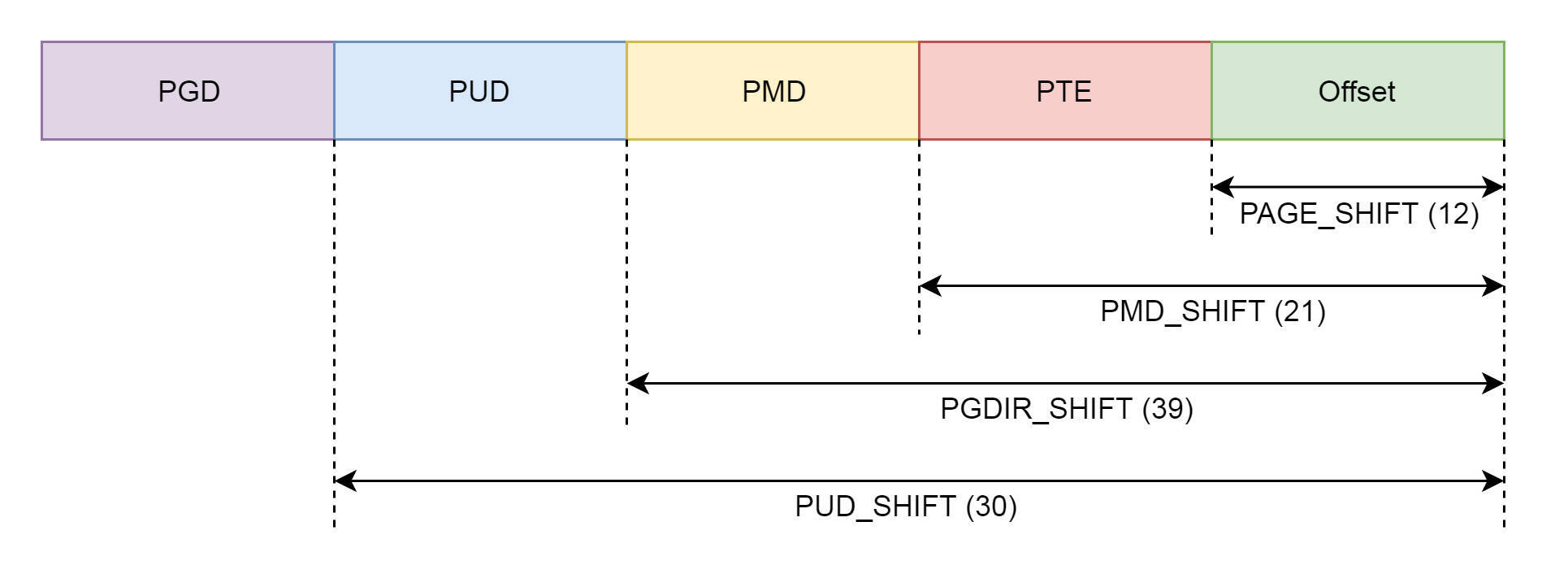

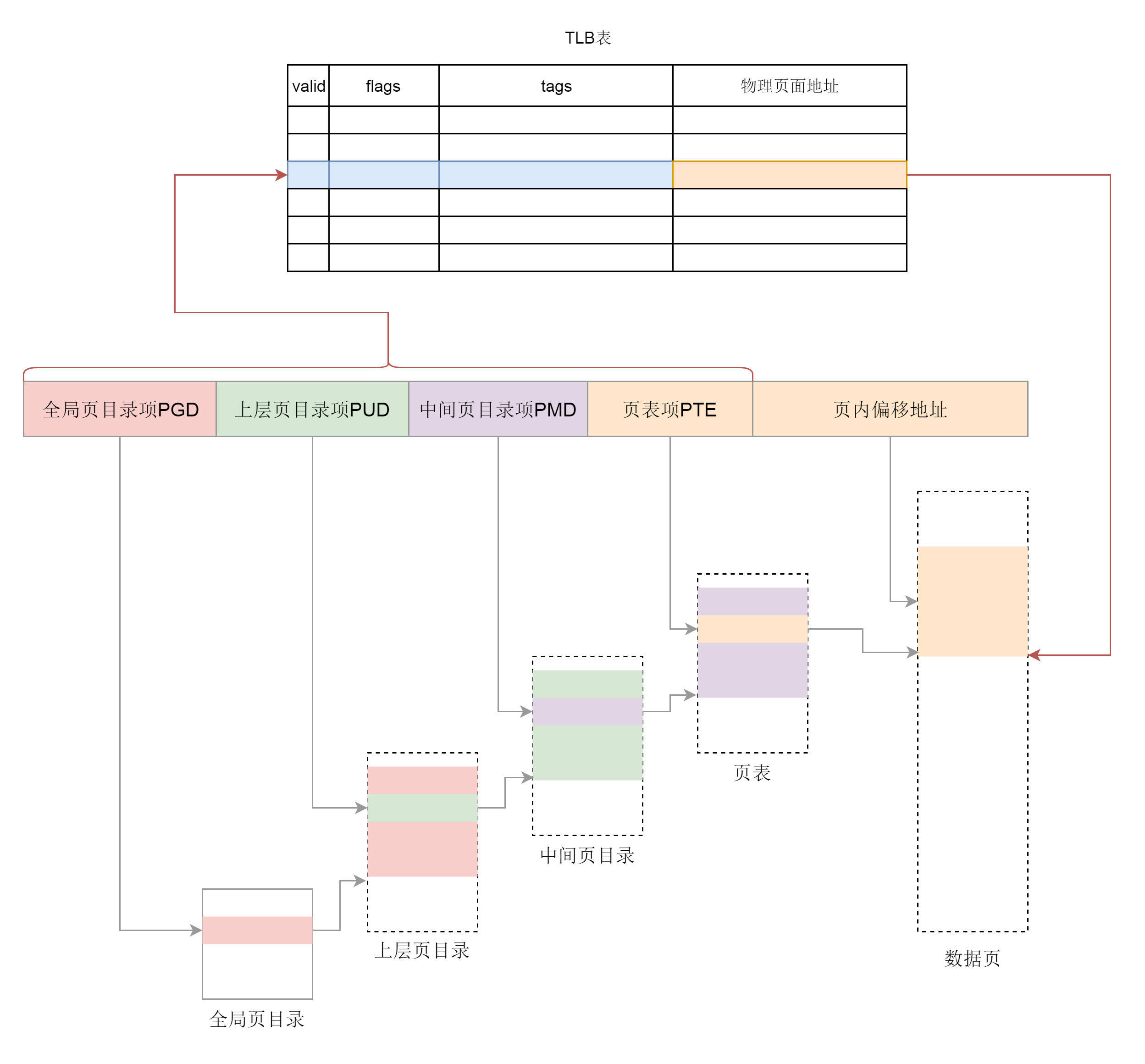

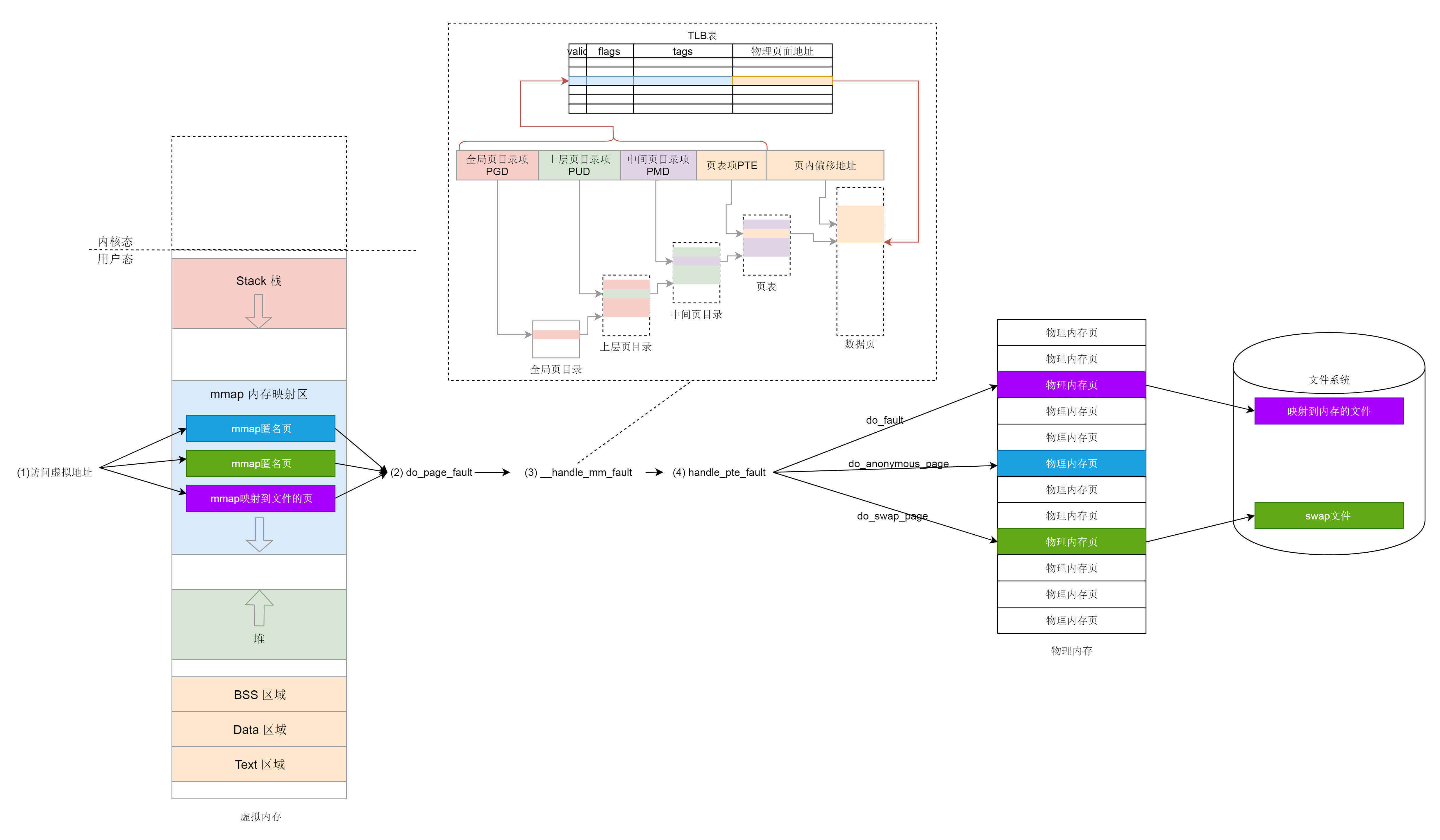

p->group_leader = p;