课程资源: https://github.com/kibaamor/101

代码走读:https://github.com/kibaamor/101/blob/master/source-code-reading/readme.MD, https://cncamp.notion.site/golang-843c958dafc54f0aab4fa1e4527da78a, https://cncamp.notion.site/kubernetes-8a9d48ee26284b3c8ddf9de4c62ea895, https://cncamp.notion.site/mesh-adf426d889f0448faa1671f5e05c9f12

iptables: https://ipset.netfilter.org/iptables-extensions.man.html

Go 语言特性

多线程

并发和并行

- 并发(concurrency):两个或多个事件在同一时间间隔发生。

- 并行(parallellism):两个或者多个事件在同一时刻发生。

Go 语言进阶

线程调度

深入理解 Go 语言线程调度

- 进程:资源分配的基本单位

- 线程:调度的基本单位

- 无论是线程还是进程,在 linux 中都以 task_struct 描述,从内核角度看,与进程无本质区别

- Glibc 中的 pthread 库提供 NPTL(Native POSIX Threading Library)支持

进程切换开销

- 直接开销

- 切换页表全局目录(PGD)

- 切换内核态堆栈

- 切换硬件上下文(进程恢复前,必须装入寄存器的数据统称为硬件上下文)

- 刷新TLB

- 系统调度器的代码执行

- 间接开销

- CPU 缓存失效导致的进程需要到内存直接访问的IO 操作变多

线程切换开销

- 线程本质上只是一批共享资源的进程,线程切换本质上依然需要内核进行进程切换。

- 一组线程因为共享内存资源,因此一个进程的所有线程共享虚拟地址空间,线程切换相比进程切换,主要节省了虚拟地址空间的切换。

Goroutine

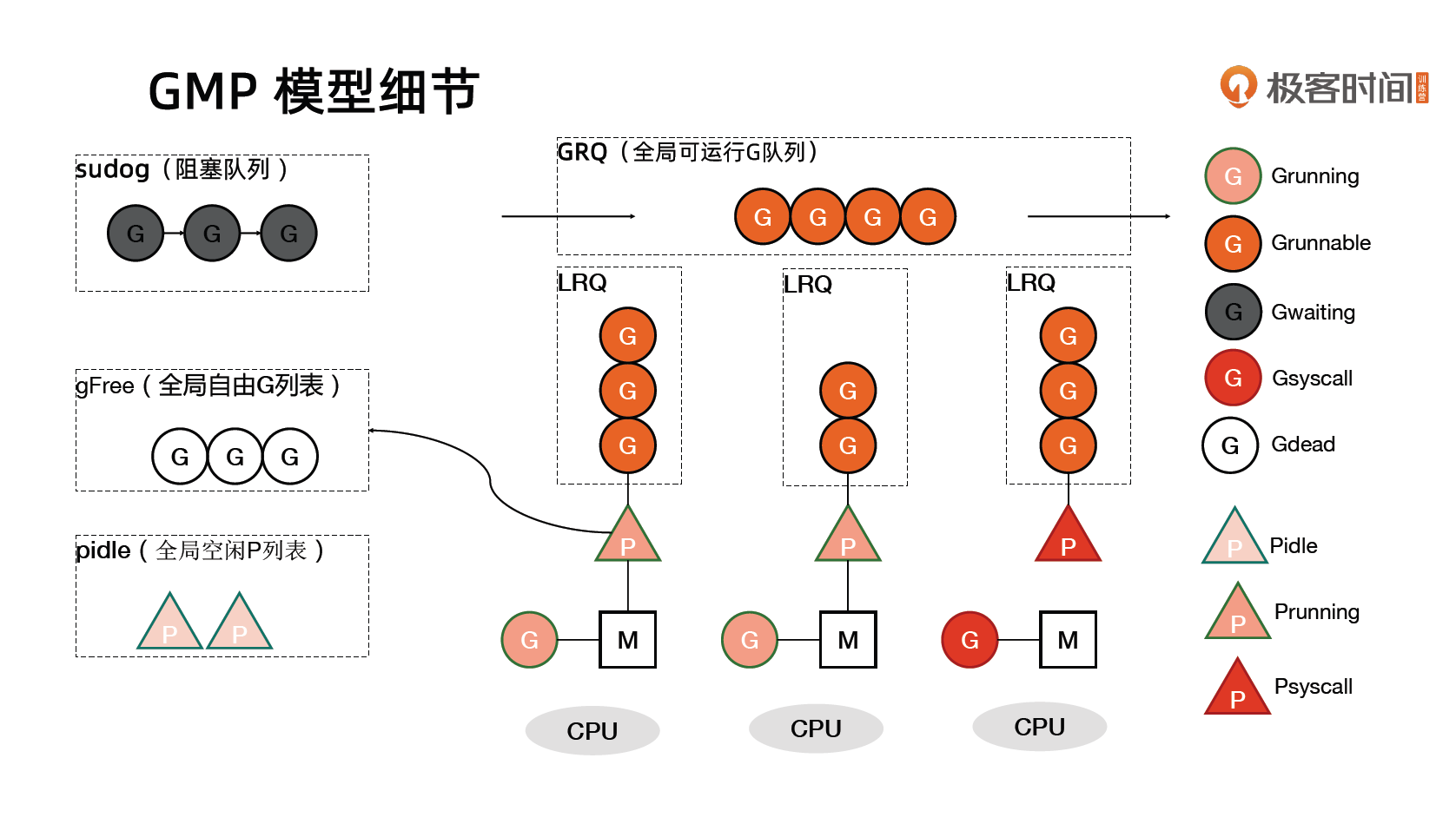

Go 语言基于 GMP 模型实现用户态线程

- G:表示 goroutine,每个 goroutine 都有自己的栈空间,定时器,初始化的栈空间在2k 左右,空间会随着需求增长。

- M:抽象化代表内核线程,记录内核线程栈信息,当 goroutine 调度到线程时,使用该 goroutine 自己的栈信息。

- P:代表调度器,负责调度 goroutine,维护一个本地 goroutine 队列,M 从 P 上获得 goroutine 并执行,同时还负责部分内存的管理。

GMP模型细节

G 所处的位置

- 进程都有一个全局的 G 队列

- 每个 P 拥有自己的本地执行队列

- 有不在运行队列中的 G

- 处于 channel 阻塞态的 G 被放在 sudog

- 脱离 P 绑定在 M 上的 G,如系统调用

- 为了复用,执行结束进入 P 的 gFree 列表中的 G

Goroutine 创建过程

- 获取或者创建新的 Goroutine 结构体

- 从处理器的 gFree 列表中查找空闲的 Goroutine

- 如果不存在空闲的 Goroutine,会通过 runtime.malg 创建一个栈大小足够的新结构体

- 将函数传入的参数移到 Goroutine 的栈上

- 更新 Goroutine 调度相关的属性,更新状态为 _Grunnable

- 返回的 Goroutine 会存储到全局变量 allgs 中

将 Goroutine 放到运行队列上

关键函数

func runqput(pp *p, gp *g, next bool)

- Goroutine 设置到处理器的 runnext 作为下一个处理器执行的任务

- 当处理器的本地运行队列已经没有剩余空间时,就会把本地队列中的前一半 Goroutine 和待加入的 Goroutine 一起打乱顺序后通过

runtime.runqputslow添加到调度器持有的全局运行队列上

调度器行为

关键函数

func schedule()可以参考的资料《深入分析Go1.18 GMP调度器底层原理》

- 为了保证公平,当全局运行队列中有待执行的 Goroutine 时,通过 schedtick 保证有一定几率(1/61) 通过

runtime.globrunqget从全局的运行队列中查找一个的 Goroutine 来运行 - 从处理器本地的运行队列中查找待执行的 Goroutine

- 如果前两种方法都没有找到 Goroutine,会通过

runtime.findrunnable进行阻塞地查找 Goroutine - 从本地运行队列、全局运行队列中查找

- 从网络轮询器中查找是否有 Goroutine 等待运行

- 通过 runtime.runqsteal 尝试从其他随机的处理器中窃取待运行的 Goroutine

源码走读

关于M和P的数量的问题答疑昨天群里陷入了讨论,我看了一下代码把调用关系列在了这个文档里

设计考量

- 默认配置下,P的数量 = CPU个数,可通过GOMAXPROCS修改,上限是256

- M数量是内核线程数量,M大于P,上限是10000

- P的数量在调度器初始化的procresize中控制

- 当调度器进行调度,唤醒P的时候,会通过met获取idle m,如果获取不到,则创建新的M(也就是内核线程)

- 这样做的目的是,M可能陷入系统调用,而系统调用可能是阻塞的,比如磁盘读取,这个时候CPU是空闲的,创建新的M并与P关联,可以让更多的G被调度,充分利用CPU。

代码分析

/usr/local/go/src/runtime/proc.go

schedinit()-->

sched.maxmcount = 10000 // m count limit is 10000 by default

procs = atoi32(gogetenv("GOMAXPROCS"))

procresize(procs)-->

nallp := make([]*p, nprocs) // P count is read from environment variable GOMAXPROCS

pp.init(i)

p.m.set(mget()) // mget to associate p with idle m

schedule()-->

wakep()-->

startm()-->

nmp := mget()

if nmp == nil {

newm(fn, _p_, id)-->

mp := new(m)

mp.g0 = malg(8192 * sys.StackGuardMultiplier) // g0 is the maintainer for the m, like create other G

}

nmp.nextp.set(_p_)

notewakeup(&nmp.park)-->

semawakeup((*m)(unsafe.Pointer(v)))

pthread_cond_signal(&mp.cond) // wake up the kernel thread内存管理

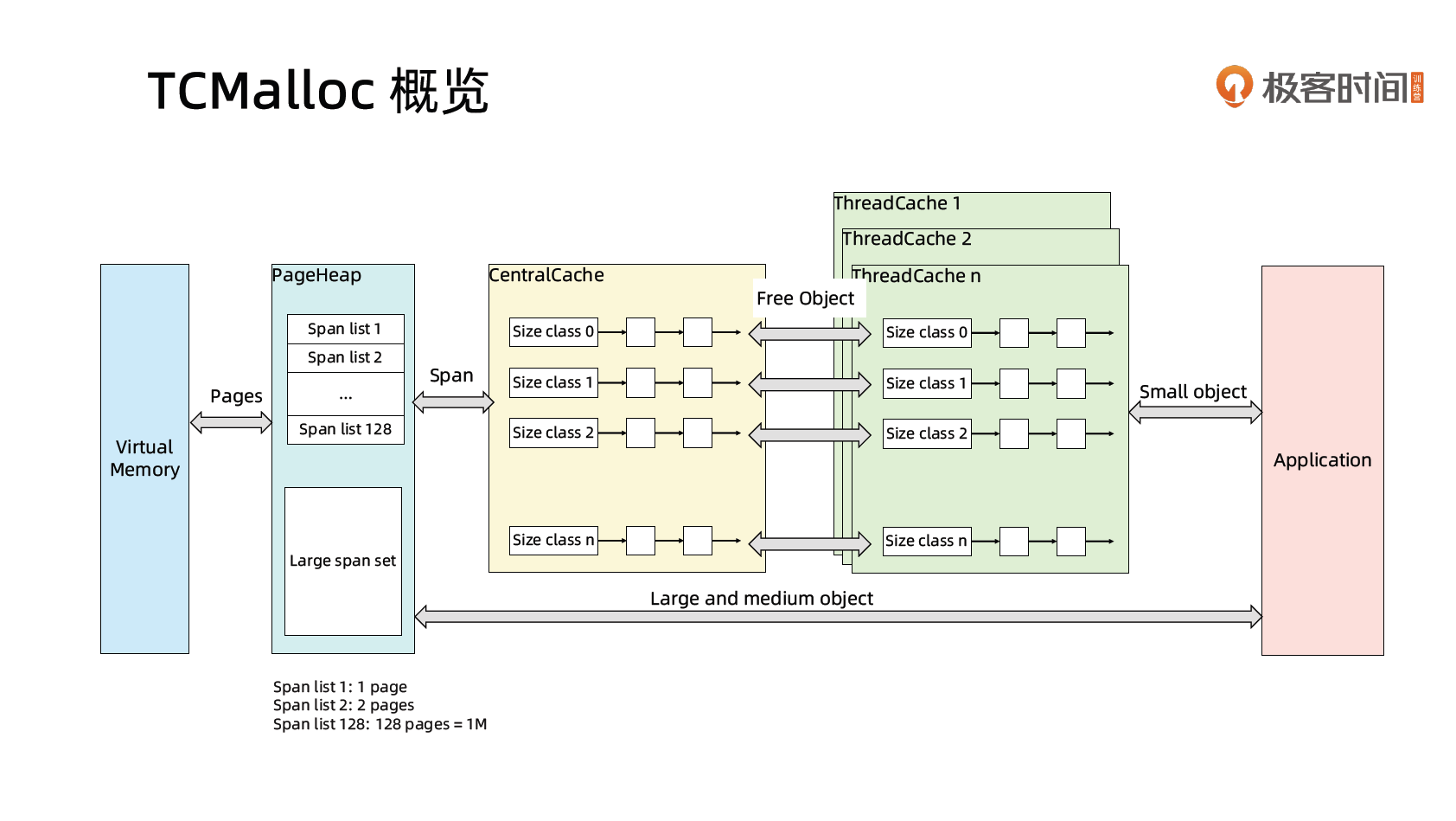

TCMalloc

- page: 内存页,一块 8K 大小的内存空间。Go 与操作系统之间的内存申请和释放,都是以 page 为单位的

- span: 内存块,一个或多个连续的 page 组成一个 span

- sizeclass: 空间规格,每个 span 都带有一个 sizeclass ,标记着该 span 中的 page 应该如何使用

object: 对象,用来存储一个变量数据内存空间,一个 span 在初始化时,会被切割成一堆等大的 object ;假设 object 的大小是 16B ,span 大小是 8K ,那么就会把 span 中的 page 就会被初始化 8K / 16B = 512 个 object 。所谓内存分配,就是分配一个object 出去

对象大小定义

- 小对象大小:0~256KB

- 中对象大小:256KB~1MB

- 大对象大小:>1MB

- 小对象的分配流程

- ThreadCache -> CentralCache -> PageHeap,大部分时候,ThreadCache 缓存都是足够的,不需要去访问 CentralCache 和 PageHeap,无系统调用配合无锁分配,分配效率是非常高的

- 中对象分配流程

- 直接在 PageHeap 中选择适当的大小即可,128 Page 的 Span 所保存的最大内存就是 1MB

- 大对象分配流程

- 从 large span set 选择合适数量的页面组成 span,用来存储数据

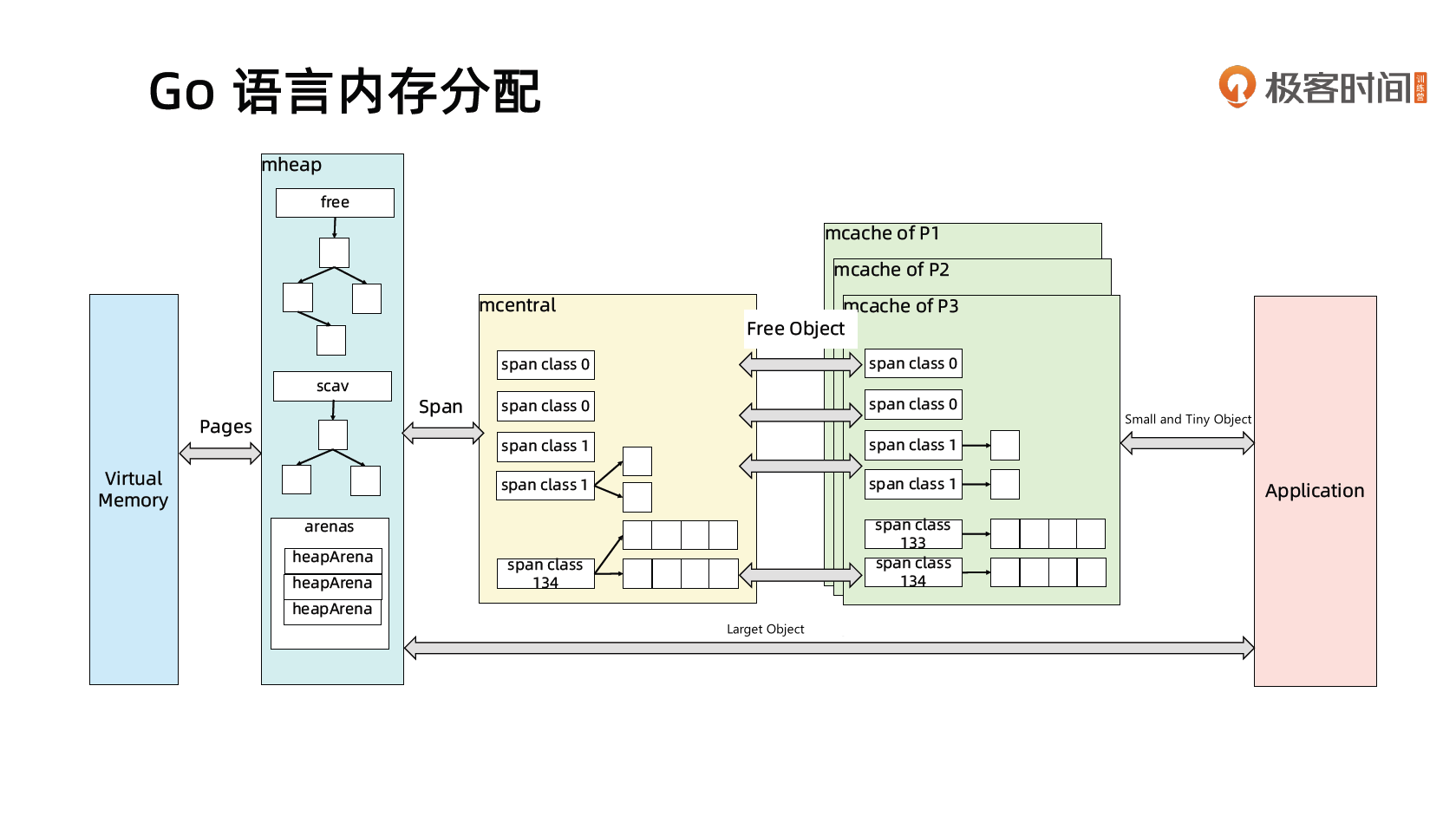

Go 语言内存分配

关键函数

func mallocgcGo 语言内存分配可视化指南(A visual guide to Go Memory Allocator from scratch (Golang))

对象大小定义

- 小(Small)对象:<=32KB

- 其中大小 <16B 且不是指针的对象称为微(Tiny)对象

- 大(Large)对象:>32KB

- 小(Small)对象:<=32KB

mcache:小对象的内存分配直接走

- size class 从 1 到 66,每个 class 两个 span (scan 和 noscan)

- Span 大小是 8KB,按 span class 大小切分

- mcentral

- Span 内的所有内存块都被占用时,没有剩余空间继续分配对象,mcache 会向 mcentral 申请 1 个 span,mcache 拿到 span 后继续分配对象

- 当 mcentral 向 mcache 提供 span 时,如果没有符合条件的 span,mcentral 会向 mheap 申请 span

- mheap

- 当 mheap 没有足够的内存时,mheap 会向 OS 申请内存

- mheap 把 Span 组织成了树结构,而不是链表

- 然后把 Span 分配到 heapArena 进行管理,它包含地址映射和 span 是否包含指针等位图

- 为了更高效的分配、回收和再利用内存

- mspan

- allocBits

- 记录了每块内存分配的情况

- gcmarkBits

- 记录了每块内存的引用情况,标记阶段对每块内存进行标记,有对象引用的内存标记为 1,没有的标记为 0

- allocBits

Go 语言 GC

Golang 的汇编看不懂时可以看 A Quick Guide to Go’s Assembler

可以参考的资料《Golang 垃圾回收(一)概述》、《golang 垃圾回收(二)屏障技术》、《golang 垃圾回收(三)插入写屏障》、《golang 垃圾回收(四)删除写屏障》、《golang 垃圾回收(五)混合写屏障》

混合写屏障伪代码

// src/runtime/mbarrier.go

// Go uses a hybrid barrier that combines a Yuasa-style deletion

// barrier—which shades the object whose reference is being

// overwritten—with Dijkstra insertion barrier—which shades the object

// whose reference is being written. The insertion part of the barrier

// is necessary while the calling goroutine's stack is grey. In

// pseudocode, the barrier is:

writePointer(slot, ptr):

shade(*slot) // 删除写屏障(Yuasa-style 屏障)

if current stack is grey:

shade(ptr) // 插入写屏障(Dijkstra屏障)

*slot = ptrGo 实际实现为

writePointer(slot, ptr):

shade(*slot)

shade(ptr)

*slot = ptr垃圾回收触发机制

- 内存分配量达到阀值触发 GC

- 每次内存分配时都会检查当前内存分配量是否已达到阀值,如果达到阀值则立即启动 GC。

- 阀值 = 上次 GC 内存分配量 * 内存增长率

- 内存增长率由环境变量 GOGC 控制,默认为 100,即每当内存扩大一倍时启动 GC。

- 每次内存分配时都会检查当前内存分配量是否已达到阀值,如果达到阀值则立即启动 GC。

- 定期触发 GC

- 默认情况下,最长 2 分钟触发一次 GC,这个间隔在

src/runtime/proc.go:forcegcperiod变量中被声明

- 默认情况下,最长 2 分钟触发一次 GC,这个间隔在

- 手动触发

- 程序代码中也可以使用

runtime.GC()来手动触发 GC。这主要用于 GC 性能测试和统计。

- 程序代码中也可以使用

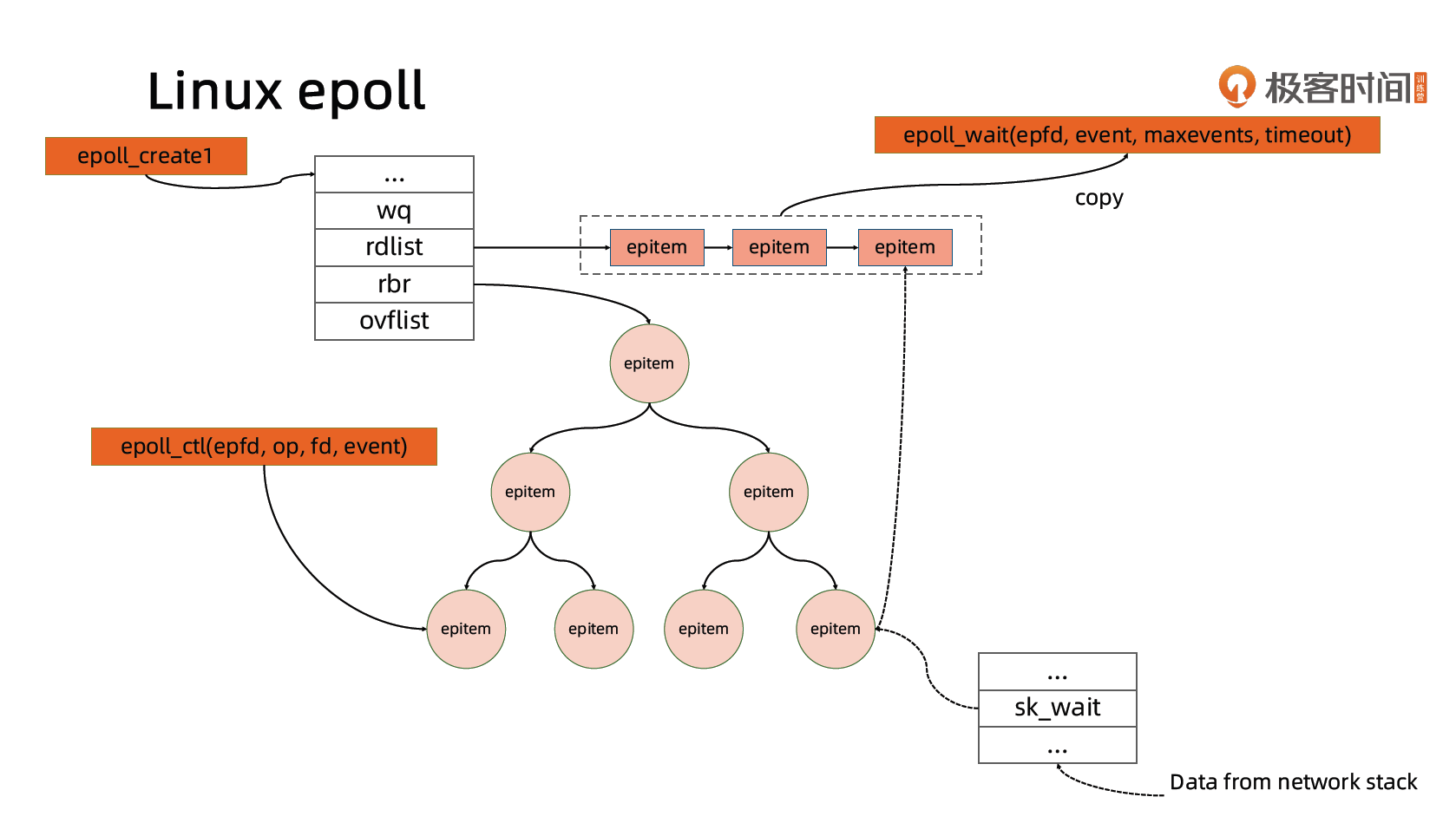

动手编写一个 HTTP Server

http.ListenAndServe()-->

server.ListenAndServe()-->

net.Listen("tcp", addr)-->

lc.Listen(context.Background(), network, address)-->

sl.listenTCP(ctx, la)-->

fd, err := internetSocket(ctx, sl.network, laddr, nil, syscall.SOCK_STREAM, 0, "listen", sl.ListenConfig.Control)-->

socket(ctx, net, family, sotype, proto, ipv6only, laddr, raddr, ctrlFn)-->

sysSocket(family, sotype, proto) // syscall.Socket and return fd

fd, err = newFD(s, family, sotype, net) // fd.pfd.sysfd = sysfd(socket fd)

fd.listenStream(laddr, listenerBacklog(), ctrlFn)-->

syscall.Bind(fd.pfd.Sysfd, lsa) // bind socket with address

listenFunc() // syscall.Listen

fd.init()-->

runtime_pollServerInit()--> // fd_poll_runtime.go

poll_runtime_pollServerInit()--> // netpoll.go

netpollGenericInit()-->

netpollinit()--> // netpoll_epoll.go

epollcreate1()

epollctl(epfd, _EPOLL_CTL_ADD, r, &ev)

runtime_pollOpen()-->

poll_runtime_pollOpen()--> // netpoll.go

netpollopen()--> // netpoll_epoll.go

var ev epollevent

ev.events = _EPOLLIN | _EPOLLOUT | _EPOLLRDHUP | _EPOLLET

*(**pollDesc)(unsafe.Pointer(&ev.data)) = pd

return -epollctl(epfd, _EPOLL_CTL_ADD, int32(fd), &ev)

srv.Serve(ln)-->

l.Accept()--> // tcpsocket.go

l.accept()--> // return TCPConn which holds the connection fd

fd := ln.fd.accept()-->

fd.pfd.Accept()--> // fd_unix.go syscall.Accept4

if err == nil {

return s, rsa, "", err

}

switch err {

case syscall.EAGAIN:

if fd.pd.pollable() {

fd.pd.waitRead()-->

runtime_pollWait()-->poll_runtime_pollWait()-->netpollblock()-->

atomic.Casuintptr(gpp, 0, pdWait)

gopark(netpollblockcommit, unsafe.Pointer(gpp), waitReasonIOWait, traceEvGoBlockNet, 5)-->

mcall(park_m) // put the go routine to park, schedule->findrunnable will wake it up

}

go c.serve(connCtx)-->c.readRequest(ctx)-->

req, err := readRequest(c.bufr, keepHostHeader)-->tp.ReadLine()-->r.readLineSlice()-->r.R.ReadLine()-->b.fill()-->

b.rd.Read(b.buf[b.w:])--> // fd_unix.go Read implements io.Reader.

ignoringEINTRIO(syscall.Read, fd.Sysfd, p) // syscall.Read// shedule parked go routine

schedule()-->findrunnable()-->

list := netpoll(0)--> //proc.go

n := epollwait(epfd, &events[0], int32(len(events)), waitms)

for i := int32(0); i < n; i++ {

netpollready(&toRun, pd, mode)-->

rg = netpollunblock(pd, 'r', true) // find related go routine of the epoll fd

toRun.push(rg)

}

startIdle(n)-->startmLinux epoll

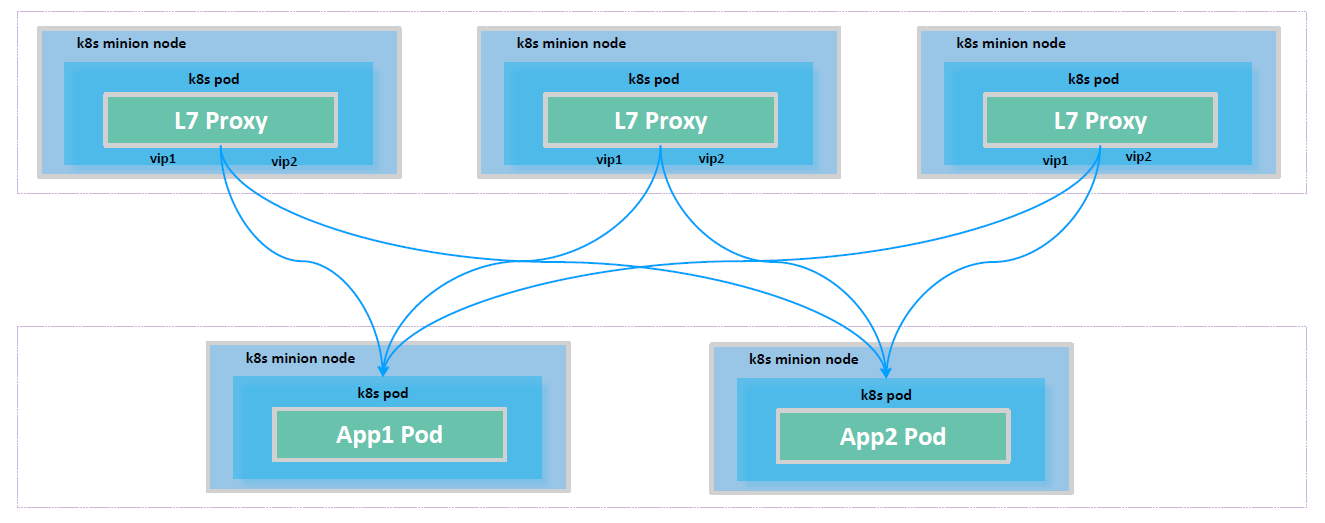

HttpServer 的实现细节

Go 语言将协程与 fd 资源绑定

- 一个 socket fd 与一个协程绑定

- 当 socket fd 未就绪时,将对应协程设置为 Gwaiting 状态,将 CPU 时间片让给其他协程

- Go 语言 runtime 调度器进行调度唤醒协程时,检查 fd 是否就绪,如果就绪则将协程置为 Grunnable 并加入执行队列

- 协程被调度后处理 fd 数据

Docker 核心技术

理解Docker

Linux 内核代码中 Namespace 的实现

进程数据结构

// include/linux/sched.h

struct task_struct {

//...

/* Namespaces: */

struct nsproxy *nsproxy;

//...

};Namespace 数据结构

// include/linux/nsproxy.h

/*

* A structure to contain pointers to all per-process

* namespaces - fs (mount), uts, network, sysvipc, etc.

*

* The pid namespace is an exception -- it's accessed using

* task_active_pid_ns. The pid namespace here is the

* namespace that children will use.

*

* 'count' is the number of tasks holding a reference.

* The count for each namespace, then, will be the number

* of nsproxies pointing to it, not the number of tasks.

*

* The nsproxy is shared by tasks which share all namespaces.

* As soon as a single namespace is cloned or unshared, the

* nsproxy is copied.

*/

struct nsproxy {

refcount_t count;

struct uts_namespace *uts_ns;

struct ipc_namespace *ipc_ns;

struct mnt_namespace *mnt_ns;

struct pid_namespace *pid_ns_for_children;

struct net *net_ns;

struct time_namespace *time_ns;

struct time_namespace *time_ns_for_children;

struct cgroup_namespace *cgroup_ns;

};Linux 对 Namespace 操作方法

clone

在创建新进程的系统调用时,可以通过 flags 参数指定需要新建的 Namespace 类型:

// CLONE_NEWCGROUP / CLONE_NEWIPC / CLONE_NEWNET / CLONE_NEWNS / CLONE_NEWPID / CLONE_NEWUSER / CLONE_NEWUTS

int clone(int (*fn)(void *), void *child_stack, int flags, void *arg)setns

该系统调用可以让调用进程加入某个已经存在的 Namespace 中:

Int setns(int fd, int nstype)unshare

该系统调用可以将调用进程移动到新的 Namespace 下:

int unshare(int flags)关于 namespace 的常用操作

- 查看当前系统的 namespace:

lsns -t <type> - 查看某进程的 namespace:

ls -la /proc/<pid>/ns/ - 查看某命令的 namespace:

sudo lsns | grep <command name> - 进入某 namespace 运行命令:

nsenter -t <pid> -n ip addr - 在新 network namespace 运行命令:

unshare -fn sleep 60

Linux 内核代码中 Cgroups 的实现

进程数据结构

// include/linux/sched.h

struct task_struct {

//...

#ifdef CONFIG_CGROUPS

/* Control Group info protected by css_set_lock: */

struct css_set __rcu *cgroups;

/* cg_list protected by css_set_lock and tsk->alloc_lock: */

struct list_head cg_list;

#endif

//...

};css_set 是 cgroup_subsys_state 对象的集合数据结构

// include/linux/cgroup-defs.h

/*

* A css_set is a structure holding pointers to a set of

* cgroup_subsys_state objects. This saves space in the task struct

* object and speeds up fork()/exit(), since a single inc/dec and a

* list_add()/del() can bump the reference count on the entire cgroup

* set for a task.

*/

struct css_set {

/*

* Set of subsystem states, one for each subsystem. This array is

* immutable after creation apart from the init_css_set during

* subsystem registration (at boot time).

*/

struct cgroup_subsys_state *subsys[CGROUP_SUBSYS_COUNT];

//...

};cgroups

cgroups 实现了对资源的配额和度量

- blkio: 这个子系统设置限制每个块设备的输入输出控制。例如:磁盘,光盘以及 USB 等等。

- CPU: 这个子系统使用调度程序为 cgroup 任务提供 CPU 的访问。

- cpuacct: 产生 cgroup 任务的CPU 资源报告。

- cpuset: 如果是多核心的 CPU,这个子系统会为 cgroup 任务分配单独的 CPU 和内存。

- devices: 允许或拒绝 cgroup 任务对设备的访问。

- freezer: 暂停和恢复 cgroup 任务。

- memory: 设置每个 cgroup 的内存限制以及产生内存资源报告。

- net_cls: 标记每个网络包以供 cgroup 方便使用。

- ns: 名称空间子系统。

- pid: 进程标识子系统。

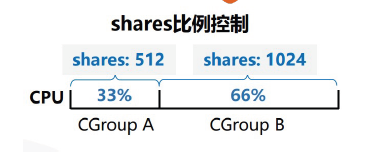

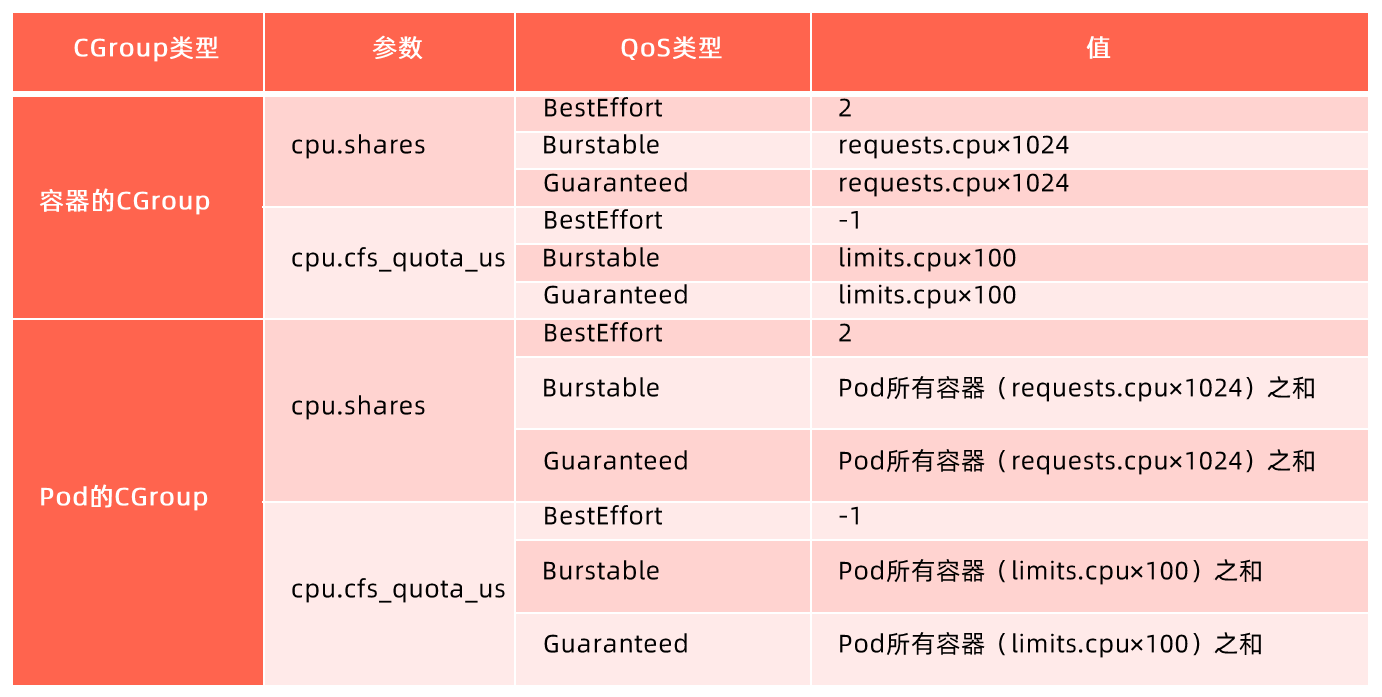

CPU 子系统

- cpu.shares: 可出让的能获得 CPU 使用时间的相对值。

- cpu.cfs_period_us:cfs_period_us 用来配置时间周期长度,单位为 us(微秒)。

- cpu.cfs_quota_us:cfs_quota_us 用来配置当前 Cgroup 在 cfs_period_us 时间内最多能使用的 CPU 时间数,单位为 us(微秒)。

- cpu.stat : Cgroup 内的进程使用的 CPU 时间统计。

- nr_periods : 经过 cpu.cfs_period_us 的时间周期数量。

- nr_throttled : 在经过的周期内,有多少次因为进程在指定的时间周期内用光了配额时间而受到限制。

- throttled_time : Cgroup 中的进程被限制使用CPU 的总用时,单位是 ns(纳秒)

Linux 调度器

内核默认提供了 5 个调度器,Linux 内核使用 struct sched_class 来对调度器进行抽象:

- Stop 调度器,

stop_sched_class:优先级最高的调度类,可以抢占其他所有进程,不能被其他进程抢占; - Deadline 调度器,

dl_sched_class:使用红黑树,把进程按照绝对截止期限进行排序,选择最小进程进行调度运行; - RT 调度器,

rt_sched_class:实时调度器,为每个优先级维护一个队列; - CFS 调度器,

cfs_sched_class:完全公平调度器,采用完全公平调度算法,引入虚拟运行时间概念; - IDLE-Task 调度器,

idle_sched_class:空闲调度器,每个 CPU 都会有一个 idle 线程,当没有其他进程可以调度时,调度运行 idle 线程。

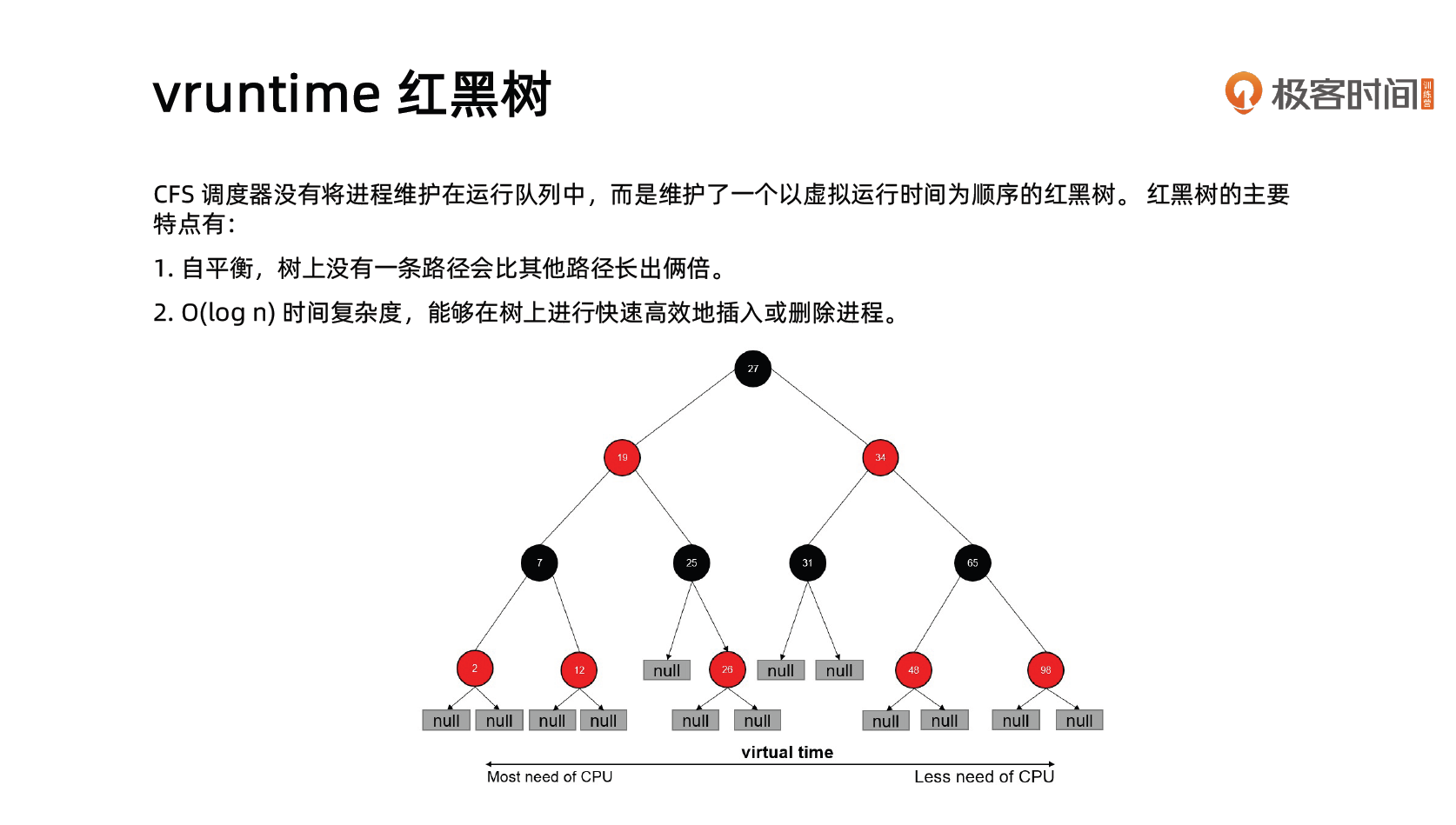

CFS 调度器

CFS 是 Completely Fair Scheduler 简称,即完全公平调度器。

- CFS 实现的主要思想是维护为任务提供处理器时间方面的平衡,这意味着应给进程分配相当数量的处理器。

- 分给某个任务的时间失去平衡时,应给失去平衡的任务分配时间,让其执行。

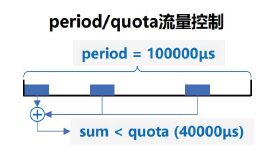

CFS 通过虚拟运行时间(vruntime)来实现平衡,维护提供给某个任务的时间量。

vruntime = 实际运行时间 * 1024 / 进程权重进程按照各自不同的速率在物理时钟节拍内前进,优先级高则权重大,其虚拟时钟比真实时钟跑得慢,但获得比较多的运行时间。

vruntime 红黑树

CFS进程调度

cpuacct 子系统

用于统计 Cgroup 及其子 Cgroup 下进程的 CPU 的使用情况。

- cpuacct.usage

包含该 Cgroup 及其子 Cgroup 下进程使用 CPU 的时间,单位是 ns(纳秒)。

- cpuacct.stat

包含该 Cgroup 及其子 Cgroup 下进程使用的 CPU 时间,以及用户态和内核态的时间。

Memory 子系统

memory.usage_in_bytes

cgroup 下进程使用的内存,包含 cgroup 及其子 cgroup 下的进程使用的内存

memory.max_usage_in_bytes

cgroup 下进程使用内存的最大值,包含子 cgroup 的内存使用量。

memory.limit_in_bytes

设置 Cgroup 下进程最多能使用的内存。如果设置为 -1,表示对该 cgroup 的内存使用不做限制。

memory.soft_limit_in_bytes

这个限制并不会阻止进程使用超过限额的内存,只是在系统内存足够时,会优先回收超过限额的内存,使之向限定值靠拢。

memory.oom_control

设置是否在 Cgroup 中使用 OOM(Out of Memory)Killer,默认为使用。当属于该 cgroup 的进程使用的内存超过最大的限定值时,会立刻被 OOM Killer 处理。

Cgroup driver

systemd:

- 当操作系统使用 systemd 作为 init system 时,初始化进程生成一个根 cgroup 目录结构并作为 cgroup 管理器。

- systemd 与 cgroup 紧密结合,并且为每个 systemd unit 分配 cgroup。

cgroupfs:

- docker 默认用 cgroupfs 作为 cgroup 驱动。

存在问题:

- 在 systemd 作为 init system 的系统中,默认并存着两套 groupdriver。

- 这会使得系统中 Docker 和 kubelet 管理的进程被 cgroupfs 驱动管,而 systemd 拉起的服务由 systemd 驱动管,让 cgroup 管理混乱且容易在资源紧张时引发问题。

因此 kubelet 会默认 —cgroup-driver=systemd,若运行时 cgroup 不一致时,kubelet 会报错。

Cgroup 的使用

可以使用 cgroup-tools 来管理 Cgroup

# 创建一个名为 k 的 CPU 子系统

$ cgcreate -g cpu:k

# 创建后的路径为

$ ls /sys/fs/cgroup/cpu/k

cgroup.clone_children cgroup.procs cpu.cfs_burst_us cpu.cfs_period_us cpu.cfs_quota_us cpu.idle cpu.rt_period_us cpu.rt_runtime_us cpu.shares cpu.stat notify_on_release tasks

# 获取 CPU 配额

$ cgget -r cpu.cfs_period_us -r cpu.cfs_quota_us k

k:

cpu.cfs_period_us: 100000

cpu.cfs_quota_us: -1

# 限制 CPU 使用率为 50%

$ cgset -r cpu.cfs_quota_us=50000 k

# 确认设置生效

$ cgget -r cpu.cfs_period_us -r cpu.cfs_quota_us k

k:

cpu.cfs_period_us: 100000

cpu.cfs_quota_us: 50000

# 测试

$ top -p $(ps -ef | grep 'bash -c while : ; do : ; done' | grep -v grep | awk '{print $2}') -b -n 1

top - 22:48:54 up 1:25, 2 users, load average: 1.54, 1.41, 1.21

Tasks: 1 total, 1 running, 0 sleeping, 0 stopped, 0 zombie

%Cpu(s): 8.4 us, 0.8 sy, 0.0 ni, 86.8 id, 0.0 wa, 0.0 hi, 4.0 si, 0.0 st

MiB Mem : 7898.4 total, 141.7 free, 2822.3 used, 4934.4 buff/cache

MiB Swap: 2048.0 total, 2042.7 free, 5.3 used. 4779.8 avail Mem

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

33693 root 20 0 4784 3224 2976 R 53.3 0.0 4:32.59 bash

# 删除 CPU 子系统 k

$ cgdelete cpu:k文件系统

Union FS

- 将不同目录挂载到同一个虚拟文件系统下(unite several directories into a single virtual filesystem)的文件系统

- 支持为每一个成员目录(类似 Git Branch)设定 readonly、readwrite 和 whiteout-able 权限

- 文件系统分层, 对 readonly 权限的 branch 可以逻辑上进行修改(增量地, 不影响 readonly 部分的)。

- 通常 Union FS 有两个用途, 一方面可以将多个 disk 挂到同一个目录下, 另一个更常用的就是将一个 readonly 的 branch 和一个 writeable 的 branch 联合在一起。

Docker 的文件系统

典型的 Linux 文件系统组成:

- Bootfs(boot file system)

- Bootloader - 引导加载 kernel,

- Kernel - 当 kernel 被加载到内存中后 umount bootfs。

- rootfs (root file system)

- /dev,/proc,/bin,/etc 等标准目录和文件。

- 对于不同的 linux 发行版, bootfs 基本是一致的,但 rootfs 会有差别。

Docker 启动

Linux

- 在启动后,首先将 rootfs 设置为 readonly, 进行一系列检查, 然后将其切换为 “readwrite” 供用户使用。

Docker 启动

- 初始化时也是将 rootfs 以 readonly 方式加载并检查,然而接下来利用 union mount 的方式将一个 readwrite 文件系统挂载在 readonly 的 rootfs 之上;

- 并且允许再次将下层的 FS(file system) 设定为 readonly 并且向上叠加。

- 这样一组 readonly 和一个 writeable 的结构构成一个 container 的运行时态, 每一个 FS 被称作一个 FS 层。

Docker 写操作

由于镜像具有共享特性,所以对容器可写层的操作需要依赖存储驱动提供的写时复制和用时分配机制,以此来支持对容器可写层的修改,进而提高对存储和内存资源的利用率。

- 写时复制

- 写时复制,即 Copy-on-Write。

- 一个镜像可以被多个容器使用,但是不需要在内存和磁盘上做多个拷贝。

- 在需要对镜像提供的文件进行修改时,该文件会从镜像的文件系统被复制到容器的可写层的文件系统进行修改,而镜像里面的文件不会改变。

- 不同容器对文件的修改都相互独立、互不影响。

- 用时分配

- 按需分配空间,而非提前分配,即当一个文件被创建出来后,才会分配空间。

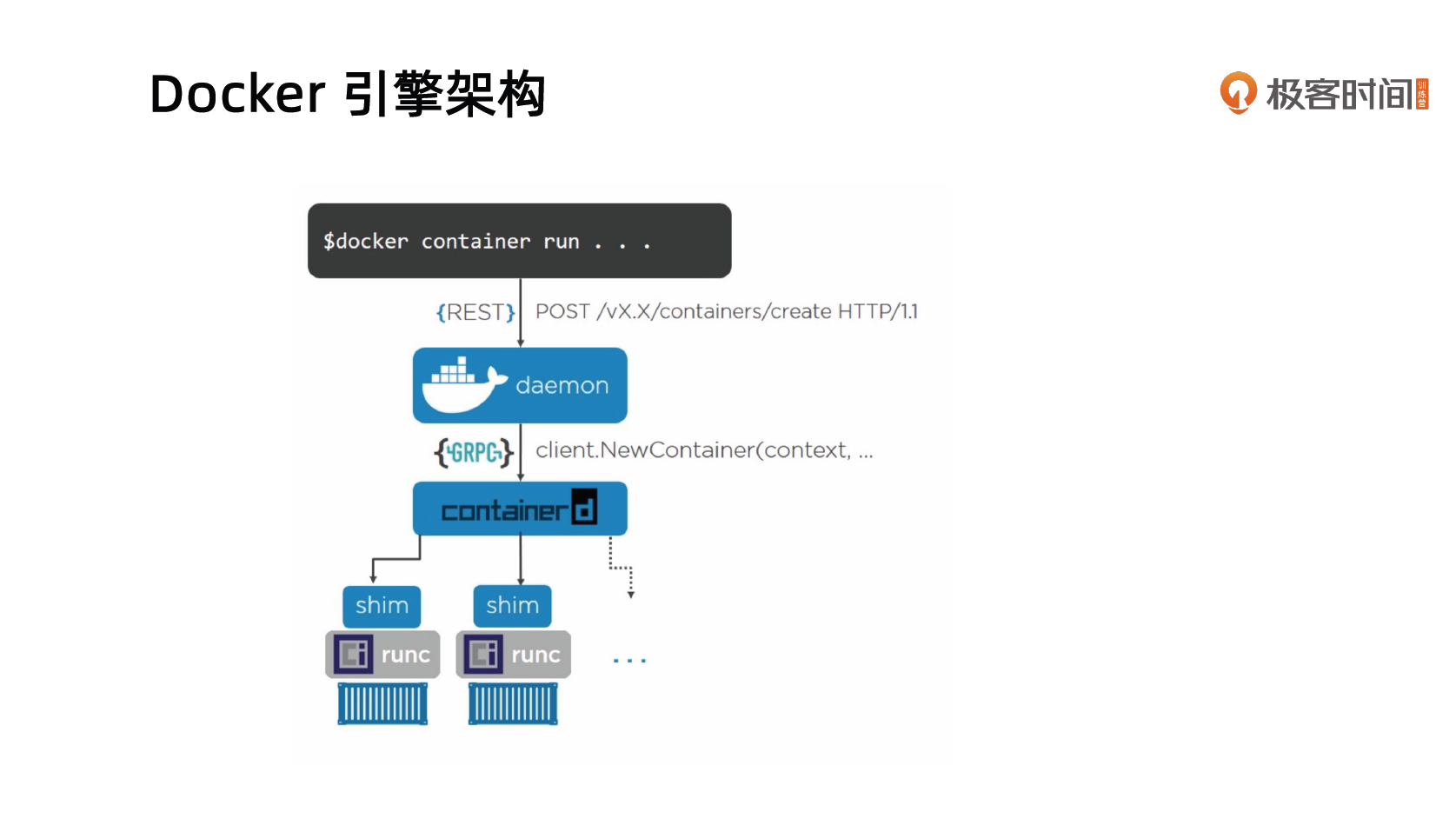

Docker 引擎架构

需要注意的是,在这个架构中,运行的 Docker 容器的父进程不是 Docker daemon ,这样就能避免重启 daemon 导致容器也必须重启。

$ docker inspect c07 | grep -i pid

"Pid": 5621,

"PidMode": "",

"PidsLimit": null,

$ ps -ef | grep 5621

root 5621 5600 0 11:45 pts/0 00:00:00 zsh

$ ps -ef | grep 5600

root 5600 1 0 11:45 ? 00:00:00 /snap/docker/2915/bin/containerd-shim-runc-v2 -namespace moby -id c07f841e7a66cb54f78f72445cb5baf7d479a3c27e8ea03966da1841e3605151 -address /run/snap.docker/containerd/containerd.sock

$ pstree -H 5600 -p -s -T

systemd(1)───containerd-shim(5600)───zsh(5621)Docker 网络

- Null(—net=None)

- 把容器放入独立的网络空间但不做任何网络配置;

- 用户需要通过运行 docker network 命令来完成网络配置。

- Host

- 使用主机网络名空间,复用主机网络。

- Container

- 重用其他容器的网络。

- Bridge(—net=bridge)

- 使用 Linux 网桥和 iptables 提供容器互联,Docker 在每台主机上创建一个名叫 docker0 的网桥,通过 veth pair 来连接该主机的每一个 EndPoint。

- Overlay(libnetwork, libkv)

- 通过网络封包实现。

- Remote(work with remote drivers)

- Underlay:使用现有底层网络,为每一个容器配置可路由的网络 IP。

- Overlay:通过网络封包实现。

Null 模式

- Null 模式是一个空实现;

- 可以通过 Null 模式启动容器并在宿主机上通过命令为容器配置网络。

https://github.com/kibaamor/101/blob/master/module3/setup-network.md

# 以后台的方式运行一个名为 nginx 的 nginx 容器,但不配置网络

$ docker run --network=none --name nginx -d nginx

# 获取刚刚运行的 nginx 容器中 nginx 进程在主机上的 Pid

$ docker inspect -f '{{.State.Pid}}' nginx

63648

# 查看 nginx 容器的网络配置

$ nsenter -t 63648 -n ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

# 将 nginx 容器进程所使用的 network namespace 连接到 /var/run/netns,这样才能使用 ip netns 命令查看和修改

# 创建目录

$ mkdir -p /var/run/netns

# 链接

$ ln -s /proc/63648/ns/net /var/run/netns/63648

# 确认链接成功

$ ip netns list

63648

# 查看主机上网桥的配置

$ brctl show

bridge name bridge id STP enabled interfaces

docker0 8000.0242b3da2420 no

# 显示主机上 docker0 网口的 ip 信息

$ ip address show dev docker0

3: docker0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN group default

link/ether 02:42:b3:da:24:20 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0

valid_lft forever preferred_lft forever

inet6 fe80::42:b3ff:feda:2420/64 scope link

valid_lft forever preferred_lft forever

# 创建 veth pair

$ ip link add A type veth peer name B

# 配置 A

# 把 A 添加到网桥 docker0

$ brctl addif docker0 A

# 启动 A

$ ip link set A up

# 配置 B

# 将 B 的 network namespace 移动到进程 63648 中

$ ip link set B netns 63648

# 将 B 改名为 eth0

$ ip netns exec 63648 ip link set dev B name eth0

# 启动 eth0

$ ip netns exec 63648 ip link set eth0 up

# 设置 eth0 的 IP 和子网掩码(根据 docker0 信息来)

$ ip netns exec 63648 ip addr add 172.17.0.100/16 dev eth0

# 设置 eth0 的默认网关(即为 docker0 的 IP 地址)

$ ip netns exec 63648 ip route add default via 172.17.0.1

# 测试能访问 nginx(如果失败,检查一下 HTTP_PROXY 等配置)

$ curl 172.17.0.100

<!DOCTYPE html>

<html>

<head>

<title>Welcome to nginx!</title>

<style>

html { color-scheme: light dark; }

body { width: 35em; margin: 0 auto;

font-family: Tahoma, Verdana, Arial, sans-serif; }

</style>

</head>

<body>

<h1>Welcome to nginx!</h1>

<p>If you see this page, the nginx web server is successfully installed and

working. Further configuration is required.</p>

<p>For online documentation and support please refer to

<a href="http://nginx.org/">nginx.org</a>.<br/>

Commercial support is available at

<a href="http://nginx.com/">nginx.com</a>.</p>

<p><em>Thank you for using nginx.</em></p>

</body>

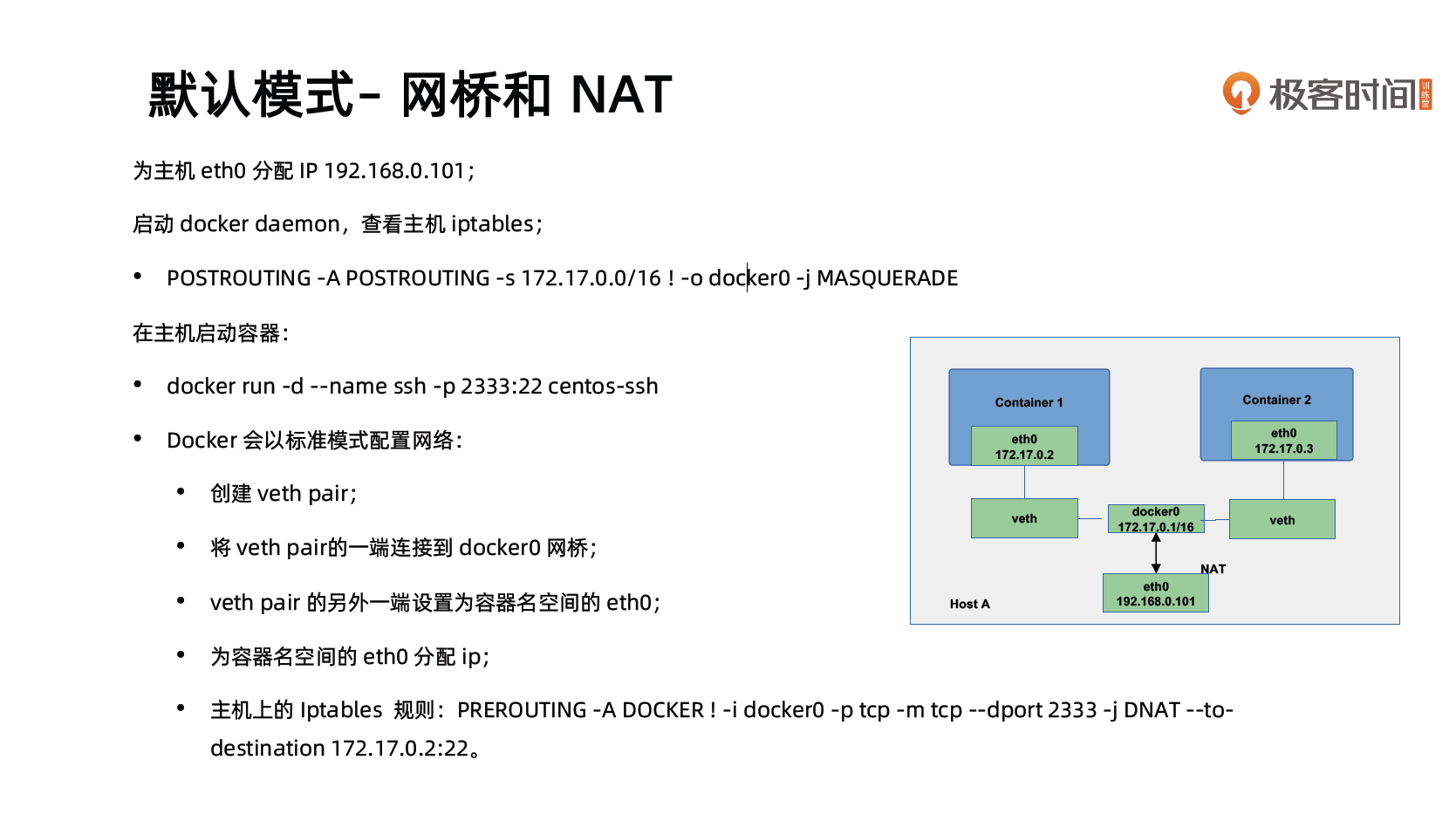

</html>默认模式 - 网桥和 NAT

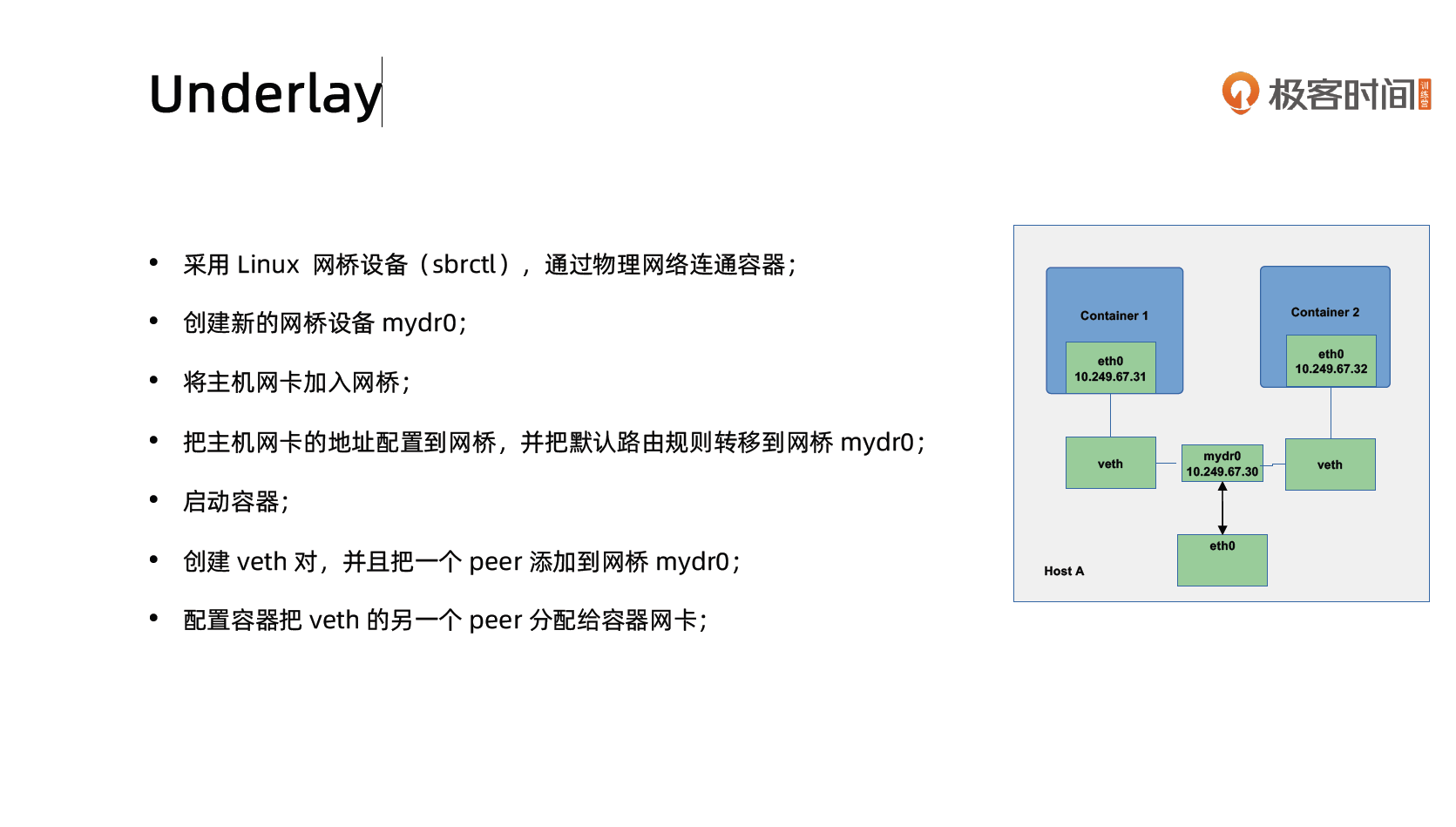

Underlay

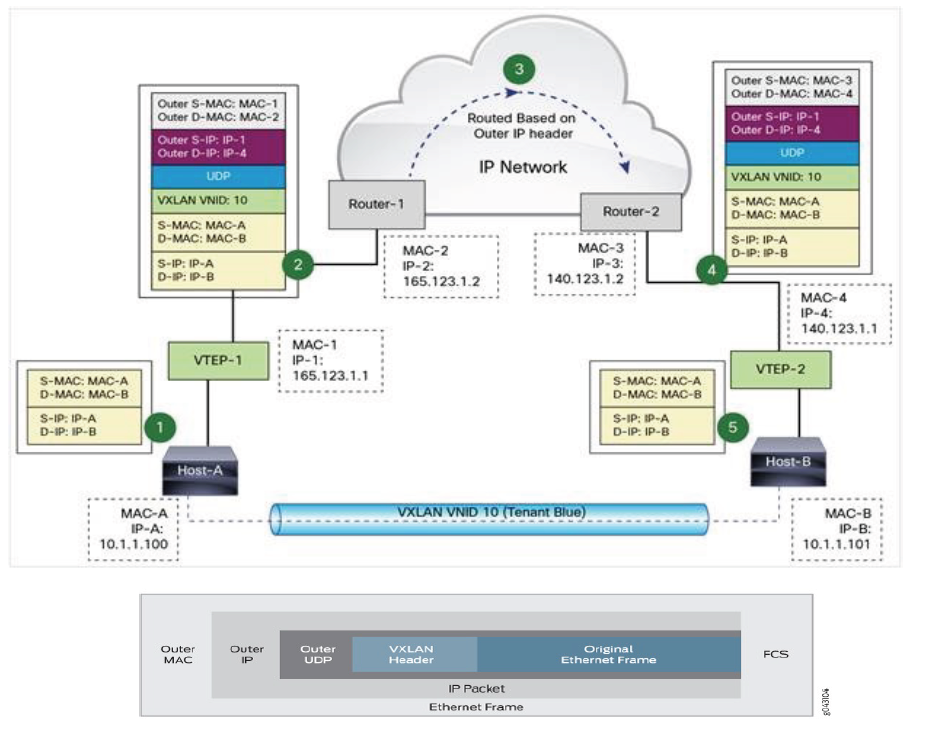

Overlay

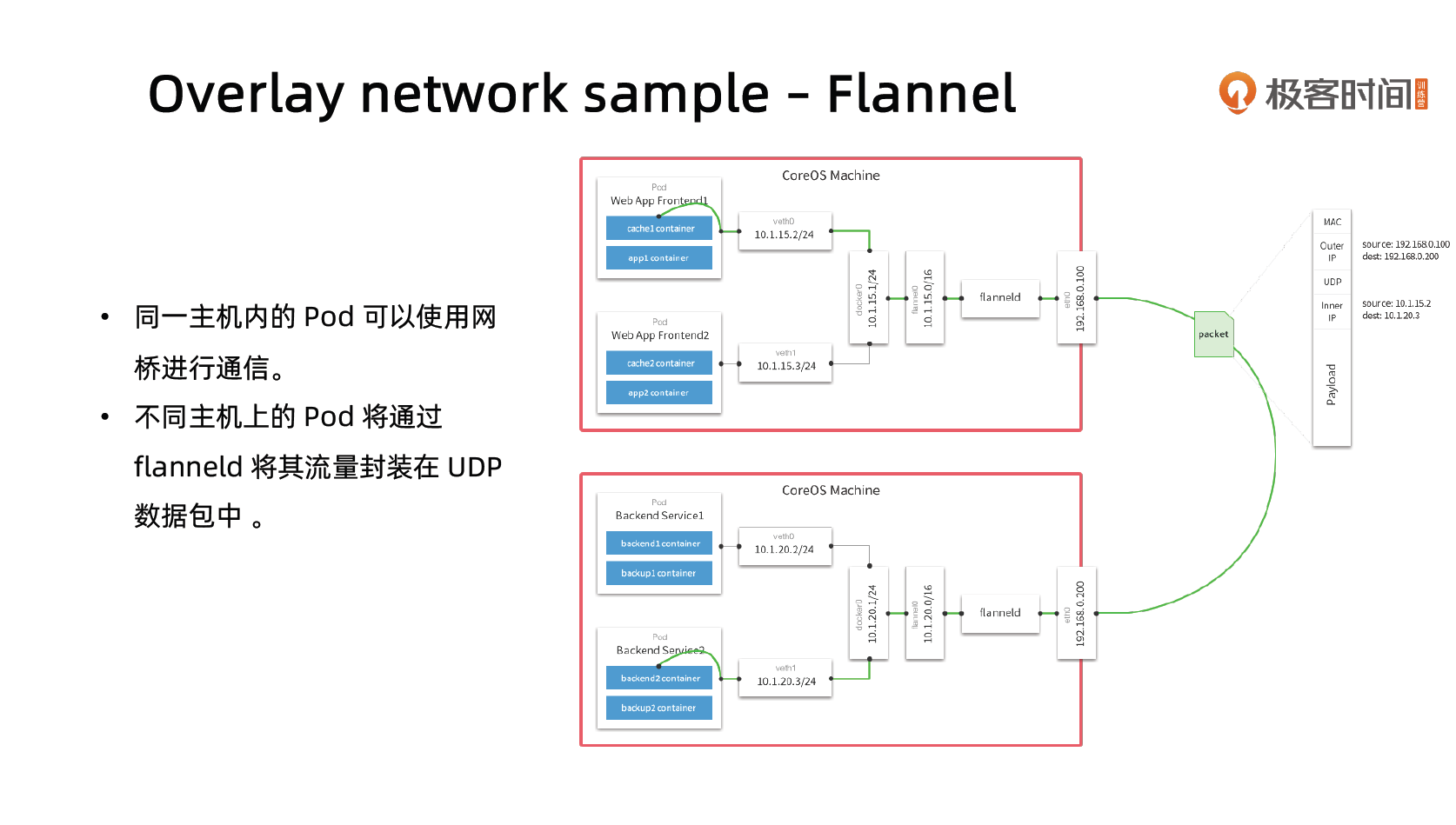

- Docker overlay 网络驱动原生支持多主机网络;

- Libnetwork 是一个内置的基于 VXLAN 的网络驱动。

Dockerfile 的最佳实践

回顾12 Factor 之进程

- 运行环境中,应用程序通常是以一个和多个进程运行的。

- 12-Factor 应用的进程必须无状态(Stateless)且无共享(Share nothing)。

- 任何需要持久化的数据都要存储在后端服务内,比如数据库。

- 应在构建阶段将源代码编译成待执行应用。

- Session Sticky 是 12-Factor 极力反对的。

- Session 中的数据应该保存在诸如 Memcached 或 Redis 这样的带有过期时间的缓存中。

Docker 遵循以上原则管理和构建应用。

理解构建上下文(Build Context)

- 当运行docker build 命令时,当前工作目录被称为构建上下文。

- docker build 默认查找当前目录的Dockerfile 作为构建输入,也可以通过 -f 指定Dockerfile。

docker build -f ./Dockerfile

- 当docker build 运行时,首先会把构建上下文传输给 docker daemon,把没用的文件包含在构建上下文时,会导致传输时间长,构建需要的资源多,构建出的镜像大等问题。

- 试着到一个包含文件很多的目录运行下面的命令,会感受到差异;

docker build -f $GOPATH/src/github.com/cncamp/golang/httpserver/Dockerfile;docker build $GOPATH/src/github.com/cncamp/golang/httpserver/;- 可以通过

.dockerignore文件从编译上下文排除某些文件。

- 因此需要确保构建上下文清晰,比如创建一个专门的目录放置 Dockerfile,并在目录中运行

docker build。

Build Cache

构建容器镜像时,Docker 依次读取 Dockerfile 中的指令,并按顺序依次执行构建指令。

Docker 读取指令后,会先判断缓存中是否有可用的已存镜像,只有已存镜像不存在时才会重新构建。

- 通常 Docker 简单判断 Dockerfile 中的指令与镜像。

- 针对 ADD 和 COPY 指令,Docker 判断该镜像层每一个文件的内容并生成一个 checksum,与现存镜像比较时,Docker 比较的是二者的 checksum。

- 其他指令,比如

RUN apt-get -y update,Docker 简单比较与现存镜像中的指令字串是否一致。 - 当某一层 cache 失效以后,所有所有层级的 cache 均一并失效,后续指令都重新构建镜像。

Dockerfile 常用指令

FROM:选择基础镜像,推荐alpine

FROM [--platform=<platform>] <image>[@<digest>] [AS <name>]LABELS:按标签组织项目

LABEL multi.label1=”value1” multi.label2=”value2” other=”value3”

配合label filter 可过滤镜像查询结果

docker images -f label=multi.label1="value1"RUN:执行命令

最常见的用法是 RUN apt-get update && apt-get install,这两条命令应该永远用 && 连接,如果分开执行,RUN apt-get update 构建层被缓存,可能会导致新 package 无法安装

CMD:容器镜像中包含应用的运行命令,需要带参数

CMD [“executable”, “param1”, “param2”…]

EXPOSE:发布端口

EXPOSE <port> [<port>/<protocol>...]是镜像创建者和使用者的约定

在 docker run -P 时,docker 会自动映射 expose 的端口到主机大端口,如 0.0.0.0:32768->80/tcp

ENV 设置环境变量

ENV <key>=<value>…ADD:从源地址(文件,目录或者URL)复制文件到目标路径

ADD [--chown=<user>:<group>] <src>... <dest>ADD [--chown=<user>:<group>] ["<src>",... "<dest>"](路径中有空格时使用)ADD 支持 Go 风格的通配符,如 ADD check* /testdir/

src 如果是文件,则必须包含在编译上下文中,ADD 指令无法添加编译上下文之外的文件

src 如果是URL

- 如果 dest 结尾没有 /,那么 dest 是目标文件名,如果 dest 结尾有 /,那么 dest 是目标目录名

如果 src 是一个目录,则所有文件都会被复制至 dest

如果 src 是一个本地压缩文件,则在 ADD 的同时完整解压操作

如果 dest 不存在,则 ADD 指令会创建目标目录

应尽量减少通过 ADD URL 添加 remote 文件,建议使用 curl 或者 wget && untar (维护起来理解成本高)

COPY:从源地址(文件,目录或者URL)复制文件到目标路径

COPY [--chown=<user>:<group>] <src>... <dest>COPY [--chown=<user>:<group>] ["<src>",... "<dest>"]// 路径中有空格时使用COPY 的使用与 ADD 类似,但有如下区别

COPY 只支持本地文件的复制,不支持URL

COPY 不解压文件

COPY 可以用于多阶段编译场景,可以用前一个临时镜像中拷贝文件

COPY —from=build /bin/project /bin/project

COPY 语义上更直白,复制本地文件时,优先使用 COPY

ENTRYPOINT:定义可以执行的容器镜像入口命令

ENTRYPOINT [“executable”, “param1”, “param2”] // docker run参数追加模式

ENTRYPOINT command param1 param2 // docker run 参数替换模式

docker run -entrypoint 可替换 Dockerfile 中定义的 ENTRYPOINT

ENTRYPOINT 的最佳实践是用 ENTRYPOINT 定义镜像主命令,并通过 CMD 定义主要参数,如下所示

ENTRYPOINT [“s3cmd”]

CMD [“—help”]

VOLUME: 将指定目录定义为外挂存储卷,Dockerfile 中在该指令之后所有对同一目录的修改都无效

VOLUME [“/data”]

等价于docker run -v /data,可通过docker inspect 查看主机的mount point,

/var/lib/docker/volumes/<containerid>/_dataUSER:切换运行镜像的用户和用户组,因安全性要求,越来越多的场景要求容器应用要以 non-root 身份运行

USER <user>[:<group>]WORKDIR:等价于cd,切换工作目录

WORKDIR /path/to/workdir

其他非常用指令

- ARG

- ONBUILD

- STOPSIGNAL

- HEALTHCHECK

- SHELL

Dockerfile 最佳实践

目标:易管理、少漏洞、镜像小、层级少、利用缓存。

- 不要安装无效软件包。

- 应简化镜像中同时运行的进程数,理想状况下,每个镜像应该只有一个进程。

- 当无法避免同一镜像运行多进程时,应选择合理的初始化进程(init process)。

- 最小化层级数

- 最新的 docker 只有 RUN,COPY,ADD 创建新层,其他指令创建临时层,不会增加镜像大小。

- 比如 EXPOSE 指令就不会生成新层。

- 多条RUN 命令可通过连接符连接成一条指令集以减少层数。

- 通过多段构建减少镜像层数。

- 最新的 docker 只有 RUN,COPY,ADD 创建新层,其他指令创建临时层,不会增加镜像大小。

- 把多行参数按字母排序,可以减少可能出现的重复参数,并且提高可读性。

- 编写 dockerfile 的时候,应该把变更频率低的编译指令优先构建以便放在镜像底层以有效利用 build cache。

- 复制文件时,每个文件应独立复制,这确保某个文件变更时,只影响改文件对应的缓存。

多进程的容器镜像

- 选择适当的 init 进程

- 需要捕获 SIGTERM 信号并完成子进程的优雅终止

- 负责清理退出的子进程以避免僵尸进程

开源项目

https://github.com/krallin/tini

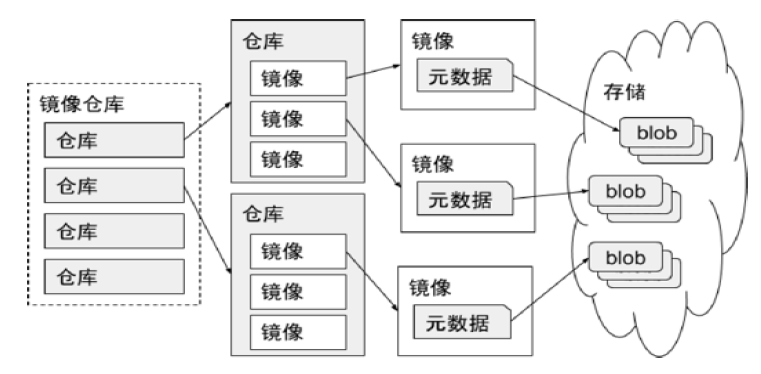

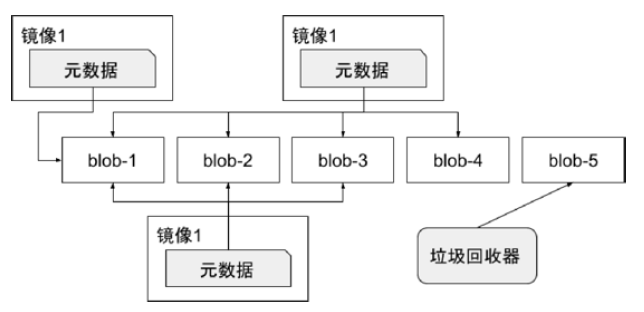

镜像仓库

创建私有镜像仓库

https://distribution.github.io/distribution/

docker run -d -p 5000:5000 registry

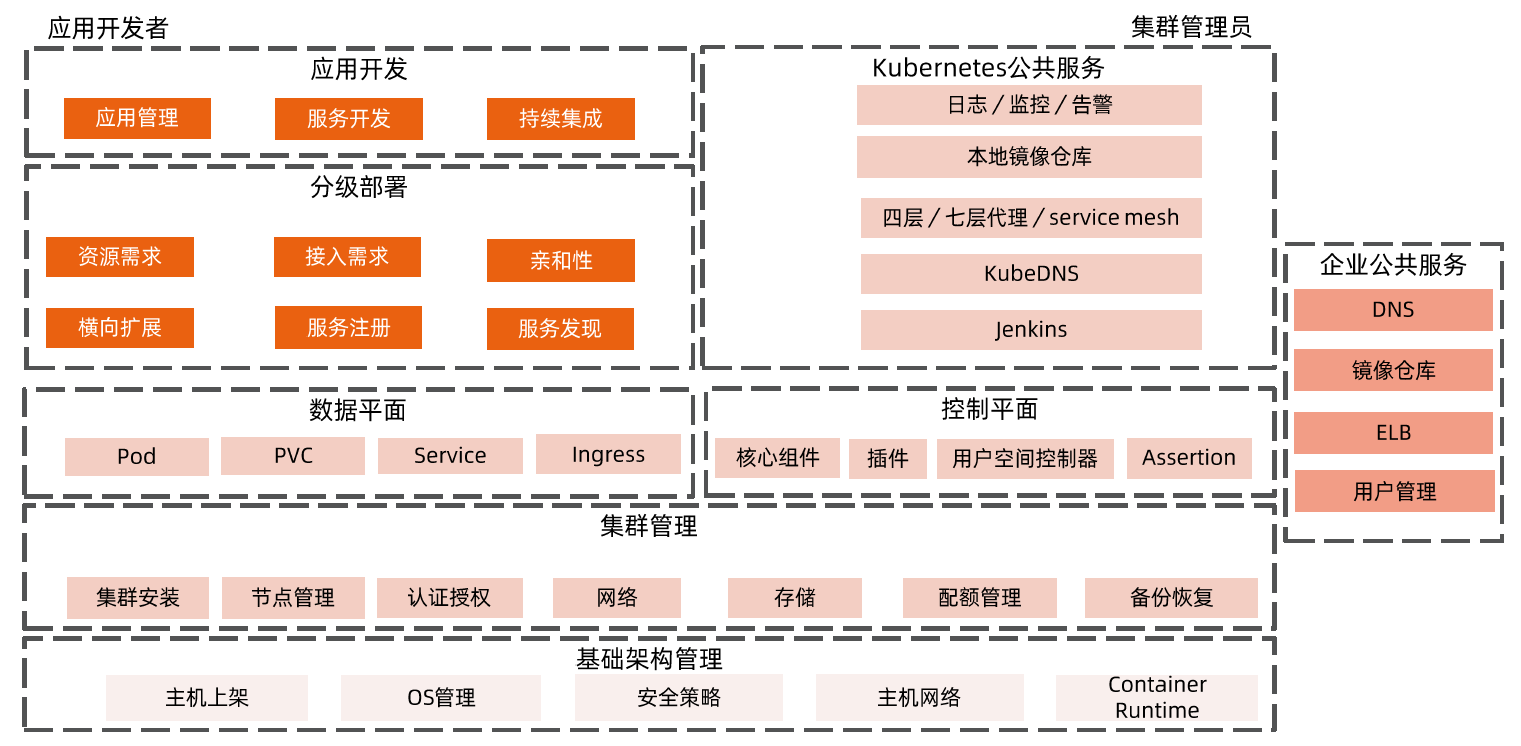

Kubernetes 架构原则和对象设计

云计算

什么是云计算

云计算是对所有计算资源、网络资源和存储资源的一种抽象。

怎么理解呢?

比如,有 5000 台机器。

- 我们可以从网络上打通,把它们形成一个集群。

- 我们可以有一个用于控制的控制平面,把这些计算资源抽象出来。

我们就能知道这 5000 个节点,每个节点上有多少 CPU、内存等。对于整个集群来说,我们也知道哪些节点是健康的,哪些节点是不健康的。谁能参与计算,谁不能参与计算等。这样我们就拥有了一个大的计算池。

上面是从云平台侧考虑的,做了资源的抽象。

另一方面,从业务的角度来说,业务也不用管作业实际部署在哪儿,只用告诉云平台某个业务需要多少实例,每个实例需要多少 CPU 和内存等资源信息即可。云平台会自动找合适节点来运行业务。

这就是云计算,对计算资源做一个抽象,让业务面向抽象的计算资源来部署应用。

云计算平台的分类

以 Openstack 为典型的虚拟化平台

- 虚拟机构建和业务代码部署分离。

- 可变的基础架构使后续维护风险变大。

以谷歌 borg 为典型的基于进程的作业调度平台

- 技术的迭代引发 borg 的换代需求。

- 早期的隔离依靠 chroot jail 实现,一些不合理的设计需要在新产品中改进。

- 对象之间的强依赖 job 和 task 是强包含关系,不利于重组。

- 所有容器共享 IP,会导致端口冲突,隔离困难等问题。

- 为超级用户添加复杂逻辑导致系统过于复杂。

Kubernetes 架构基础

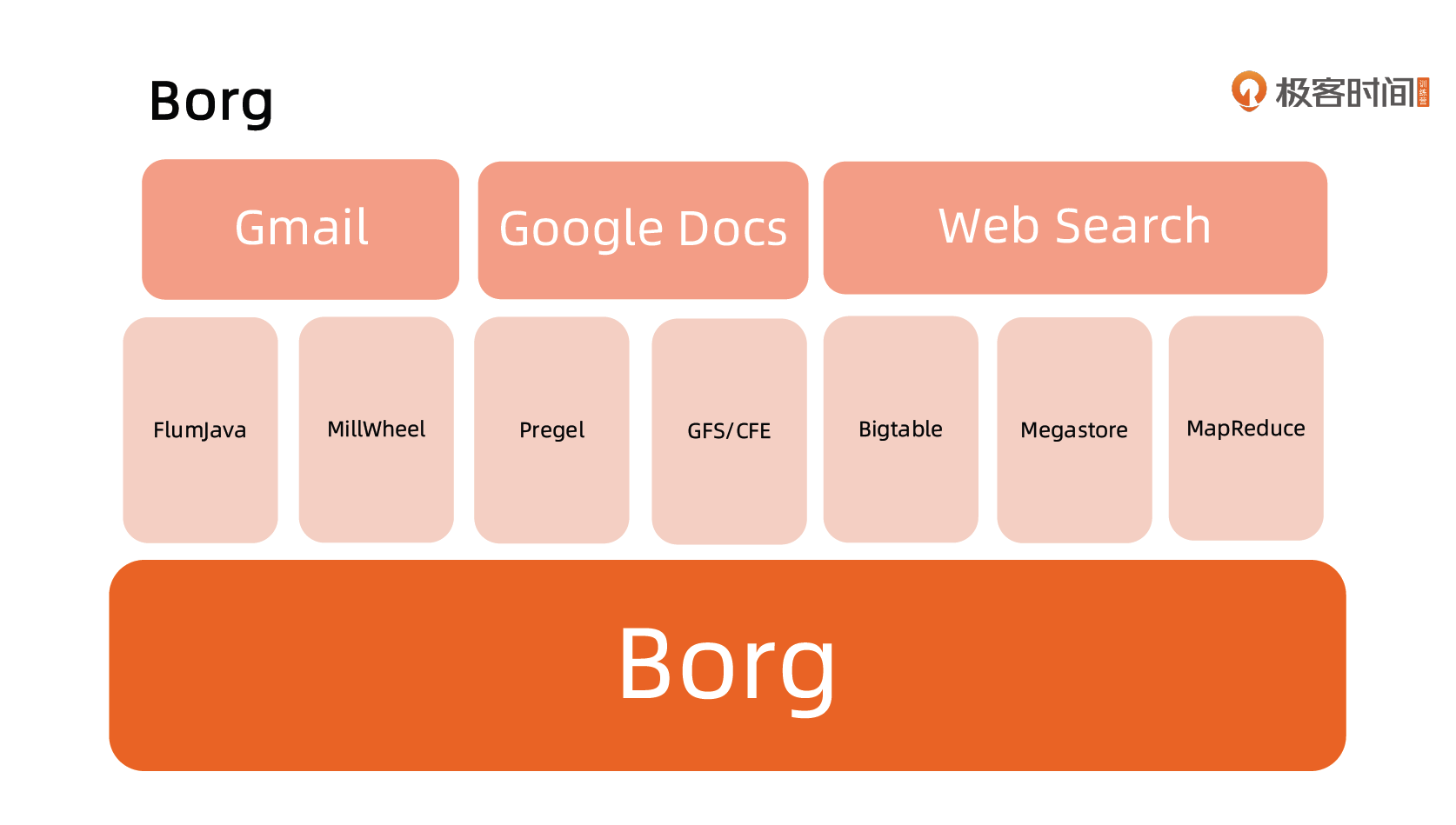

Google Borg

建议对原论文

特性

- 物理资源利用率高。

- 服务器共享,在进程级别做隔离。

- 应用高可用,故障恢复时间短。

- 调度策略灵活。

- 应用接入和使用方便,提供了完备的 Job 描述语言,服务发现,实时状态监控和诊断工具。

优势

- 对外隐藏底层资源管理和调度、故障处理等。

- 实现应用的高可靠和高可用。

- 足够弹性,支持应用跑在成千上万的机器上。

基本概念

Workload

- prod:在线任务,长期运行、对延时敏感、面向终端用户等,比如 Gmail, Google Docs,Web Search 服务等。

- non-prod : 离线任务,也称为批处理任务(Batch),比如一些分布式计算服务等。

Cell

相当于一个集群

- 一个 Cell 上跑一个集群管理系统 Borg。

- 通过定义 Cell 可以让 Borg 对服务器资源进行统一抽象,作为用户就无需知道自己的应用跑在哪台机器上,也不用关心资源分配、程序安装、依赖管理、健康检查及故障恢复等。

Job 和 Task

相当于 k8s 中的 pod 和 container

- 用户以 Job 的形式提交应用部署请求。一个 Job 包含一个或多个相同的 Task,每个 Task 运行相同的应用程序,Task 数量就是应用的副本数。

- 每个 Job 可以定义属性、元信息和优先级,优先级涉及到抢占式调度过程。

Naming

- Borg 的服务发现通过 BNS ( Borg NameService)来实现。

- 50.jfoo.ubar.cc.borg.google.com 可表示在一个名为 cc 的 Cell 中由用户 uBar 部署的一个名为 jFoo 的 Job下的第 50 个 Task。

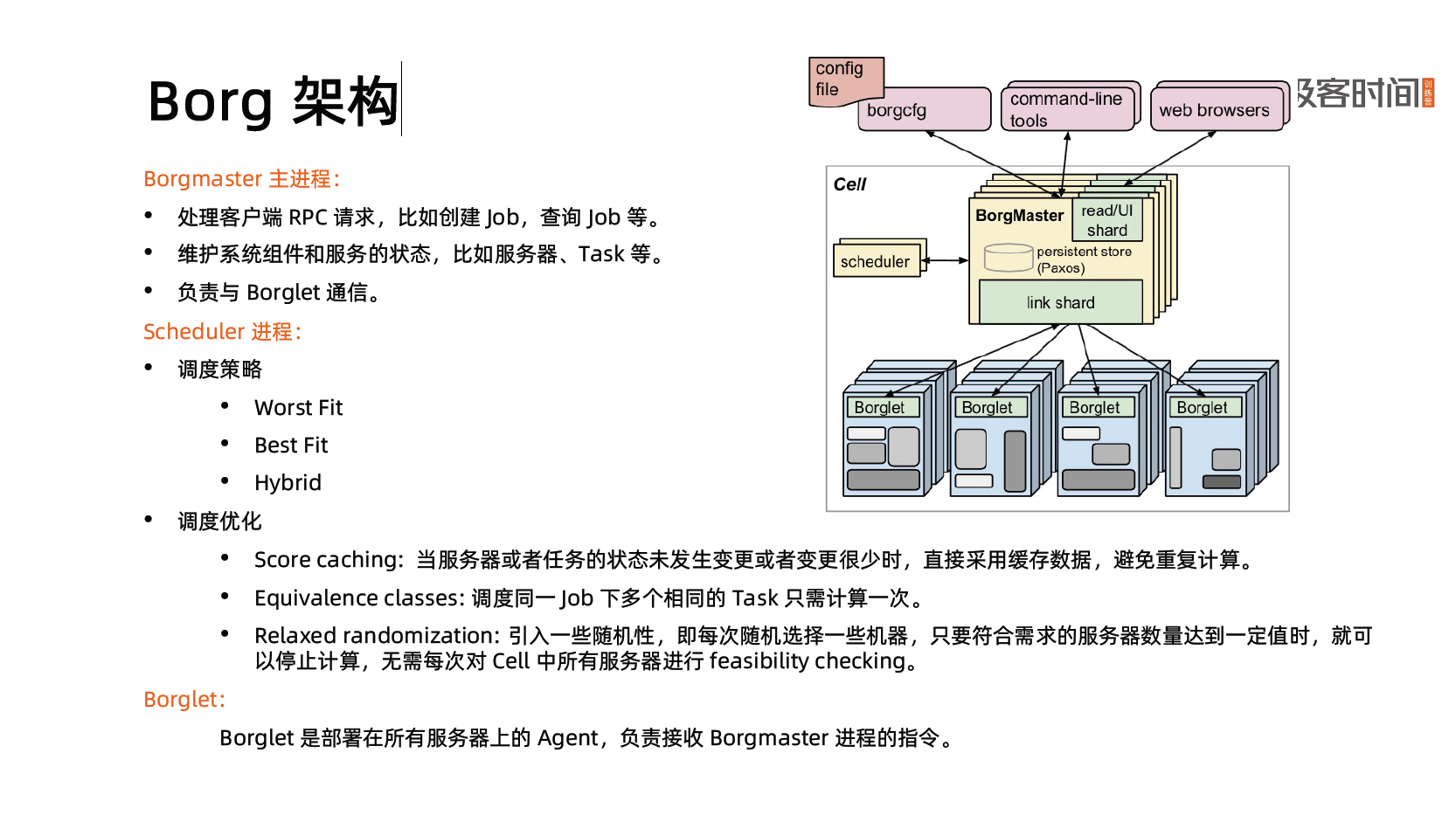

Borg 架构

应用高可用

- 被抢占的 non-prod 任务放回 pending queue,等待重新调度。

- 多副本应用跨故障域部署。所谓故障域有大有小,比如相同机器、相同机架或相同电源插座等,一挂全挂。

- 对于类似服务器或操作系统升级的维护操作,避免大量服务器同时进行。

- 支持幂等性,支持客户端重复操作。

- 当服务器状态变为不可用时,要控制重新调度任务的速率。因为 Borg 无法区分是节点故障还是出现了短暂的网络分区,如果是后者,静静地等待网络恢复更利于保障服务可用性。

- 当某种”任务 @ 服务器”的组合出现故障时,下次重新调度时需避免这种组合再次出现,因为极大可能会再次出现相同故障。

- 记录详细的内部信息,便于故障排查和分析。

- 保障应用高可用的关键性设计原则:无论何种原因,即使 Borgmaster 或者 Borglet 挂掉、失联,都不能杀掉正在运行的服务(Task)。

Borg 系统自身高可用

- Borgmaster 组件多副本设计。

- 采用一些简单的和底层(low-level)的工具来部署 Borg 系统实例,避免引入过多的外部依赖。

- 每个 Cell 的 Borg 均独立部署,避免不同 Borg 系统相互影响。

资源利用率

- 通过将在线任务(prod)和离线任务(non-prod,Batch)混合部署,空闲时,离线任务可以充分利用计算资源;繁忙时,在线任务通过抢占的方式保证优先得到执行,合理地利用资源。

- 98% 的服务器实现了混部。

- 90% 的服务器中跑了超过25 个 Task 和 4500 个线程。

- 在一个中等规模的 Cell 里,在线任务和离线任务独立部署比混合部署所需的服务器数量多出约20%-30%。

可以简单算一笔账,Google 的服务器数量在千万级别,按 20% 算也是百万级别,大概能省下的服务器采购费用就是百亿级别了,这还不包括省下的机房等基础设施和电费等费用。

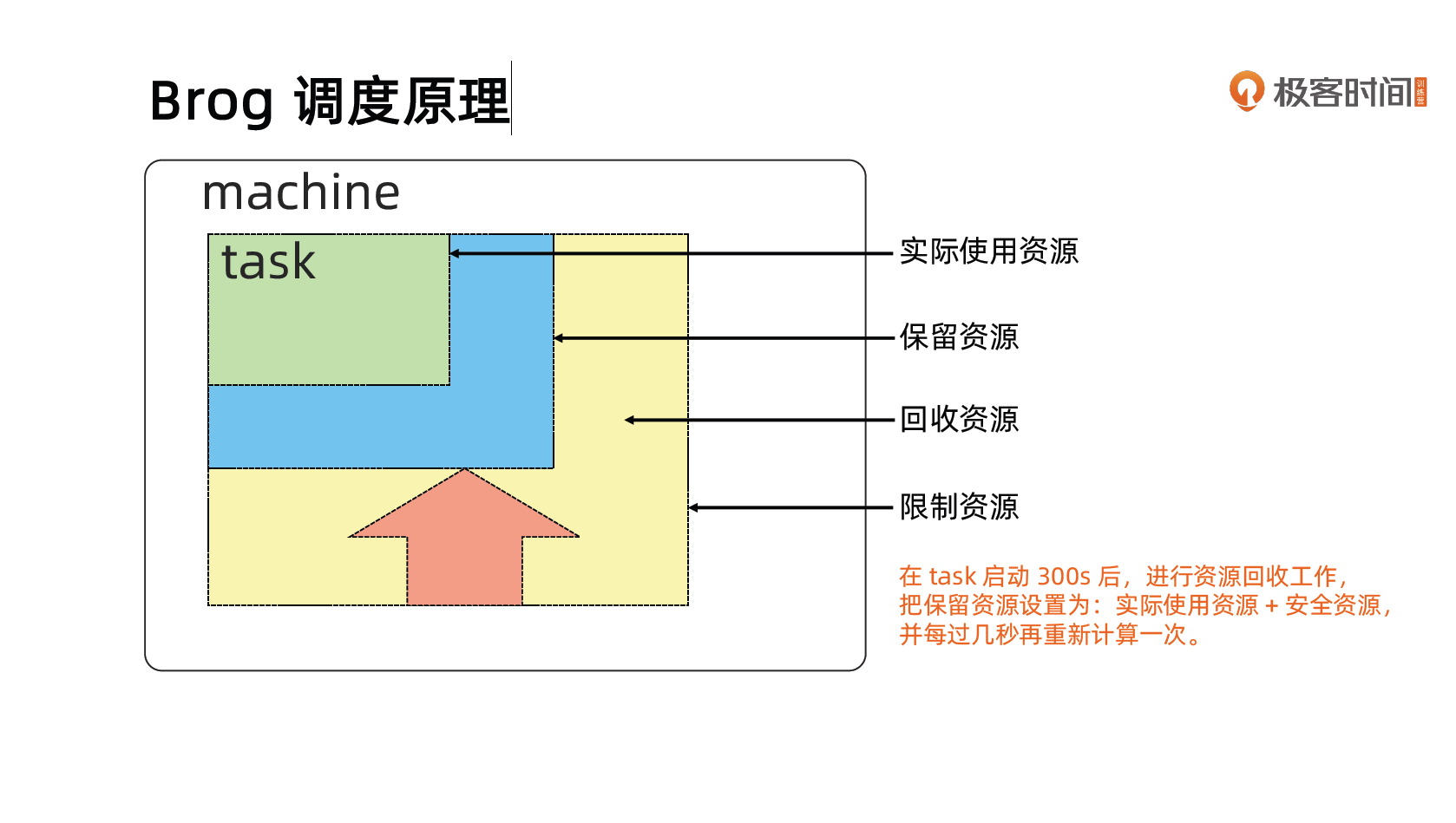

Brog 调度原理

隔离性

安全性隔离:

- 早期采用 Chroot jail,后期版本基于 Namespace。

性能隔离:

- 采用基于 Cgroup 的容器技术实现。

- 在线任务(prod)是延时敏感(latency-sensitive)型的,优先级高,而离线任务(non-prod,Batch)优先级低。

- Borg 通过不同优先级之间的抢占式调度来优先保障在线任务的性能,牺牲离线任务。

- Borg 将资源类型分成两类:

- 可压榨的(compressible),CPU 是可压榨资源,资源耗尽不会终止进程;

- 不可压榨的(non-compressible),内存是不可压榨资源,资源耗尽进程会被终止。

什么是Kubernetes(K8s)

Kubernetes 是谷歌开源的容器集群管理系统,是 Google 多年大规模容器管理技术 Borg 的开源版本,主要功能包括:

- 基于容器的应用部署、维护和滚动升级;

- 负载均衡和服务发现;

- 跨机器和跨地区的集群调度;

- 自动伸缩;

- 无状态服务和有状态服务;

- 插件机制保证扩展性。

命令式( Imperative)vs 声明式( Declarative)

声明式(Declaritive)系统规范

命令式:

- 我要你做什么,怎么做,请严格按照我说的做。

声明式:

- 我需要你帮我做点事,但是我只告诉你我需要你做什么,不是你应该怎么做。

- 直接声明:我直接告诉你我需要什么。

- 间接声明:我不直接告诉你我的需求,我会把我的需求放在特定的地方,请在方便的时候拿出来处理。

幂等性:

- 状态固定,每次我要你做事,请给我返回相同结果。

面向对象的:

- 把一切抽象成对象。

Kubernetes:声明式系统

Kubernetes 的所有管理能力构建在对象抽象的基础上,核心对象包括:

- Node:计算节点的抽象,用来描述计算节点的资源抽象、健康状态等。

- Namespace:资源隔离的基本单位,可以简单理解为文件系统中的目录结构。

- Pod:用来描述应用实例,包括镜像地址、资源需求等。Kubernetes 中最核心的对象,也是打通应用和基础架构的秘密武器。

- Service:服务如何将应用发布成服务,本质上是负载均衡和域名服务的声明。

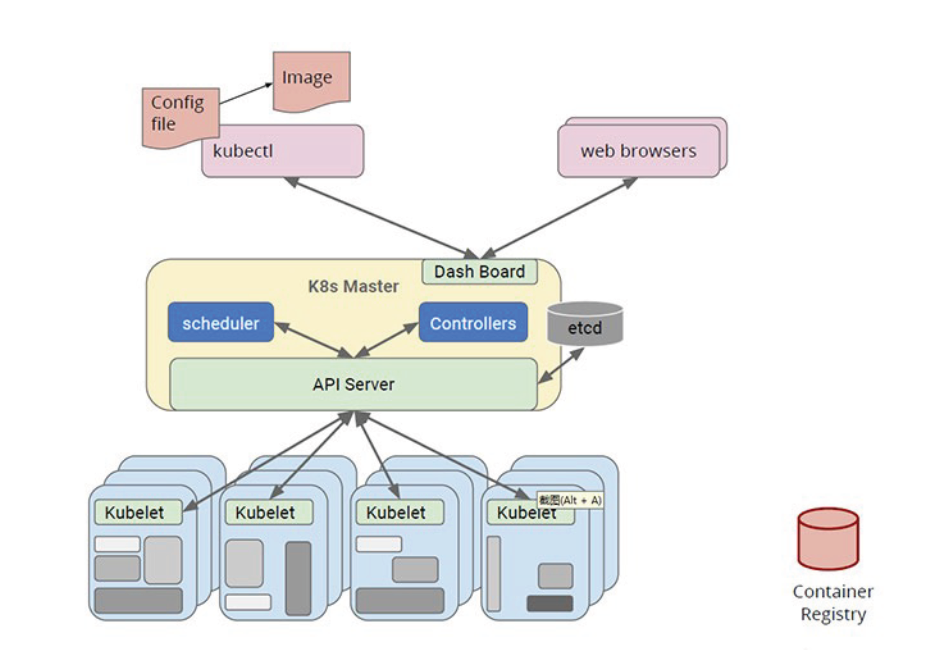

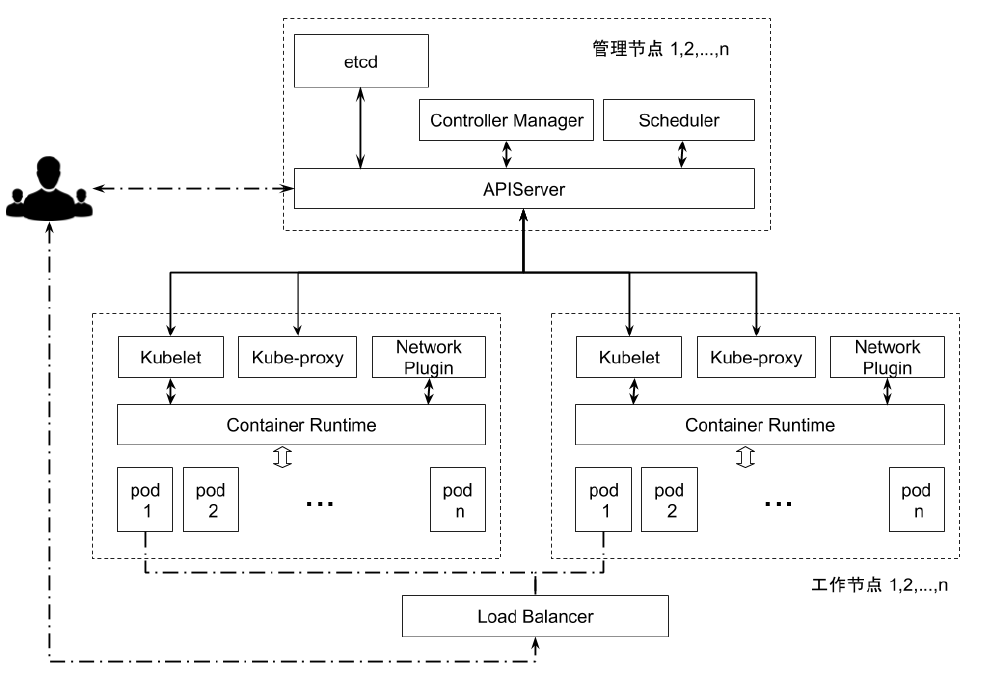

Kubernetes 架构

Kubernetes 采用与 Borg 类似的架构

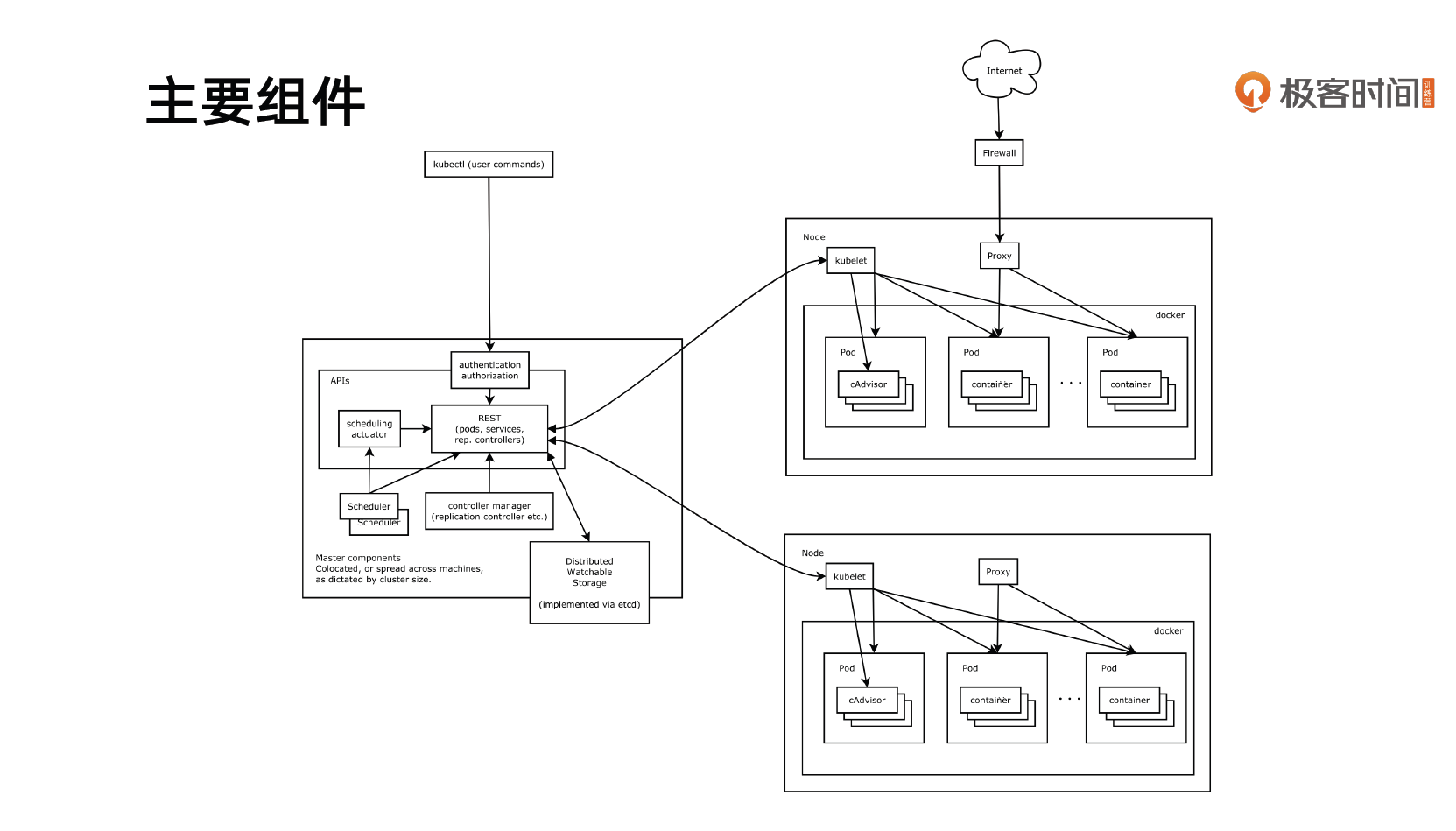

主要组件

Kubernetes 的主节点(Master Node)

API 服务器(API Server)

API Server 的主要作用是对请求做认证、鉴权以及准入(验证请求内容的合法性),无其他逻辑。

这是Kubernetes 控制面板中唯一带有用户可访问API 以及用户可交互的组件。API 服务器会暴露一个RESTful 的Kubernetes API 并使用JSON 格式的清单文件(manifest files)。

群的数据存储(Cluster Data Store)

Kubernetes 使用 “etcd” 。这是一个强大的、稳定的、高可用的键值存储, 被 Kubernetes 用于长久储存所有的API 对象。

控制管理器(Controller Manager)

被称为 “kube-controller manager”,它运行着所有处理集群日常任务的控制器。包括了节点控制器、副本控制器、端点(endpoint)控制器以及服务账户等。

调度器(Scheduler)

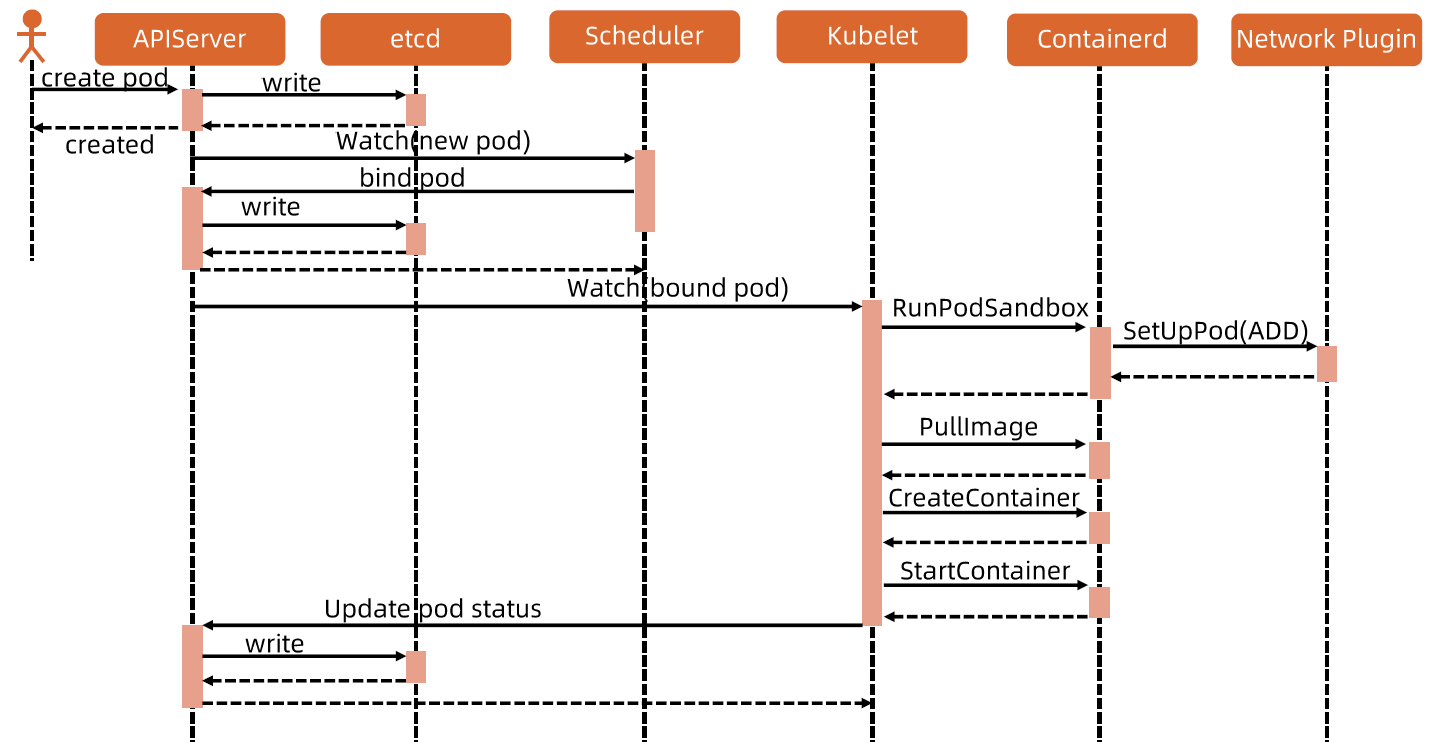

调度器会监控新建的 pods(一组或一个容器)并将其分配给节点。

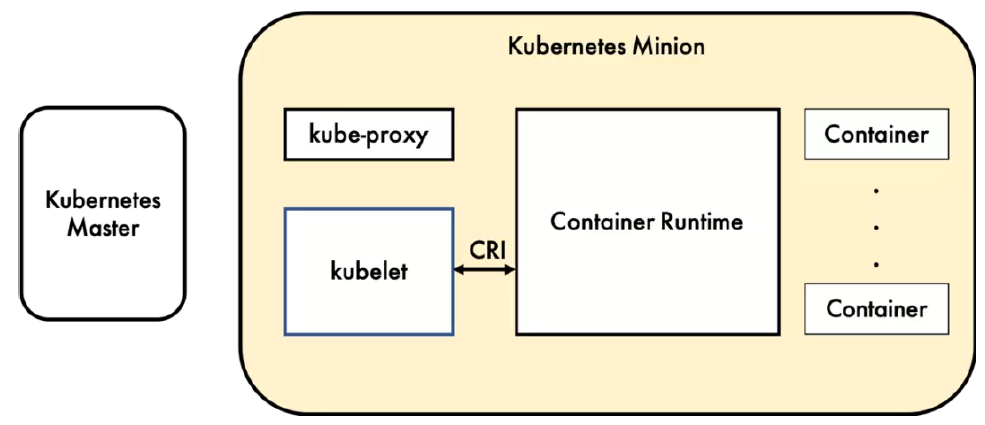

Kubernetes 的工作节点(Worker Node)

Kubelet

负责调度到对应节点的 Pod 的生命周期管理,执行任务并将 Pod 状态报告给主节点的渠道,通过容器运行时(拉取镜像、启动和停止容器等)来运行这些容器。它还会定期执行被请求的容器的健康探测程序。

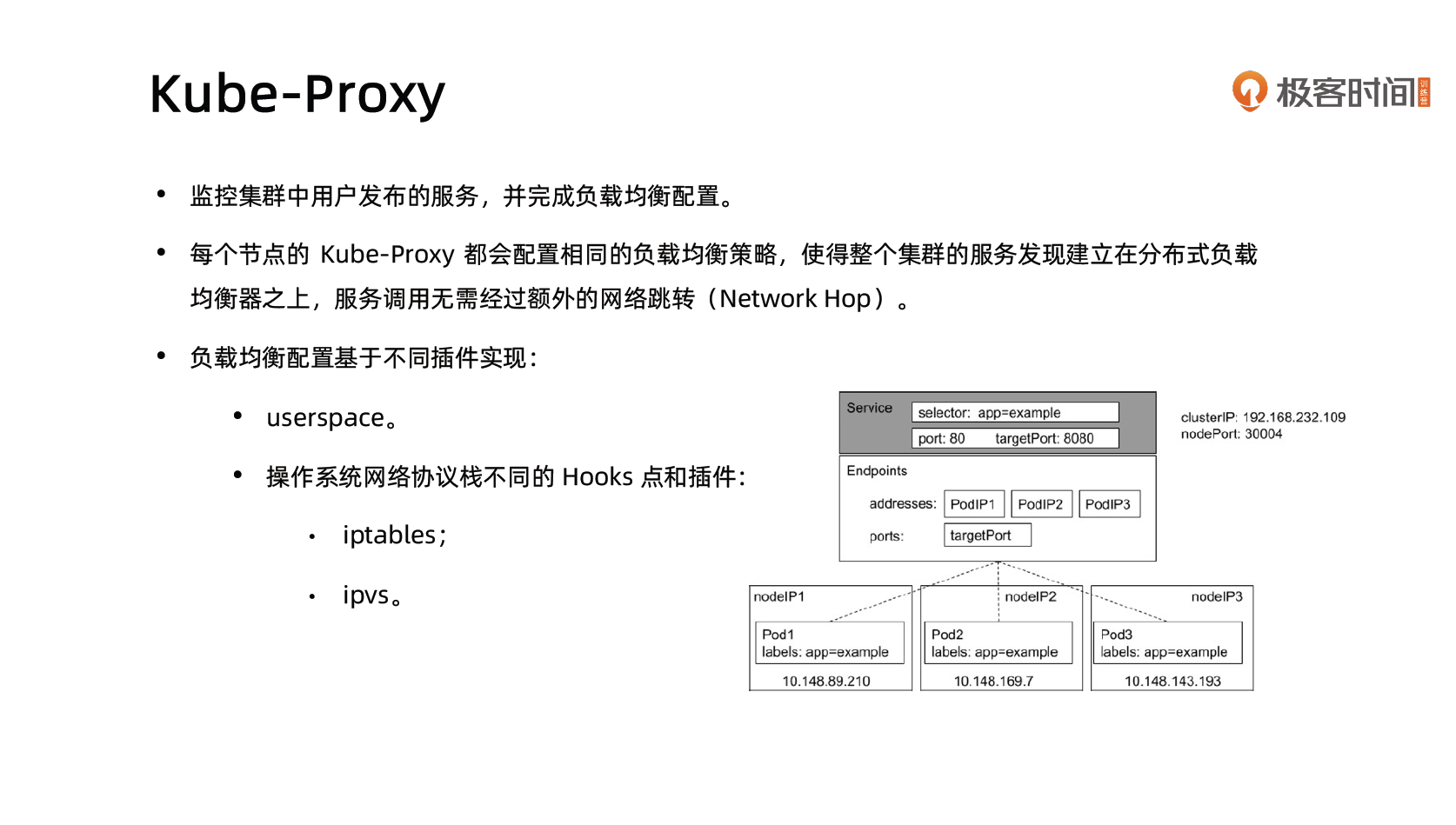

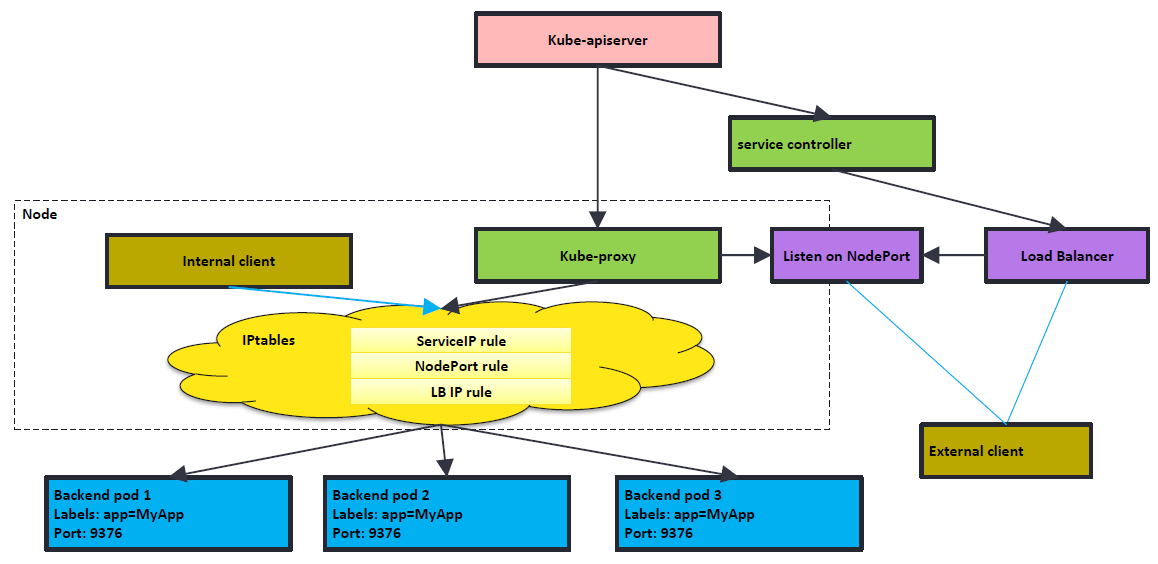

Kube-proxy

它负责节点的网络,在主机上维护网络规则并执行连接转发。它还负责对正在服务的 pods 进行负载平衡。

etcd

直接访问 etcd 的数据

# 启动一个 minikube 集群

$ minikube start

# 获取 kube-system 中所有 pods

$ kubectl -n kube-system get pods

NAME READY STATUS RESTARTS AGE

coredns-7db6d8ff4d-z2rlw 1/1 Running 0 4h10m

etcd-minikube 1/1 Running 0 4h10m

kube-apiserver-minikube 1/1 Running 0 4h10m

kube-controller-manager-minikube 1/1 Running 0 4h10m

kube-proxy-m5fjm 1/1 Running 0 4h10m

kube-scheduler-minikube 1/1 Running 0 4h10m

storage-provisioner 1/1 Running 1 (4h9m ago) 4h10m

# 进入集群 etcd 所在的容器

$ kubectl -n kube-system exec -it etcd-minikube /bin/sh

$ alias etcdctl="etcdctl --endpoints https://localhost:2379 --cacert=/var/lib/minikube/certs/etcd/ca.crt --cert=/var/lib/minikube/certs/etcd/server.crt --key=/var/lib/minikube/certs/etcd/server.key"

# 查看 etcd 中的数据

$ etcdctl get --prefix / --keys-only

# 监听 default 命名空间中名为 nginx-svc 的 service 的变化

$ etcdctl watch --prefix /registry/services/specs/default/nginx-svcAPIServer

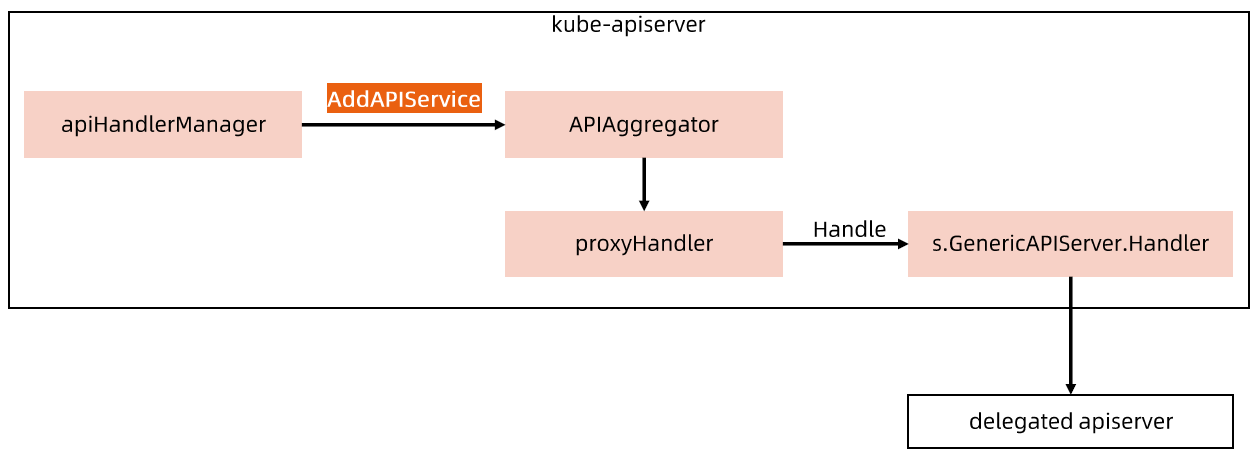

APIServer 展开

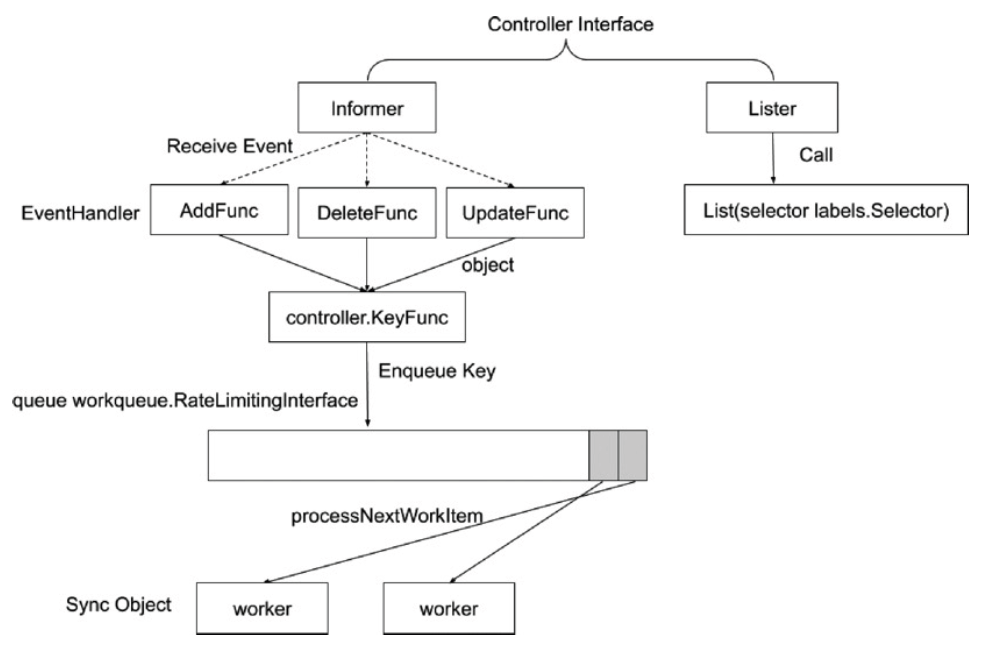

Controller Manager

- Controller Manager 是集群的大脑,是确保整个集群动起来的关键;

- 作用是确保 Kubernetes 遵循声明式系统规范,确保系统的真实状态(Actual State)与用户定义的期望状态(Desired State)一致;

- Controller Manager 是多个控制器的组合,每个 Controller 事实上都是一个 control loop,负责侦听其管控的对象,当对象发生变更时完成配置;

- Controller 配置失败通常会触发自动重试,整个集群会在控制器不断重试的机制下确保最终一致性( Eventual Consistency)。

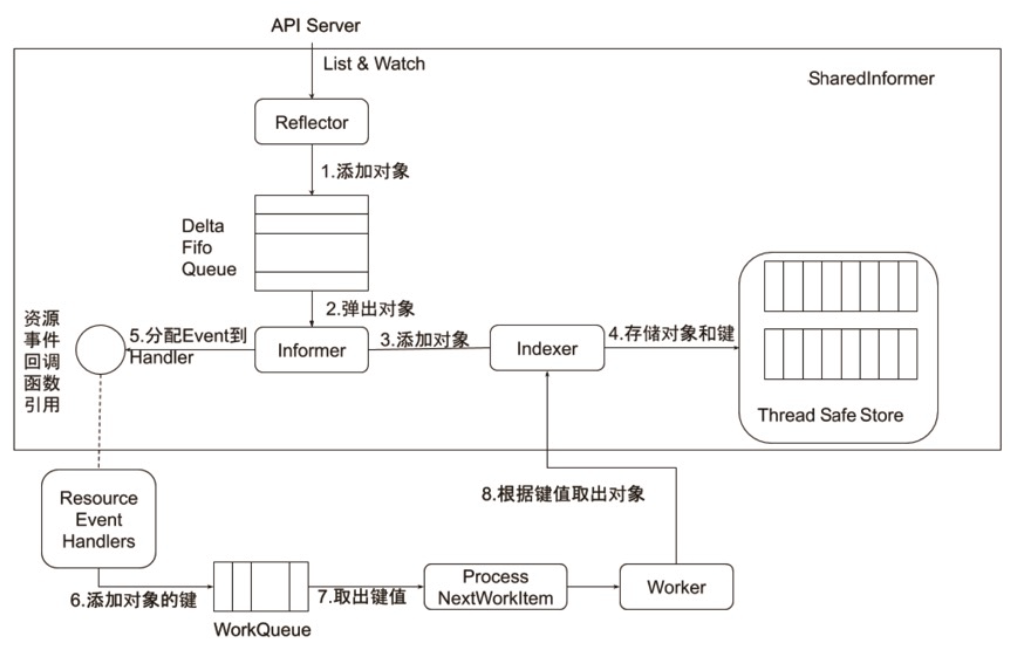

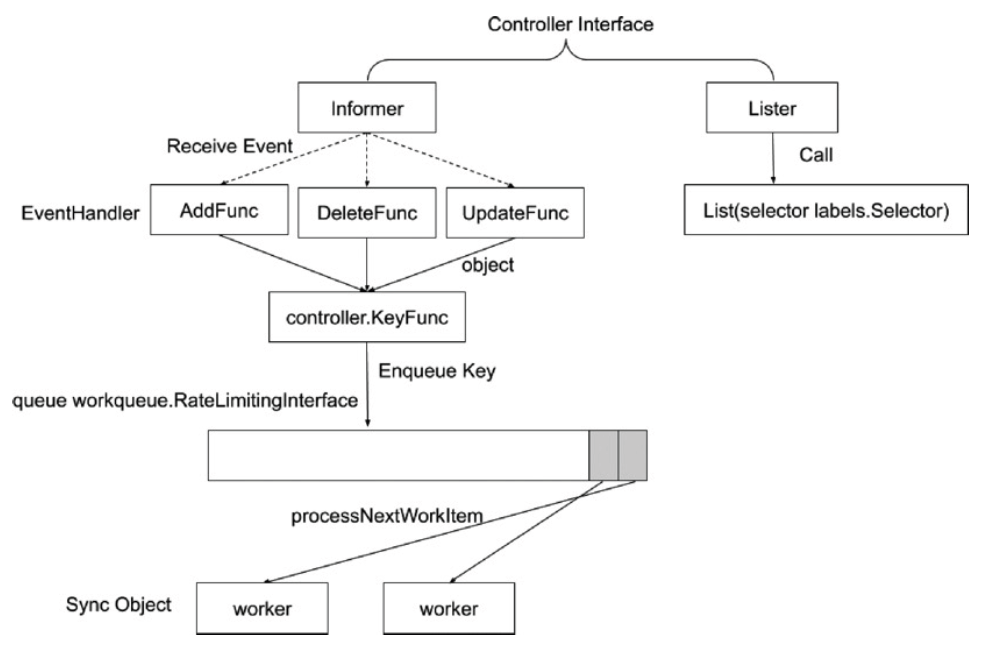

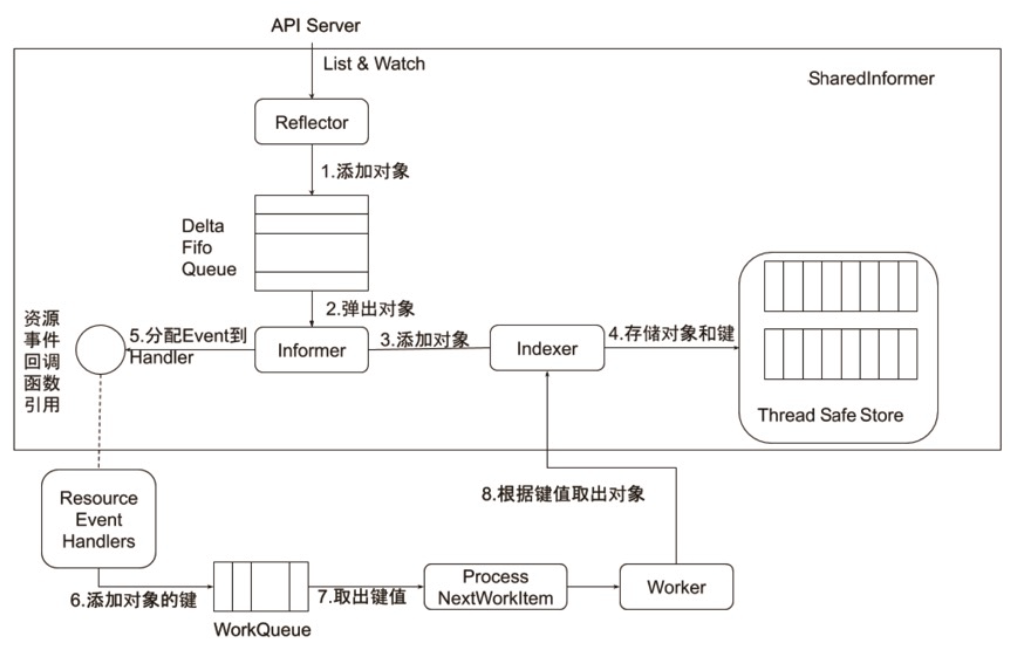

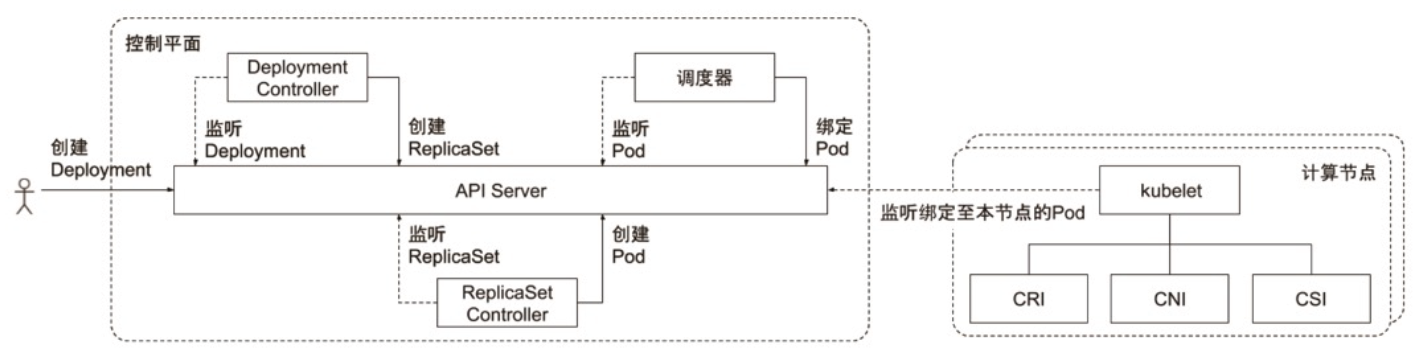

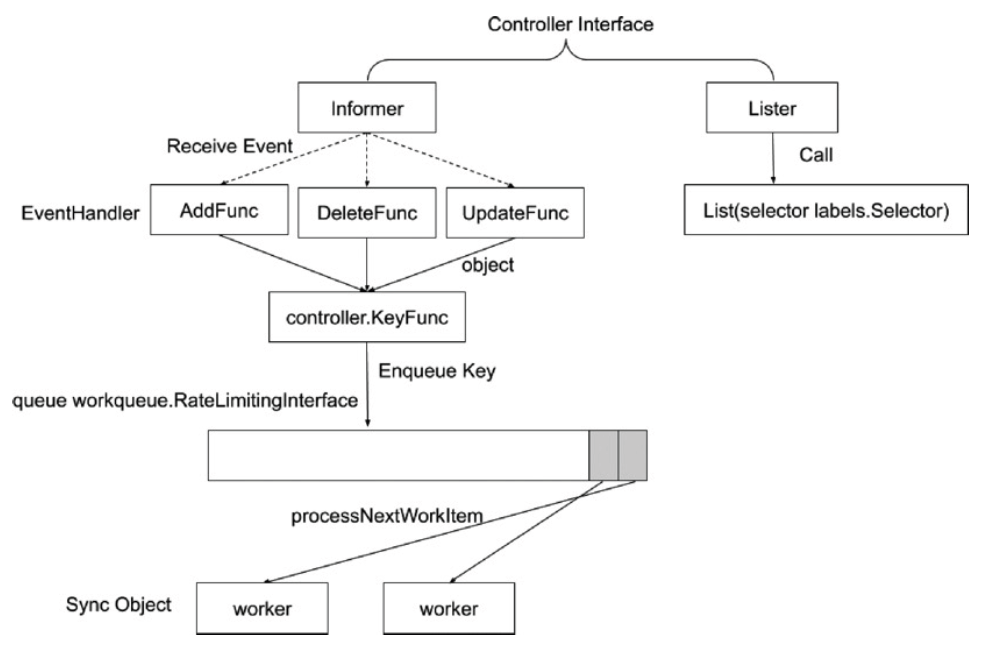

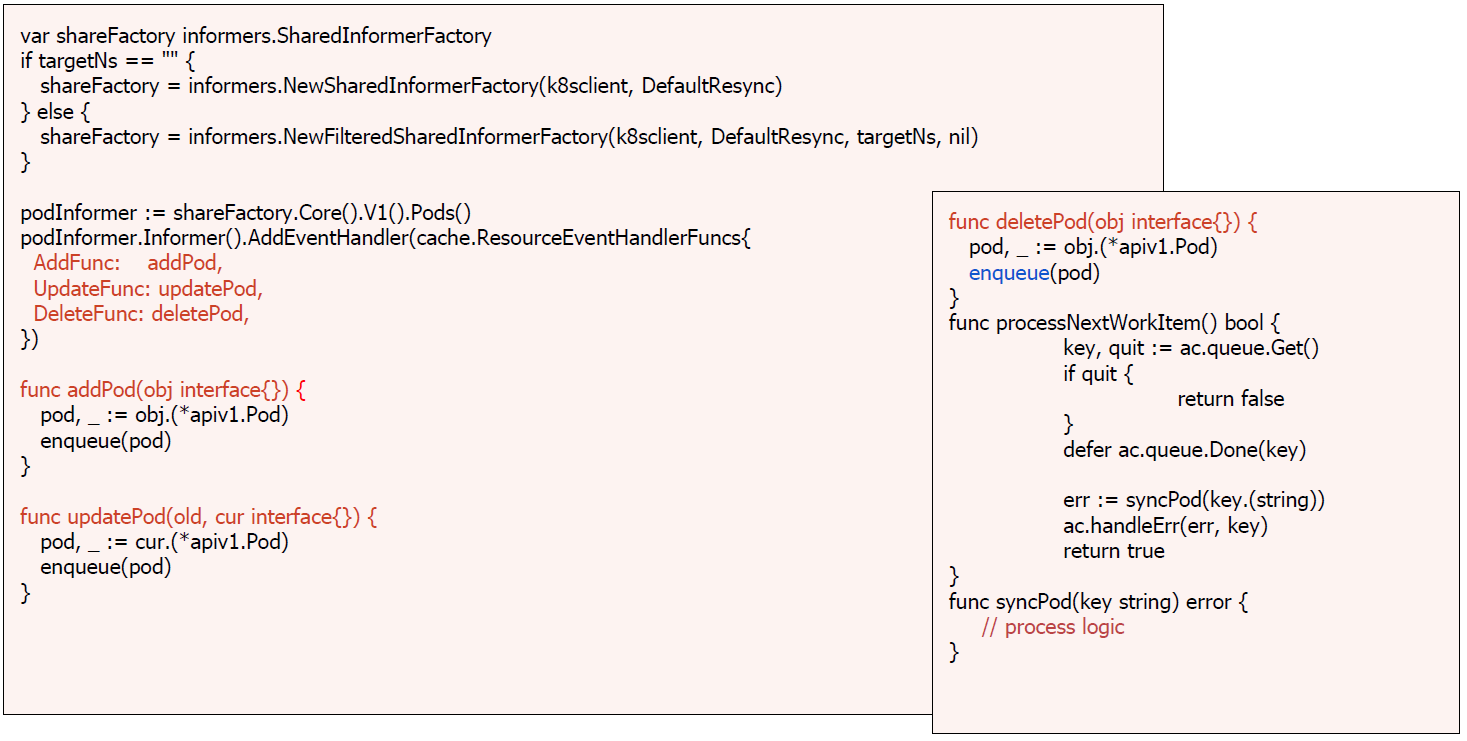

控制器的工作流程

Informer 的内部机制

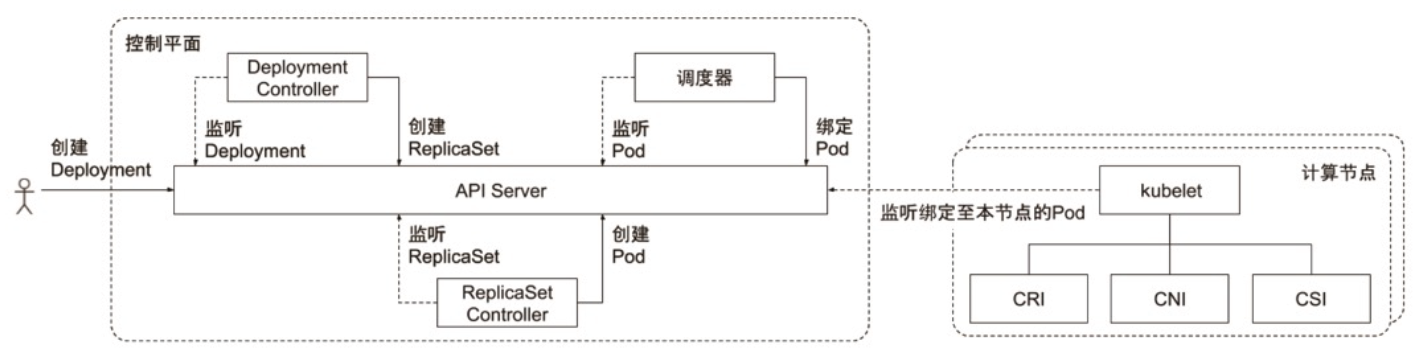

控制器的协同工作原理

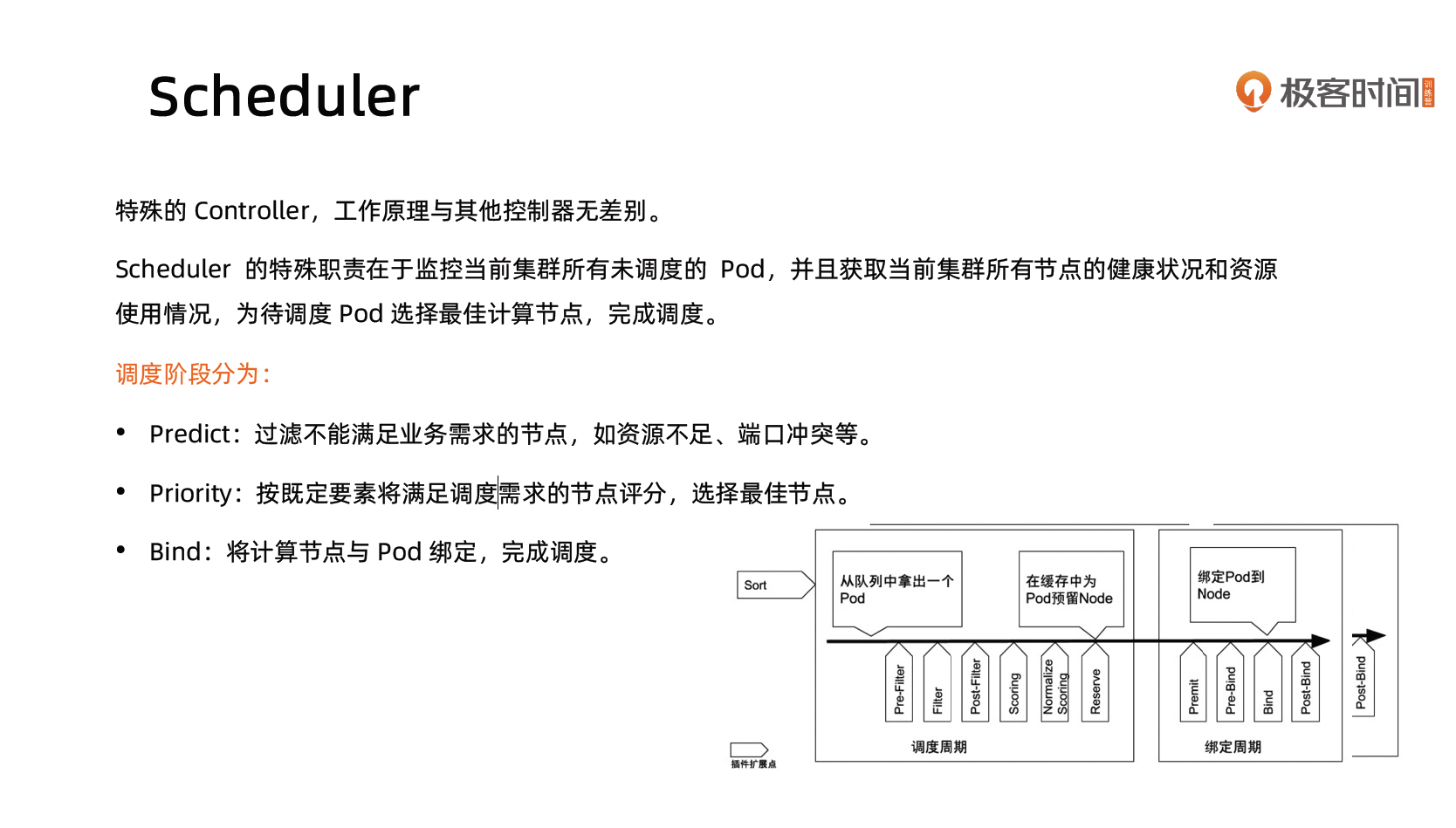

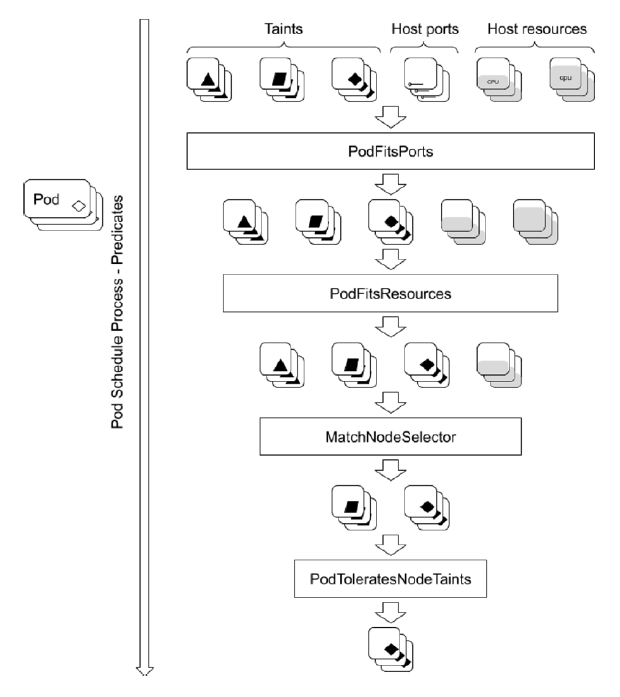

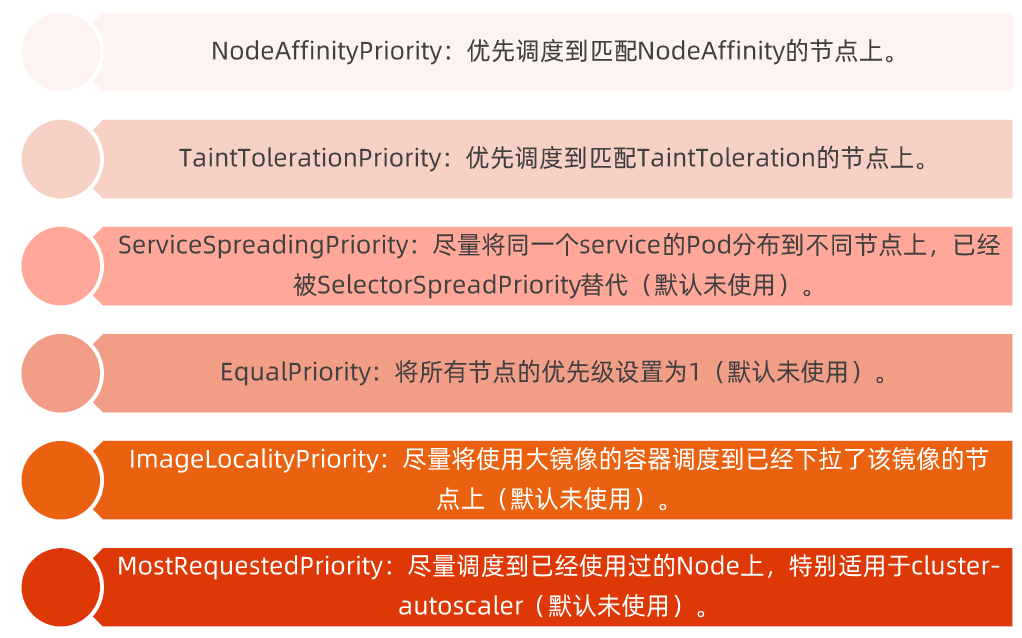

Scheduler

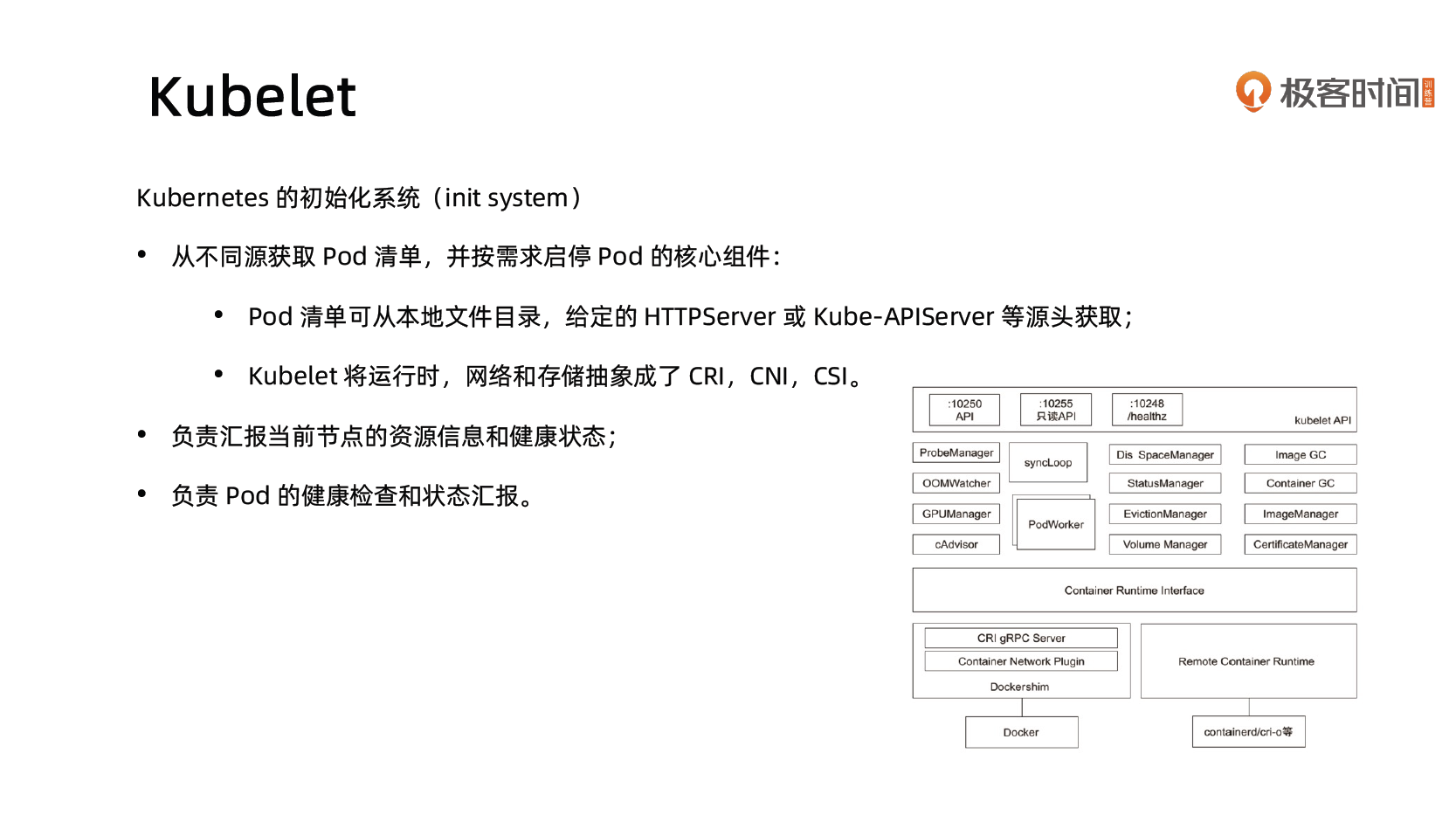

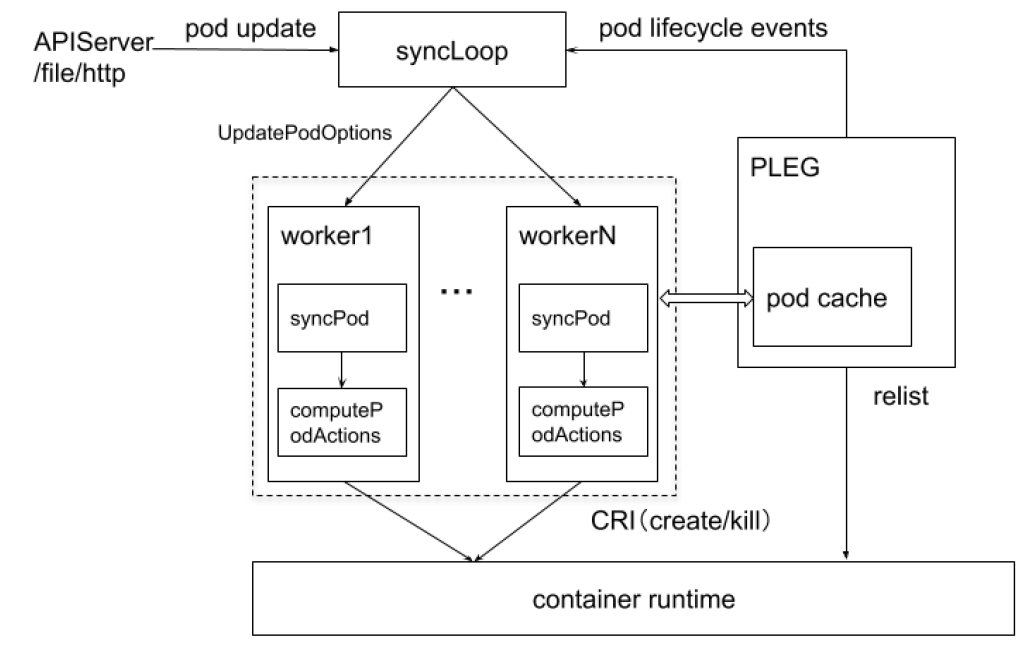

Kubelet

Kube-Proxy

推荐的 Add-ons

- kube-dns:负责为整个集群提供 DNS 服务;

- Ingress Controller:为服务提供外网入口;

- MetricsServer:提供资源监控;

- Dashboard:提供GUI;

- Fluentd-Elasticsearch:提供集群日志采集、存储与查询。

了解 kubectl

Kubectl 命令和 kubeconfig

- kubectl 是一个 Kubernetes 的命令行工具,它允许 Kubernetes 用户以命令行的方式与 Kubernetes 交互,其默认读取配置文件 ~/.kube/config。

- kubectl 会将接收到的用户请求转化为 rest 调用以 rest client 的形式与 apiserver 通讯。

- apiserver 的地址,用户信息等配置在 kubeconfig。

可以在命令后加 -v 9 来开启详细的日志,如 kubectl get namespace default -v 9。

apiVersion: v1

clusters:

- cluster:

certificate-authority: /home/k/.minikube/ca.crt

extensions:

- extension:

last-update: Thu, 02 May 2024 21:50:24 CST

provider: minikube.sigs.k8s.io

version: v1.33.0

name: cluster_info

server: https://127.0.0.1:32774

name: minikube

contexts:

- context:

cluster: minikube

extensions:

- extension:

last-update: Thu, 02 May 2024 21:50:24 CST

provider: minikube.sigs.k8s.io

version: v1.33.0

name: context_info

namespace: default

user: minikube

name: minikube

current-context: minikube

kind: Config

preferences: {}

users:

- name: minikube

user:

client-certificate: /home/k/.minikube/profiles/minikube/client.crt

client-key: /home/k/.minikube/profiles/minikube/client.keykubectl 常用命令

kubectl get po -oyaml -w

- kubectl 可查看对象。

- -oyaml 输出详细信息为 yaml 格式。

- -w watch 该对象的后续变化。

- -owide 以详细列表的格式查看对象。

kubectl describe 展示资源的详细信息和相关 Event。

kubectl exec 提供进入运行容器的通道,可以进入容器进行 debug 操作。

Kubectl logs 可查看 pod 的标准输入(stdout, stderr),与 tail 用法类似。

深入理解 Kubernetes

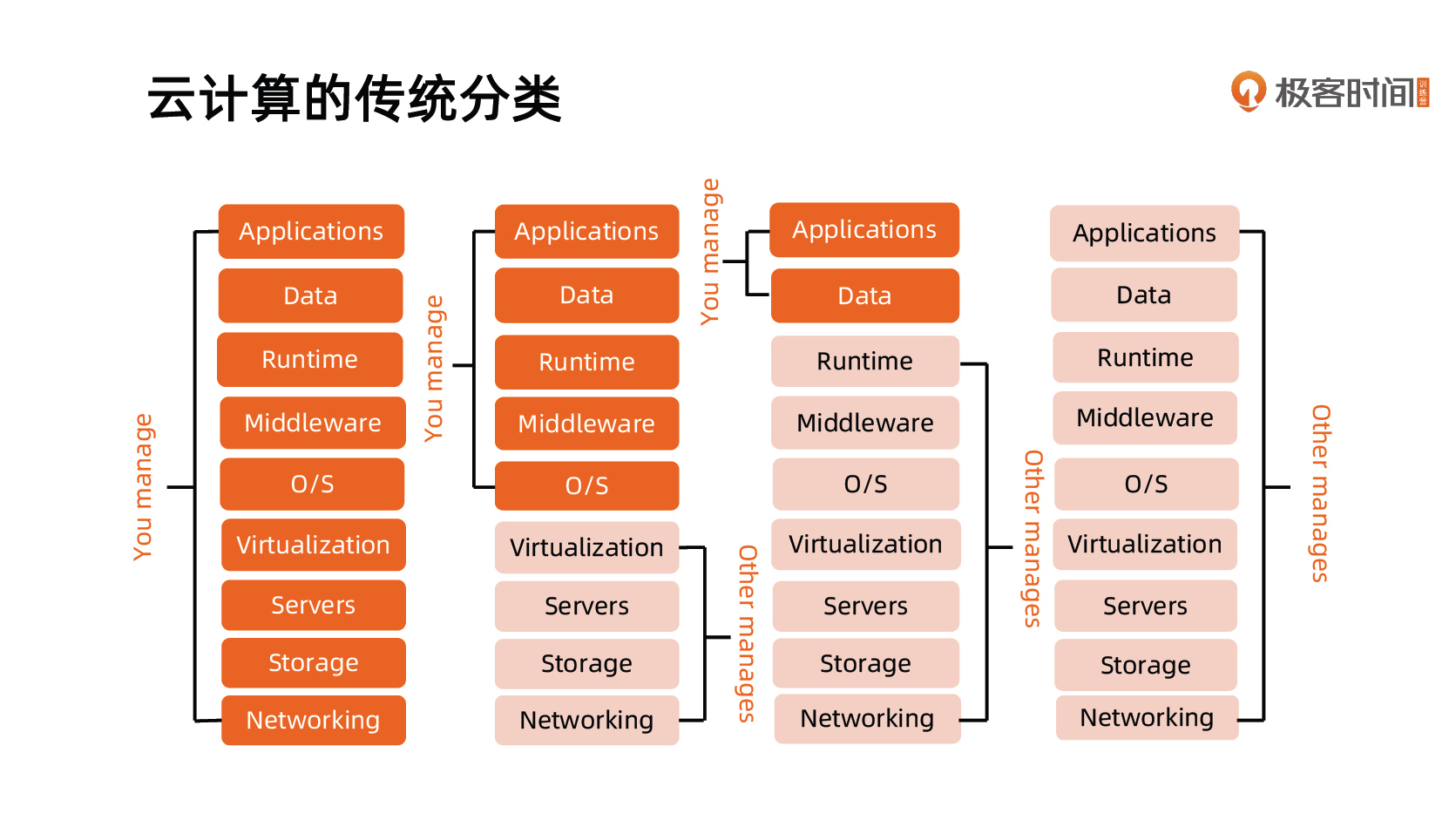

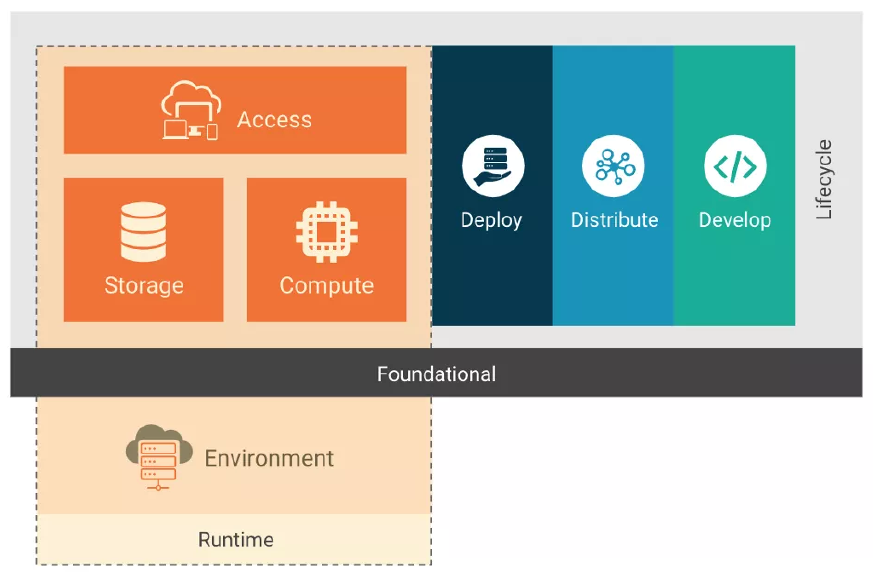

云计算的传统分类

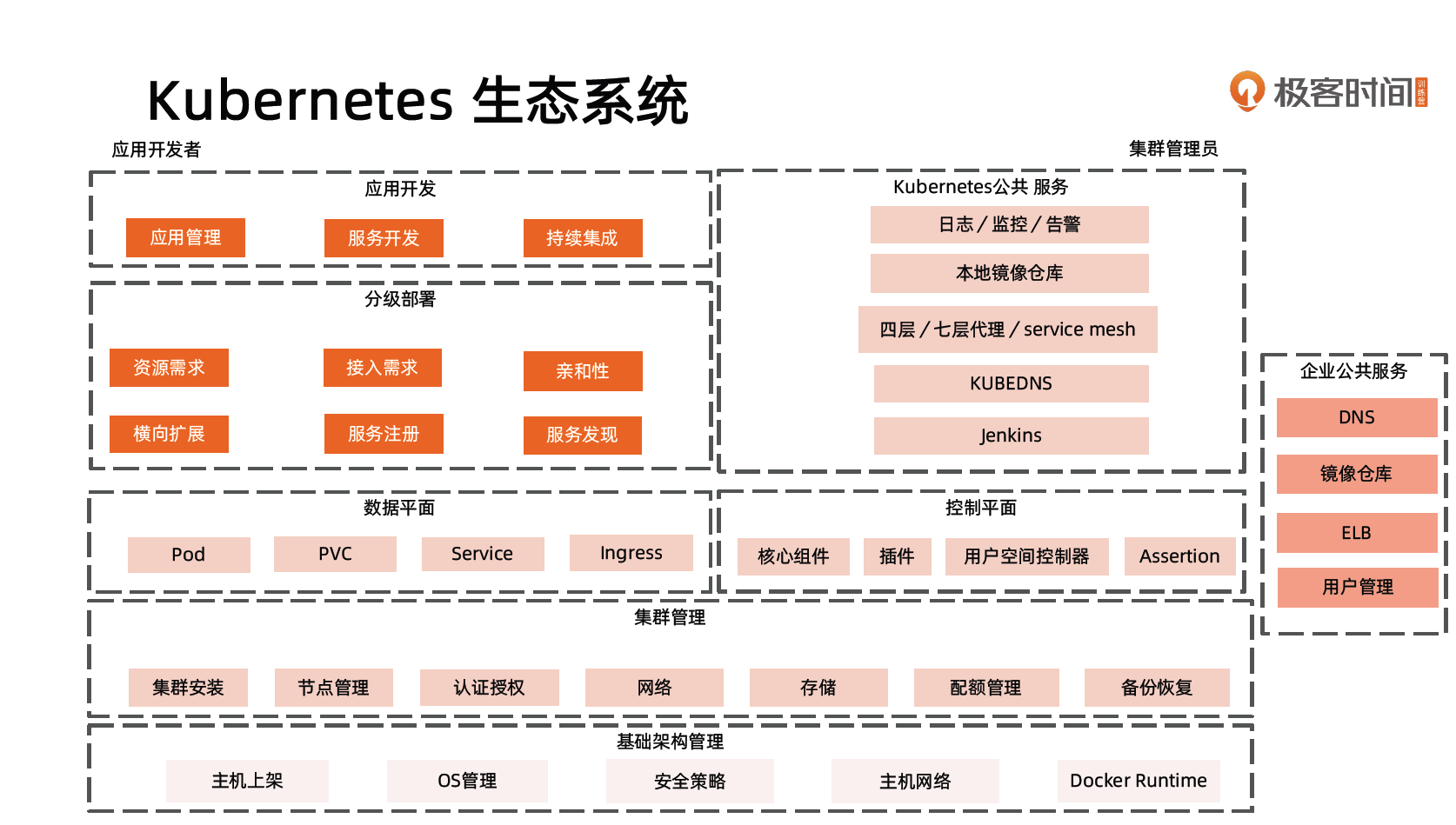

Kubernetes 生态系统

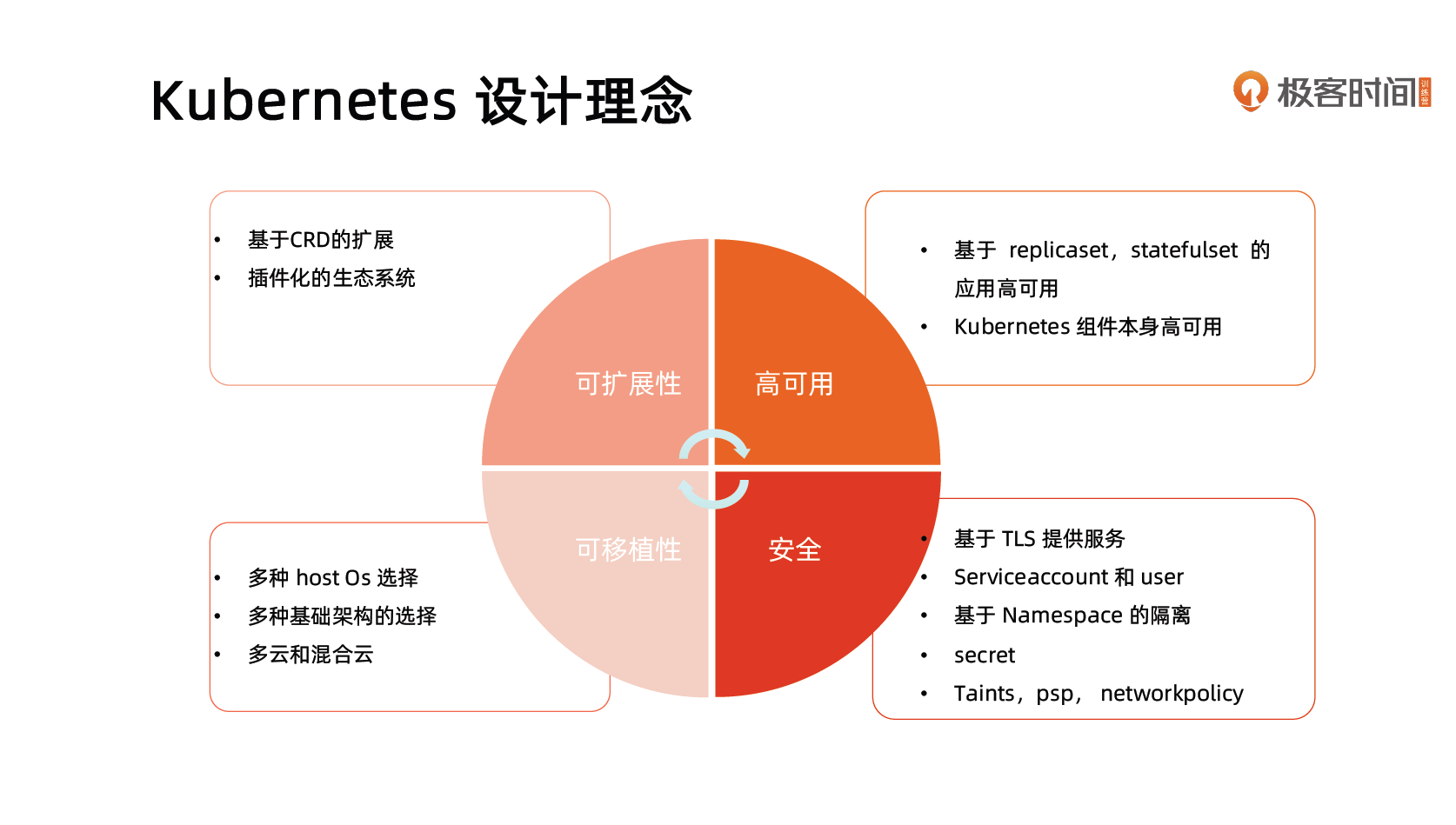

Kubernetes 设计理念

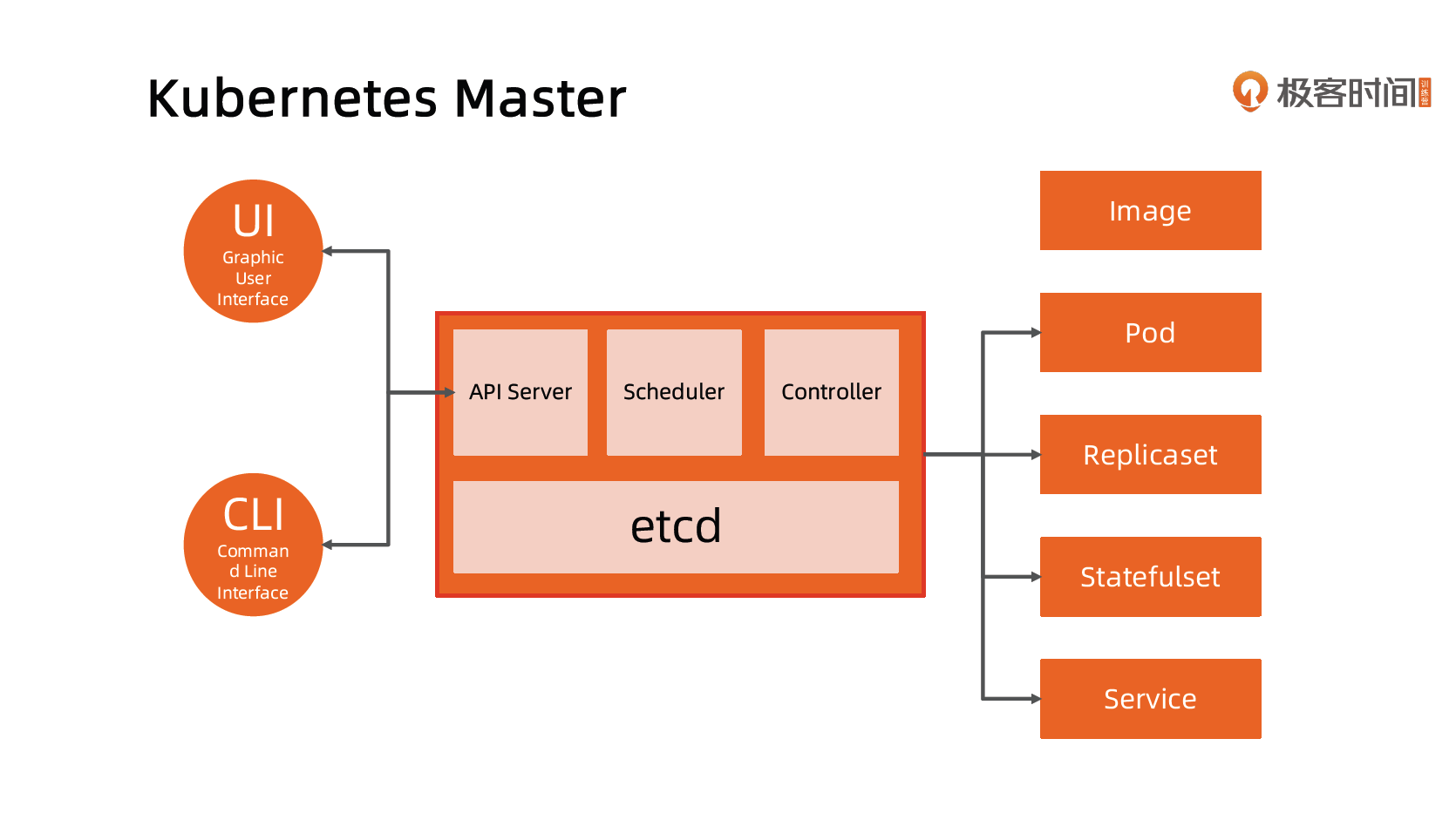

Kubernetes Master

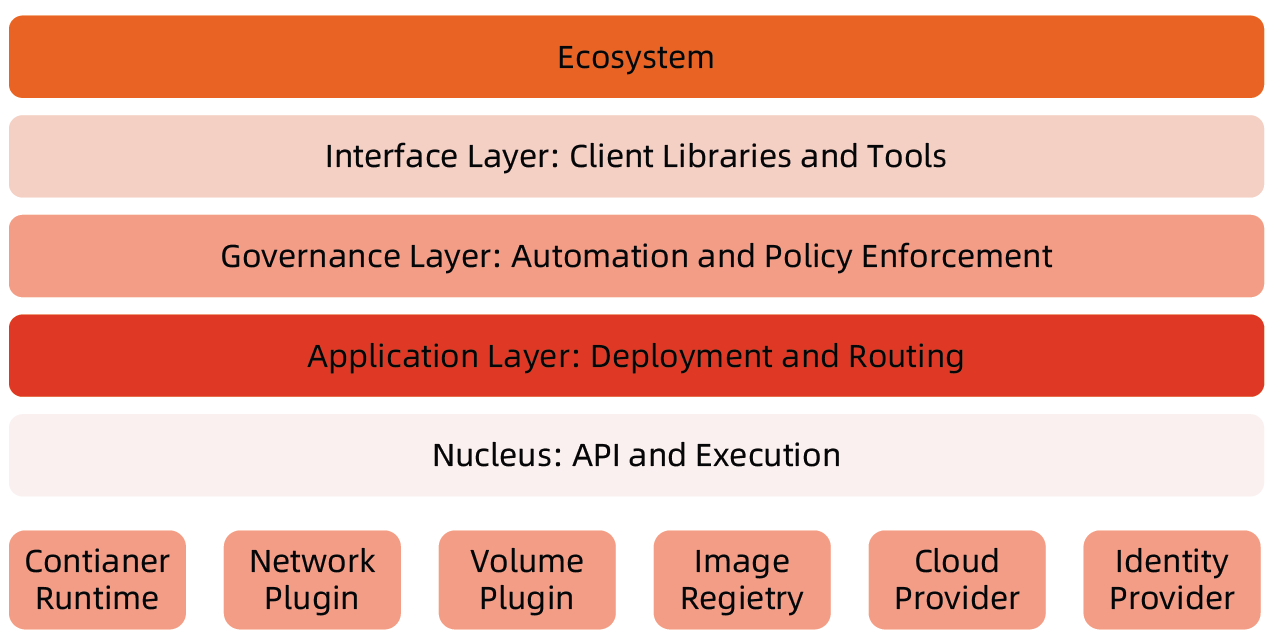

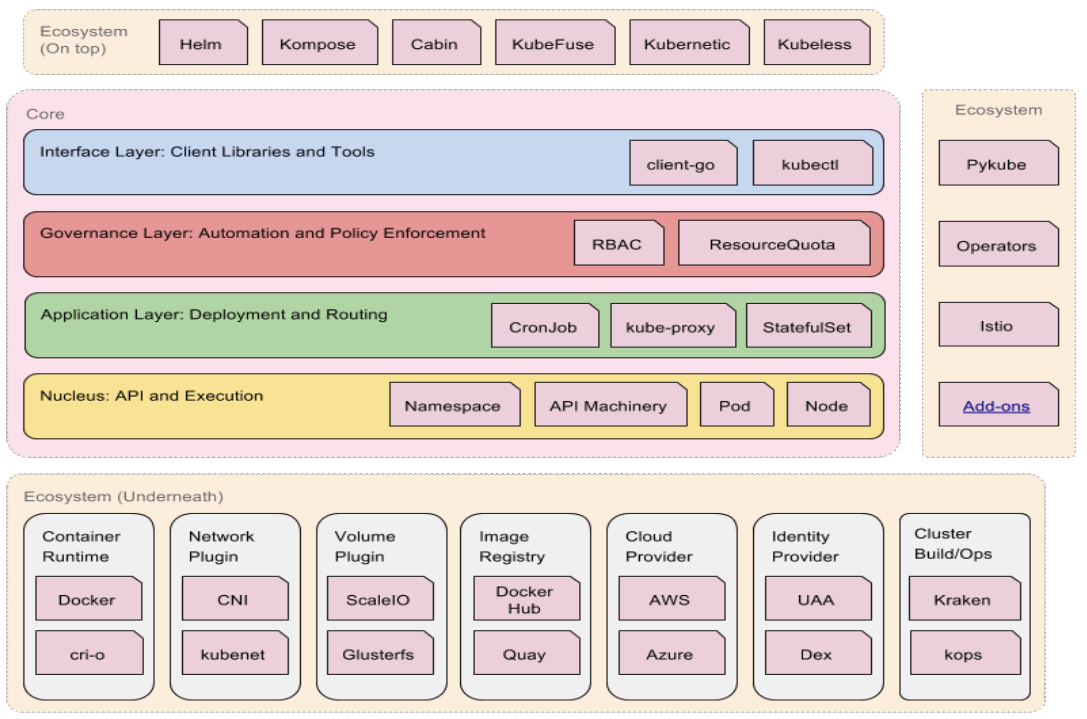

分层架构

- 核心层:Kubernetes 最核心的功能,对外提供 API 构建高层的应用,对内提供插件式应用执行环境。

- 应用层:部署(无状态应用、有状态应用、批处理任务、集群应用等)和路由(服务发现、DNS 解析等)。

- 管理层:系统度量(如基础设施、容器和网络的度量)、自动化(如自动扩展、动态 Provision 等)、策略管理(RBAC、Quota、PSP、NetworkPolicy 等)。

- 接口层:Kubectl 命令行工具、客户端 SDK 以及集群联邦。

- 生态系统:在接口层之上的庞大容器集群管理调度的生态系统,可以划分为两个范畴:

- Kubernetes 外部:日志、监控、配置管理、CI、CD、Workflow、FaaS、OTS 应用、ChatOps 等;

- Kubernetes 内部:CRI、CNI、CVI、镜像仓库、Cloud Provider、集群自身的配置和管理等。

API 设计原则

- 所有 API 都应是声明式的

- 相对于命令式操作,声明式操作对于重复操作的效果是稳定的,这对于容易出现数据丢失或重复的分布式环境来说是很重要的。

- 声明式操作更易被用户使用,可以使系统向用户隐藏实现的细节,同时也保留了系统未来持续优化的可能性。

- 此外,声明式的 API 还隐含了所有的 API 对象都是名词性质的,例如 Service、Volume 这些 API 都是名词,这些名词描述了用户所期望得到的一个目标对象。

- API 对象是彼此互补而且可组合的

- 这实际上鼓励 API 对象尽量实现面向对象设计时的要求,即”高内聚,松耦合”,对业务相关的概念有一个合适的分解,提高分解出来的对象的可重用性。

- 高层 API 以操作意图为基础设计

- 如何能够设计好 API,跟如何能用面向对象的方法设计好应用系统有相通的地方,高层设计一定是从业务出发,而不是过早的从技术实现出发。

- 因此,针对 Kubernetes 的高层 API 设计,一定是以 Kubernetes 的业务为基础出发,也就是以系统调度管理容器的操作意图为基础设计。

- 低层 API 根据高层 API 的控制需要设计

- 设计实现低层 API 的目的,是为了被高层 API 使用,考虑减少冗余、提高重用性的目的,低层 API 的设计也要以需求为基础,要尽量抵抗受技术实现影响的诱惑。

- 尽量避免简单封装,不要有在外部 API 无法显式知道的内部隐藏的机制

- 简单的封装,实际没有提供新的功能,反而增加了对所封装 API 的依赖性。

- 例如 StatefulSet 和 ReplicaSet,本来就是两种 Pod 集合,那么 Kubernetes 就用不同 API 对象来定义它们,而不会说只用同一个 ReplicaSet,内部通过特殊的算法再来区分这个 ReplicaSet 是有状态的还是无状态。

- API 操作复杂度与对象数量成正比

- API 的操作复杂度不能超过 O(N),否则系统就不具备水平伸缩性了。

- API 对象状态不能依赖于网络连接状态

- 由于众所周知,在分布式环境下,网络连接断开是经常发生的事情,因此要保证 API 对象状态能应对网络的不稳定,API 对象的状态就不能依赖于网络连接状态。

- 尽量避免让操作机制依赖于全局状态

- 因为在分布式系统中要保证全局状态的同步是非常困难的。

Kubernetes 如何通过对象的组合完成业务描述

引用依赖:一个对象中有个属性的名字指向了另一个对象。

基于命名规范:Deployment 根据 PodTemplate 的 hash 值来作为 Replicaset 名字的一部分,这个关系是写在代码中的。

基于标签:根据标签来筛选。

架构设计原则

- 只有 APIServer 可以直接访问 etcd 存储,其他服务必须通过 Kubernetes API 来访问集群状态;

- 单节点故障不应该影响集群的状态;

- 在没有新请求的情况下,所有组件应该在故障恢复后继续执行上次最后收到的请求(比如网络分区或服务重启等);

- 所有组件都应该在内存中保持所需要的状态,APIServer 将状态写入 etcd 存储,而其他组件则通过 API Server 更新并监听所有的变化;

- 优先使用事件监听而不是轮询。

引导(Bootstrapping)原则

- Self-hosting 是目标。

- 减少依赖,特别是稳态运行的依赖。

- 通过分层的原则管理依赖。

- 循环依赖问题的原则:

- 同时还接受其他方式的数据输入(比如本地文件等),这样在其他服务不可用时还可以手动配置引导服务;

- 状态应该是可恢复或可重新发现的;

- 支持简单的启动临时实例来创建稳态运行所需要的状态,使用分布式锁或文件锁等来协调不同状态的切换(通常称为 pivoting 技术);

- 自动重启异常退出的服务,比如副本或者进程管理器等。

核心技术概念和 API 对象

API 对象是 Kubernetes 集群中的管理操作单元。

Kubernetes 集群系统每支持一项新功能,引入一项新技术,一定会新引入对应的API 对象,支持对该功能的管理操作。

每个 API 对象都有四大类属性:

- TypeMeta

- MetaData

- Spec

- Status

TypeMeta

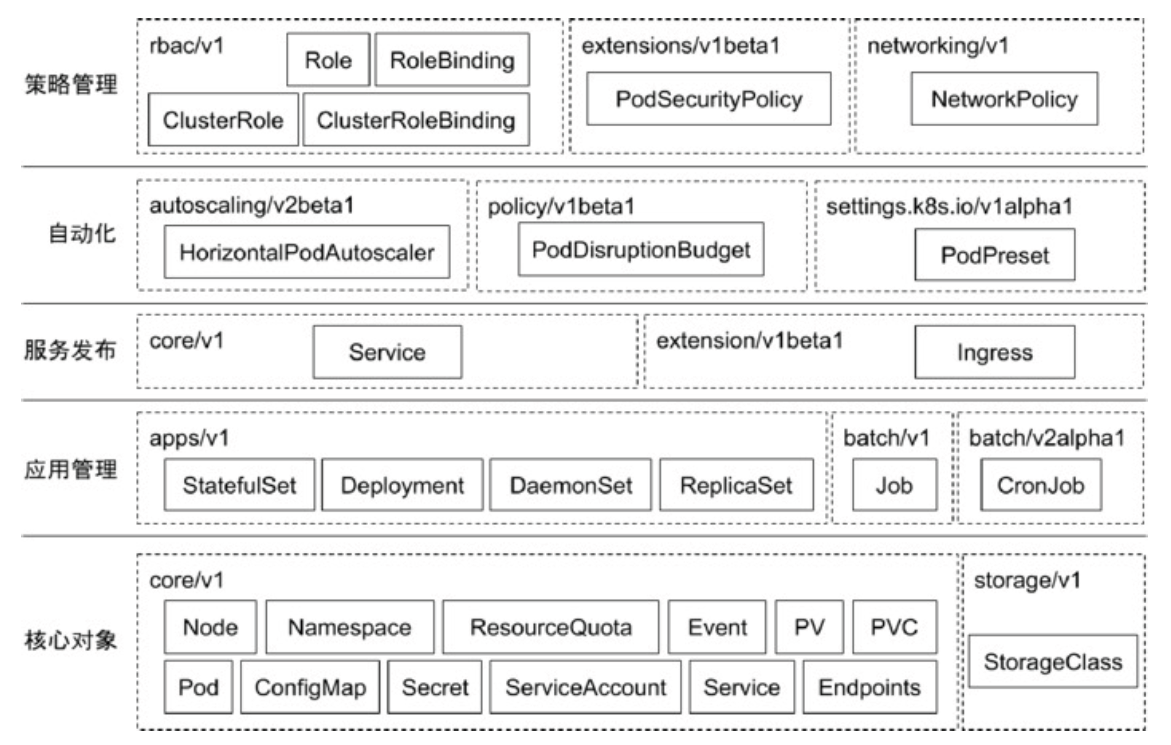

Kubernetes对象的最基本定义,它通过引入 GKV(Group,Kind,Version)模型定义了一个对象的类型。

- Group

Kubernetes 定义了非常多的对象,如何将这些对象进行归类是一门学问,将对象依据其功能范围归入不同的分组,比如把支撑最基本功能的对象归入 core 组,把与应用部署有关的对象归入 apps 组,会使这些对象的可维护性和可理解性更高。 - Kind

定义一个对象的基本类型,比如 Node、Pod、Deployment 等。 - Version

社区每个季度会推出一个 Kubernetes 版本,随着 Kubernetes 版本的演进,对象从创建之初到能够完全生产化就绪的版本是不断变化的。与软件版本类似,通常社区提出一个模型定义以后,随着该对象不断成熟,其版本可能会从 v1alpha1 到 v1alpha2,或者到 v1beta1,最终变成生产就绪版本 v1。

Metadata

Metadata 中有两个最重要的属性:Namespace 和 Name,分别定义了对象的 Namespace 归属及名字,这两个属性唯一定义了某个对象实例。

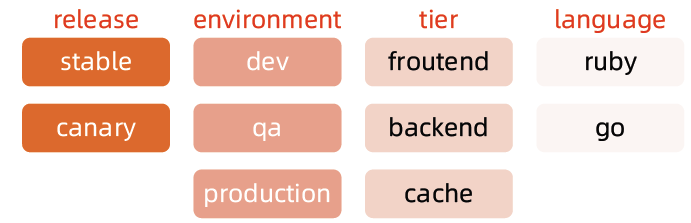

Label

顾名思义就是给对象打标签,一个对象可以有任意对标签,其存在形式是键值对。Label 定义了对象的可识别属性,Kubernetes API 支持以 Label 作为过滤条件查询对象。

Annotation

Annotation 与 Label 一样用键值对来定义,但 Annotation 是作为属性扩展,更多面向于系统管理员和开发人员,因此需要像其他属性一样做合理归类。

Finalizer

Finalizer 本质上是一个资源锁,Kubernetes 在接收某对象的删除请求时,会检查 Finalizer 是否为空,如果不为空则只对其做逻辑删除,即只会更新对象中的 metadata.deletionTimestamp 字段。

主要用于避免某个资源控制器意外终止,而无法监听到对应资源删除事件的情况。一旦某个资源设置了 Finalizer,那么这个资源删除时将不会消除,需要删除资源上的 Finalizer 后这个资源才会真正的删除,这就给了对应资源控制器处理的机会。

ResourceVersion

ResourceVersion 可以被看作一种乐观锁,每个对象在任意时刻都有其 ResourceVersion,当 Kubernetes 对象被客户端读取以后,ResourceVersion 信息也被一并读取。此机制确保了分布式系统中任意多线程能够无锁并发访问对象,极大提升了系统的整体效率。

Label

- Label 是识别 Kubernetes 对象的标签,以 key/value 的方式附加到对象上。

- key 最长不能超过 63 字节,value 可以为空,也可以是不超过 253 字节的字符串。

- Label 不提供唯一性,并且实际上经常是很多对象(如 Pods)都使用相同的 label 来标志具体的应用。

- Label 定义好后其他对象可以使用 Label Selector 来选择一组相同 label 的对象

- Label Selector 支持以下几种方式:

- 等式,如 app=nginx 和 env!=production;

- 集合,如 env in (production, qa);

- 多个 label(它们之间是 AND 关系),如 app=nginx,env=test。

Annotations

- Annotations 是 key/value 形式附加于对象的注解。

- 不同于 Labels 用于标志和选择对象,Annotations 则是用来记录一些附加信息,用来辅助应用部署、安全策略以及调度策略等。

- 比如 deployment 使用 annotations 来记录 rolling update 的状态。

Spec 和 Status

- Spec 和 Status 才是对象的核心。

- Spec 是用户的期望状态,由创建对象的用户端来定义。

- Status 是对象的实际状态,由对应的控制器收集实际状态并更新。

- 与 TypeMeta 和 Metadata 等通用属性不同,Spec 和 Status 是每个对象独有的。

常用Kubernetes 对象及其分组

核心对象概览

Node

- Node 是 Pod 真正运行的主机,可以物理机,也可以是虚拟机。

- 为了管理 Pod,每个 Node 节点上至少要运行 container runtime(比如Docker 或者Rkt)、Kubelet 和 Kube-proxy 服务。

Namespace

Namespace 是对一组资源和对象的抽象集合,比如可以用来将系统内部的对象划分为不同的项目组或用户组。

常见的 pods, services, replication controllers 和 deployments 等都是属于某一个 Namespace 的(默认是 default),而 Node, persistentVolumes 等则不属于任何 Namespace。

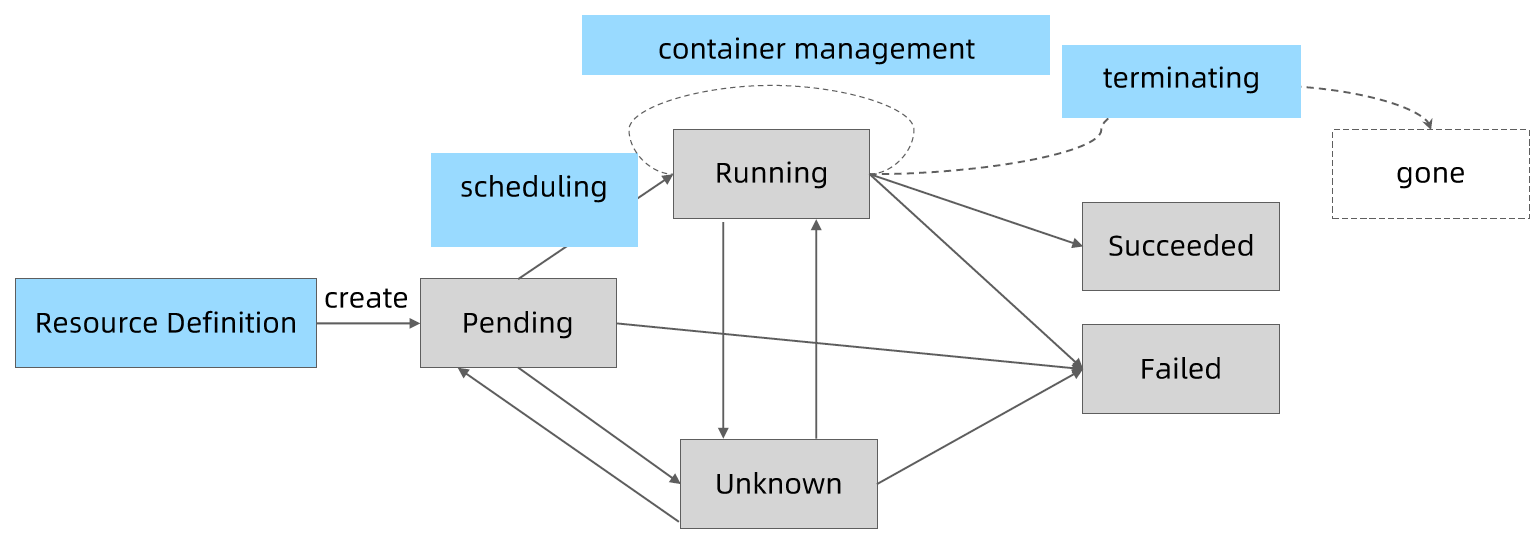

什么是 Pod

- Pod 是一组紧密关联的容器集合,它们共享 PID、IPC、Network 和 UTS namespace,是 Kubernetes 调度的基本单位。

- Pod 的设计理念是支持多个容器在一个 Pod 中共享网络和文件系统,可以通过进程间通信和文件共享这种简单高效的方式组合完成服务。

- 同一个 Pod 中的不同容器可共享资源:

- 共享网络 Namespace;

- 可通过挂载存储卷共享存储;

- 共享 Security Context。

apiVersion: v1

kind: Pod

metadata:

name: hello

spec:

containers:

- image: nginx:1.15

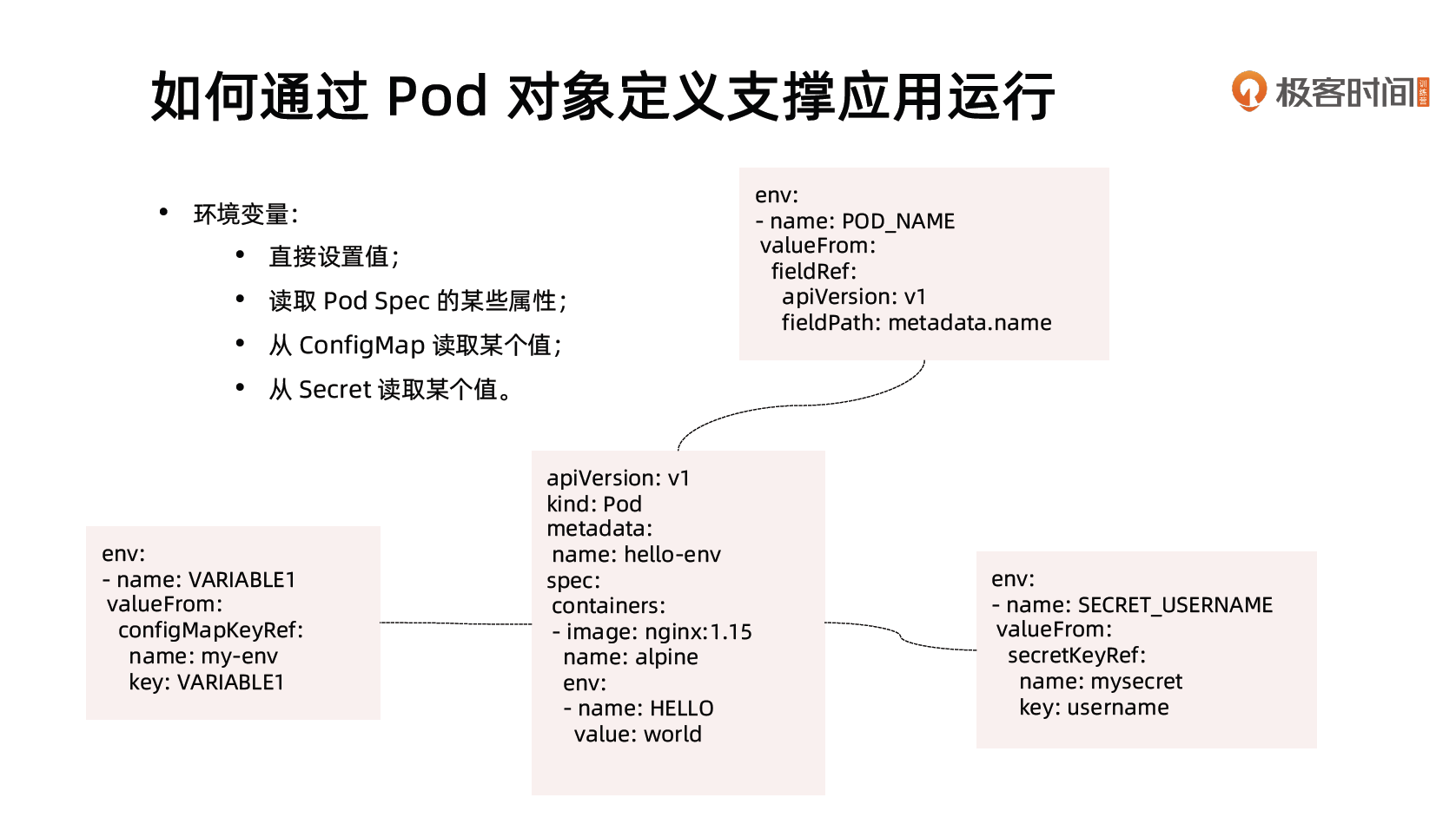

name: nginx如何通过Pod 对象定义支撑应用运行

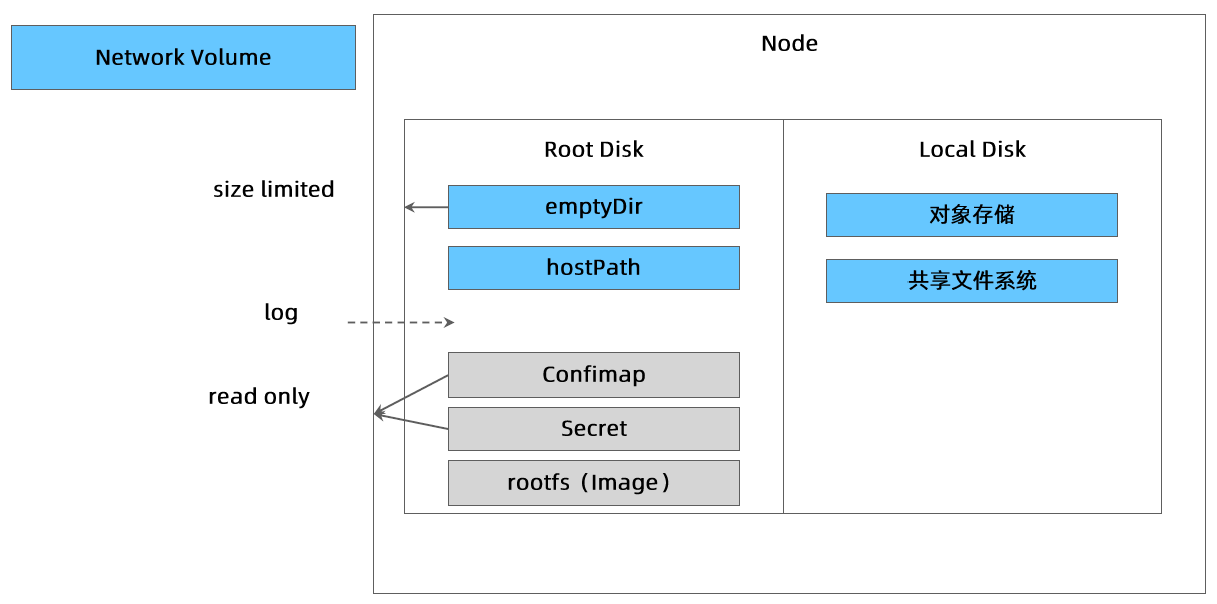

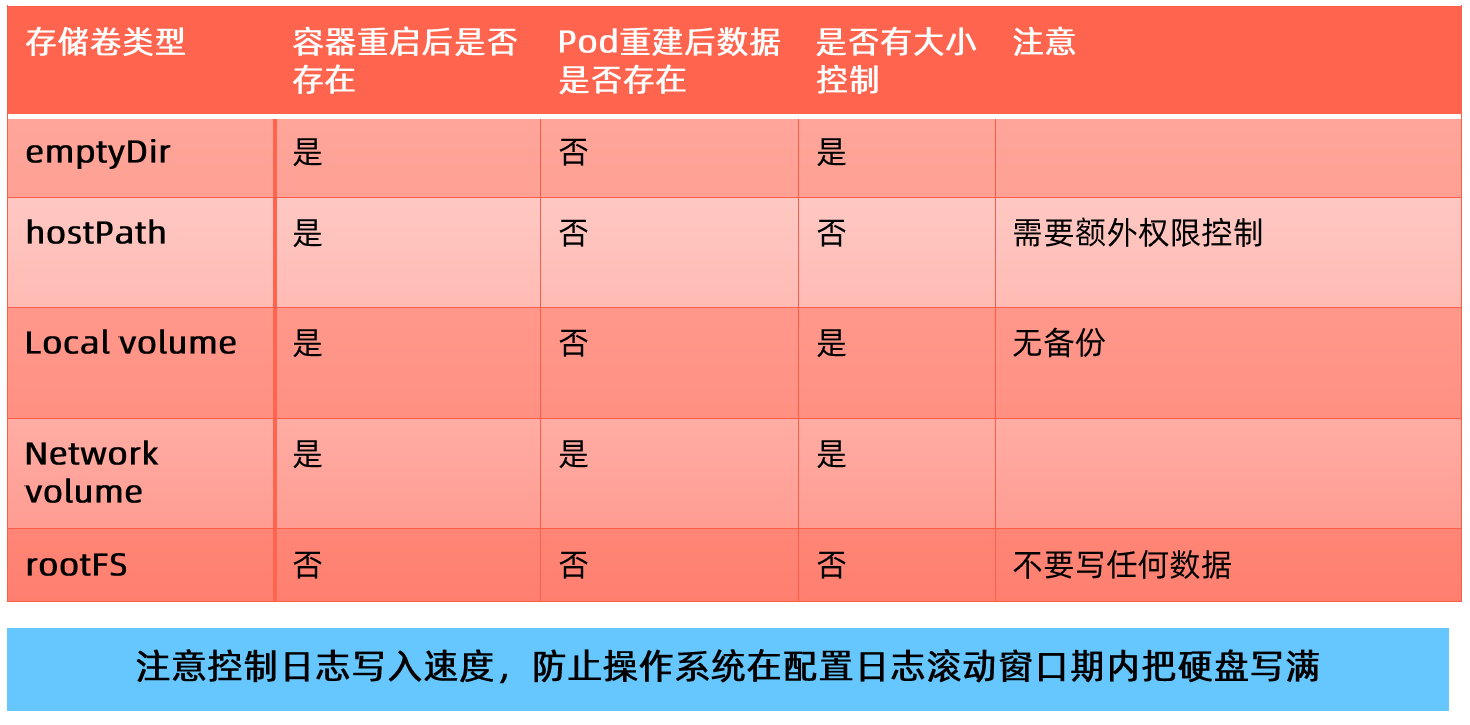

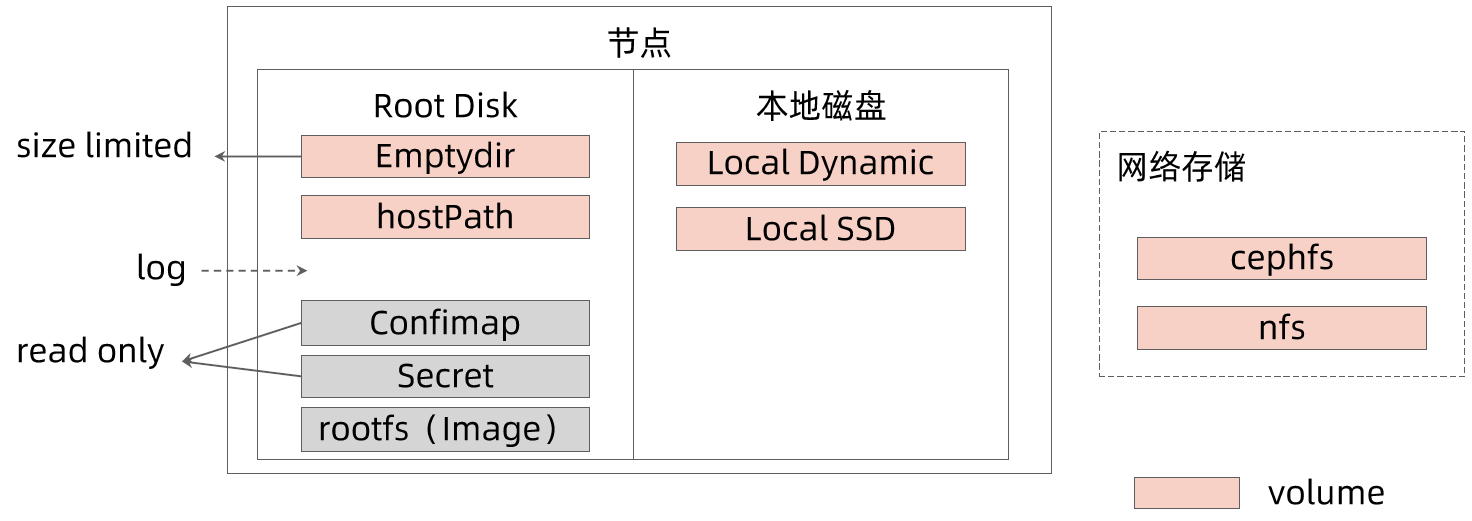

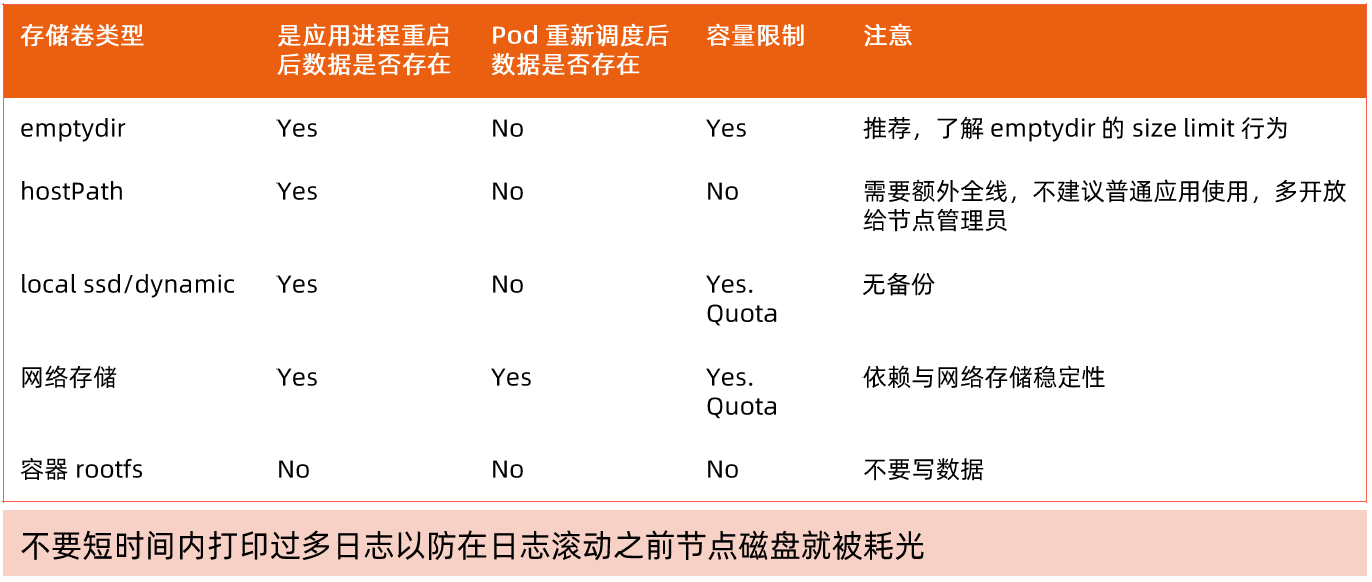

存储卷

- 通过存储卷可以将外挂存储挂载到 Pod 内部使用。

- 存储卷定义包括两个部分: Volume 和 VolumeMounts。

- Volume:定义 Pod 可以使用的存储卷来源;

- VolumeMounts:定义存储卷如何 Mount 到容器内部。

apiVersion: v1

kind: Pod

metadata:

name: hello-volume

spec:

containers:

- image: nginx:1.15

name: nginx

volumeMounts:

- name: data

mountPath: /data

volumes:

- name: data

emptyDir: {}Pod 网络

Pod 的多个容器是共享网络 Namespace 的,这意味着:

- 同一个 Pod 中的不同容器可以彼此通过 Loopback 地址访问:

- 在第一个容器中起了一个服务 http://127.0.0.1 。

- 在第二个容器内,是可以通过 httpGet http://172.0.0.1 访问到该地址的。

- 这种方法常用于不同容器的互相协作。

资源限制

Kubernetes 通过 Cgroups 提供容器资源管理的功能,可以限制每个容器的 CPU 和内存使用,比如对于刚才创建的 deployment,可以通过下面的命令限制 nginx 容器最多只用 50% 的CPU 和 128MB 的内存:

$ kubectl set resources deployment nginx-app -c=nginx --limits=cpu=500m,memory=128Mi

deployment "nginx" resource requirements updated等同于在每个 Pod 中设置 resources limits

apiVersion: v1

kind: Pod

metadata:

labels:

app: nginx

name: nginx

spec:

containers:

- image: nginx

name: nginx

resources:

limits:

cpu: "500m"

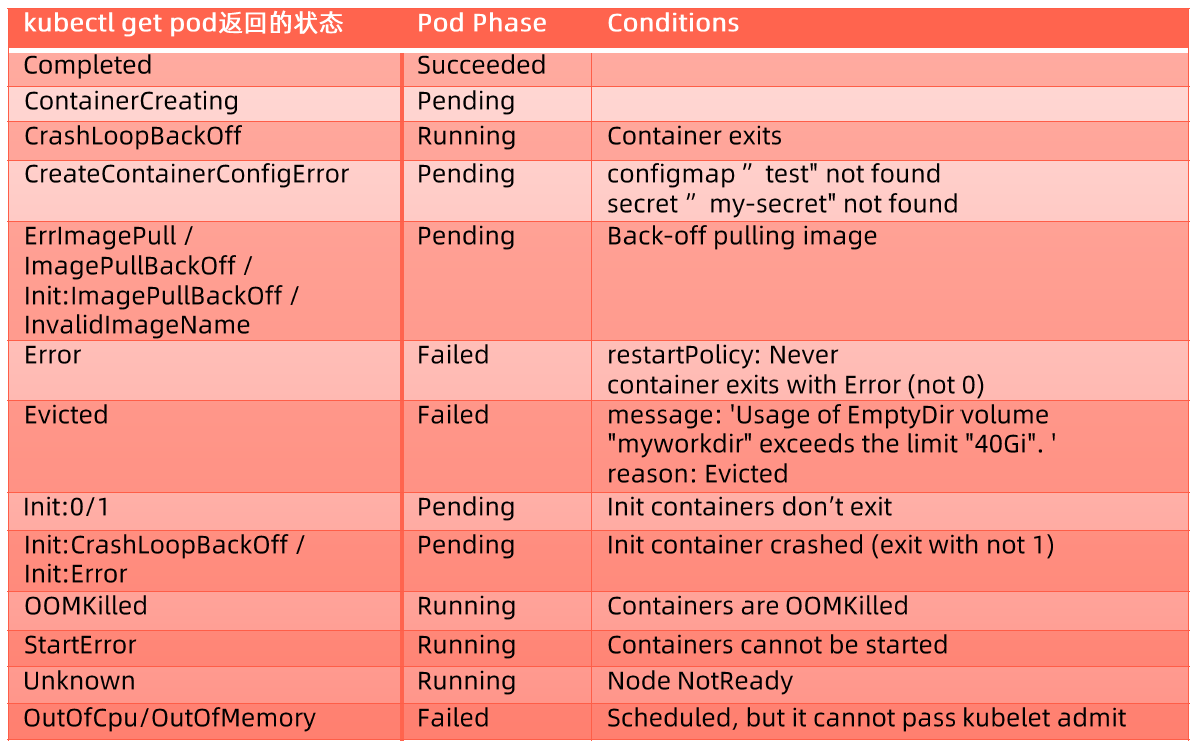

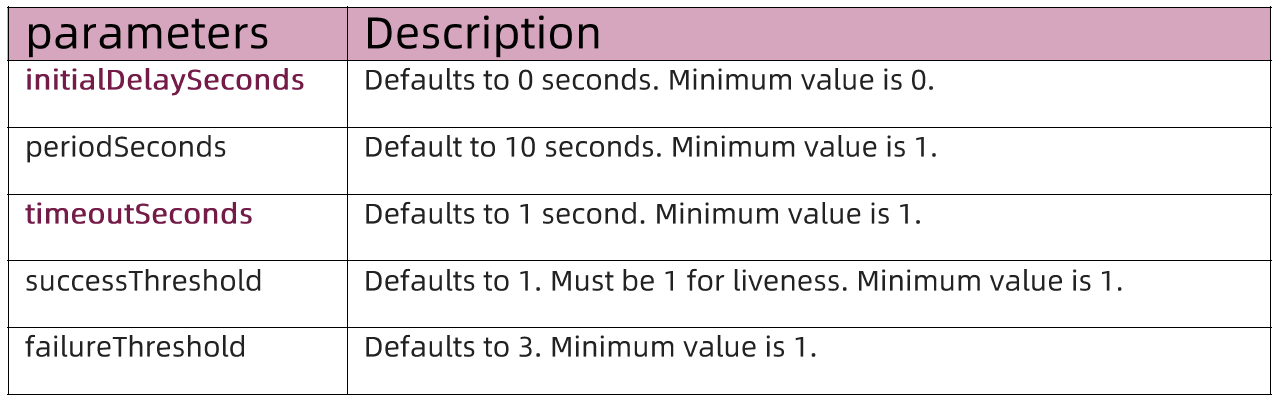

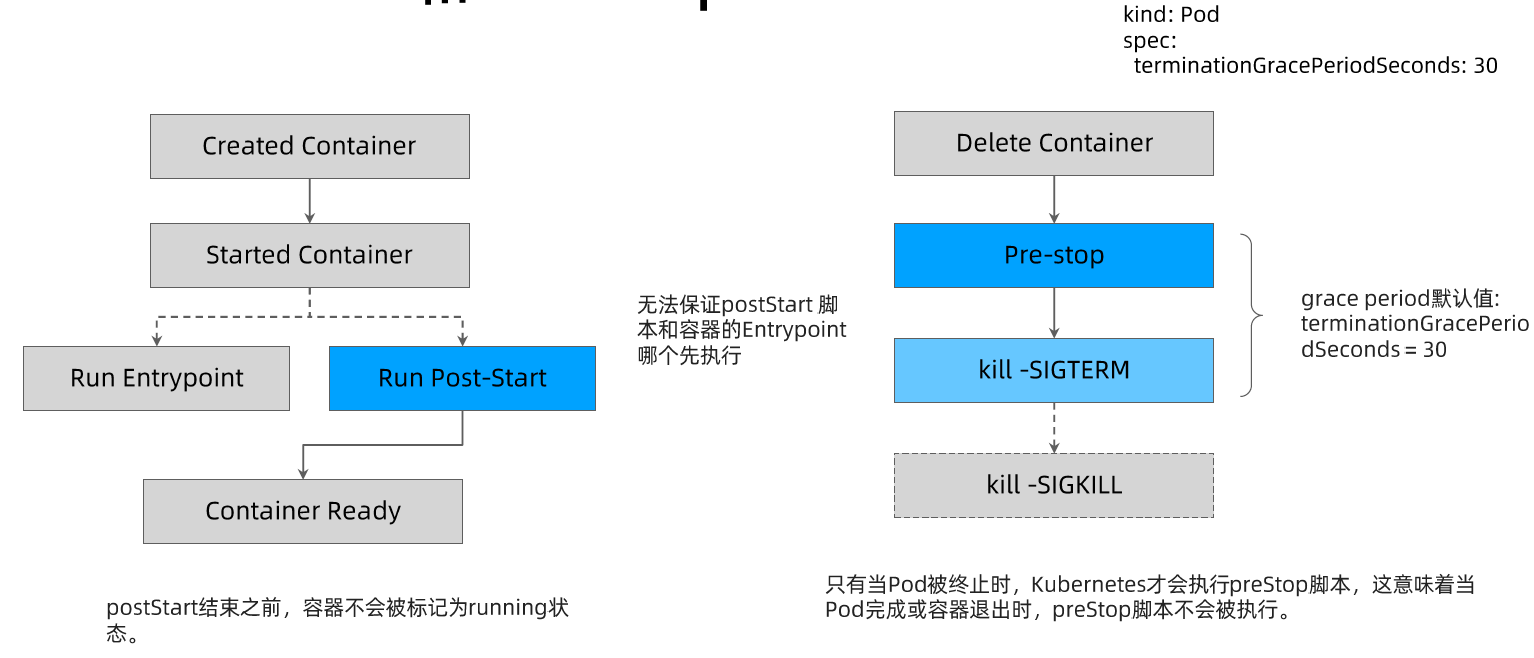

memory: "128Mi"健康检查

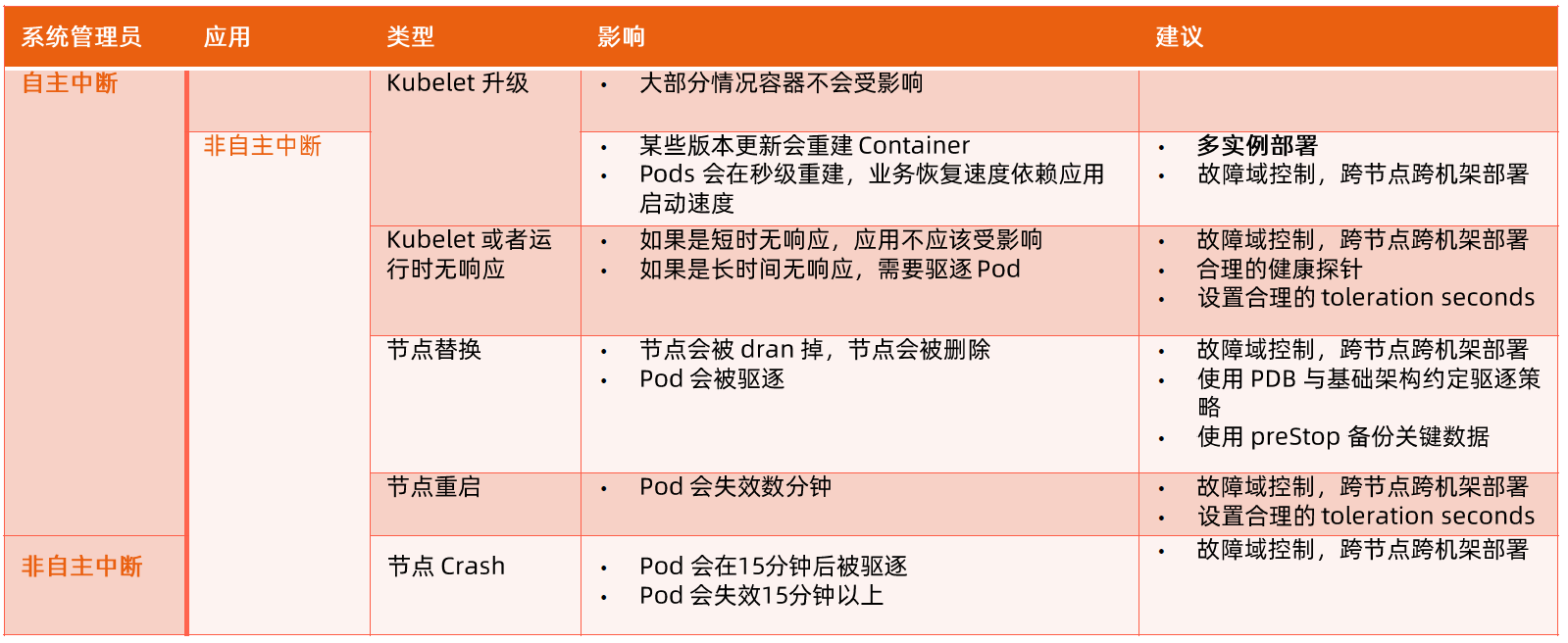

Kubernetes 作为一个面向应用的集群管理工具,需要确保容器在部署后确实处在正常的运行状态。

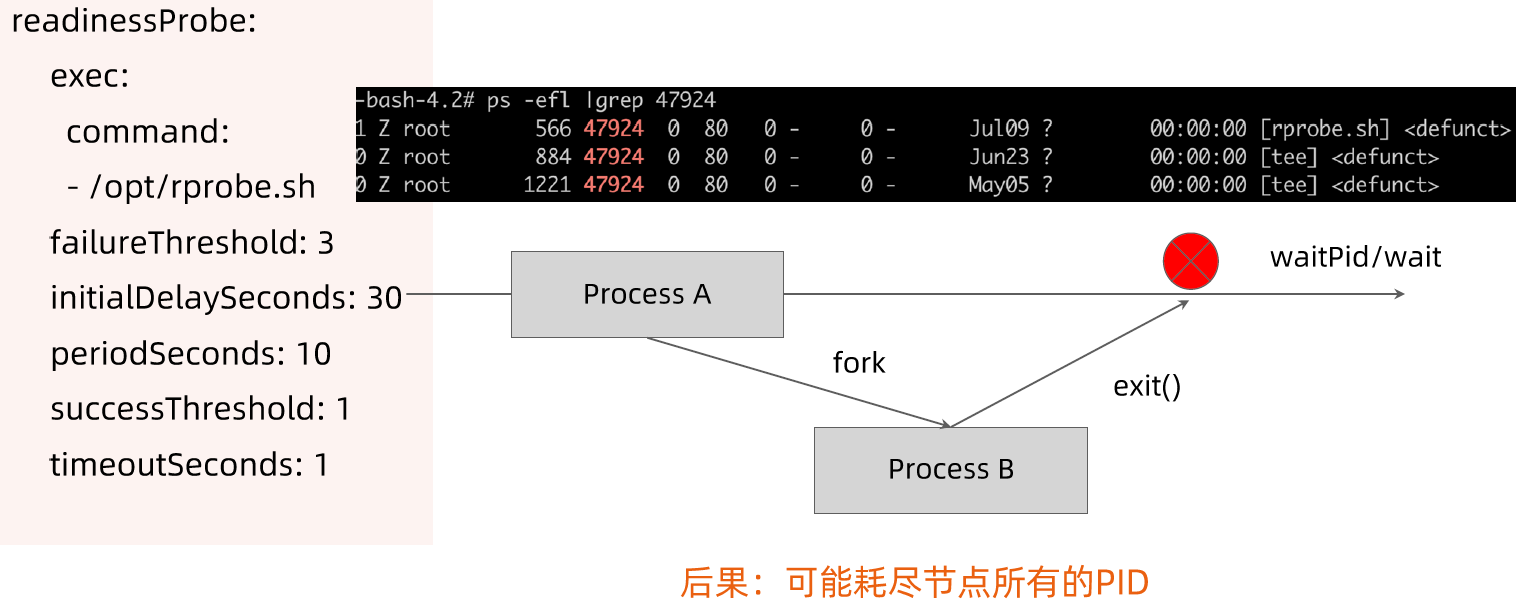

- 探针类型:

- LivenessProbe

- 探测应用是否处于健康状态,如果不健康则删除并重新创建容器。

- ReadinessProbe

- 探测应用是否就绪并且处于正常服务状态,如果不正常则不会接收来自 Kubernetes Service 的流量。

- StartupProbe

- 探测应用是否启动完成,如果在

failureThreshold * periodSeconds周期内未就绪,则会应用进程会被重启。

- 探测应用是否启动完成,如果在

- 探活方式:

- Exec

- TCP socket

- HTTP

ConfigMap

- ConfigMap 用来将非机密性的数据保存到键值对中。

- 使用时, Pods 可以将其用作环境变量、命令行参数或者存储卷中的配置文件。

- ConfigMap 将环境配置信息和容器镜像解耦,便于应用配置的修改。

密钥对象(Secret)

- Secret 是用来保存和传递密码、密钥、认证凭证这些敏感信息的对象。

- 使用 Secret 的好处是可以避免把敏感信息明文写在配置文件里。

- Kubernetes 集群中配置和使用服务不可避免的要用到各种敏感信息实现登录、认证等功能,例\如访问 AWS 存储的用户名密码。

- 为了避免将类似的敏感信息明文写在所有需要使用的配置文件中,可以将这些信息存入一个 Secret 对象,而在配置文件中通过 Secret 对象引用这些敏感信息。

- 这种方式的好处包括:意图明确,避免重复,减少暴漏机会。

用户(User Account)& 服务帐户(Service Account)

- 顾名思义,用户帐户为人提供账户标识,而服务账户为计算机进程和 Kubernetes 集群中运行的 Pod 提供账户标识。

- 用户帐户和服务帐户的一个区别是作用范围:

- 用户帐户对应的是人的身份,人的身份与服务的 Namespace 无关,所以用户账户是跨 Namespace 的;

- 而服务帐户对应的是一个运行中程序的身份,与特定 Namespace 是相关的。

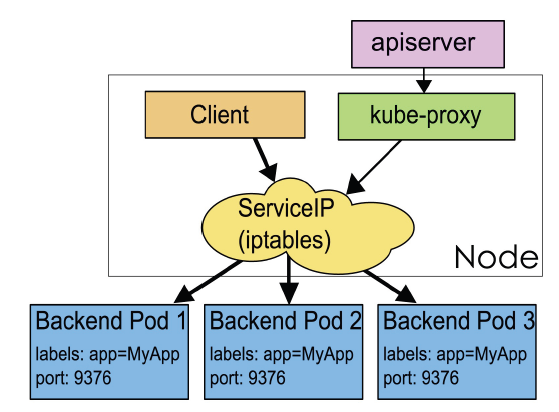

Service

Service 是应用服务的抽象,通过 labels 为应用提供负载均衡和服务发现。匹配 labels 的 Pod IP 和端口列表组成 endpoints,由 Kube-proxy 负责将服务 IP 负载均衡到这些 endpoints 上。

每个 Service 都会自动分配一个 cluster IP(仅在集群内部可访问的虚拟地址)和 DNS 名,其他容器可以通过该地址或 DNS 来访问服务,而不需要了解后端容器的运行。

apiVersion: v1

kind: Service

metadata:

name: nginx

spec:

ports:

- port: 8078 # the port that this service should serve on

name: http

# the container on each pod to connect to, can be a name

# (e.g. 'www') or a number (e.g. 80)

targetPort: 80

protocol: TCP

selector:

app: nginx副本集(Replica Set)

- Pod 只是单个应用实例的抽象,要构建高可用应用,通常需要构建多个同样的副本,提供同一个服务。

- Kubernetes 为此抽象出副本集 ReplicaSet,其允许用户定义 Pod 的副本数,每一个 Pod 都会被当作一个无状态的成员进行管理,Kubernetes 保证总是有用户期望的数量的 Pod 正常运行。

- 当某个副本宕机以后,控制器将会创建一个新的副本。

- 当因业务负载发生变更而需要调整扩缩容时,可以方便地调整副本数量。

RS 创建出来的名字分为三个部分,如:nginx-deploy-59dc7f9d89-k9rj9

- 第一个部分

nginx-deploy是 deployment 的名字。 - 第二个部分

59dc7f9d89是配置字符串的 hash 值。 - 第三个部分

k9rj9是随机值,因为是无状态的,所以给任何值都是可以的。

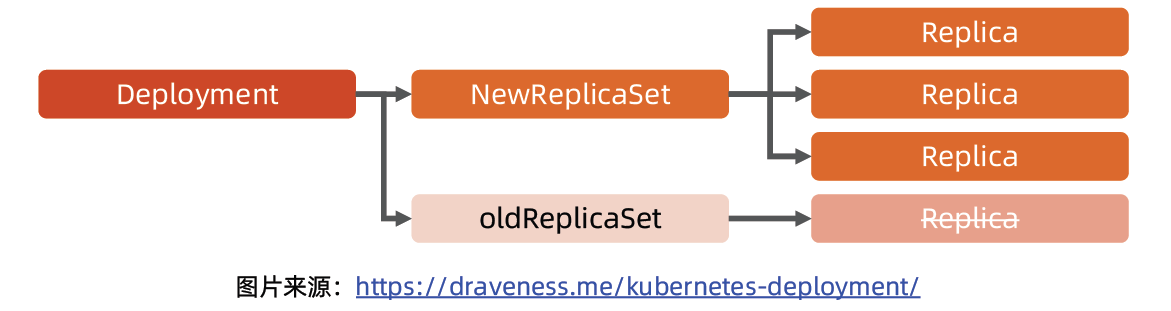

部署(Deployment)

- 部署表示用户对 Kubernetes 集群的一次更新操作。

- 部署是一个比 RS 应用模式更广的 API 对象,可以是创建一个新的服务,更新一个新的服务,也可以是滚动升级一个服务。

- 滚动升级一个服务,实际是创建一个新的 RS,然后逐渐将新 RS 中副本数增加到理想状态,将旧 RS 中的副本数减小到 0 的复合操作。

- 这样一个复合操作用一个 RS 是不太好描述的,所以用一个更通用的 Deployment 来描述。

- 以 Kubernetes 的发展方向,未来对所有长期伺服型的的业务的管理,都会通过 Deployment 来管理。

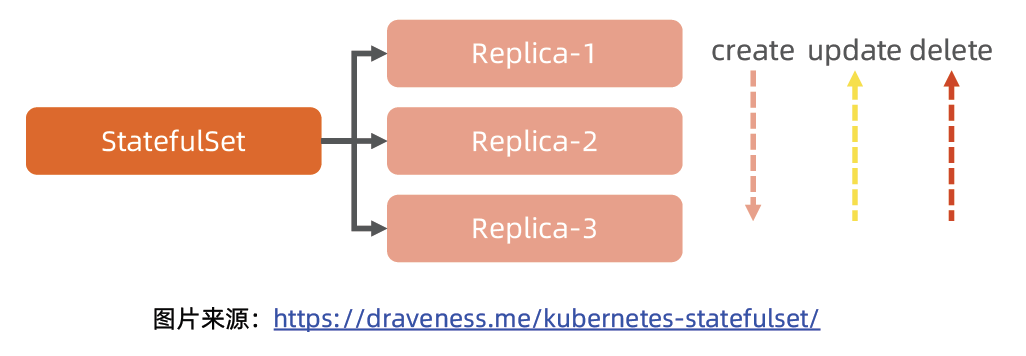

有状态服务集(StatefulSet)

- 对于 StatefulSet 中的 Pod,每个 Pod 挂载自己独立的存储,如果一个 Pod 出现故障,从其他节点启动一个同样名字的 Pod,要挂载上原来 Pod 的存储继续以它的状态提供服务。

- 适合于 StatefulSet 的业务包括数据库服务 MySQL 和 PostgreSQL,集群化管理服务 ZooKeeper、etcd 等有状态服务。

- 使用 StatefulSet,Pod 仍然可以通过漂移到不同节点提供高可用,而存储也可以通过外挂的存储来提供高可靠性,StatefulSet 做的只是将确定的 Pod 与确定的存储关联起来保证状态的连续性。

Statefulset 与Deployment 的差异

- 身份标识

- StatefulSet Controller 为每个 Pod 编号,序号从 0 开始。

- 数据存储

- StatefulSet 允许用户定义volumeClaimTemplates,Pod 被创建的同时,Kubernetes 会以 volumeClaimTemplates 中定义的模板创建存储卷,并挂载给Pod。

- StatefulSet 的升级策略不同

- onDelete

- 滚动升级

- 分片升级

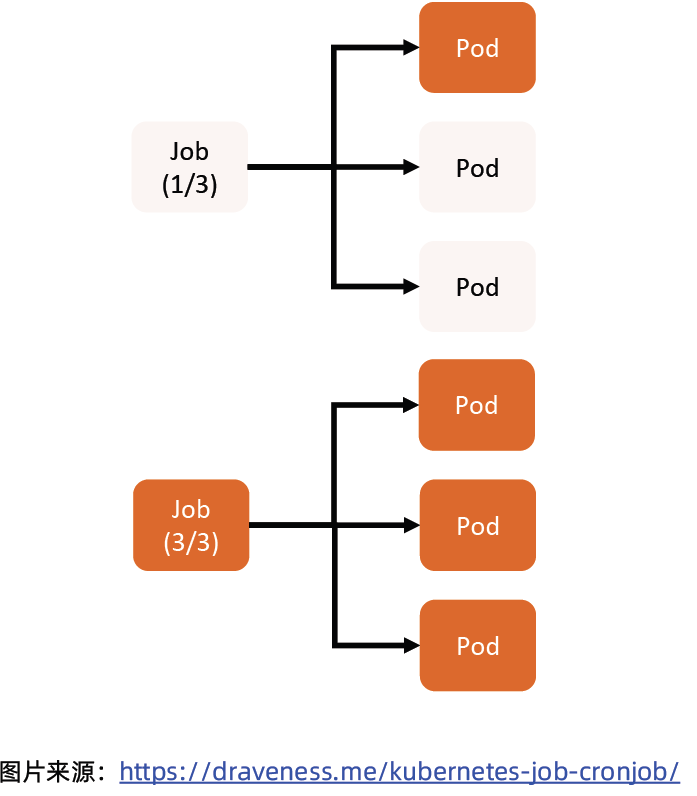

任务(Job)

- Job 是 Kubernetes 用来控制批处理型任务的 API 对象。

- Job 管理的 Pod 根据用户的设置把任务成功完成后就自动退出。

- 成功完成的标志根据不同的 spec.completions 策略而不同:

- 单 Pod 型任务有一个 Pod 成功就标志完成;

- 定数成功型任务保证有 N 个任务全部成功;

- 工作队列型任务根据应用确认的全局成功而标志成功。

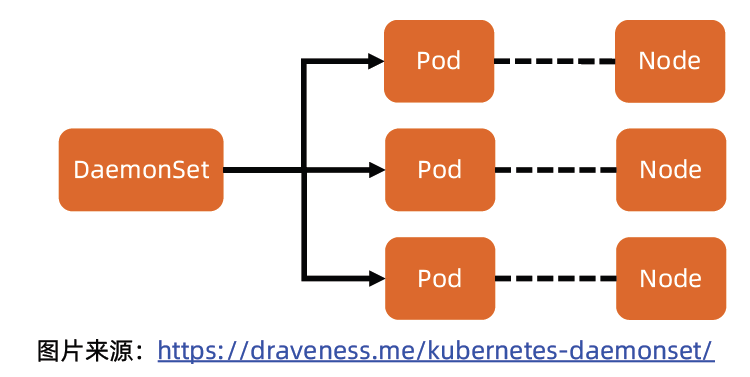

后台支撑服务集(DaemonSet)

- 长期伺服型和批处理型服务的核心在业务应用,可能有些节点运行多个同类业务的 Pod,有些节点上又没有这类 Pod 运行;

- 而后台支撑型服务的核心关注点在 Kubernetes 集群中的节点(物理机或虚拟机),要保证每个节点上都有一个此类 Pod 运行。

- 节点可能是所有集群节点也可能是通过 nodeSelector 选定的一些特定节点。

- 典型的后台支撑型服务包括存储、日志和监控等在每个节点上支撑 Kubernetes 集群运行的服务。

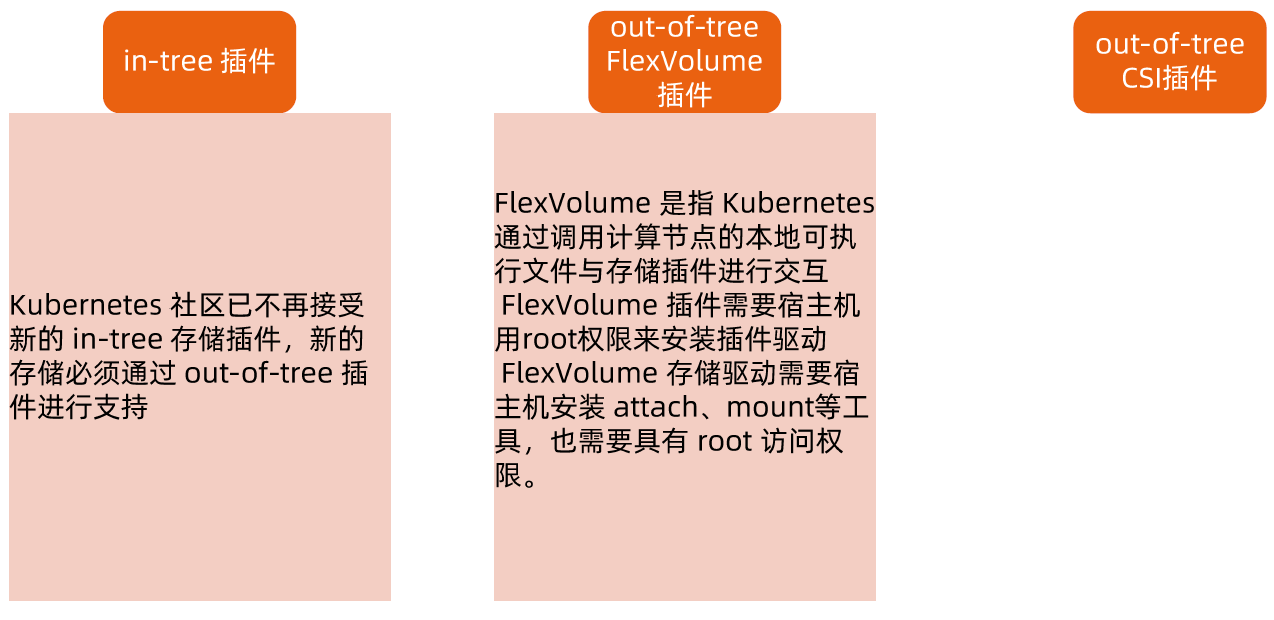

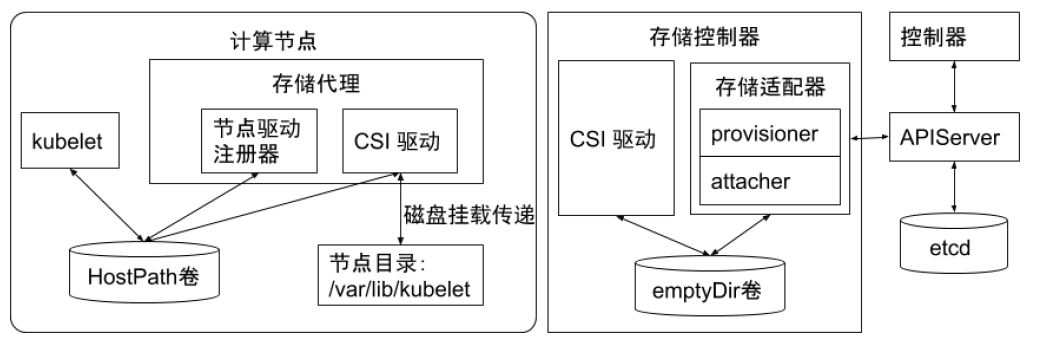

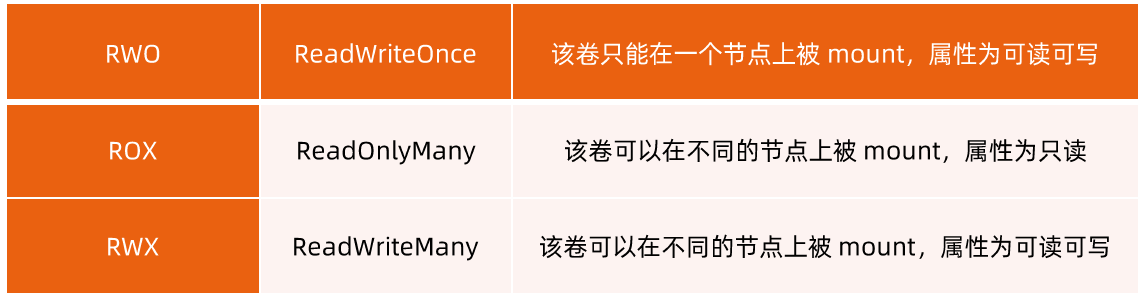

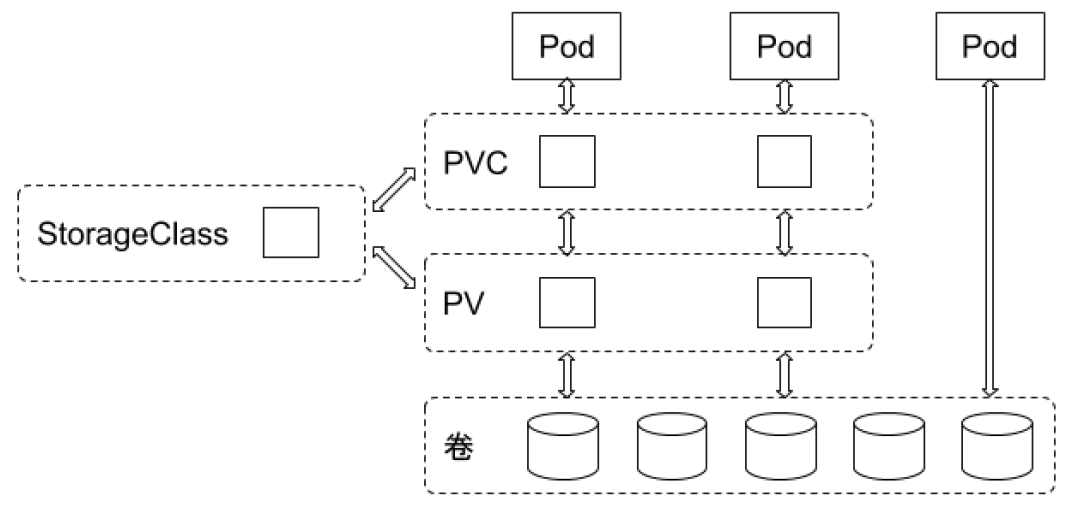

存储 PV 和 PVC

- PersistentVolume(PV)是集群中的一块存储卷,可以由管理员手动设置,或当用户创建 PersistentVolumeClaim(PVC)时根据 StorageClass 动态设置。

- PV 和 PVC 与 Pod 生命周期无关。也就是说,当 Pod 中的容器重新启动、Pod 重新调度或者删除时,PV 和 PVC 不会受到影响,Pod 存储于 PV 里的数据得以保留。

- 对于不同的使用场景,用户通常需要不同属性(例如性能、访问模式等)的 PV。

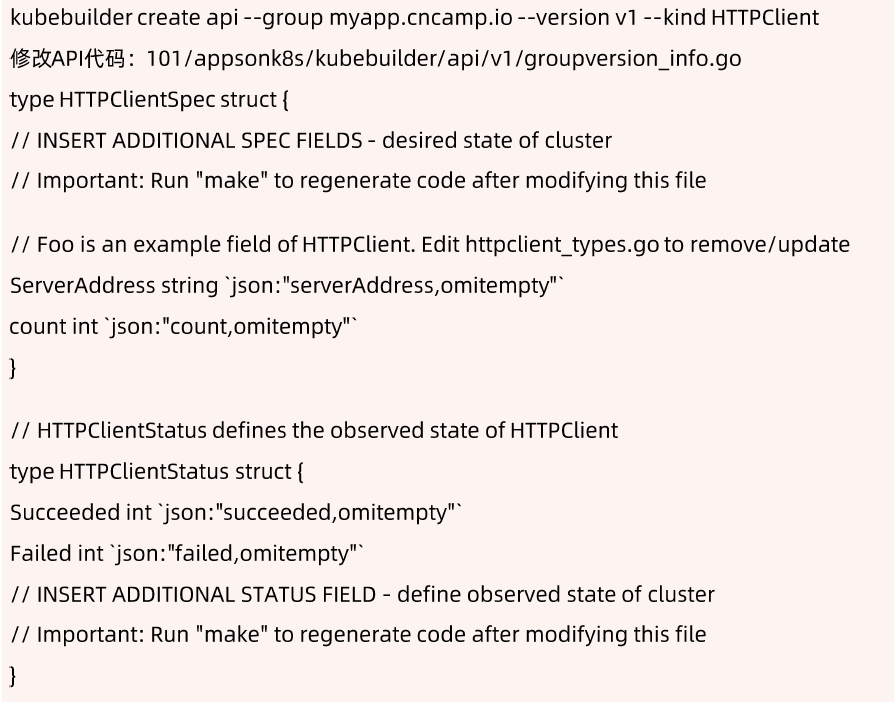

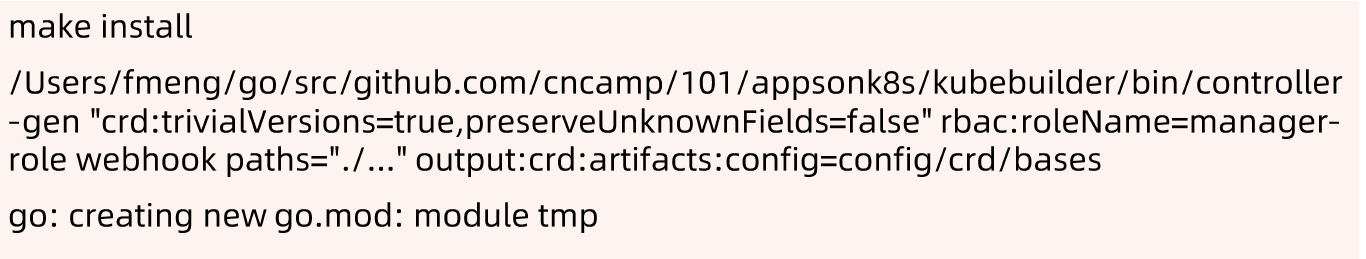

CustomResourceDefinition

- CRD 就像数据库的开放式表结构,允许用户自定义 Schema。

- 有了这种开放式设计,用户可以基于 CRD 定义一切需要的模型,满足不同业务的需求。

- 社区鼓励基于 CRD 的业务抽象,众多主流的扩展应用都是基于 CRD 构建的,比如 Istio、Knative。

- 甚至基于 CRD 推出了 Operator Mode 和 Operator SDK,可以以极低的开发成本定义新对象,并构建新对象的控制器。

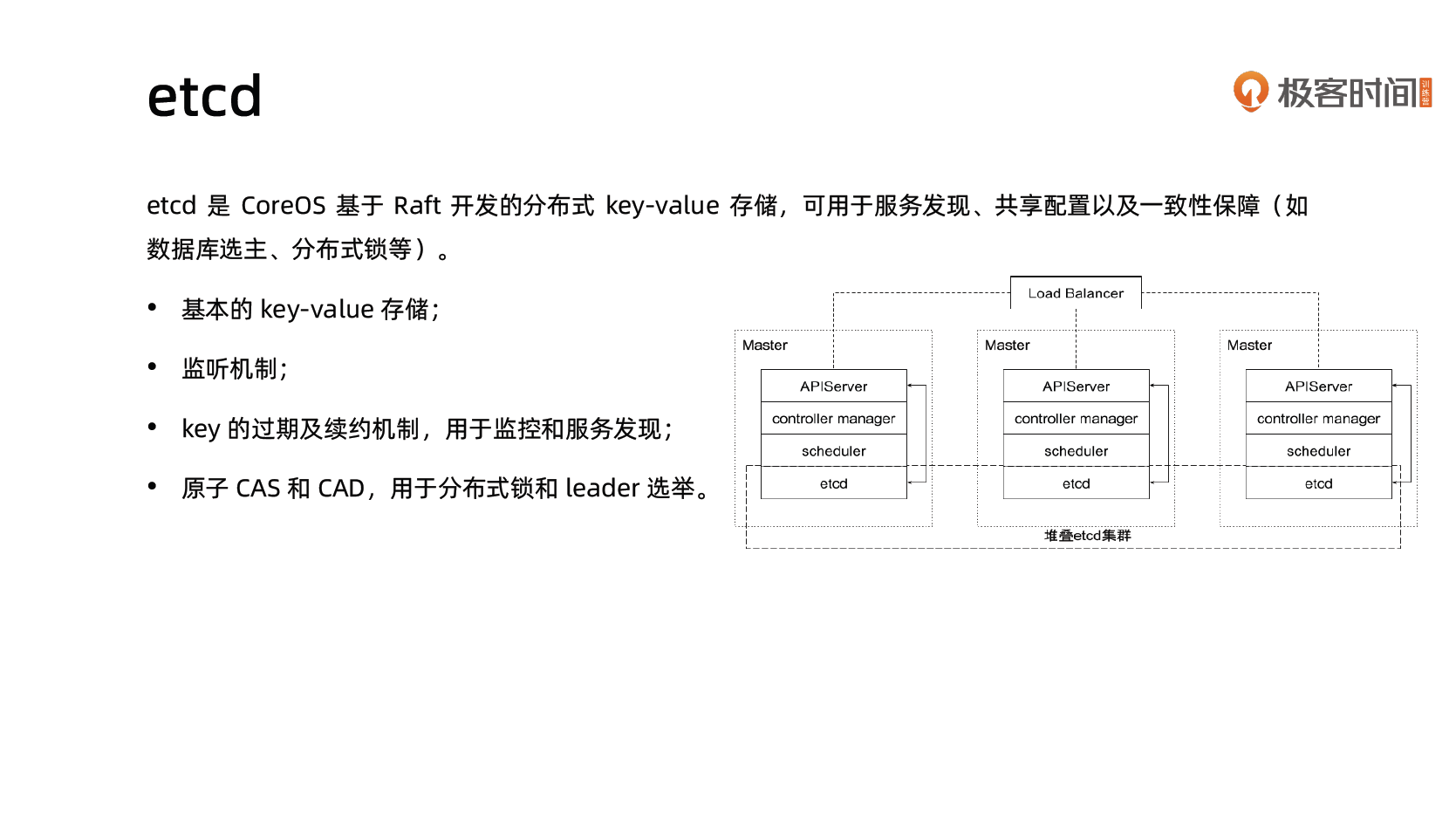

Kubernetes 控制平面组件 etcd

etcd

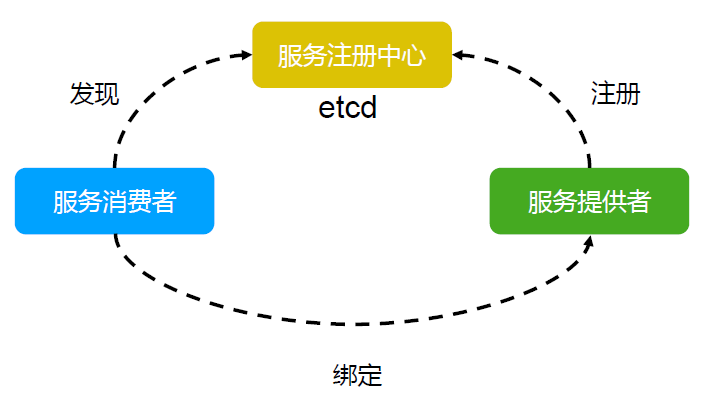

Etcd是 CoreOS 基于 Raft 开发的分布式 key value 存储,可用于服务发现、共享配置以及一致性保障(如数据库选主、分布式锁等)。

在分布式系统中,如何管理节点间的状态一直是一个难题,etcd 像是专门为集群环境的服务发现和注册而设计,它提供了数据 TTL 失效、数据改变监视、多值、目录监听、分布式锁原子操作等功能,可以方便的跟踪并管理集群节点的状态。

- 键值对存储:将数据存储在分层组织的目录中,如同在标准文件系统中

- 监测变更:监测特定的键或目录以进行更改,并对值的更改做出反应

- 简单 curl 可访问的用户的 API HTTP+JSON

- 安全 : 可选的 SSL 客户端证书认证

- 快速 : 单实例每秒 1000 次写操作, 2000+ 次读操作

- 可靠 : 使用 Raft 算法保证一致性

主要功能

- 基本的 key value 存储

- 监听机制

- key 的过期及续约机制,用于监控和服务发现

- 原子 Compare And Swap 和 Compare And Delete ,用于分布式锁和 leader 选举

使用场景

- 也可以用于键值对存储,应用程序可以读取和写入 etcd 中的数据

- etcd 比较多的应用场景是用于服务注册与发现

- 基于监听机制的分布式异步系统

键值对存储

etcd 是一个 键值存储 的组件,其他的应用都是基于其键值存储的功能展开。

- 采用 kv 型数据存储,一般情况下比关系型数据库快。

- 支持动态存储(内存)以及静态存储(磁盘)。

- 分布式存储,可集成为多节点集群。

- 存储方式,采用类似目录结构。(B+tree)

- 只有叶子节点才能真正存储数据,相当于文件。

- 叶子节点的父节点一定是目录,目录不能存储数据。

服务注册与发现

- 强一致性、高可用的服务存储目录。

- 基于 Raft 算法的 etcd 天生就是这样一个强一致性、高可用的服务存储目录。

- 一种注册服务和服务健康状况的机制。

- 用户可以在 etcd 中注册服务,并且对注册的服务配置 key TTL 定时保持服务的心跳以达到监控健康状态的效果。

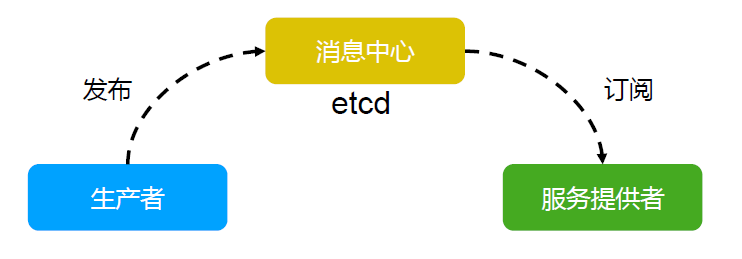

消息发布与订阅

- 在分布式系统中,最适用的一种组件间通信方式就是消息发布与订阅。

- 即构建一个配置共享中心,数据提供者在这个配置中心发布消息,而消息使用者则订阅他们关心的主题,一旦主题有消息发布,就会实时通知订阅者。

- 通过这种方式可以做到分布式系统配置的集中式管理与动态更新。

- 应用中用到的一些配置信息放到 etcd 上进行集中管理。

- 应用在启动的时候主动从 etcd 获取一次配置信息,同时,在 etcd 节点上注册一个 Watcher 并等待,以后每次配置有更新的时候, etcd 都会实时通知订阅者,以此达到获取最新配置信息的目的。

etcd 练习

查看集群成员状态

$ etcdctl member list write out=table

+------------------+---------+----------+---------------------------+---------------------------+------------+

| ID | STATUS | NAME | PEER ADDRS | CLIENT ADDRS | IS LEARNER |

+------------------+---------+----------+---------------------------+---------------------------+------------+

| aec36adc501070cc | started | minikube | https://192.168.49.2:2380 | https://192.168.49.2:2379 | false |

+------------------+---------+----------+---------------------------+---------------------------+------------+

# 写

$ etcdctl put /a b

OK

# 读

$ etcdctl get /a

/a

b

$ etcdctl get /a -wjson

{

"header": {

"cluster_id": 18038207397139143000,

"member_id": 12593026477526643000,

"revision": 23279, // 全局唯一的 revision, 每当 etcd 中有数据修改时,这个记录就会 +1

"raft_term": 4

},

"kvs": [

{

"key": "L2E=",

"create_revision": 11164, // key 创建时 revision 的值

"mod_revision": 11164, // key 上次修改时 revision 的值

"version": 1,

"value": "Yg=="

}

],

"count": 1

}

# 按 key 的前缀查询数据

$ etcdctl get --prefix /

$ etcdctl get --prefix / --keys-only --debug核心:TTL & CAS

TTL(time to live)指的是给一个 key 设置一个有效期,到期后这个 key 就会被自动删掉,这在很多分布式锁的实现上都会用到,可以保证锁的实时有效性。

Atomic Compare and Swap(CAS)指的是在对 key 进行赋值的时候,客户端需要提供一些条件,当这些条件满足后,才能赋值成功。这些条件包括:

- prevExist key 当前赋值前是否存在

- prevValue key 当前赋值前的值

- prevIndex key 当前赋值前的 Index

这样的话,key 的设置是有前提的,需要知道这个 key 当前的具体情况才可以对其设置。

Raft 协议

Raft 协议概览

Raft 协议基于 quorum 机制,即大多数同意原则,任何的变更都需超过半数的成员确认

理解 Raft 协议

http://thesecretlivesofdata.com/raft/

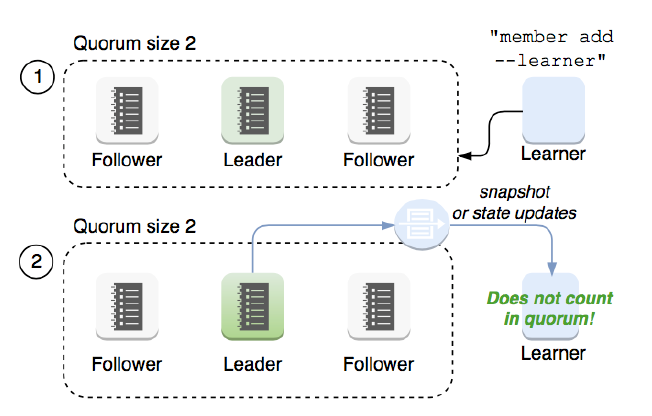

learner

Raft 4.2.1 引入的新角色

当出现一个 etcd 集群 需要增加节点 时 ,新节点与 Leader 的数据差异较大,需要较多数据同步才能跟上 leader 的最新的数据。

此时 Leader 的网络带宽很可能被用尽,进而使得 leader 无法正常保持心跳。

进而导致 follower 重新发起投票 。

进而可能引发 etcd 集群不可用 。

Learner 角色只接收数据而不参与投票 ,因此增加 learner 节点时,集群的 quorum 不变 。

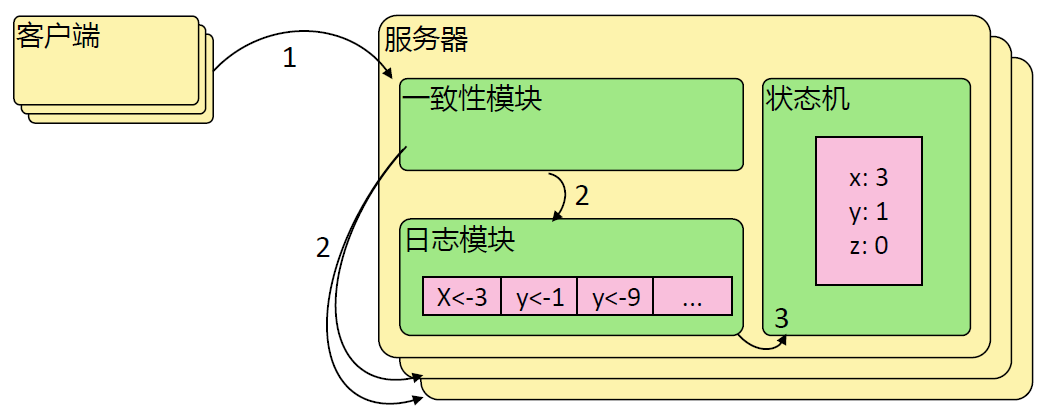

etcd 基于 Raft 的一致性

选举方法

- 初始启动时,节点处于 follower 状态并被设定一个 election timeout ,如果在这一时间周期内没有收到来自 leader 的 heartbeat ,节点将发起选举:将自己切换为 candidate 之后,向集群中其它 follower 节点发送请求,询问其是否选举自己成为 leader 。

- 当收到来自集群中过半数节点的接受投票后,节点即成为 leader ,开始接收保存 client 的数据并向其它的 follower 节点同步日志。如果没有达成一致,则 candidate 随机选择一个等待间隔( 150ms ~ 300ms )再次发起投票,得到集群中半数以上 follower 接受的 candidate 将成为 leader

- leader 节点依靠定时向 follower 发送 heartbeat 来保持其地位。

- 任何时候如果其它 follower 在 election timeout 期间都没有收到来自 leader 的 heartbeat ,同样会将自己的状态切换为 candidate 并发起选举。每成功选举一次,新 leader 的任期( Term )都会比之前 leader 的任期大 1 。

日志复制

当接 Leader 收到客户端的日志(事务请求)后先把该日志追加到本地的 Log 中,然后通过 heartbeat 把该 Entry 同步给其他 Follower Follower 接收到日志后记录日志然后向 Leader 发送 ACK ,当 Leader 收到大多数( n/2+1 Follower 的 ACK 信息后将该日志设置为已提交并追加到本地磁盘中,通知客户端并在下个 heartbeat 中 Leader 将通知所有的 Follower 将该日志存储在自己的本地磁盘中。

安全性

安全性是用于保证每个节点都执行相同序列的安全机制,如当某个 Follower 在当前 Leader commit Log 时变得不可用了,稍后可能该 Follower 又会被选举为 Leader ,这时新 Leader 可能会用新的 Log 覆盖先前已 committed 的 Log ,这就是导致节点执行不同序列 Safety 就是用于保证选举出来的 Leader 一定包含先前 committed Log 的机制;

选举安全性(Election Safety ):每个任期(Term)只能选举出一个 Leader

Leader完整性( Leader Completeness ):指 Leader 日志的完整性,当 Log 在任期 Term1 被 Commit 后,那么以后任期 Term2 、 Term3… 等的 Leader 必须包含该 Log Raft 在选举阶段就使用 Term 的判断用于保证完整性:当请求投票的该 Candidate 的 Term 较大或 Term 相同 Index 更大则投票,否则拒绝该请求。

失效处理

- Leader 失效:其他没有收到 heartbeat 的节点会发起新的选举,而当 Leader 恢复后由于步进数小会自动成为 follower (日志也会被新 leader 的日志覆盖)

- follower 节点不可用: follower 节点不可用的情况相对容易解决。因为集群中的日志内容始终是从 leader 节点同步的,只要这一节点再次加入集群时重新从 leader 节点处制日志即可。

- 多个 candidate :冲突后 candidate 将随机选择一个等待间隔( 150ms ~ 300ms )再次发起投票,得到集群中半数以上 follower 接受的 candidate 将成为 leader

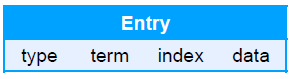

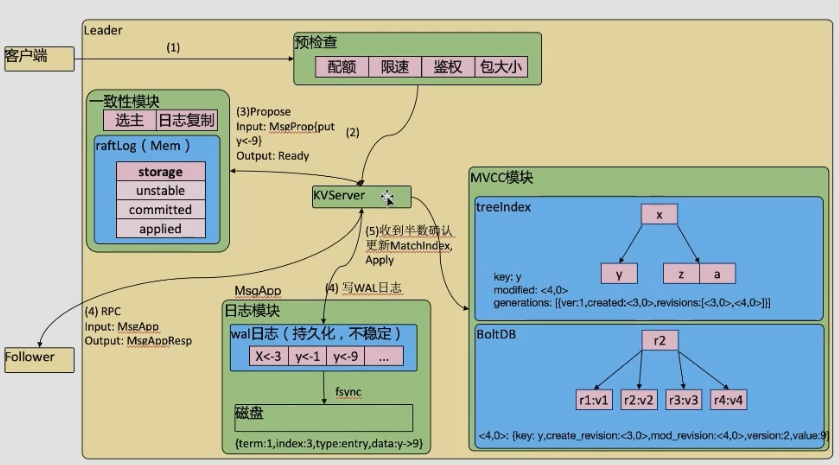

wal 日志

wal 日志是二进制的,解析出来后是以上数据结构 LogEntry 。其中第一个字段 type ,只有两种。一种是 0 表示 Normal 1 表示 ConfChange ConfChange 表示 Etcd 本身的配置变更同步,比如有新的节点加入等)。第二个字段是 term ,每个 term 代表一个主节点的任期,每次主节点变更 term 就会变化。第三个字段是 index ,这个序号是严格有序递增的,代表变更序号。第四个字段是二进制的 data ,将 raft request 对象的 pb 结构整个保存下。 etcd 源码下有个 tools/etcd dump logs ,可以将 wal 日志 dump 成文本查看,可以协助分析 Raft 协议。

Raft 协议本身不关心应用数据,也就是 data 中的部分,一致性都通过同步 wal 日志来实现,每个节点将从主节点收到的 data apply 到本地的存储, Raft 只关心日志的同步状态,如果本地存储实现的有 bug ,比如没有正确的将 data apply 到本地,也可能会导致数据不一致。

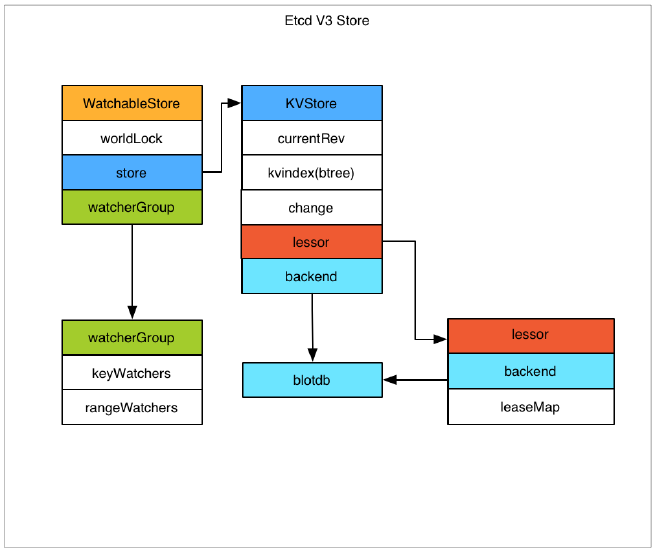

etcd v3 存储

存储机制

etcd v3 store 分为两部分,一部分是内存中的索引, kvindex ,是基于 Google 开源的一个 Golang 的 btree 实现的,另外一部分是后端存储。按照它的设计, backend 可以对接多种存储,当前使用的 boltdb 。 boltdb 是一个单机的支持事务的 kv 存储, etcd 的事务是基于 boltdb 的事务实现的。 etcd 在 boltdb 中存储的 key 是 reversion value 是 etcd 自己的 key value 组合,也就是说 etcd 会在 boltdb 中把每个版本都保存下,从而实现了多版本机制。

reversion 主要由两部分组成,第一部分 main rev ,每次事务进行加一,第二部分 sub rev ,同一个事务中的每次操作加一。

etcd 提供了命令和设置选项来控制 compact ,同时支持 put 操作的参数来精确控制某个 key 的历史版本数。

内存 kvindex 保存的就是 key 和 reversion 之前的映射关系,用来加速查询。

每个 Etcd node 都有这些模块。

只有 Leader 能写,即使是 Follower 收到写请求,在做完 “预检查” 后,也会把请求转给 Leader。

Leader 收到请求后,先把修改放到

unstable,等收到超过半数的 Node 确认后移动到committed,最后把修改应用到内存中的 MVCC 模块后才会挪到applied。只有存在在 MVCC 模块中的数据才能被客户端查询到。

Watch 机制

etcd v3 的 watch 机制支持 watch 某个固定的 key ,也支持 watch 一个范围(可以用于模拟目录的结构的 watch ),所以 watchGroup 包含两种 watcher ,一种是 key watchers ,数据结构是每个 key 对应一组 watcher ,另外一种是 range watchers, 数据结构是一个 IntervalTree ,方便通过区间查找到对应的 watcher 。

同时,每个 WatchableStore 包含两种 watcherGroup ,一种是 synced ,一种是 unsynced 前者表示该 group 的 watcher 数据都已经同步完毕,在等待新的变更,后者表示该 group 的 watcher 数据同步落后于当前最新变更,还在追赶。

当 etcd 收到客户端的 watch 请求,如果请求携带了 revision 参数,则比较请求的 revision 和 store 当前的 revision ,如果大于当前 revision ,则放入 synced 组中,否则放入 unsynced 组。同时 etcd 会启动一个后台的 goroutine 持续同步 unsynced 的 watcher ,然后将其迁移到 synced 组。也就是这种机制下, etcd v3 支持从任意版本开始 watch ,没有 v2 的 1000 条历史 event 表限制的问题(当然这是指没有 compact 的情况下)

etcd 重要参数

成员相关参数

--name 'default'

Human-readable name for this member.

--data-dir '${name}.etcd'

Path to the data directory.

--listen-peer-urls 'http://localhost:2380'

List of URLs to listen on for peer traffic.

--listen-client-urls 'http://localhost:2379'

List of URLs to listen on for client grpc traffic and http as long as --listen-client-http-urls is not specified.

集群相关参数

--initial-advertise-peer-urls 'http://localhost:2380'

List of this member's peer URLs to advertise to the rest of the cluster.

--initial-cluster 'default=http://localhost:2380'

Initial cluster configuration for bootstrapping.

--initial-cluster-state 'new'

Initial cluster state ('new' when bootstrapping a new cluster or 'existing' when adding new members to an existing cluster).

After successful initialization (bootstrapping or adding), flag is ignored on restarts.

--initial-cluster-token 'etcd-cluster'

Initial cluster token for the etcd cluster during bootstrap.

Specifying this can protect you from unintended cross-cluster interaction when running multiple clusters.

--advertise-client-urls 'http://localhost:2379'

List of this member's client URLs to advertise to the public.

The client URLs advertised should be accessible to machines that talk to etcd cluster. etcd client libraries parse these URLs to connect to the cluster.

安全相关参数

--cert-file ''

Path to the client server TLS cert file.

--key-file ''

Path to the client server TLS key file.

--client-crl-file ''

Path to the client certificate revocation list file.

--trusted-ca-file ''

Path to the client server TLS trusted CA cert file.

--peer-cert-file ''

Path to the peer server TLS cert file.

--peer-key-file ''

Path to the peer server TLS key file.

--peer-trusted-ca-file ''

Path to the peer server TLS trusted CA file.灾备

创建 Snapshot:

etcdctl snapshot save snapshot.db恢复数据

etcdctl snapshot restore snapshot.db \

--name infra2 \

--data-dir=/tmp/etcd/infra2 \

--initial-cluster infra0=http://127.0.0.1:3380,infra1=http://127.0.0.1:4380,infra2=http://127.0.0.1:5380 \

--initial-cluster-token etcd-cluster-1 \

--initial-advertise-peer-urls http://127.0.0.1:5380容量管理

- 单个对象不建议超过 1.5M

- 默认容量 2G

- 不建议超过 8G

Alarm & Disarm Alarm

设置 etcd 存储大小

etcd --quota-backend-bytes=$((16*1024*1024))写爆磁盘

while [ 1 ]; do dd if=/dev/urandom bs=1024 count=1024 | ETCDCTL_API=3 etcdctl put key || break; done查看 endpoint 状态

ETCDCTL_API=3 etcdctl --write-out=table endpoint status查看 alarm

ETCDCTL_API=3 etcdctl alarm list清理碎片

ETCDCTL_API=3 etcdctl defrag清理 alarm

ETCDCTL_API=3 etcdctl alarm disarm碎片整理

Keep one hour of history

etcd --auto-compaction-retention=1Compact up to revision 3

$ etcdctl compact 3

$ etcdctl defrag

Finished defragmenting etcd member[127.0.0.1:2379]高可用 etcd 解决方案

https://github.com/cncamp/101/tree/master/module5/etcd-ha-demo

etcd operator: coreos 开源的 ,基于 kubernetes CRD 完成 etcd 集群配置。 Archived

https://github.com/coreos/etcd-operator

Etcd statefulset Helm chart: Bitnami (powered by vmware )

https://bitnami.com/stack/etcd/helm

https://github.com/bitnami/charts/blob/master/bitnami/etcd

Kubernetes 如何使用 etcd

etcd 是 kubernetes 的后端存储

对于每一个 kubernetes Object ,都有对应的 storage.go 负责对象的存储操作 pkg/registry/core/pod/storage/storage.go

API server 启动脚本中指定 etcd servers 集群

spec:

containers:

- command:

- etcd

- --advertise-client-urls=https://192.168.34.2:2379

- --cert-file=/etc/kubernetes/pki/etcd/server.crt

- --client-cert-auth=true

- --data-dir=/var/lib/etcd

- --initial-advertise-peer-urls=https://192.168.34.2:2380

- --initial-cluster=cadmin=https://192.168.34.2:2380

- --key-file=/etc/kubernetes/pki/etcd/server.key

- --listen-client-urls=https://127.0.0.1:2379,https://192.168.34.2:2379

- --listen-metrics-urls=http://127.0.0.1:2381

- --listen-peer-urls=https://192.168.34.2:2380

- --name=cadmin

- --peer-cert-file=/etc/kubernetes/pki/etcd/peer.crt

- --peer-client-cert-auth=true

- --peer-key-file=/etc/kubernetes/pki/etcd/peer.key

- --peer-trusted-ca-file=/etc/kubernetes/pki/etcd/ca.crt

- --snapshot-count=10000

- --trusted-ca-file=/etc/kubernetes/pki/etcd/ca.crt早期 API server 对 etcd 做简单的 Ping check ,现在已经改为真实的 etcd api call

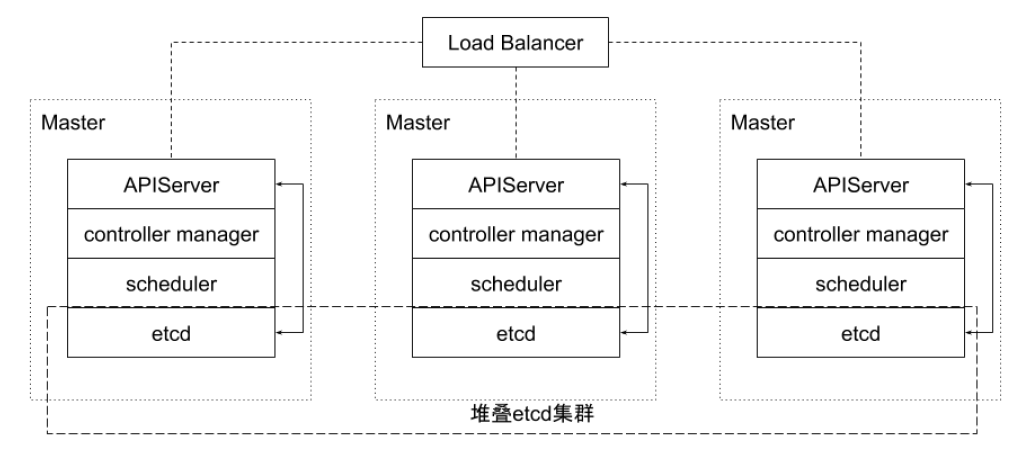

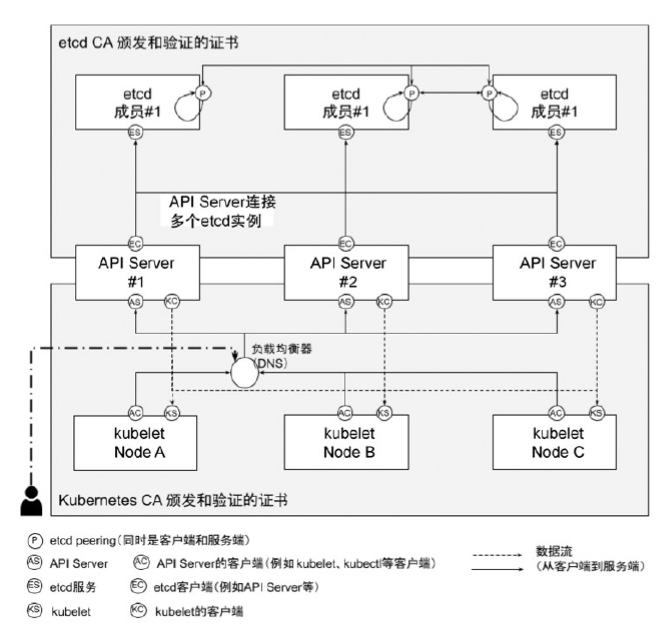

etcd 在集群中所处的位置

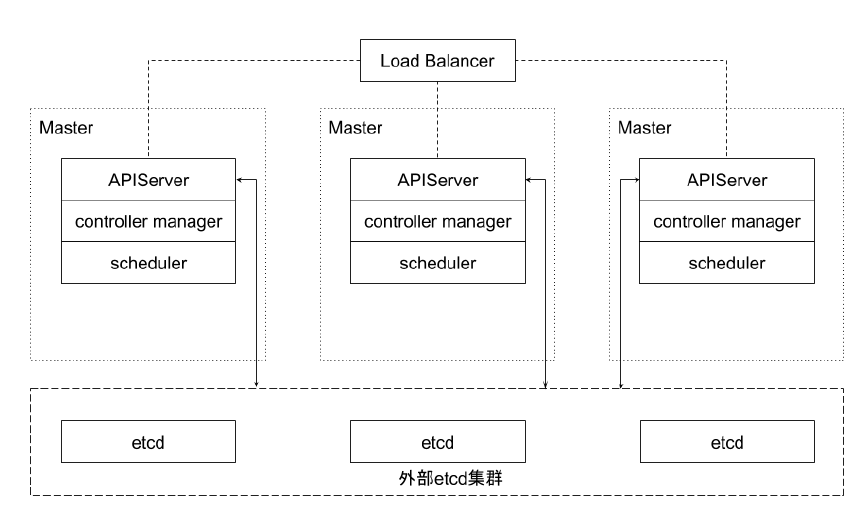

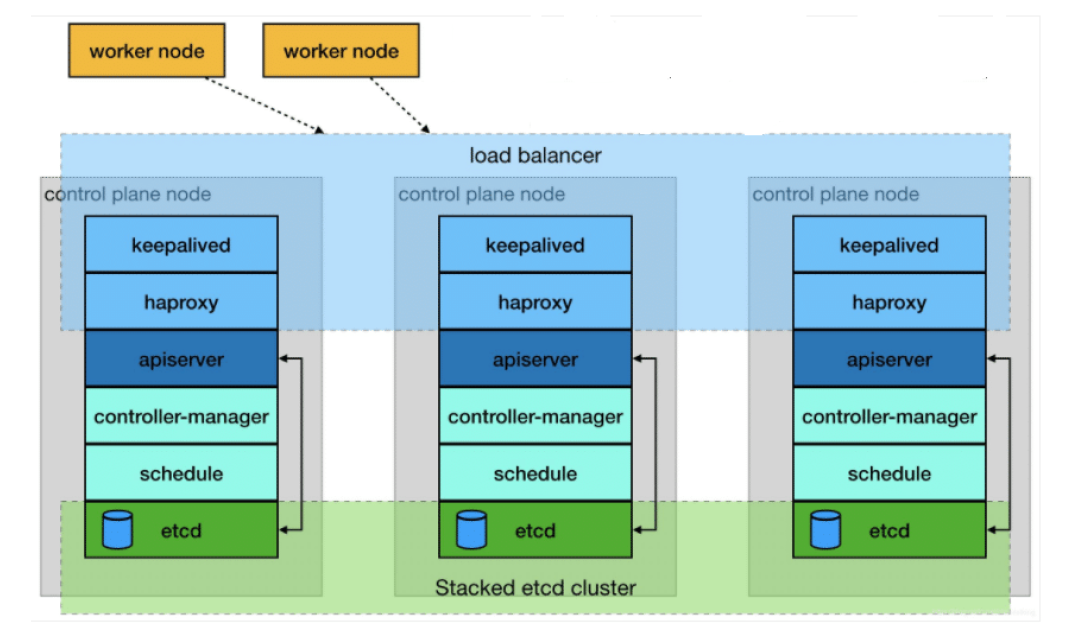

集群的高可用拓扑

堆叠式 etcd 集群的高可用拓扑

这种拓扑将相同节点上的控制平面和 etcd 成员耦合在一起。优点在于建立起来非常容易,并且对副本的管理也更容易。但是,堆叠式存在耦合失败的风险。如果一个节点发生故障,则 etcd 成员和控制平面实例都会丢失,并且集群冗余也会受到损害。可以通过添加更多控制平面节点来减轻这种风险。因此为实现集群高可用应该至少运行三个堆叠的 Master 节点。

外部 etcd 集群的高可用拓扑

该拓扑将控制平面和 etcd 成员解耦。如果丢失一个 Master 节点,对 etcd 成员的影响较小,并且不会像堆叠式拓扑那样对集群冗余产生太大影响。但是,此拓扑所需的主机数量是堆叠式拓扑的两倍。具有此拓扑的群集至少需要三个主机用于控制平面节点,三个主机用于 etcd 集群。

实践

etcd 集群高可用

多少个 peer 最适合?

- 1 个? 3 个? 5 个?

- 保证高可用是首要目标

- 所有写操作都要经过 leader

- peer 多了是否能提升集群并读操作的并发能力?

- apiserver 的配置只连本地的 etcd peer

- apiserver 的配置指定所有 etcd peers ,但只有当前连接的 etcd member 异常,apiserver 才会换目标

- 需要动态 flex up 吗?

保证 apiserver 和 etcd 之间的高效性通讯

- apiserver 和 etcd 部署在同一节点

- apiserver 和 etcd 之间的通讯基于 gRPC

- 针对每一个 object apiserver 和 etcd 之间的 Connection —> stream 共享

- http2 的特性

- Stream quota

- 带来的问题?对于大规模集群,会造成链路阻塞

- 10000 个 pod ,一次 list 操作需要返回的数据可能超过 100M

etcd 存储规划

- 本地 vs 远程?

- Remote Storage

- 优势是假设永远可用,现实真是如此吗?

- 劣势是 IO 效率,可能带来的问题?

- 最佳实践:

- Local SSD

- 利用 local volume 分配空间

- Remote Storage

- 多少空间?

- 与集群规模相关

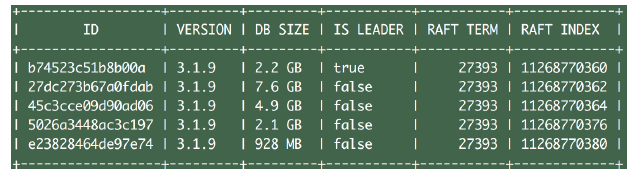

思考:为什么每个 member 的 DB size 不一致?

etcd

安全性

- peer 和 peer 之间的通讯加密

- 是否有需求

- TLS 的额外开销

- 运营复杂度增加

- 是否有需求

- 数据加密

- 是否有需求

- Kubernetes 提供了针对 secret 的加密 https://kubernetes.io/docs/tasks/administer-cluster/encrypt-data/

事件分离

- 对于大规模集群,大量的事件会对 etcd 造成压力

- API server 启动脚本中指定 etcd servers 集群

$ ks exec -it kube-apiserver-minikube -- kube-apiserver --help

--etcd-servers-overrides strings

Per-resource etcd servers overrides, comma separated. The individual override format: group/resource#servers, where servers are URLs, semicolon separated. Note that this applies only to resources compiled into this server binary.如何监控

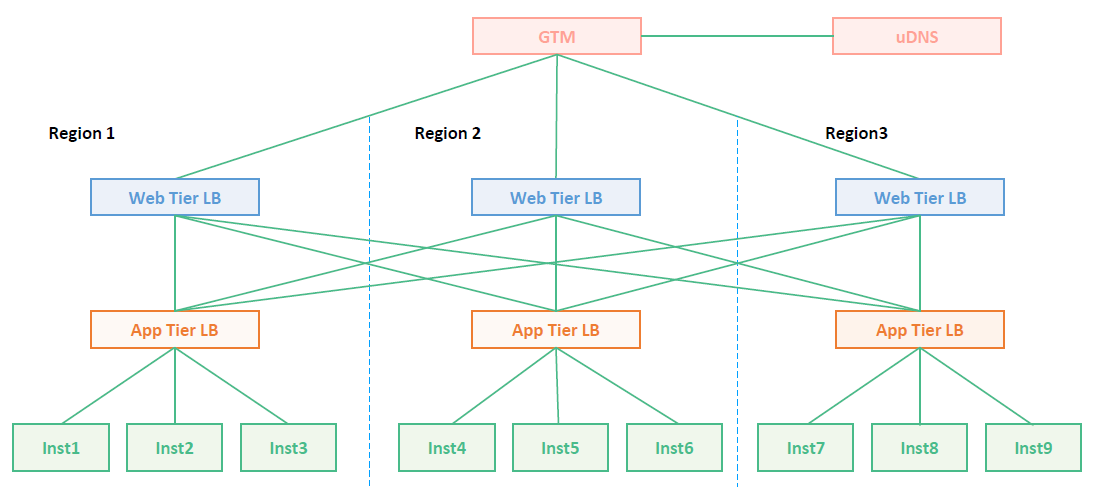

减少网络延迟

- 数据中心内的 RTT 大概是数毫秒,国内的典型 RTT 约为 50ms ,两大洲之间的 RTT 可能慢至 400ms 。因此建议 etcd 集群尽量同地域部署。

- 当客户端到 Leader 的并发连接数量过多,可能会导致其他 Follower 节点发往 Leader 的请求因为网络拥塞而被延迟处理。在 Follower 节点上,可能会看到这样的错误:

- dropped MsgProp to 247ae21ff9436b2d since streamMsg’s sending buffer is full

- 可以在节点上通过流量控制工具( Traffic Control )提高 etcd 成员之间发送数据的优先级来避免。

减少磁盘 I/O 延迟

对于磁盘延迟,典型的旋转磁盘写延迟约为 10 毫秒。对于 SSD Solid State Drives ,固态硬盘),延迟通常低于 1 毫秒。 HDD Hard Disk Drive ,硬盘驱动器)或者网盘在大量数据读写操作的情况下延时会不稳定。因此强烈建议使用 SSD 。

同时为了降低其他应用程序的 I/O 操作对 etcd 的干扰,建议将 etcd 的数据存放在单独的磁盘内。也可以将不同类型的对象存储在不同的若干个 etcd 集群中,比如将频繁变更的 event 对象从主 etcd 集群中分离出来,以保证主集群的高性能。在 APIServer 处这是可以通过参数配置的。这些 etcd 集群最好也分别能有一块单独的存储磁盘。

如果不可避免地, etcd 和其他的业务共享存储磁盘,那么就需要通过下面 ionice 命令对 etcd 服务设置更高的磁盘 I/O 优先级,尽可能避免其他进程的影响。

ionice -c2 -n0 -p 'pgrep etcd'保持合理的日志文件大小

etcd 以日志的形式保存数据,无论是数据创建还是修改,它都将操作追加到日志文件,因此日志文件大小会随着数据修改次数而线性增长。

当 Kubernetes 集群规模较大时,其对 etcd 集群中的数据更改也会很频繁,集群日记文件会迅速增长。

为了有效降低日志文件大小,etcd 会以固定周期创建快照保存系统的当前状态,并移除旧日志文件。另外当修改次数累积到一定的数量(默认是 10000 ,通过参数 “—snapshot-count” 指定), etcd 也会创建快照文件。

如果 etcd 的内存使用和磁盘使用过高,可以先分析是否数据写入频度过大导致快照频度过高,确认后可通过调低快照触发的阈值来降低其对内存和磁盘的使用。

设置合理的存储配额

存储空间的配额用于控制 etcd 数据空间的大小。合理的存储配额可保证集群操作的可靠性。如果没有存储配额,也就是 etcd 可以利用整个磁盘空间, etcd 的性能会因为存储空间的持续增长而严重下降,甚至有耗完集群磁盘空间导致不可预测集群行为的风险。如果设置的存储配额太小,一旦其中一个节点的后台数据库的存储空间超出了存储配额, etcd 就会触发集群范围的告警,并将集群置于只接受读和删除请求的维护模式。只有在释放足够的空间、消除后端数据库的碎片和清除存储配额告警之后,集群才能恢复正常操作。

自动压缩历史版本

etcd 会为每个键都保存了历史版本。为了避免出现性能问题或存储空间消耗完导致写不进去的问题,这些历史版本需要进行周期性地压缩。压缩历史版本就是丢弃该键给定版本之前的所有信息,节省出来的空间可以用于后续的写操作。 etcd 支持自动压缩历史版本。在启动参数中指定参数 “—auto-compaction”,其值以小时为单位。也就是 etcd 会自动压缩该值设置的时间窗口之前的历史版本。

定期消除碎片化

压缩历史版本,相当于离散地抹去 etcd 存储空间某些数据, etcd 存储空间中将会出现碎片。这些碎片无法被后台存储使用,却仍占据节点的存储空间。因此定期消除存储碎片,将释放碎片化的存储空间,重新调整整个存储空间。

备份

- 备份方案

- etcd 备份:备份完整的集群信息,灾难恢复

- etcdctl snapshot save

- 备份 Kubernetes event

- etcd 备份:备份完整的集群信息,灾难恢复

- 频度?

- 时间间隔太长:

- 能否接受 user data lost

- 如果有外部资源配置,如负载均衡等,能否接受数据丢失导致的 leak

- 时间间隔太短:

- 对 etcd 的影响

- 做 snapshot 的时候, etcd 会锁住当前数据

- 并发的写操作需要开辟新的空间进行增量写,导致磁盘空间增长

- 对 etcd 的影响

- 时间间隔太长:

- 如何保证备份的时效性,同时防止磁盘爆掉?

- Auto defrag

优化运行参数

当网络延迟和磁盘延迟固定的情况下,可以优化 etcd 运行参数来提升集群的工作效率。 etcd 基于 Raft 协议进行 Leader 选举,当 Leader 选定以后才能开始数据读写操作,因此频繁的 Leader 选举会导致数据读写性能显著降低。可以通过调整心跳周期( Heatbeat Interval )和选举超时时间 Election Timeout ),来降低 Leader 选举的可能性。

心跳周期是控制 Leader 以何种频度向 Follower 发起心跳通知。心跳通知除表明 Leader 活跃状态之外,还带有待写入数据信息, Follower 依据心跳信息进行数据写入,默认心跳周期是 100ms 。选举超时时间定义了当 Follower 多久没有收到 Leader 心跳,则重新发起选举,该参数的默认设置是 1000ms 。

如果 etcd 集群的不同实例部署在延迟较低的相同数据中心,通常使用默认配置即可。如果不同实例部署在多数据中心或者网络延迟较高的集群环境,则需要对心跳周期和选举超时时间进行调整。建议心跳周期参数推荐设置为接近 etcd 多个成员之间平均数据往返周期的最大值,一般是平均 RTT 的 0.55 - 1.5 倍。如果心跳周期设置得过低, etcd 会发送很多不必要的心跳信息,从而增加 CPU 和网络的负担。如果设置得过高,则会导致选举频繁超时。选举超时时间也需要根据 etcd 成员之间的平均 RTT 时间来设置。选举超时时间最少设置为 etcd 成员之间 RTT 时间的 10 倍,以便对网络波动。

心跳间隔和选举超时时间的值必须对同一个 etcd 集群的所有节点都生效,如果各个节点配置不同,就会导致集群成员之间协商结果不可预知而不稳定。

etcd 备份存储

etcd 的默认工作目录下会生成两个子目录: wal 和 snap 。 wal 是用于存放预写式日志,其最大的作用是记录整个数据变化的全部历程。所有数据的修改在提交前,都要先写入 wal 中。

snap 是用于存放快照数据。为防止 wal 文件过多, etcd 会定期(当 wal 中数据超过 10000 条记录时,由参数 “—snapshot-count” 设置)创建快照。当快照生成后 wal 中数据就可以被删除了。

如果数据遭到破坏或错误修改需要回滚到之前某个状态时,方法就有两个:一是从快照中恢复数据主体,但是未被拍入快照的数据会丢失;而是执行所有 WAL 中记录的修改操作,从最原始的数据恢复到数据损坏之前的状态,但恢复的时间较长。

备份方案实践

官方推荐 etcd 集群的备份方式是定期创建快照。和 etcd 内部定期创建快照的目的不同,该备份方式依赖外部程序定期创建快照,并将快照上传到网络存储设备以实现 etcd 数据的冗余备份。上传到网络设备的数据,都应进行了加密。即使当所有 etcd 实例都丢失了数据,也能允许 etcd 集群从一个已知的良好状态的时间点在任一地方进行恢复。根据集群对 etcd 备份粒度的要求,可适当调节备份的周期。在生产环境中实测,拍摄快照通常会影响集群当时的性能,因此不建议频繁创建快照。但是备份周期太长,就可能导致大量数据的丢失。

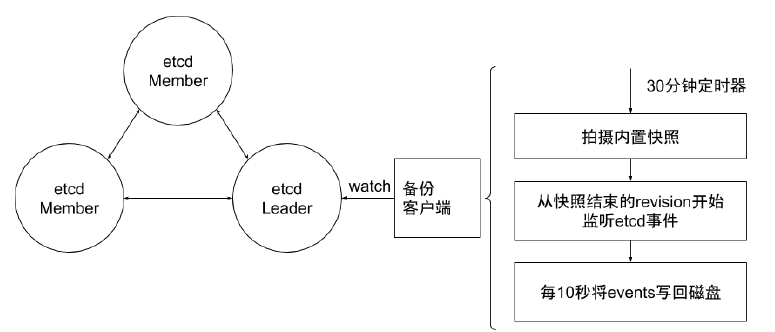

这里可以使用增量备份的方式。如图所示,备份程序每 30 分钟触发一次快照的拍摄。紧接着它从快照结束的版本( Revision )开始,监听 etcd 集群的事件,并每 10 秒钟将事件保存到文件中,并将快照和事件文件上传到网络存储设备中。 30 分钟的快照周期对集群性能影响甚微。当大灾难来临时,也至多丢失 10 秒的数据。至于数据修复,首先把数据从网络存储设备中下载下来,然后从快照中恢复大块数据,并在此基础上依次应用存储的所有事件。这样就可以将集群数据恢复到灾难发生前。

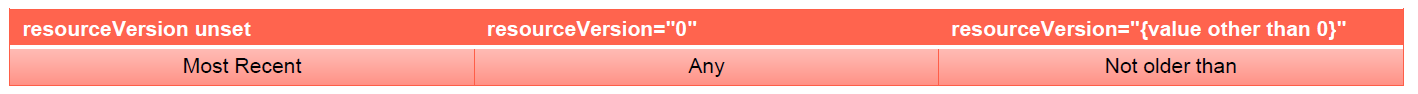

ResourceVersion

- 单个对象的 resourceVersion

- 对象的最后修改 resourceVersion

- List 对象的 resourceVersion

- 生成 list response 时的 resourceVersion

- List 行为

- List 对象时,如果不加 resourceVersion ,意味着需要 Most Recent 数据,请求会击穿 APIServer 缓存,直接发送至 etcd

- APIServer 通过 Label 过滤对象查询时,过滤动作是在 APIServer 端, APIServer 需要向 etcd 发起全量查询请求

遭遇到的陷阱

- 频繁的 leader election

- etcd 分裂

- etcd 不响应

- 与 apiserver 之间的链路阻塞

- 磁盘暴涨

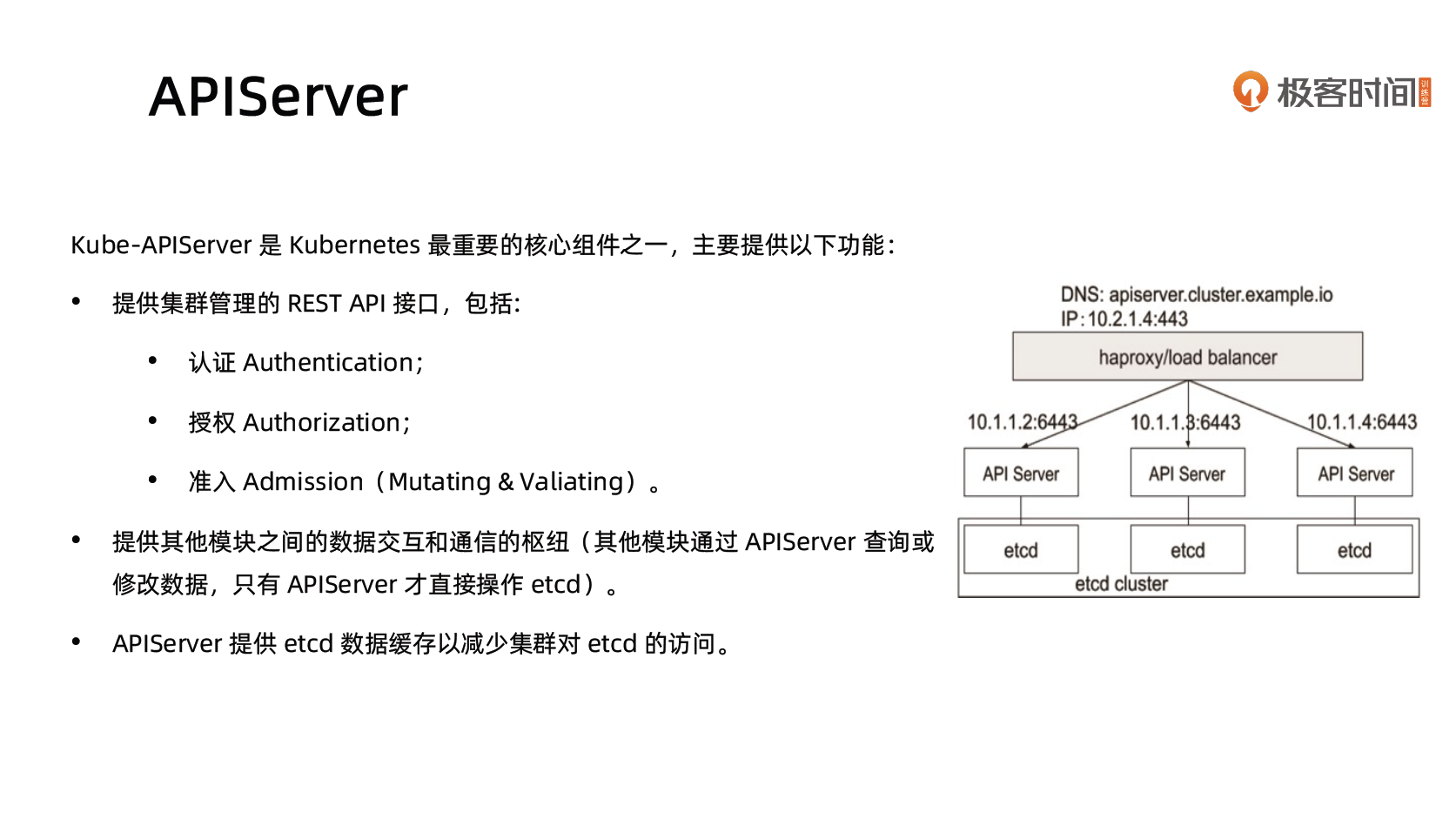

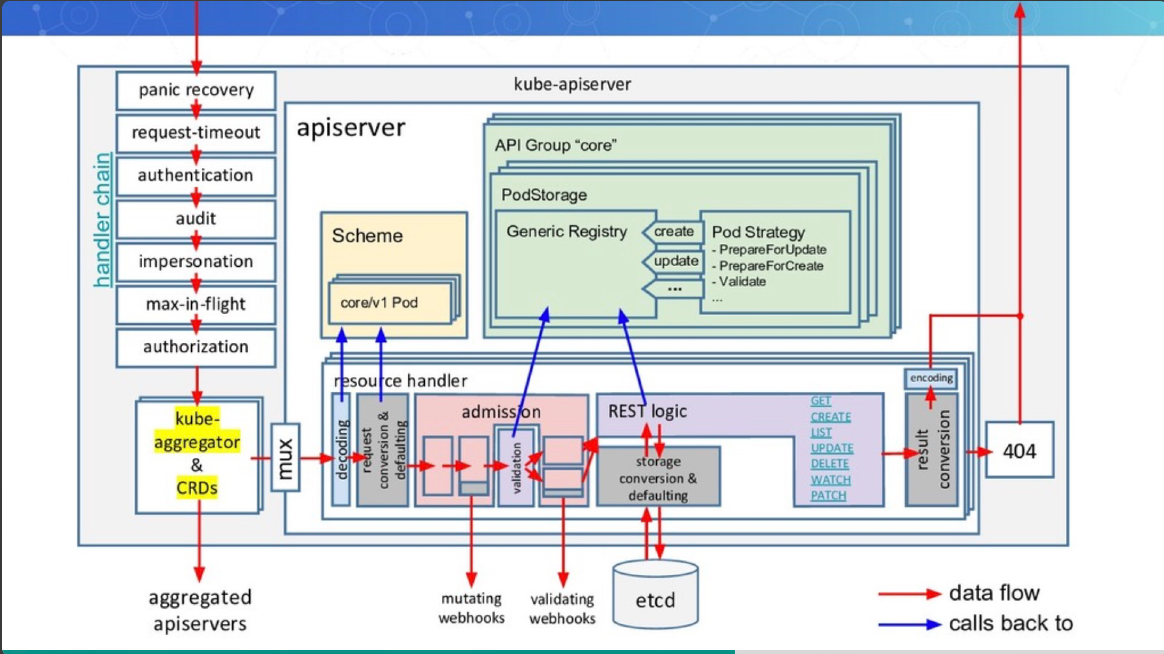

Kubernetes 控制平面组件 API Server

API Server

kube-apiserver 是 Kubernetes 最重要的核心组件之一,主要提供以下的功能:

- 提供集群管理的 REST API 接口,包括认证授权、数据校验以及集群状态变更等

- 提供其他模块之间的数据交互和通信的枢纽(其他模块通过 API Server 查询或修改数据,只有 API Server 才直接操作 etcd)

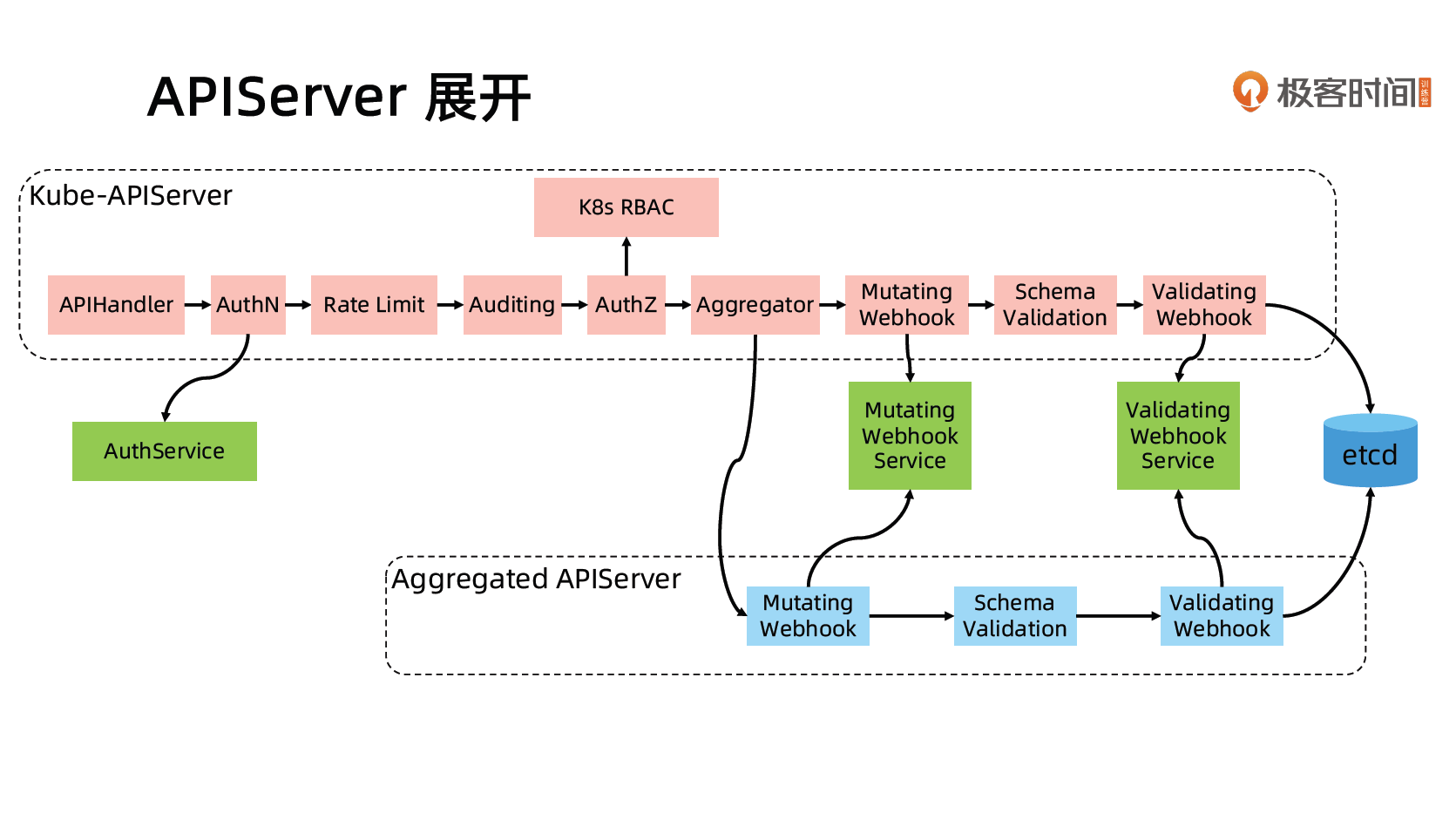

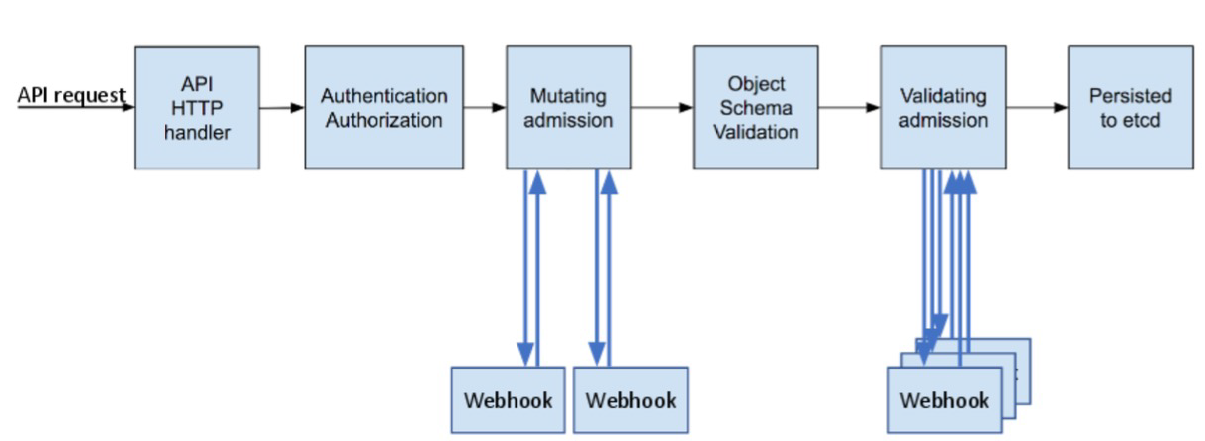

访问控制概览

Kubernetes API的每个请求都会经过多阶段的访问控制之后才会被接受,这包括认证、授权以及准入控制(Admission Control)等。

访问控制细节

认证

开启 TLS 时,所有的请求都需要首先认证。Kubernetes 支持多种认证机制,并支持同时开启多个认证插件(只要有一个认证通过即可)。如果认证成功,则用户的 username 会传入授权模块做进一步授权验证;而对于认证失败的请求则返回 HTTP 401。

认证插件

- X509证书

- https://github.com/kibaamor/101/blob/master/module6/basic-auth/x509.MD

- 使用 X509 客户端证书只需要 API Server 启动时配置

--client-ca-file=SOMEFILE。在证书认证时,其 CN 域用作用户名,而组织机构域则用作 group 名。

- 静态Token文件

- https://github.com/kibaamor/101/tree/master/module6/basic-auth

- 使用静态 Token 文件认证只需要 API Server 启动时配置

--token-auth-file=SOMEFILE。 - 该文件为csv格式,每行至少包括三列 token,username,user id,

- token,user,uid,”group1,group2,group3”

- 引导Token

- 为了支持平滑地启动引导新的集群,Kubernetes 包含了一种动态管理的持有者令牌类型, 称作启动引导令牌(Bootstrap Token)。

- 这些令牌以 Secret 的形式保存在 kube-system 名字空间中,可以被动态管理和创建。

- 控制器管理器包含的 TokenCleaner 控制器能够在启动引导令牌过期时将其删除。

- 在使用 kubeadm 部署 Kubernetes 时,可通过 kubeadm token list 命令查询。

- 静态密码文件

- 需要 API Server 启动时配置

--basic-auth-file=SOMEFILE,文件格式为 csv,每行至少三列 password, user, uid,后面是可选的 group 名- password,user,uid,”group1,group2,group3”

- 需要 API Server 启动时配置

- ServiceAccount

- ServiceAccount 是 Kubernetes 自动生成的,并会自动挂载到容器的

/run/secrets/kubernetes.io/serviceaccount目录中。

- ServiceAccount 是 Kubernetes 自动生成的,并会自动挂载到容器的

- OpenID

- OAuth 2.0的认证机制

- Webhook 令牌身份认证

- —authentication-token-webhook-config-file 指向一个配置文件,其中描述如何访问远程的Webhook 服务。

- —authentication-token-webhook-cache-ttl 用来设定身份认证决定的缓存时间。默认时长为2 分钟。

- 匿名请求

- 如果使用 AlwaysAllow 以外的认证模式,则匿名请求默认开启,但可用

--anonymous-auth=false禁止匿名请求。

- 如果使用 AlwaysAllow 以外的认证模式,则匿名请求默认开启,但可用

基于webhook的认证服务集成

构建符合Kubernetes规范的认证服务

需要依照 Kubernetes 规范,构建认证服务,用来认证 tokenreview request

构建认证服务需要满足如下Kubernetes的规范

URL: https://authn.example.com/authenticate

Method: POST

Input:

{

"apiVersion": "authentication.k8s.io/v1beta1",

"kind": "TokenReview",

"spec": {

"token": "(BEARERTOKEN)"

}

}Output:

{

"apiVersion": "authentication.k8s.io/v1beta1",

"kind": "TokenReview",

"status": {

"authenticated": true,

"user": {

"username": "janedoe@example.com",

"uid": "42",

"groups": [

"developers",

"qa"

]

}

}

}开发认证服务

https://github.com/kibaamor/101/tree/master/module6/authn-webhook

解码认证请求

decoder := json.NewDecoder(r.Body)

var tr authentication.TokenReview

err := decoder.Decode(&tr)

if err != nil {

log.Println("[Error]", err.Error())

w.WriteHeader(http.StatusBadRequest)

json.NewEncoder(w).Encode(map[string]interface{}{

"apiVersion": "authentication.k8s.io/v1beta1",

"kind": "TokenReview",

"status": authentication.TokenReviewStatus{

Authenticated: false,

},

})

return

}转发认证请求至认证服务器

// Check User

ts := oauth2.StaticTokenSource(

&oauth2.Token{AccessToken: tr.Spec.Token},

)

tc := oauth2.NewClient(context.Background(), ts)

client := github.NewClient(tc)

user, _, err := client.Users.Get(context.Background(), "")

if err != nil {

log.Println("[Error]", err.Error())

w.WriteHeader(http.StatusUnauthorized)

json.NewEncoder(w).Encode(map[string]interface{}{

"apiVersion": "authentication.k8s.io/v1beta1",

"kind": "TokenReview",

"status": authentication.TokenReviewStatus{

Authenticated: false,

},

})

return

}认证结果返回给 API Server

w.WriteHeader(http.StatusOK)

trs := authentication.TokenReviewStatus{

Authenticated: true,

User: authentication.UserInfo{

Username: *user.Login,

UID: *user.Login,

},

}

json.NewEncoder(w).Encode(map[string]interface{}{

"apiVersion": "authentication.k8s.io/v1beta1",

"kind": "TokenReview",

"status": trs,

})配置认证服务

{

"kind": "Config",

"apiVersion": "v1",

"preferences": {},

"clusters": [

{

"name": "github-authn",

"cluster": {

"server": "http://192.168.34.2:3000/authenticate"

}

}

],

"users": [

{

"name": "authn-apiserver",

"user": {

"token": "secret"

}

}

],

"contexts": [

{

"name": "webhook",

"context": {

"cluster": "github-authn",

"user": "authn-apiserver"

}

}

],

"current-context": "webhook"

}配置 apiserver

可以是任何认证系统

- 但在用户认证完成后,生成代表用户身份的 token

- 该 token 通常是有失效时间的

- 用户获取该 token 以后以后,将token配置进 kubeconfig

修改 apiserver 设置,开启认证服务,apiserver 保证将所有收到的请求中的 token 信息,发给认证服务进行验证

- --authentication-token-webhook-config-file,该文件描述如何访问认证服务

- --authentication-token-webhook-cache-ttl,默认 2 分钟

配置文件需要mount进Pod

配置文件中的服务器地址需要指向 authService

生产系统中遇到的陷阱

基于 Keystone 的认证插件导致 Keystone 故障且无法恢复

Keystone 是企业关键服务

Kubernetes 以 Keystone 作为认证插件

Keystone 在出现故障后会抛出 401 错误

Kubernetes 发现 401 错误后会尝试重新认证

大多数 controller 都有指数级 back off,重试间隔越来越慢

但 gophercloud 针对过期 token 会一直 retry

大量的 request 积压在 Keystone 导致服务无法恢复

Kubernetes 成为压死企业认证服务的最后一根稻草

解决方案?

- Circuit break

- Rate limit

鉴权

授权

授权主要是用于对集群资源的访问控制,通过检查请求包含的相关属性值,与相对应的访问策略相比较,API 请求必须满足某些策略才能被处理。跟认证类似,Kubernetes 也支持多种授权机制,并支持同时开启多个授权插件(只要有一个验证通过即可)。如果授权成功,则用户的请求会发送到准入控制模块做进一步的请求验证;对于授权失败的请求则返回 HTTP 403。

Kubernetes 授权仅处理以下的请求属性:

- user, group, extra

- API、请求方法(如 get、post、update、patch 和 delete)和请求路径(如 /api)

- 请求资源和子资源

- Namespace

- API Group

目前,Kubernetes 支持以下授权插件:

- ABAC

- RBAC

- Webhook

- Node

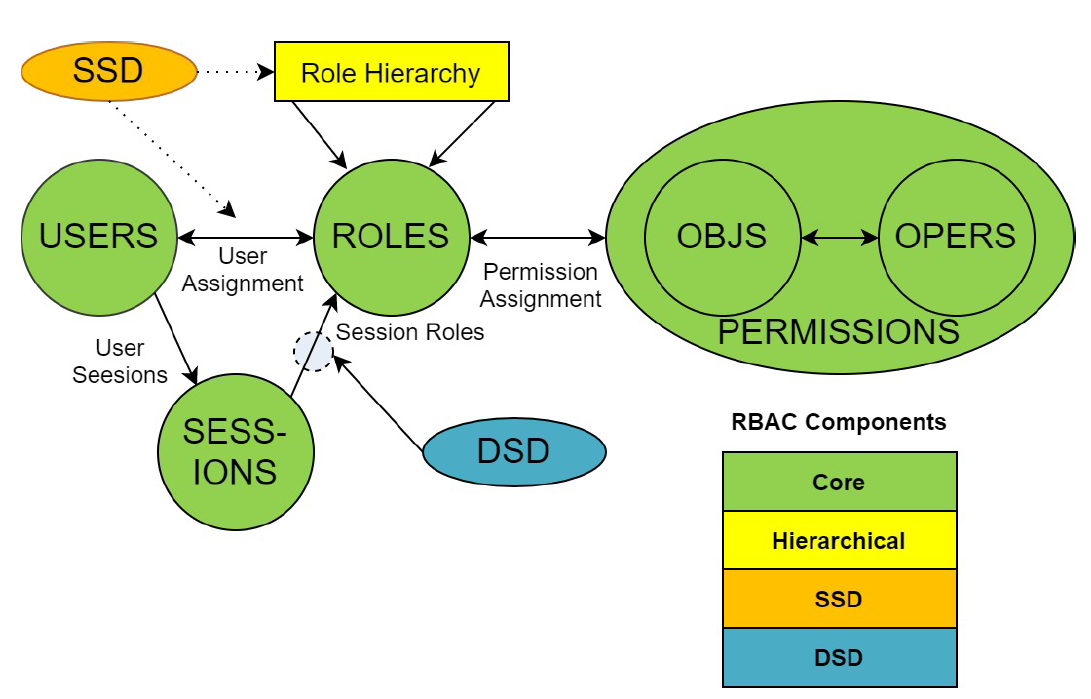

RBAC vs ABAC

ABAC(Attribute Based Access Control)本来是不错的概念,但是在 Kubernetes 中的实现比较难于管理和理解,而且需要对 Master 所在节点的 SSH 和文件系统权限,要使得对授权的变更成功生效,还需要重新启动 API Server。

而 RBAC 的授权策略可以利用 kubectl 或者 Kubernetes API 直接进行配置。RBAC 可以授权给用户,让用户有权进行授权管理,这样就可以无需接触节点,直接进行授权管理。RBAC 在 Kubernetes 中被映射为 API 资源和操作。

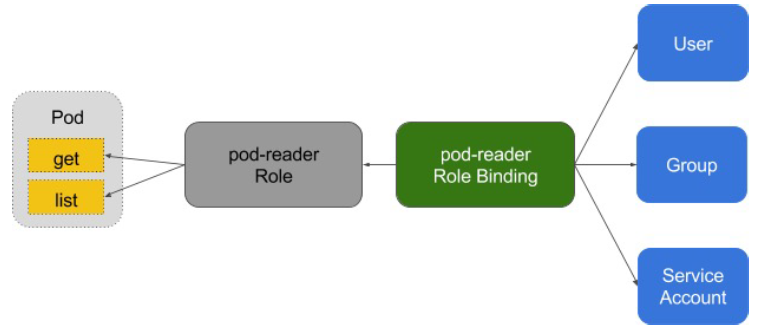

RBAC 老图

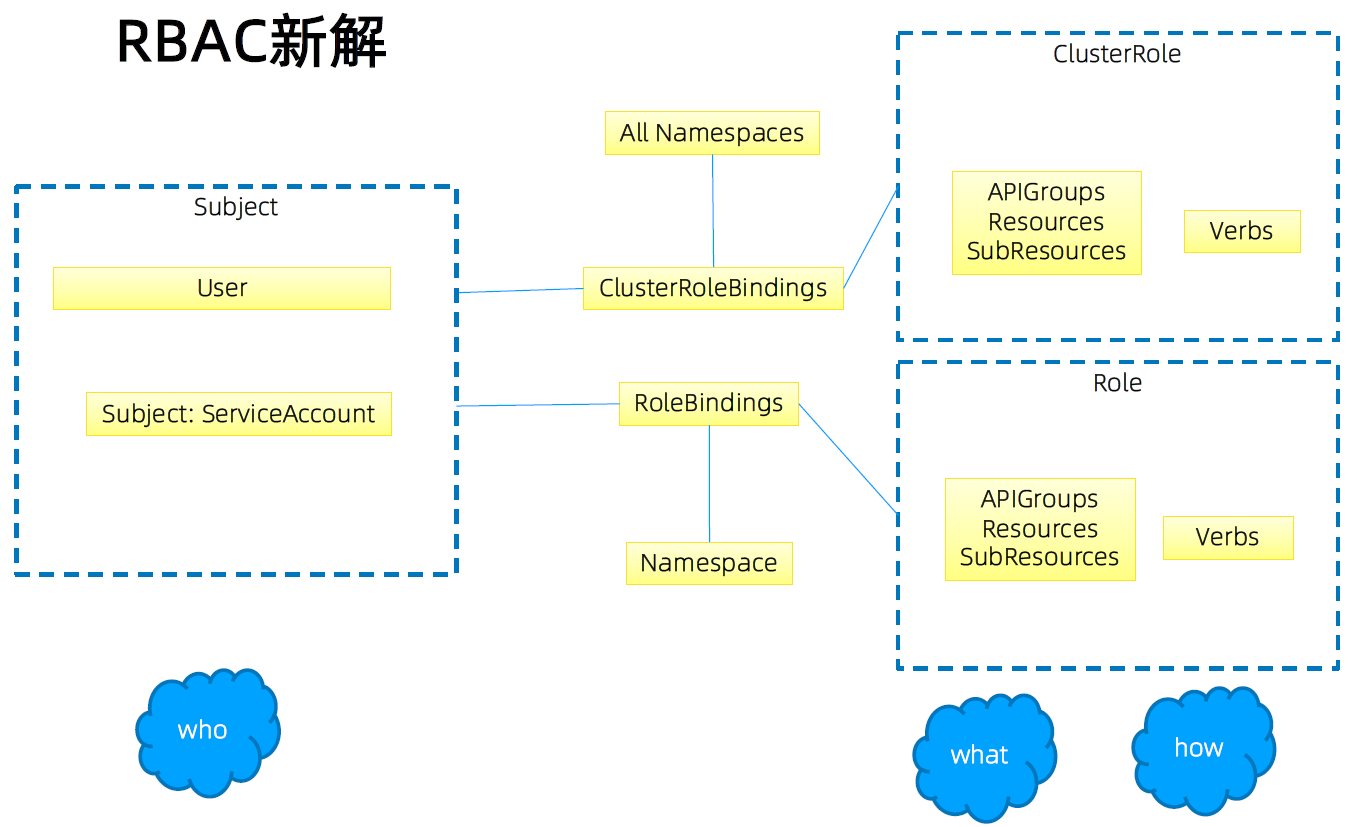

RBAC 新解

Role 与 ClusterRole

Role(角色)是一系列权限的集合,例如一个角色可以包含读取 Pod 的权限和列出 Pod 的权限。

Role 只能用来给某个特定 namespace 中的资源作鉴权,对多 namespace 和集群级的资源或者是非资源类的 API(如/healthz)使用 ClusterRole。

sub resource 可以单独控制权限(比如健康检查只能更新 status,不能更新 spec)

# Role示例

kind: Role

apiVersion: rbac.authorization.k8s.io/v1

metadata:

namespace: default

name: pod-reader

rules:

- apiGroups: [""] # "" indicates the core API group

resources: ["pods"]

verbs: ["get", "watch", "list"]

------

# ClusterRole示例

kind: ClusterRole

apiVersion: rbac.authorization.k8s.io/v1

metadata:

# "namespace" omitted since ClusterRoles are not namespaced

name: secret-reader

rules:

- apiGroups: [""]

resources: ["secrets"]

verbs: ["get", "watch", "list"]binding

# RoleBinding示例(引用ClusterRole)

# This role binding allows "dave" to read secrets in the "development"

namespace.

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: read-secrets

namespace: development # This only grants permissions within the "development" namespace.

subjects:

- kind: User

name: dave

apiGroup: rbac.authorization.k8s.io

roleRef:

kind: ClusterRole

name: secret-reader

apiGroup: rbac.authorization.k8s.io

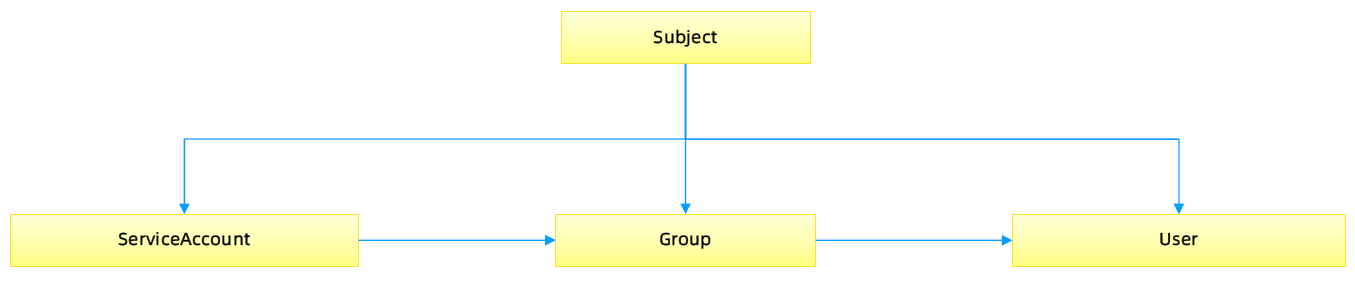

账户/组的管理

角色绑定(Role Binding)是将角色中定义的权限赋予一个或者一组用户。

它包含若干主体(用户、组或服务账户)的列表和对这些主体所获得的角色的引用。

组的概念:

- 当与外部认证系统对接时,用户信息(UserInfo)可包含 Group 信息,授权可针对用户群组

- 当对 ServiceAccount 授权时,Group 代表某个 Namespace 下的所有 ServiceAccount

针对群租授权

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: read-secrets-global

subjects:

- kind: Group

name: manager # 'name' 是区分大小写的

apiGroup: rbac.authorization.k8s.io

roleRef:

kind: ClusterRole

name: secret-reader

apiGroup: rbac.authorization.k8s.io

-------

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: read-secrets-global

subjects:

- kind: Group

name: system:serviceaccounts:qa

apiGroup: rbac.authorization.k8s.io

roleRef:

kind: ClusterRole

name: secret-reader

apiGroup: rbac.authorization.k8s.io规划系统角色

User

- 管理员

- 所有资源的所有权限??

- 普通用户

- 是否有该用户创建的 namespace 下的所有 object 的操作权限?

- 对其他用户的 namespace 资源是否可读,是否可写?

SystemAccount

- SystemAccount 是开发者(kubernetes developer 或者 domain developer)创建应用后,应用于 apiserver 通讯需要的身份

- 用户可以创建自定的 ServiceAccount,kubernetes 也为每个 namespace 创建 default ServiceAccount

- Default ServiceAccount 通常需要给定权限以后才能对 apiserver 做写操作

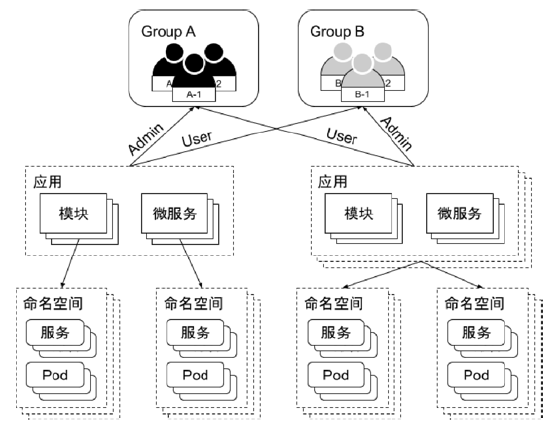

实现方案

在 cluster 创建时,创建自定义的 clusterrole,比如 namespace-creator

Namespace-creator role 定义用户可操作的对象和对应的读写操作。

创建自定义的 namespace admission controller

- 当 namespace 创建请求被处理时,获取当前用户信息并 annotate 到 namespace

创建 RBAC controller

- Watch namespace 的创建事件

- 获取当前 namespace 的创建者信息

- 在当前 namespace 创建 rolebinding 对象,并将 namespace-creator 角色和用户绑定

与权限相关的其他最佳实践

ClusterRole 是非 namespace 绑定的,针对整个集群生效

通常需要创建一个管理员角色,并且绑定给开发运营团队成员

ThirdPartyResource 和 CustomResourceDefinition 是全局资源,普通用户创建 ThirdPartyResource 以后,需要管理员授予相应权限后才能真正操作该对象

针对所有的角色管理,建议创建 spec,用源代码驱动

虽然可以通过edit操作来修改权限,但后期会导致权限管理混乱,可能会有很多临时创建出来的角色和角色绑定对象,重复绑定某一个资源权限

权限是可以传递的,用户 A 可以将其对某对象的某操作,抽取成一个权限,并赋给用户 B

防止海量的角色和角色绑定对象,因为大量的对象会导致鉴权效率低,同时给 apiserver 增加负担

ServiceAccount 也需要授权的,否则你的 component 可能无法操作某对象

Tips:SSH 到 master 节点通过 insecure port 访问 apiserver 可绕过鉴权,当需要做管理操作又没有权限时可以使用(不推荐)

运营过程中出现的陷阱

案例1:

- 研发人员为提高系统效率,将 update 方法修改为 patch

- 研发人员本地非安全测试环境测试通过

- 上生产,发现不 work

- 原因:忘记更新 rolebinding,对应的 serviceaccount 没有 patch 权限

案例2:

- 研发人员创建 CRD,并针对该 CRD 编程

- 上生产后不工作

- 原因,该 CRD 未授权,对应的组件 get 不到对应的 CRD 资源

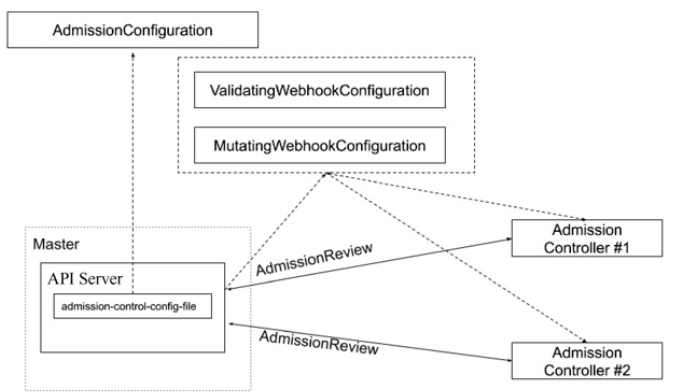

准入

准入控制

为资源增加自定义属性

- 作为多租户集群方案中的一环,我们需要在 namespace 的准入控制中,获取用户信息,并将用户信息更新的 namespace 的 annotation

只有当 namespace 中有有效用户信息时,我们才可以在 namespace 创建时,自动绑定用户权限,namespace 才可用。

准入控制(Admission Control)在授权后对请求做进一步的验证或添加默认参数。不同于授权和认证只关心请求的用户和操作,准入控制还处理请求的内容,并且仅对创建、更新、删除或连接(如代理)等有效,而对读操作无效。

准入控制支持同时开启多个插件,它们依次调用,只有全部插件都通过的请求才可以放过进入系统。

准入控制插件

- AlwaysAdmit: 接受所有请求。

- AlwaysPullImages: 总是拉取最新镜像。在多租户场景下非常有用。

- DenyEscalatingExec: 禁止特权容器的 exec 和 attach 操作。

- ImagePolicyWebhook: 通过 webhook 决定 image 策略,需要同时配置

--admission-controlconfig-file - ServiceAccount:自动创建默认 ServiceAccount,并确保 Pod 引用的 ServiceAccount 已经存在

- SecurityContextDeny:拒绝包含非法 SecurityContext 配置的容器

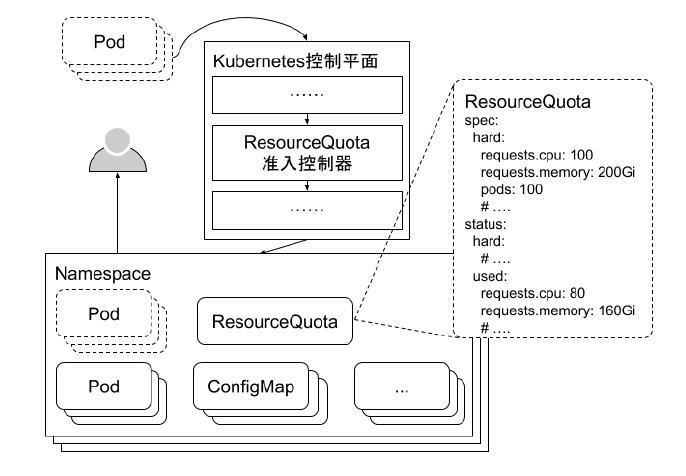

- ResourceQuota:限制 Pod 的请求不会超过配额,需要在 namespace 中创建一个 ResourceQuota 对象

- LimitRanger:为 Pod 设置默认资源请求和限制,需要在 namespac 中创建一个 LimitRange 对象

- InitialResources:根据镜像的历史使用记录,为容器设置默认资源请求和限制

- NamespaceLifecycle:确保处于 termination 状态的 namespace 不再接收新的对象创建请求,并拒绝请求不存在的 namespace

- DefaultStorageClass:为 PVC 设置默认 StorageClass

- DefaultTolerationSeconds:设置 Pod 的默认 forgiveness toleration 为 5 分钟

- PodSecurityPolicy:使用 Pod Security Policies 时必须开启

- NodeRestriction:限制 kubelet 仅可访问 node、endpoint、pod、service 以及 secret、configmap、PV 和PVC 等相关的资源

准入控制插件的开发

https://github.com/kibaamor/101/blob/master/module6/mutatingwebhook/readme.MD

https://github.com/kibaamor/admission-controller-webhook-demo

准入控制插件

除默认的准入控制插件以外,Kubernetes 预留了准入控制插件的扩展点,用户可自定义准入控制插件实现自定义准入功能

- MutatingWebhookConfiguration:变形插件,支持对准入对象的修改

- ValidatingWebhookConfiguration:校验插件,只能对准入对象合法性进行校验,不能修改

# {{if eq .k8snode_validating "enabled"}}

apiVersion: admissionregistration.k8s.io/v1beta1

kind: MutatingWebhookConfiguration

metadata:

name: ns-mutating.webhook.k8s.io

webhooks:

- clientConfig:

caBundle: {{.serverca_base64}}

url: https://admission.local.tess.io/apis/admission.k8s.io/v1alpha1/ns-mutating

failurePolicy: Fail

name: ns-mutating.webhook.k8s.io

namespaceSelector: {}

rules:

- apiGroups:

- ""

apiVersions:

- '*'

operations:

- CREATE

resources:

- nodes

sideEffects: Unknown

# {{end}}配额管理

https://github.com/kibaamor/101/tree/master/module6/quota

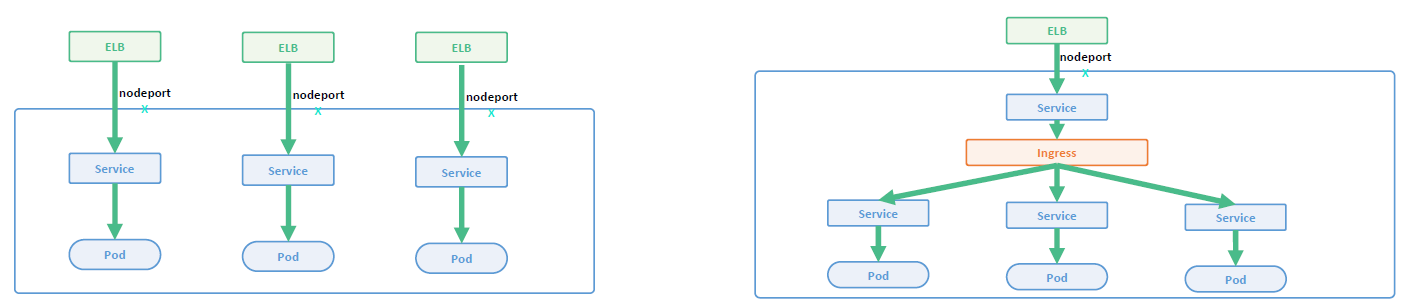

配额管理

- 原因:资源有限,如何限定某个用户有多少资源?

方案: - 预定义每个 Namespace 的 ResourceQuota,并把 spec 保存为 configmap

- 用户可以创建多少个 Pod

- BestEffortPod

- QoSPod

- 用户可以创建多少个 service

- 用户可以创建多少个 ingress

- 用户可以创建多少个 service VIP

- 用户可以创建多少个 Pod

- 创建 ResourceQuota Controller

- 监控 namespace 创建事件,当 namespace 创建时,在该 namespace 创建对应的 ResourceQuota 对象

- apiserver 中开启 ResourceQuota 的 admission plugin

限流

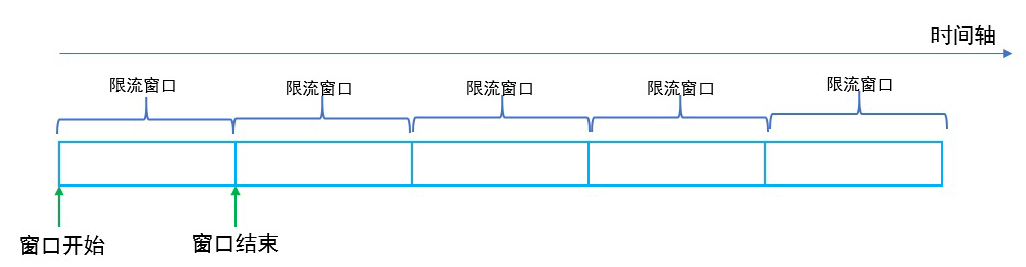

计数器固定窗口算法

原理就是对一段固定时间窗口内的请求进行计数,如果请求数超过了阈值,则舍弃该请求;

如果没有达到设定的阈值,则接受该请求,且计数加 1 。

当时间窗口结束时,重置计数器为 0 。

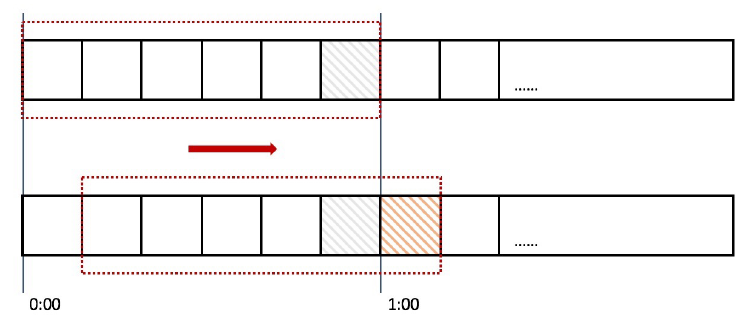

计数器滑动窗口算法

在固定窗口的基础上,将一个计时窗口分成了若干个小窗口,然后每个小窗口维护一个独立的计数器。

当请求的时间大于当前窗口的最大时间时,则将计时窗口向前平移一个小窗口。

平移时,将第一个小窗口的数据丢弃,然后将第二个小窗口设置为第一个小窗口,同时在最后面新增一个小窗口,将新的请求放在新增的小窗口中。

同时要保证整个窗口中所有小窗口的请求数目之后不能超过设定的阈值。

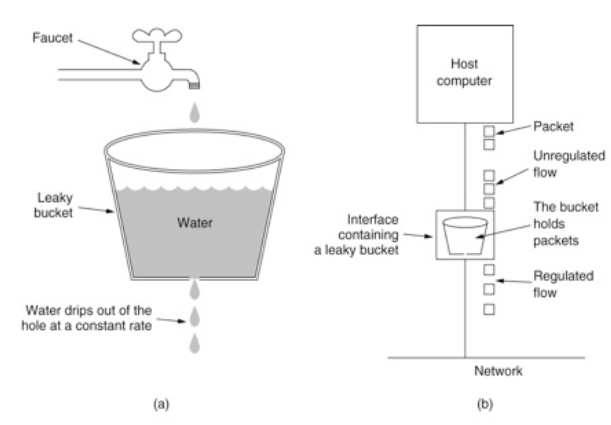

漏斗算法

漏斗算法的原理也很容易理解。请求来了之后会首先进到漏斗里,然后漏斗以恒定的速率将请求流出进行处理,从而起到平滑流量的作用。

当请求的流量过大时,漏斗达到最大容量时会溢出,此时请求被丢弃。

在系统看来,请求永远是以平滑的传输速率过来,从而起到了保护系统的作用。

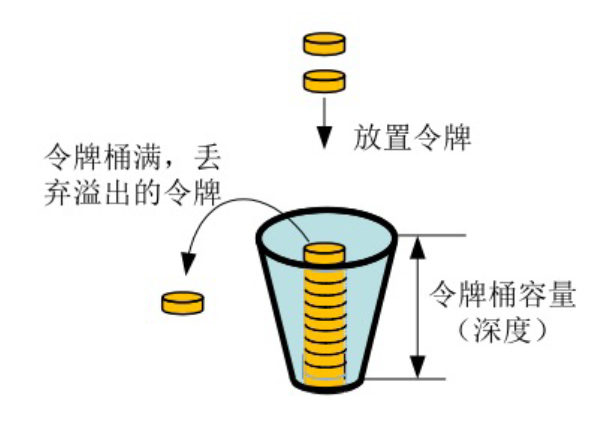

令牌桶算法

令牌桶算法是对漏斗算法的一种改进,除了能够起到限流的作用外,还允许一定程度的流量突发。

在令牌桶算法中,存在一个令牌桶,算法中存在一种机制以恒定的速率向令牌桶中放入令牌。

令牌桶也有一定的容量,如果满了令牌就无法放进去了。

当请求来时,会首先到令牌桶中去拿令牌,如果拿到了令牌,则该请求会被处理,并消耗掉拿到的令牌;

如果令牌桶为空,则该请求会被丢弃。

API Server 中的限流

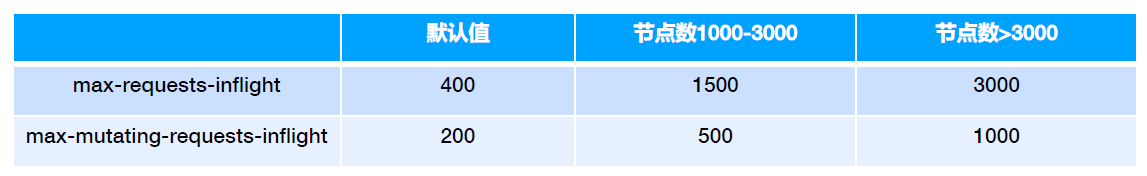

max-requests-inflight: 在给定时间内的最大 non-mutating 请求数

max-mutating-requests-inflight: 在给定时间内的最大 mutating 请求数,调整 apiserver 的流控 qos

代码 staging/src/k8s.io/apiserver/pkg/server/filters/maxinflight.go:WithMaxInFlightLimit()

传统限流方法的局限性

- 粒度粗

- 无法为不同用户,不同场景设置不通的限流

- 单队列

- 共享限流窗口/桶,一个坏用户可能会将整个系统堵塞,其他正常用户的请求无法被及时处理

- 不公平

- 正常用户的请求会被排到队尾,无法及时处理而饿死

- 无优先级

- 重要的系统指令一并被限流,系统故障难以恢复

API Priority and Fairness

APF 以更细粒度的方式对请求进行分类和隔离。

- 它还引入了空间有限的排队机制,因此在非常短暂的突发情况下,API 服务器不会拒绝任何请求。

- 通过使用公平排队技术从队列中分发请求,这样, 一个行为不佳的控制器就不会饿死其他控制器(即使优先级相同)。

APF的核心

- 多等级

- 多队列

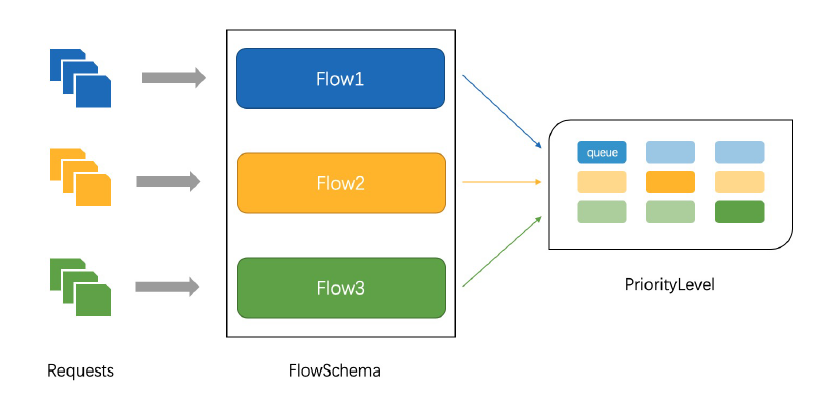

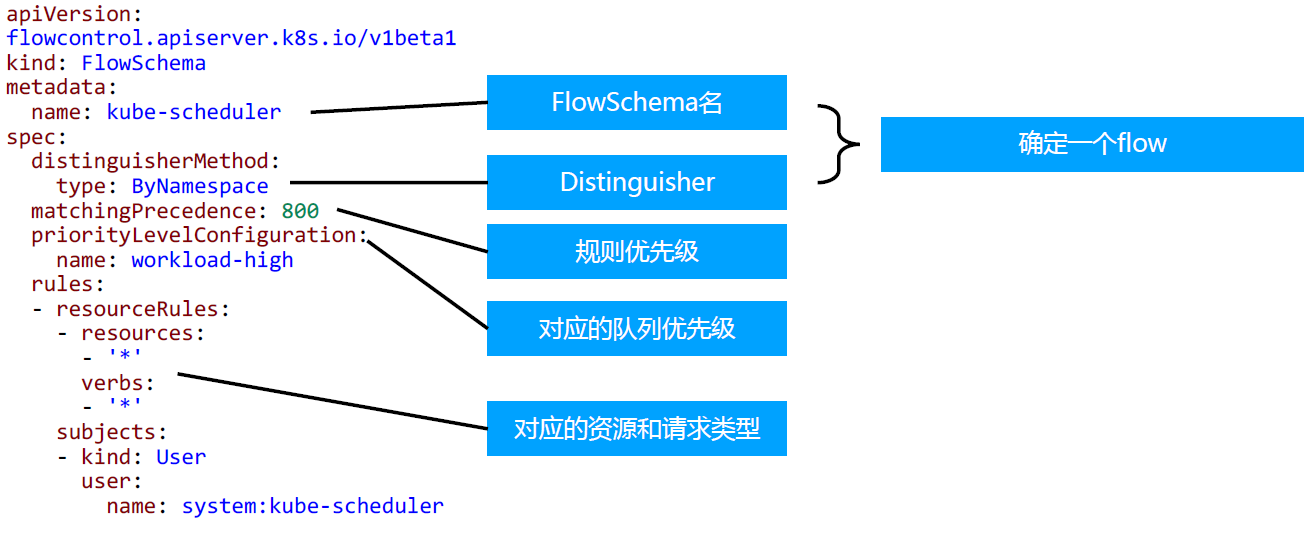

APF 的实现依赖两个非常重要的资源 FlowSchema, PriorityLevelConfiguration

- APF 对请求进行更细粒度的分类,每一个请求分类对应一个 FlowSchema (FS)

- FS 内的请求又会根据 distinguisher 进一步划分为不同的 Flow.

- FS 会设置一个优先级(Priority Level, PL),不同优先级的并发资源是隔离的。所以不同优先级的资源不会相互排挤。特定优先级的请求可以被高优处理。

- 一个 PL 可以对应多个 FS,PL 中维护了一个 QueueSet,用于缓存不能及时处理的请求,请求不会因为超出 PL 的并发限制而被丢弃。

- FS 中的每个 Flow 通过 shuffle sharding 算法从 QueueSet 选取特定的 queues 缓存请求。

- 每次从 QueueSet 中取请求执行时,会先应用 fair queuing 算法从 QueueSet 中选中一个 queue,然后从这个 queue 中取出 oldest 请求执行。所以即使是同一个 PL 内的请求,也不会出现一个 Flow 内的请求一直占用资源的不公平现象。

概念

- 传入的请求通过FlowSchema 按照其属性分类,并分配优先级。

- 每个优先级维护自定义的并发限制,加强了隔离度,这样不同优先级的请求,就不会相互饿死。

- 在同一个优先级内,公平排队算法可以防止来自不同flow 的请求相互饿死。

- 该算法将请求排队,通过排队机制,防止在平均负载较低时,通信量突增而导致请求失败。

优先级

- 如果未启用 APF,API 服务器中的整体并发量将受到 kube-apiserver 的参数

--maxrequests-inflight和--max-mutating-requests-inflight的限制。 - 启用 APF 后,将对这些参数定义的并发限制进行求和,然后将总和分配到一组可配置的优先级中。每个传入的请求都会分配一个优先级;

- 每个优先级都有各自的配置,设定允许分发的并发请求数。

- 例如,默认配置包括针对领导者选举请求、内置控制器请求和 Pod 请求都单独设置优先级。这表示即使异常的 Pod 向 API 服务器发送大量请求,也无法阻止领导者选举或内置控制器的操作执行成功。

排队

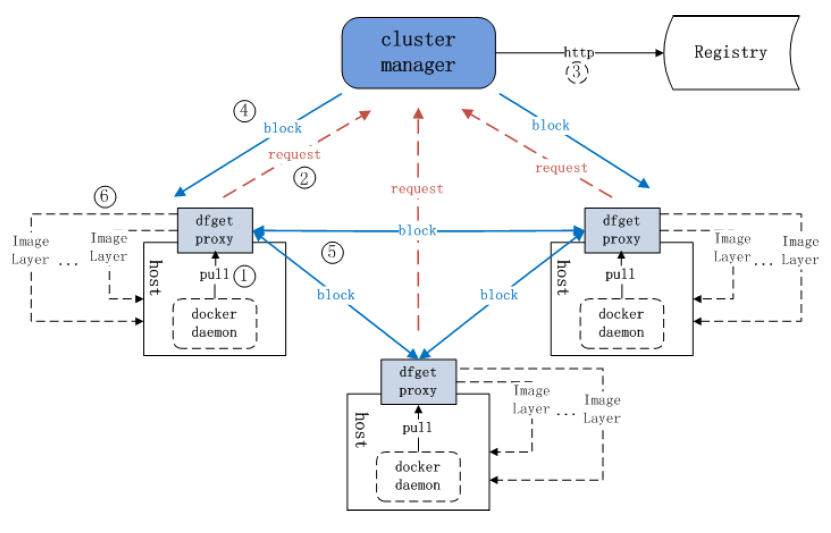

- 即使在同一优先级内,也可能存在大量不同的流量源。